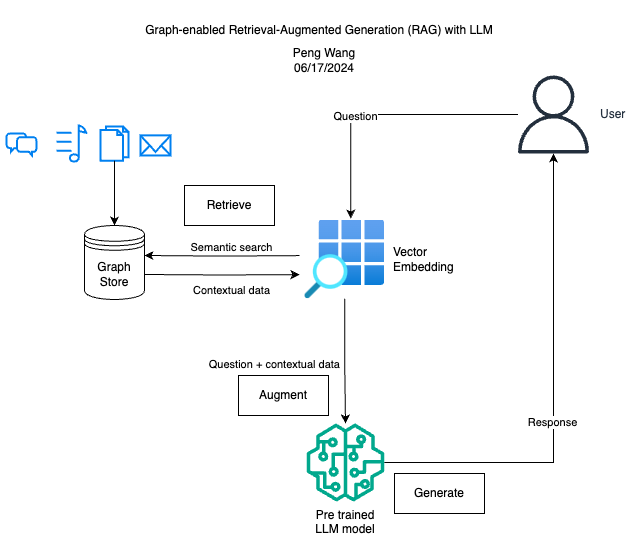

检索增强生成 (RAG) 的概念是向大型语言模型 (LLM) 提供来自外部知识源(如 PDF 文档、CSV 文件等)的补充信息。这使它们能够生成更准确、更符合上下文的响应。但是,RAG 难以处理广泛的异构信息。

RAG 利用向量数据库,该数据库基于不同实体(如单词或短语)的高维向量表示来测量它们之间的相似性或相关性。它忽略了实体的结构和关系。例如,在向量表示中,“员工”一词可能比“信息”与“雇主”更相关,因为它在向量空间中看起来更接近。

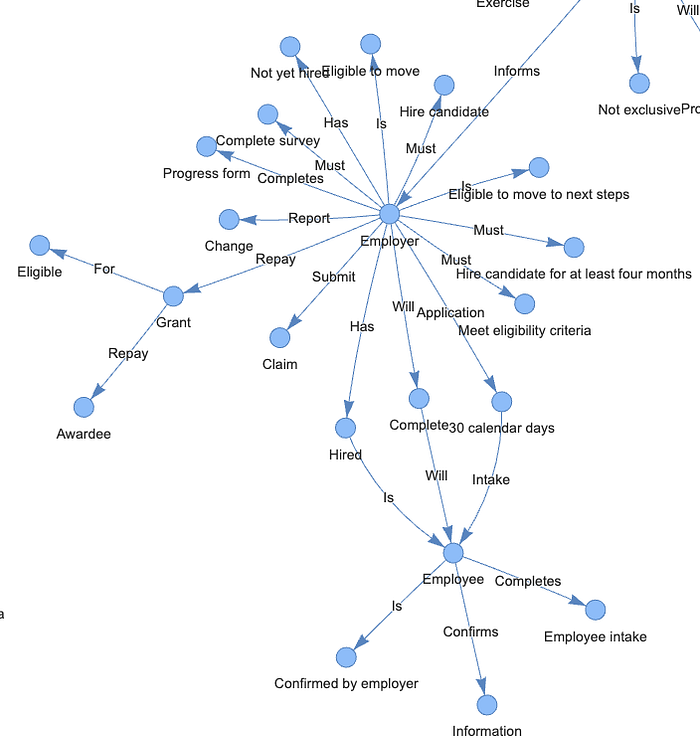

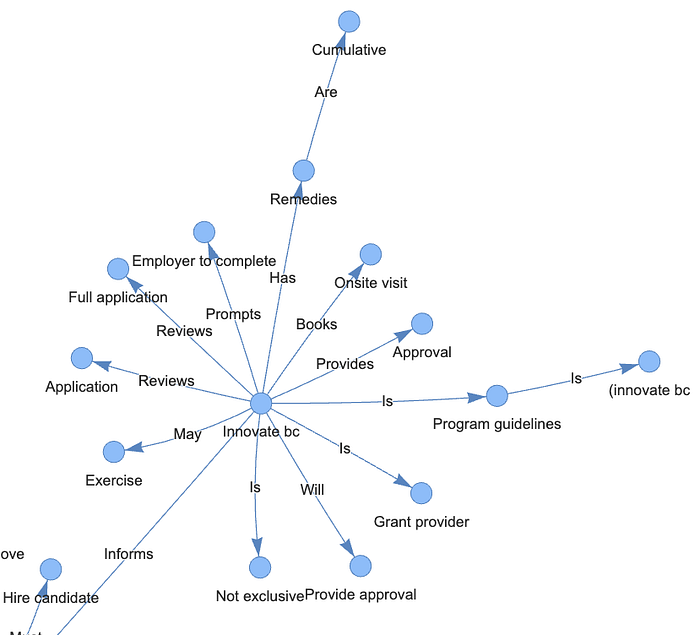

这可以通过引入知识图谱来实现,知识图谱是一种将数据组织为节点和边的数据结构,可增强检索信息的语境性。知识图谱由主语-谓语-宾语三元组组成,其中主语/宾语由节点表示,谓语/关系由边表示。例如,在这个三元组“雇主 — 提交 — 索赔”中,“提交”是谓语,表示“雇主”和“索赔”之间的关系。通过三元组表示,知识图谱数据库可以使复杂的数据搜索更加准确和高效。

一、执行

1、安装依赖项

!pip 安装 -q pypdf

!pip 安装 -q python-dotenv

!pip 安装 -q pyvis

!pip 安装 -q transformers einops 加速 langchain bitsandbytes sentence\_transformers langchain-community langchain-core

!pip 安装 -q llama-index

!pip 安装 -q llama-index-llms-huggingface

!pip 安装 -q llama-index-embeddings-langchain

!pip 安装 -q llama-index-embeddings-huggingface

- LlamaIndex:一个简单、灵活的数据框架,用于将自定义数据源连接到 LLM

- SimpleDirectoryReader:将数据从本地文件加载到 LlamaIndex 的最简单方法

- KnowledgeGraphIndex:从非结构化文本自动构建知识图谱

- SimpleGraphStore:简单图形存储索引

- PyVis:一个用于可视化和构建图形网络的 Python 库

2、启用诊断日志记录

日志记录为代码执行提供了有价值的见解。

导入操作系统、日志记录、系统日志

记录.basicConfig(流=sys.stdout,级别=logging.INFO)

日志记录.getLogger()。addHandler(日志记录.StreamHandler(流=sys.stdout))

3、连接 Huggingface API

使用您的 Huggingface 推理 API 端点进行更新

从huggingface\_hub导入登录

os.environ\[ "HF\_KEY" \] = "您的 Hugging Face 访问令牌在此处"

login(token=os.environ.get( 'HF\_KEY' ),add\_to\_git\_credential= True )

4、加载 PDF 文档

- 创新不列颠哥伦比亚省创新者技能计划

- 卑诗省艺术委员会申请协助

从llama\_index.core导入SimpleDirectoryReader

文档 = SimpleDirectoryReader(input\_dir= "/content/" , required\_exts= ".pdf" ).load\_data()

二、构建知识图谱索引

1、使用 HuggingFace 创建本地嵌入

HuggingFaceEmbeddings 是 LangChain 库中的一个类,它为 Hugging Face 的句子转换器模型提供了一个包装器,用于生成文本嵌入。它允许您使用 Hugging Face 上的任何句子嵌入模型来执行语义搜索、文档聚类和问答等任务。multi-qa-MiniLM-L6-cos-v1本练习使用 HF 句子转换器模型。

从llama\_index.embeddings.huggingface导入HuggingFaceEmbedding

EMBEDDING\_MODEL\_NAME = “sentence-transformers/multi-qa-MiniLM-L6-cos-v1”

embed\_model = HuggingFaceEmbedding(model\_name=EMBEDDING\_MODEL\_NAME,embed\_batch\_size= 10 )

2、从 ServiceContext 迁移到 Settings

LlamaIndex v0.10.0 中引入了一个新的全局 Settings 对象,旨在取代旧的 ServiceContext 配置。

新的 Settings 对象是一个全局设置,其参数是延迟实例化的。LLM 或嵌入模型等属性仅在底层模块实际需要时才会加载。

从llama\_index.core导入设置

Settings.embed\_model = embed\_model

Settings.chunk\_size = 256

Settings.chunk\_overlap = 50

当文档被录入索引时,它们会被分割成具有一定重叠度的块。这称为“分块”。默认块大小为 1024,而默认块重叠度为 20。我们将块大小设置为 256,重叠度为 50,因为我们的文档长度较短。更多分块策略可在此处找到。

3、定义自定义提示

从llama\_index.core导入PromptTemplate

system\_prompt = """<|SYSTEM|># 您是人工智能管理助理。

您的目标是仅使用提供的上下文准确回答问题。

"""

\# 这将包装 llama-index 内部的默认提示

query\_wrapper\_prompt = PromptTemplate( "<|USER|>{query\_str><|ASSISTANT|>" )

LLM\_MODEL\_NAME = "meta-llama/Llama-2-7b-chat-hf"

4、设置法学硕士 (LLM)

导入torch

从llama\_index.llms.huggingface导入HuggingFaceLLM

llm = HuggingFaceLLM(

context\_window= 4096 ,

max\_new\_tokens= 512 ,

generate\_kwargs={ "temperature" : 0.1 , "do\_sample" : False },

system\_prompt=system\_prompt,

query\_wrapper\_prompt=query\_wrapper\_prompt,

tokenizer\_name=LLM\_MODEL\_NAME,

model\_name=LLM\_MODEL\_NAME,

device\_map= "auto" ,

\# 如果使用 CUDA 则取消注释此行以减少内存使用

model\_kwargs={ "torch\_dtype" : torch.float16 , "load\_in\_8bit" : True }

)

Settings.llm = llm

5、构建知识图谱索引

从llama\_index.core.storage.storage\_context导入StorageContext

从llama\_index.core导入SimpleDirectoryReader、KnowledgeGraphIndex

从llama\_index.core.graph\_stores导入SimpleGraphStore

#设置存储上下文

graph\_store = SimpleGraphStore()

storage\_context = StorageContext.from\_defaults(graph\_store=graph\_store)

index = KnowledgeGraphIndex.from\_documents(documents=documents,

max\_triplets\_per\_chunk= 3 ,

storage\_context=storage\_context,

embed\_model=embed\_model,

include\_embeddings= True )

-

max_triplets_per_chunk :从文本的每个块中提取的三元组的最大数量。减少此数字可以加快处理速度,因为需要处理的三元组更少。

-

include_embeddings :控制是否在索引中包含嵌入。默认值为 False,因为生成嵌入可能需要大量计算。

6、可视化知识图谱

从pyvis.network导入Network

g = index.get\_networkx\_graph()

net = Network(notebook= True , cdn\_resources= "in\_line" , directed= True )

net.from\_nx(g)

net.save\_graph( "rag\_graph.html" )

从IPython.display导入HTML,显示

HTML(filename= "rag\_graph.html" )

7、询问

query\_engine = index.as\_query\_engine(llm=llm, similarity\_top\_k=5)

done = False

但未完成:

print(“\*” \*30)

question = input(“输入您的问题:”)

response = query\_engine.query(question)print

( response)

done = input(“结束聊天?(y/n):”)== “y”

三、总结

传统的基于向量的 RAG 和 Graph RAG 在存储和显示数据的方式上有所不同。向量数据库适合基于相似性比较事物。它们使用数字来衡量事物之间的距离。另一方面,知识图谱用于显示复杂的连接以及事物之间的相互依赖关系。它们使用节点和边进行语义分析和高级推理。每个都有自己的用例。

如何学习大模型?

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

这里给大家精心整理了一份全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2. 大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

3. 大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

4. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

5. 大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方CSDN官方认证二维码,免费领取【

保证100%免费】

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?