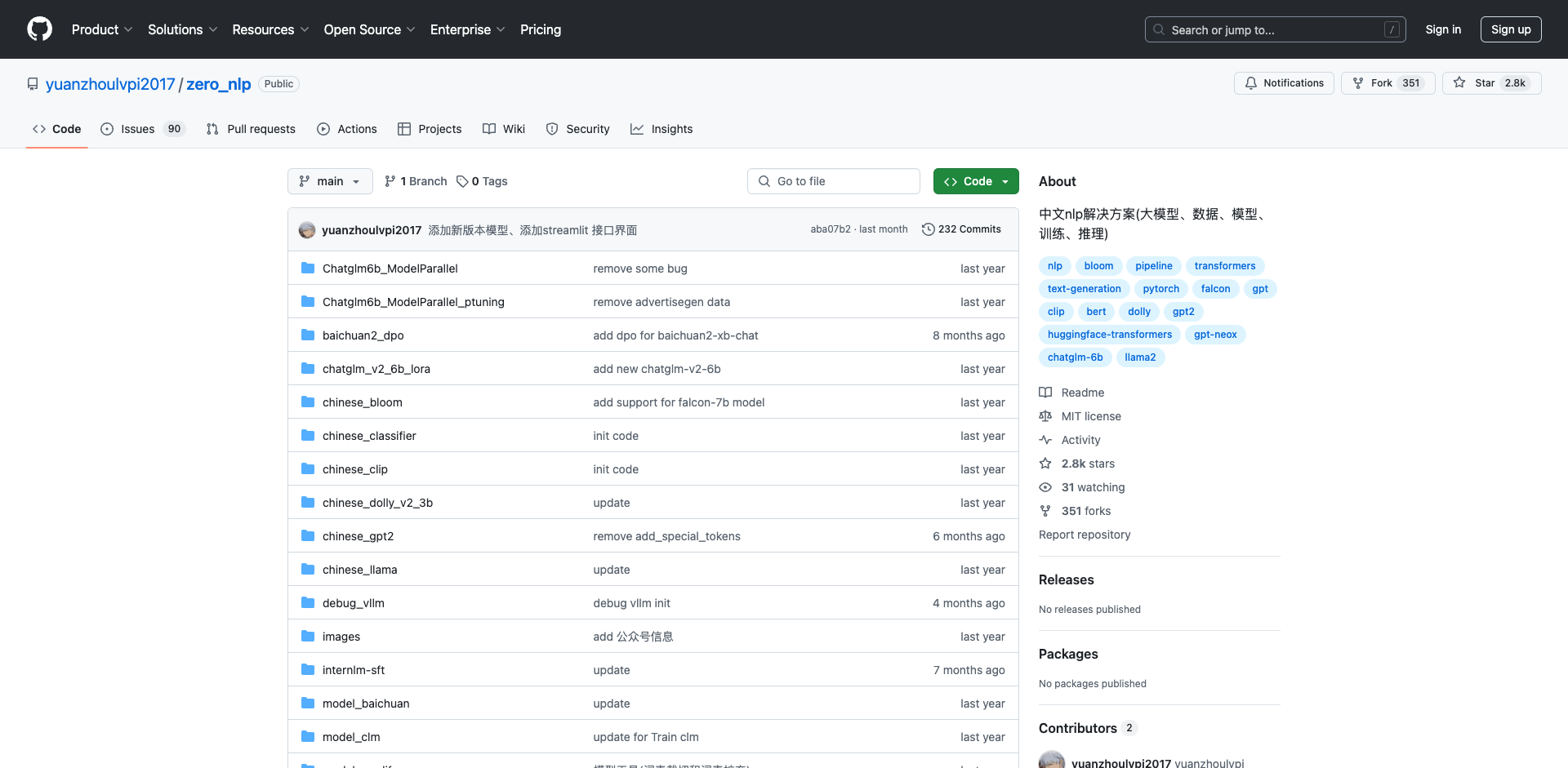

zero_nlp:从零开始的中文NLP训练框架

zero_nlp是一个面向中文自然语言处理(NLP)任务的开箱即用训练框架。该项目旨在为研究人员和开发者提供一套完整的NLP模型训练与部署解决方案,涵盖了从数据处理到模型训练、微调和部署的全流程。

主要特点

-

全面的模型支持:项目支持多种主流大型语言模型和多模态模型,包括GPT-2、CLIP、GPT-NeoX、Dolly、LLaMA、ChatGLM-6B等。这使得用户可以根据具体任务需求选择合适的模型架构。

-

丰富的数据资源:zero_nlp整合了大量开源训练数据,并提供了数据处理模板,方便用户快速处理垂直领域数据。项目采用多线程和内存映射等技术,可高效处理百GB级别的大规模数据集。

-

完整的训练流程:每个子项目都提供了完整的模型训练步骤说明,包括数据清洗、预处理、模型构建、训练、部署以及模型结构可视化等环节。

-

多卡并行支持:针对超大规模模型,zero_nlp实现了训练和推理阶段的多GPU并行功能,解决了单卡显存不足的问题。

-

模型工具:项目提供了词表裁剪和扩充等实用工具,方便用户根据需求对预训练模型进行定制化修改。

主要模块

zero_nlp包含了多个独立的子项目,覆盖了不同的NLP任务和模型架构:

-

中文文本分类:基于BERT等预训练模型实现多分类任务。

-

中文GPT-2:从预训练到微调的完整GPT-2中文版实现。

-

中文CLIP:多模态文本-图像联合学习模型的中文实现。

-

图像描述生成:基于Vision Encoder-Decoder架构的中文图像描述生成模型。

-

ChatGLM-6B:对清华大学开源的ChatGLM-6B模型进行微调。

-

中文Dolly:基于Databricks开源的Dolly模型进行中文领域适配。

-

预训练模型:提供了GPT、BLOOM等模型的中文预训练代码。

-

百川大模型:对百度开源的文心大模型进行训练和部署。

-

模型修剪:实现了大模型的词表裁剪和扩充功能。

-

流水线并行:针对LLaMA2等超大模型实现了多卡流水线并行训练。

使用方法

每个子项目都提供了详细的使用说明文档,用户可以按照以下步骤使用zero_nlp:

- 克隆项目代码库

- 安装依赖包

- 准备训练数据

- 修改配置文件

- 运行训练脚本

- 评估模型效果

- 部署模型(可选)

未来展望

zero_nlp项目仍在持续更新中。未来计划添加更多前沿NLP模型的支持,优化训练效率,并提供更多实用工具和示例。欢迎感兴趣的开发者参与贡献,共同推动中文NLP技术的发展。

总的来说,zero_nlp为中文NLP研究和应用提供了一个全面、易用的开发框架,有助于加速NLP技术在中文领域的落地与创新。无论是初学者还是专业研究人员,都可以从这个项目中获益,快速构建和优化各类NLP应用。

文章链接:www.dongaigc.com/a/from-zero-to-nlp-chinese-framework

https://www.dongaigc.com/a/from-zero-to-nlp-chinese-framework

www.dongaigc.com/p/yuanzhoulvpi2017/zero_nlp

https://www.dongaigc.com/p/yuanzhoulvpi2017/zero_nlp

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?