发表会议:NeurIPS 2024

代码地址:https://github.com/ForestsKing/GLAFF

作者:王成森,齐琦,王敬宇,孙海峰,庄子瑞,吴金明,廖建新

团队:北京邮电大学、深圳鹏程实验室

Abstract+Conclusion

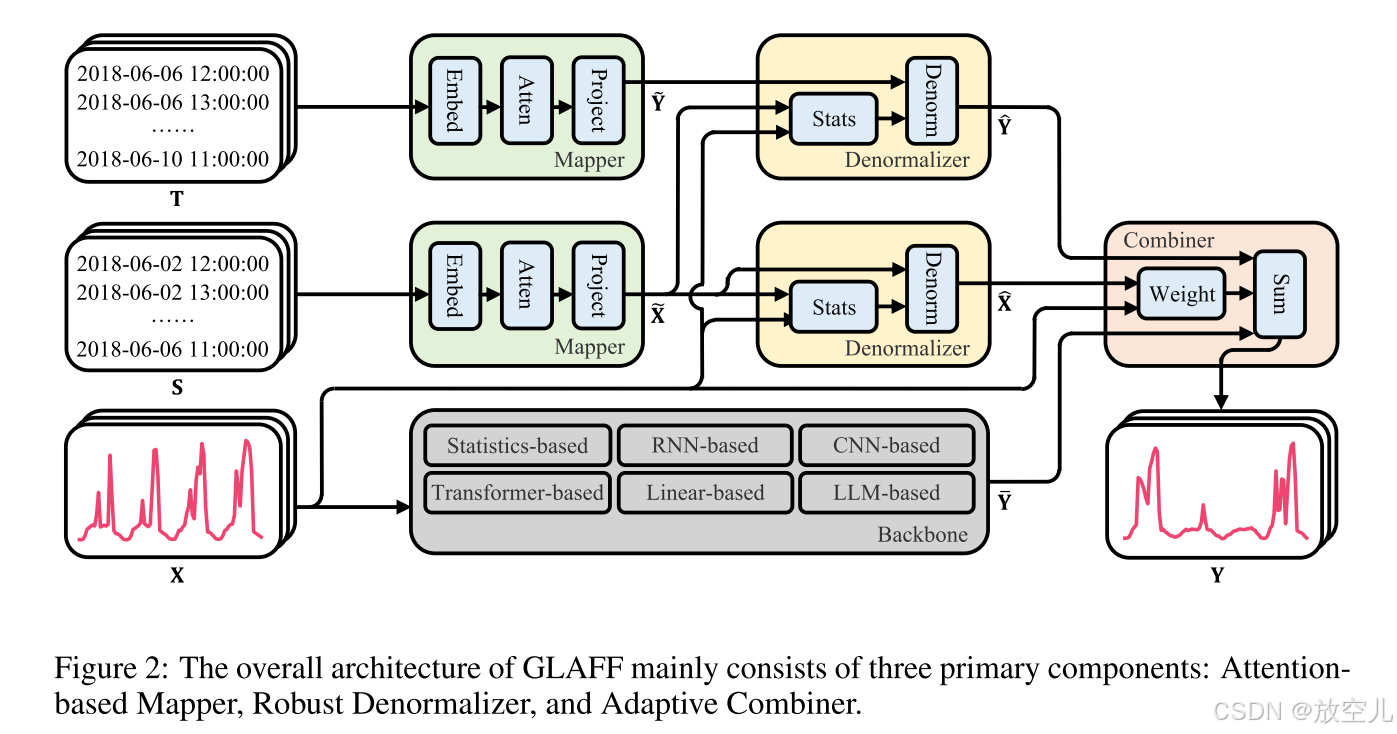

背景:现有的工作主要集中在局部预测,时间戳仅仅被当作一种可选的补充,没有得到充分利用。当从真实的世界收集的数据被污染时,全局信息的缺失将损害这些算法的鲁棒预测能力。为了解决该问题,提出一种新的框架GLAFF。在此框架内,时间戳被单独建模以捕获全局依赖性。作为一个插件,GLAFF自适应地调整全局和局部信息的组合权重,实现与任何时间序列预测主干的无缝协作。

GLAFF操作步骤:第一步采用基于注意力的映射器来单独建模包含全局信息的时间戳,并将其映射到符合标准分布的观测值,第二步处理滑动窗口的观察结果中存在异常的情况,我们利用鲁棒反规范化器来逆规范化初始映射,从而减轻数据漂移的影响。最后,自适应组合器在预测窗口内动态调整全局映射和局部预测的组合权重,从而产生最终预测结果。

Introduction

提出问题:

DLinear 和FPT 完全忽略了时间戳。Informer 和TimesNet通过将其嵌入与位置嵌入和数据嵌入相加来合并时间戳。这些相互交织的模式鼓励网络从更直观的观察中提取信息。iTransformer 将时间戳特性单独嵌入到注意力机制使用的令牌中。这种跨时间点的嵌入方法破坏了时间戳的物理意义。

FPT(特征金字塔网络),它基于transformer的思想,使用查询(query)、键(key)和值(value)来捕获上下文信息,能够生成新的特征图,该特征图可以对跨空间和跨尺度的非局部交互进行编码

验证:

使用Traffic数据集对上述模型进行了消融研究。

图1(a)中描述的结果表明,在删除时间戳后,模型的性能没有显着下降。同时,我们提出的GLAFF在主流预测模型中表现出显着的增强。当从真实的世界收集的局部信息包含异常时,全局信息的缺失将损害大多数预测技术的鲁棒预测能力。在图1(B)中,traffic是明显的周期性模式,与五个高峰(工作日)和两个低峰(周末)交替。但由于放假,24日至192日这一周出现了偏差,出现了三个高峰值和四个低峰值。从图1(B)右下角的说明中可以明显看出,主流预测模型[通常表现出可靠的预测能力。尽管如此,当历史窗口内的观测值包括异常时,如图1(B)左下角所示,这些模型会受到显著影响,并产生明显低估的预测。因此,有必要在现有的预测技术中合理地纳入更稳健的全球信息。

GLAFF的操作步骤:

第一步采用基于注意力的映射器来单独建模包含全局信息的时间戳,并将其映射到符合标准分布的观测值,第二步处理滑动窗口的观察结果中存在异常的情况,我们利用鲁棒反规范化器来逆规范化初始映射,从而减轻数据漂移的影响。最后,自适应组合器在预测窗口内动态调整全局映射和局部预测的组合权重,从而产生最终预测结果。

读完Intro学到:

模型和时间戳如何一起合并?通过将时间戳嵌入与位置嵌入和数据嵌入相加来合并时间戳

early fusion:

早期融合(特征级融合) 定义: 早期融合(特征级融合)是指在数据处理的早期阶段,将不同模态的数据融合成一个统一的表示,然后通过一个模型进行处理。 优点: 简化模型:只需要一个模型来处理融合后的表示,模型结构相对简单。 端到端学习:可以实现端到端的学习,模型可以直接从原始数据中学习到有用的特征。 缺点: 信息丢失:在融合过程中,可能会丢失某些模态的特定信息,尤其是当不同模态的数据维度和性质差异较大时。 受噪声影响大:如果某一模态的数据质量较差或含有噪声,可能会对整个融合表示产生负面影响,进而影响模型的性能。 应用场景 数据维度较小且模态间关联性强:当不同模态的数据维度较小且关联性强时,早期融合可以有效地捕捉到多模态数据的共同特征。

late fusion:

晚期融合(决策级融合) 定义: 晚期融合(决策级融合)是指每种模态的数据独立地通过各自的模型进行处理,最后将各模态的输出结果进行融合,得到最终的决策或预测结果。 优点: 最大化处理效率:每种模态的数据通过独立的模型处理,可以充分利用每种模态的特点,提高处理效率。 鲁棒性和可靠性高:由于每种模态的数据独立处理,不受其他模态噪声的影响,因此整体系统的鲁棒性和可靠性较高。 灵活的模型选择:可以根据每种模态的特点选择最适合的模型,提高模型的性能。 缺点: 模型复杂度高:需要多个模型来处理不同模态的数据,模型结构相对复杂。 融合策略设计:需要设计合适的融合策略来整合不同模态的输出结果,这可能增加系统的复杂性。

Methodology

注:本章主要讲解GLAFF的三个组件,所以每章的操作过程对照模型图看理解会更容易理解。

在骨干网络基于历史观测值 X(可能包括未充分利用的历史时间戳 S 和未来时间戳 T)提供局部预测 Y∈之后,GLAFF 利用全局信息来修正它。最初,Attention-Based Mapper通过注意力机制捕获时间戳之间的依赖关系,将时间戳特征 S 和 T 映射到初始历史映射

∈

和初始未来映射

∈

,符合标准分布。随后,Robust Denormalizer基于初始映射

和实际观测值 X 在历史窗口内的分位数偏差,将初始映射

和

反归一化到

∈

和

∈

,以减轻数据漂移的影响。最后,Adaptive Combiner根据最终映射

和历史窗口内实际观测值 X 之间的差异,动态调整全局映射

∈

和局部预测 Y 在预测窗口内的组合权重,产生最终的预测结果 Y。

Attention-based Mapper

操作过程:每个时间戳特征最初由嵌入层标记以描述其属性,通过自注意应用于相互交互,并由前馈网络单独处理以进行序列表示。随后,利用投影层来获取初始映射。利用注意力机制捕获远程依赖和并行计算的能力,Attention-Based Mapper可以充分地建模由时间戳体现的全局信息。

注:

,

表示第 i 个注意力块的中间特征变量输出,h:这通常代表序列的长度或者时间步长的数量。d:这代表特征的维度,也就是每个时间步或单词的嵌入向量的大小。

注:为了保持实现的简单性,嵌入层和投影层都由单个线性层组成。

Robust Denormalizer

科普:

什么是数据漂移?

数据漂移是指在机器学习模型的训练过程中,训练数据集和实际应用场景中的数据集之间产生了不一致性,导致模型在应用新数据时表现不佳。这种不一致性可以是量级的,也可以是结构性的。

主要分为以下两种类型:

特征漂移(Feature Drift):指模型训练时所使用的特征与实际应用场景中的特征之间产生了差异。

目标漂移(Target Drift):指训练数据集中的目标变量(即模型需要预测的变量)与实际应用场景中的目标变量之间产生了差异。

例子:一个电商网站的推荐系统最初是根据用户的历史购买数据训练的。然而,随着时间的推移,消费者的购买习惯发生了变化,比如开始更多购买新产品或不同类型的商品。如果推荐系统没有定期更新或调整,它可能继续推荐用户已经不再感兴趣的旧商品,导致推荐效果不佳。

在了解到数据漂移的存在后,GLAFF的建模策略有两个阶段: 第一阶段:基于注意力的映射(Attention-based Mapper)生成初始映射 和

,这些映射被假设为满足标准分布,为了降低建模时间戳和观测值之间依赖关系的难度。 第二阶段:利用初始映射

和实际观测值 X 在历史窗口内的分布偏差,鲁棒反归一化器(Robust Denormalizer)分别对初始映射

和

进行反归一化,生成最终映射

和

,以减轻数据漂移的影响。

减轻数据漂移的方法:

在将数据输入深度学习模型之前,通过归一化过程去除原始数据中的动态因素,然后在深度学习模型输出后,通过反归一化过程重新引入这些动态因素。传统的反归一化过程通常考虑均值和标准差的分布偏差,但这种方法容易受到极端值的影响,并且在观测值包含异常值时缺乏鲁棒性。GLAFF不依赖于均值和标准差,而是采用中位数和分位数范围来增强鲁棒反归一化器对异常值的抵抗力。这样可以更有效地处理数据中的异常值,提高模型对数据漂移的适应性。

Adaptive Combiner

在线概念漂移(online concept drifts ):它指的是随着时间的推移,数据的统计属性发生改变,导致学习模型与当前数据分布不匹配的情况。这种变化可能是由于引入了新的因素、改变了现有因素的重要性或者因素之间的关系发生了变化。

在现实世界的场景中,数据偏好对模型偏差的影响会因为在线概念漂移而不断变化。这意味着模型在不同时间点可能会对不同类型的数据表现出不同的偏好,因为数据的分布和模式在不断演变。例如,在金融市场分析中,影响股票价格的因素可能会随时间而变化,导致过去的模型参数不再适用。 这意味着在不同的时间序列模式下,模型应该能够灵活地调整对全局或局部信息的重视程度。当时间序列模式清晰且稳定时,应更加重视稳健的全局信息。当时间序列模式模糊且变化时,应更多关注灵活的局部信息。

Adaptive Combiner最初根据历史窗口内最终映射和实际观测X之间的偏差,动态调整预测窗口内全局映射

和局部预测

的组合权重。随后,我们基于组合的权重聚集双源信息以产生最终的预测Y。

参数解释:

MLP:权重生成网络是一个多层感知机(MLP),包含一个隐藏层和一个Softmax层,用于权重归一化。

∑ 表示在最后一个维度上进行求和操作。

⊕ 表示在最后一个维度上进行连接操作

Y 是通过组合权重 W与全局映射

和局部预测

的连接(concatenation)结果相乘,然后对最后一个维度进行求和(summation)得到的。

Experiment

Experimental Setup

数据集按时间顺序划分为(6:2:2)训练集,验证集和测试集,以确保没有信息泄漏问题。

这些主干包括对先前预测技术中采用的时间戳的三种不同处理,即求和(Informer,TimesNet),级联(iTransformer)和省略(DLinear)

Main Result

结论:如果主干网络(即基础预测模型)本身已经具有很强的建模能力,那么GLAFF带来的额外提升可能会相对较小。这是因为主干网络已经能够有效地捕捉数据中的模式和趋势,从而减少了对GLAFF中全局信息的依赖。相反,如果主干网络的建模能力较弱,GLAFF通过提供全局信息的补充,可以显著提高预测性能。

科普:完全忽略时间戳的DLinear,简单时间戳的iTransformer

traffic和eletricity数据集特征是多通道和周期清晰;ETTh2、ETTm2和Exchange是非平稳的

FPT完全忽略时间戳,类似于DLinear。

但是这里我跑了作者的实验,发现结果有些不同,这个图是我的实验,iTransformer在跑周期性清晰的数据,比如traffic,的确+GLAFF会有提升;但是我在跑周期性弱的数据集ETTh2的时候加了GLAFF是不如原本的iTransformer。但是,作者实验的所有结果都是优于原有模型。所以我不知道iTransformer这个模型是有另外独立的参数吗?我已经发信问原作者了,后续有消息我会发在评论区。

我的考虑是:

Prediction Showcase

在traffic中,交通量按小时记录,通常呈现工作日五个高峰和周末两个低峰的周期性。假期导致历史数据中的高峰缺失,使得Informer、DLinear和iTransformer模型错误预测未来只有低峰。TimesNet虽预测出高峰,但模式错误。GLAFF框架通过整合全局信息,帮助这四种模型准确识别高峰时段和周期性,显著提高预测准确性

在Eletricity,由于短路故障,示例历史窗口中的中间两天电力消耗出现激增。DLinear、TimesNet和iTransformer模型由于只考虑了有限的局部信息,错误地预测未来平稳段也会有激增。Informer模型虽然预测没有激增,但忽略了平稳段的存在。GLAFF框架通过引入全局信息,帮助这四种模型识别了激增的偶发性和正确的周期模式

Ablation Study

在w/o Backbone中,完全删除了GLAFF中的骨干网络,并仅使用时间戳来映射未来

在w/o注意中,用具有相等大小的MLP网络来代替堆叠的注意块

在w/o分位数中,我们用传统的逆归一化来代替鲁棒反归一化器

在w/o Adaptive中,我们用一个简单的平均机制来代替Adaptive Combiner,用于全局映射和局部预测

结论:在具有明显周期性和稳定分布的场景中,时间戳所包含的周期性模式,足以支持模型在没有局部观测信息的情况下进行准确预测。证明了GLAFF框架在处理时间序列数据时,能够有效地利用全局信息来提高预测的准确性和鲁棒性。

注意力机制在处理具有明显周期性和稳定分布的场景中,对于捕捉时间戳之间的依赖性至关重要

Efficiency Evaluation

加入GLAFF会导致训练时间平均增加23.4382 s,内存使用量增加25.0608 MB。比如:与DLinear主干相比,GLAFF的训练时间增加了14秒,内存使用量增加了25 MB,同时预测精度提高了13.1%。 内存使用稳定:GLAFF的内存使用量不受数据集大小和预测长度的影响,始终保持在大约25MB左右。这表明GLAFF在处理不同规模的数据集时具有很好的可扩展性,且对系统资源的需求相对固定。 训练时间减少:在某些特定场景下,如TimesNet主干网络在ETTh2数据集上,Informer主干网络在Traffic数据集上,DLinear主干网络,以及TimesNet主干网络,GLAFF不仅提高了预测准确性,还显著减少了训练时间。

idea

本论文工程量比较多,虽然他看起来比较简单,但是想到了之前没有人关注的区域,所以我认为他对2025年的时间序列方向的工作一定会有极大推进,有很多思路我们可以去探索,比如说在Attention-based Mapper模块把注意力模块换成更轻量和高效的架构,如扩张卷积或图神经网络。

代码讲解

代码部分,为了大家更好的阅读和探讨我在飞书进行上传,有问题大家可以在疑问区域直接评论和且代码部分每个公式我也做了详细数学介绍,绝对通俗易懂!

代码位置:Docs![]() https://h1sy0ntasum.feishu.cn/wiki/Iszhwy7ZnioZIVkPw0qcX9M2nid?from=from_copylink

https://h1sy0ntasum.feishu.cn/wiki/Iszhwy7ZnioZIVkPw0qcX9M2nid?from=from_copylink

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?