先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年最新Python全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上Python知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

如果你需要这些资料,可以添加V获取:vip1024c (备注Python)

正文

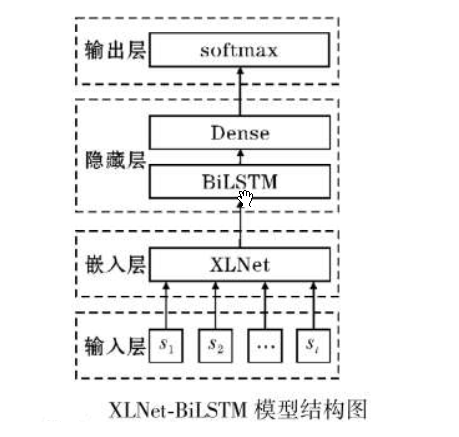

思路:将xlnet做为嵌入层提取特征,然后传入BiLSTM,最后使用全连接层输出分类。创建xlnet_lstm模型,代码如下:

class xlnet_lstm(nn.Module):

def init(self, xlnetpath, hidden_dim, output_size, n_layers, bidirectional=True, drop_prob=0.5):

super(xlnet_lstm, self).init()

self.output_size = output_size

self.n_layers = n_layers

self.hidden_dim = hidden_dim

self.bidirectional = bidirectional

xlnet ----------------重点,xlnet模型需要嵌入到自定义模型里面

self.xlnet = XLNetModel.from_pretrained(xlnetpath)

for param in self.xlnet.parameters():

param.requires_grad = True

LSTM layers

self.lstm = nn.LSTM(768, hidden_dim, n_layers, batch_first=True, bidirectional=bidirectional)

dropout layer

self.dropout = nn.Dropout(drop_prob)

linear and sigmoid layers

if bidirectional:

self.fc = nn.Linear(hidden_dim * 2, output_size)

else:

self.fc = nn.Linear(hidden_dim, output_size)

self.sig = nn.Sigmoid()

def forward(self, x, hidden):

生成xlnet字向量

x = self.xlnet(x)[0] # xlnet 字向量

lstm_out

x = x.float()

lstm_out, (hidden_last, cn_last) = self.lstm(x, hidden)

print(lstm_out.shape) #[batchsize,64,768]

print(hidden_last.shape) #[4, batchsize, 384]

print(cn_last.shape) #[4,batchsize, 384]

修改 双向的需要单独处理

if self.bidirectional:

正向最后一层,最后一个时刻

hidden_last_L = hidden_last[-2]#[batchsize, 384]

反向最后一层,最后一个时刻

hidden_last_R = hidden_last[-1]#[batchsize, 384]

进行拼接

hidden_last_out = torch.cat([hidden_last_L, hidden_last_R], dim=-1) #[batchsize, 768]

else:

hidden_last_out = hidden_last[-1] # [batchsize, 384]

dropout and fully-connected layer

out = self.dropout(hidden_last_out) #out的shape[batchsize,768]

out = self.fc(out)

return out

def init_hidden(self, batch_size):

weight = next(self.parameters()).data

number = 1

if self.bidirectional:

number = 2

if (USE_CUDA):

hidden = (weight.new(self.n_layers * number, batch_size, self.hidden_dim).zero_().float().cuda(),

weight.new(self.n_layers * number, batch_size, self.hidden_dim).zero_().float().cuda()

)

else:

hidden = (weight.new(self.n_layers * number, batch_size, self.hidden_dim).zero_().float(),

weight.new(self.n_layers * number, batch_size, self.hidden_dim).zero_().float()

)

return hidden

xlnet_lstm需要的参数功6个,参数说明如下:

--xlnetpath:xlnet预训练模型的路径

--hidden_dim:隐藏层的数量。

--output_size:分类的个数。

--n_layers:lstm的层数

--bidirectional:是否是双向lstm

--drop_prob:dropout的参数

定义xlnet的参数,如下:

class ModelConfig:

batch_size = 2

output_size = 2

hidden_dim = 384 # 768/2

n_layers = 2

lr = 2e-5

bidirectional = True # 这里为True,为双向LSTM

training params

epochs = 10

batch_size=50

print_every = 10

clip = 5 # gradient clipping

use_cuda = USE_CUDA

xlnet_path = ‘xlnet-base-chinese’ # 预训练bert路径

现在能在网上找到很多很多的学习资源,有免费的也有收费的,当我拿到1套比较全的学习资源之前,我并没着急去看第1节,我而是去审视这套资源是否值得学习,有时候也会去问一些学长的意见,如果可以之后,我会对这套学习资源做1个学习计划,我的学习计划主要包括规划图和学习进度表。

分享给大家这份我薅到的免费视频资料,质量还不错,大家可以跟着学习

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip1024c (备注python)

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip1024c (备注python)

[外链图片转存中…(img-7A9N80E9-1713416472565)]

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

1565

1565

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?