文末有福利领取哦~

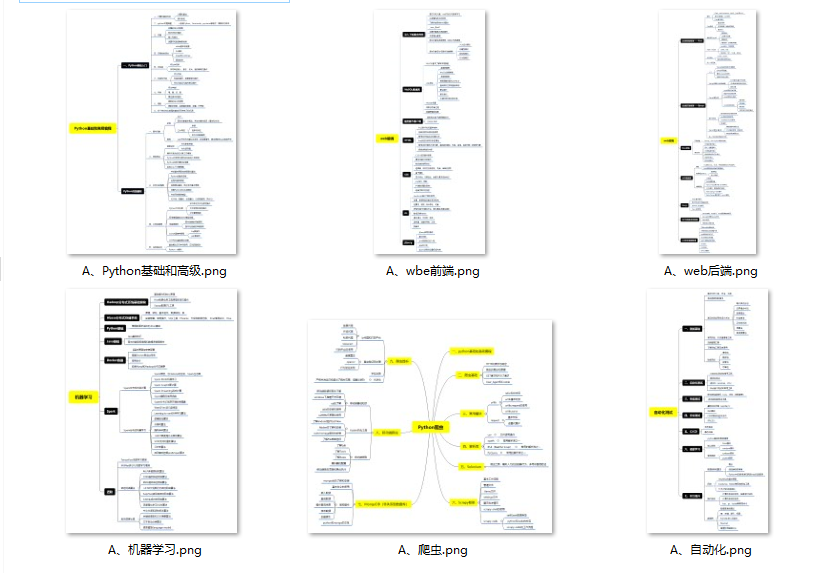

👉一、Python所有方向的学习路线

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

👉二、Python必备开发工具

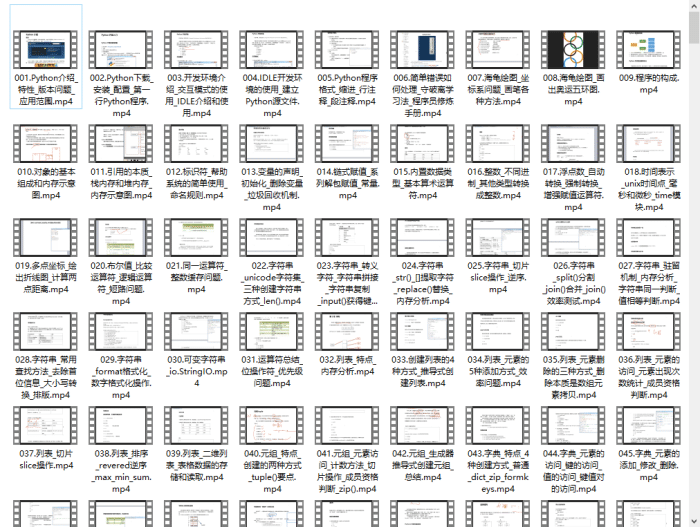

👉三、Python视频合集

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

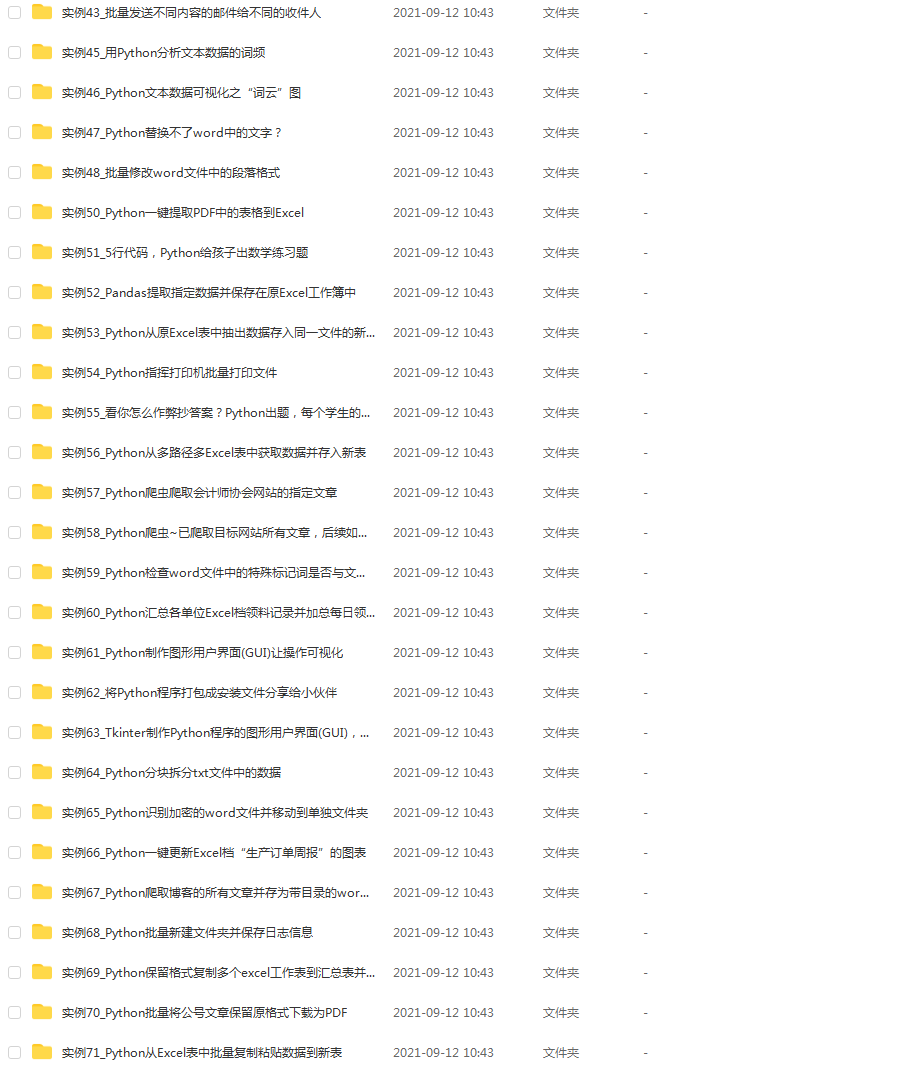

👉 四、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。(文末领读者福利)

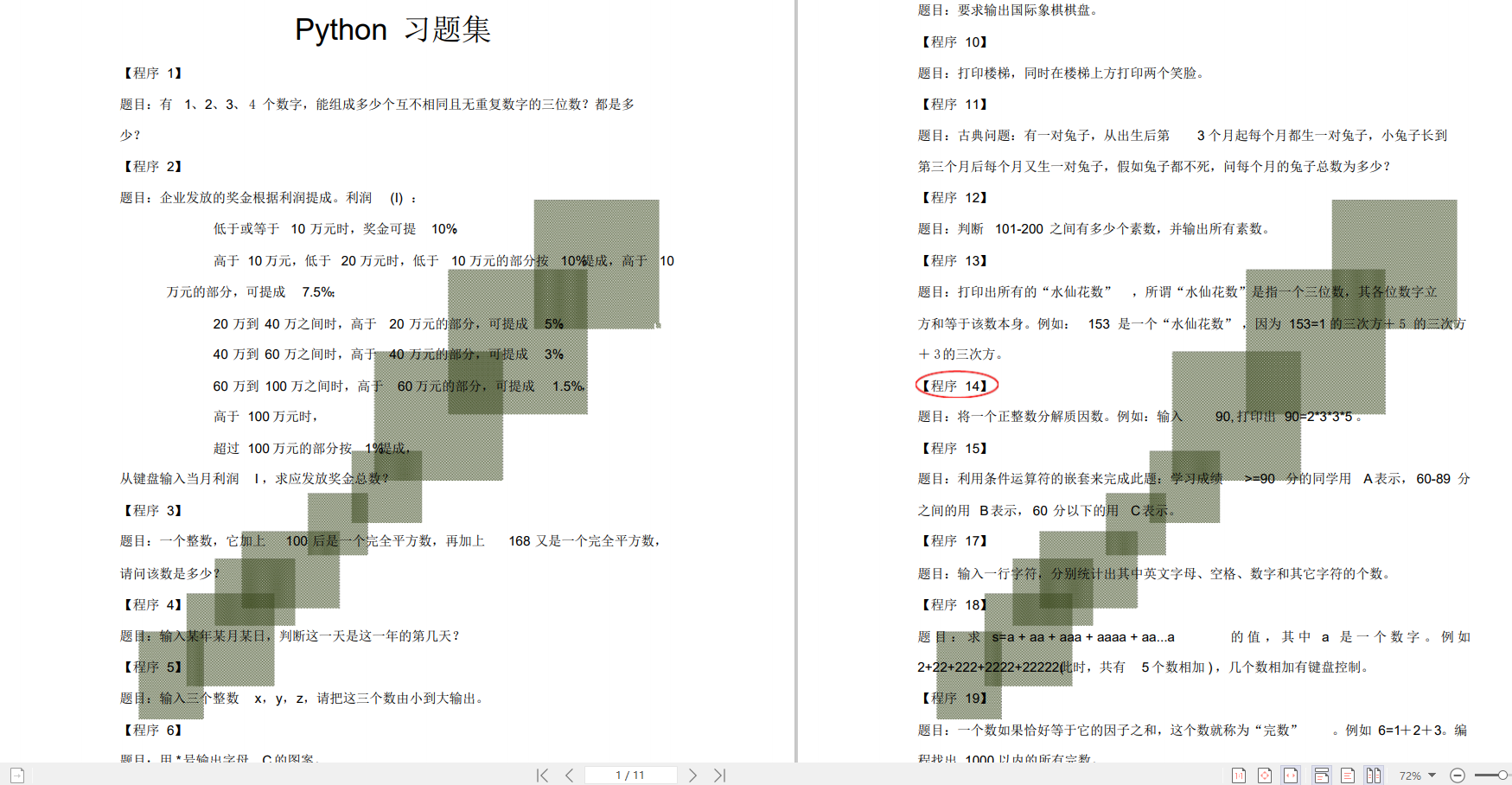

👉五、Python练习题

检查学习结果。

👉六、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

👉因篇幅有限,仅展示部分资料,这份完整版的Python全套学习资料已经上传

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

把被解释变量Y的样本条件均值表示为解释变量X的某种函数,称为样本回归函数(SRF)。(Sample regression function)

如果为线性函数:

Y i ^ = β 1 ^ + β 2 ^ X i \hat{Y_i}=\hat{β_1}+\hat{β_2}X_i Yi=β1+β2^Xi

实际观测的被解释变量值 Y i Y_i Yi不完全等于样本条件均值 Y i ^ \hat{Y_i} Yi^,二者之差可以用 e i e_i ei表示。

则: Y i − Y i ^ = e i Y_i -\hat{Y_i}=e_i Yi−Yi^=ei 或 Y i = β 1 ^ + β 2 ^ X i + e i Y_i=\hat{β_1}+\hat{β_2}X_i+e_i Yi=β1+β2Xi+ei

需要明确:样本回归函数与总体回归函数有所区别。总体回归函数虽然未知,但是是确定的:样本回归线随抽样波动而变化,可以有多条。总体回归函数的参数 β 1 和 β 2 β_1和β_2 β1和β2是确定的常数,样本回归函数的参数 β 1 ^ 和 β 2 ^ \hat{β_1}和\hat{β_2} β1和β2是随机变量。SRF与PRF总是会存在差异。

====================================================================================

五个基本假定:

- 1.零均值假定 给定解释变量 X i X_i Xi,随机扰动项 u i u_i ui的条件均值始终为零。

E ( u i ∣ X i ) = 0 E(u_i|X_i)=0 E(ui∣Xi)=0

- 2.同方差假定 对于每个给定的 X i X_i Xi,随机扰动项 u i u_i ui的条件期方差都等于一个常数 σ 2 σ^2 σ2

V a r ( u i ∣ X i ) = E [ u i − E ( u i ∣ X i ) ] 2 = E ( u i 2 ) = σ 2 Var(u_i|X_i)=E[u_i-E(u_i|X_i)]2=E(u_i2)=σ^2 Var(ui∣Xi)=E[ui−E(ui∣Xi)]2=E(ui2)=σ2

- 3.无自相关假定 随机扰动项 u i u_i ui的逐次值互不相关,或者说对于所有的i和j(i≠j), u i 和 u j 的 协 方 差 为 零 。 u_i和u_j的协方差为零。 ui和uj的协方差为零。

C o v ( u i , u j ) = E [ u i − E ( u i ) ] [ u j − E ( u j ) ] = E ( u i u j ) = 0 Cov(u_i,u_j)=E[u_i-E(u_i)][u_j-E(u_j)]=E(u_iu_j)=0 Cov(ui,uj)=E[ui−E(ui)][uj−E(uj)]=E(uiuj)=0

- 4.随机扰动项 u i u_i ui与解释变量 X i X_i Xi不相关,可表示

为 C o v ( u i , X i ) = E [ u i − E ( u i ) ] [ X i − E ( X i ) ] = 0 Cov(u_i,X_i)=E[u_i-E(u_i)][X_i-E(X_i)]=0 Cov(ui,Xi)=E[ui−E(ui)][Xi−E(Xi)]=0

- 5.正态性假定 即假定随机扰动项服从期望为0,方差为 σ 2 σ^2 σ2的正态分布,表示为

u i u_i ui~ N ( 0 , σ 2 ) N(0,σ^2) N(0,σ2)

满足此五个假设的线性回归模型,称为古典线性回归模型(CLRM)

其中四个假定,也可以用 Y i Y_i Yi表示:

对零均值假定有: E ( Y i ∣ X i ) = β 1 + β 2 X i E(Y_i|X_i)=β_1+β_2X_i E(Yi∣Xi)=β1+β2Xi

对同方差假定有: V a r ( Y i ∣ X i ) = σ 2 Var(Y_i|X_i)=σ^2 Var(Yi∣Xi)=σ2

对无自相关假定有: C o v ( Y i , Y j ) = 0 ( i ≠ j ) Cov(Y_i,Y_j)=0(i≠j) Cov(Yi,Yj)=0(i=j)

对正态性假定有: Y Y Y~ N ( β 1 + β 2 X i , σ 2 ) N(β_1+β_2X_i,σ^2) N(β1+β2Xi,σ2)

用产生样本概率最大的原则去确定样本回归函数,称为极大似然准则;

用估计剩余平方和最小的原则确定样本回归函数,称为最小二乘准则。

最小二乘法,也称最小二乘估计(OLS或OLSE)

最小二乘法使样本回归函数尽可能地接近总体回归函数,需满足最小二乘准则,使剩余平方和 Σ e i 2 Σe_i^2 Σei2最小。

即

m i n Σ e i 2 = m i n Σ ( Y i − Y i ^ ) 2 = m i n Σ ( Y i − β 1 ^ − β 2 ^ X i ) 2 minΣe_i2=minΣ(Y_i-\hat{Y_i})2=minΣ(Y_i-\hat{β_1}-\hat{β_2}X_i)^2 minΣei2=minΣ(Yi−Yi)2=minΣ(Yi−β1−β2^Xi)2

…

β 2 ^ = Σ ( X i − X ‾ ) ( Y i − Y ‾ ) Σ ( X i 2 − X ^ ) = x i y i x i 2 \hat{β_2}=\frac{Σ(X_i-\overline{X})(Y_i-\overline{Y})}{Σ(X_i2-\hat{X})}=\frac{x_iy_i}{x_i2} β2=Σ(Xi2−X)Σ(Xi−X)(Yi−Y)=xi2xiyi

β 1 ^ = Y ‾ − β 2 ^ X ‾ \hat{β_1}=\overline{Y}-\hat{β_2}\overline{X} β1=Y−β2X

用普通最小二乘法拟合的样本回归线有以下性质

-

样本回归线通过样本均值。

-

估计值 Y i ^ \hat{Y_i} Yi^的均值 Σ Y i ^ n \frac{Σ\hat{Y_i}}{n} nΣYi^等于实际 Y i Y_i Yi的均值。

-

剩余项 e i e_i ei的均值的为0。

-

被解释变量估计值 Y i ^ \hat{Y_i} Yi^与剩余项 e i e_i ei不相关。

-

解释变量 X i X_i Xi与剩余项 e i e_i ei不相关。

2.4.1 参数估计量的评价标准

选择参数估计量时应考虑以下一些标准:

1.无偏性

如果参数的估计量 β ^ \hat{β} β^的期望等于参数的真实值β,即 E ( β ^ ) = β E(\hat{β})=β E(β^)=β,则称 β ^ \hat{β} β^是参数β的无偏估计量。

如果参数估计量 β ∗ β^* β∗是期望值不等于参数β的真实值,则称 β ∗ β^* β∗是有偏的,其偏倚为 E ( β ∗ ) − β E(β^*)-β E(β∗)−β,也称系统误差。无偏即无系统误差。

计量经济研究中应尽可能寻找符合无偏性要求的参数估计量。

2.有效性

一个估计量若不仅有无偏性,而且具有最小方差性,则称这个估计量为有效估计量。

即对于参数β的无偏估计量 β ^ \hat{\beta} β^,如果对于参数的任意一个无偏估计量 β ∗ \beta^* β∗,都有 V a r ( β ^ ) ≤ V a r ( β ∗ ) Var(\hat{β})≤Var(β^*) Var(β^)≤Var(β∗),则称 β ^ \hat{β} β^是参数β的有效估计量。

或者说, β ^ \hat{β} β^较 β ∗ β^* β∗有效。

3.一致性

样本容量趋于无穷大时,如果估计量, β ^ \hat{β} β^的抽样分布依概率收敛于总体参数真实值β,即

P lim n → ∞ β ^ = β P \displaystyle \lim_{n \rightarrow \infty} \hat{\beta}=β Pn→∞limβ^=β

或 lim n → ∞ P [ ( ∣ β ^ − β ∣ ) < ε ] = 1 \displaystyle \lim_{n \rightarrow \infty}P[(|\hatβ-β|)<ε]=1 n→∞limP[(∣β^−β∣)<ε]=1

也就是说,当样本容量n→∞时,估计量 β ^ \hat{β} β^与总体参数真实值β的距离 β ^ − β \hat{β}-β β^−β的绝对值小于任意给定正数ε的概率等于1,则称估计量 β ^ \hat{β} β^为一致估计量。

(也称相合性,相合估计量)

2.4.2OLS估计量的统计特性

在古典假定完全满足的情况下,回归模型参数的最小二乘估计量具有以下统计性质。

1.线性特性

由 β 2 ^ = x i y i x i 2 \hat{β_2}=\frac{x_iy_i}{x_i^2} β2^=xi2xiyi,详细过程略

可以有 β 2 ^ = Σ k i Y i \hat{β_2}=Σk_iY_i β2^=ΣkiYi,其中 k i k_i ki是一组常数,所以 β 2 ^ \hat{β_2} β2^是 Y i Y_i Yi的线性相关函数。

类似也有, β 1 ^ \hat{β_1} β1^是 Y i Y_i Yi的线性相关函数。

2.无偏性

E ( β 2 ^ ) = β 2 E(\hat{β_2})=β_2 E(β2^)=β2

E ( β 1 ^ ) = β 1 E(\hat{β_1})=β_1 E(β1^)=β1

这表明最小二乘法估计的参数 β 1 β_1 β1和 β 2 β_2 β2的期望值等于总体回归函数参数的真实值 β 1 β_1 β1和 β 2 β_2 β2,所以OLS估计式是无偏估计量。

3.有效性

普通最小二乘估计 β 1 ^ \hat{β_1} β1^和 β 2 ^ \hat{β_2} β2^具有最小的方差。证明过程略。

也可以用标准误差度量估计量的精确性,标准误差(standard error)是方差的平方根,可以用SE表示。

V a r ( β 2 ^ ) = σ 2 Σ x i 2 Var(\hat{β_2})=\frac{σ2}{Σx_i2} Var(β2^)=Σxi2σ2

V a r ( β 1 ^ ) = σ 2 ∑ X i 2 n ∑ x i 2 Var(\hat{β_1})=σ^2 \frac{\sum{X_i^2}}{n \sum{x_i^2}} Var(β1^)=σ2n∑xi2∑Xi2

S E ( β 2 ^ ) = σ ∑ x i 2 SE(\hat{β_2})=\frac{σ}{\sqrt{\sum x_i^2}} SE(β2^)=∑xi2 σ

S E ( β 1 ^ ) = σ ∑ X i 2 n ∑ x i 2 SE(\hat{β_1})=σ \sqrt{\frac{\sum X_i^2}{n \sum x_i^2}} SE(β1^)=σn∑xi2∑Xi2

其中 σ 2 σ^2 σ2作为总体随机扰动项 u i u_i ui的方差是未知的,也需要通过样本估计。

用 σ 2 ^ = ∑ e i 2 n − 2 \hat{σ^2}=\frac{\sum e_i^2}{n-2} σ2^=n−2∑ei2计算的 σ 2 σ^2 σ2的估计值 σ 2 ^ \hat{σ^2} σ2^是对 σ 2 σ^2 σ2的无偏估计。

e i 2 e_i^2 ei2是剩余平方和;n-2是自由度。

综上,OLS估计量 β 1 ^ \hat{β_1} β1^和 β 2 ^ \hat{β_2} β2^是总体参数 β 1 β_1 β1和 β 2 β_2 β2的最佳线性无偏估计量。(Best linear unbiased estimator,BLUE)。这个结论也称高斯-马尔可夫定理。

==============================================================================

所估计样本回归线对样本观测数据拟合的优劣程度,称为样本回归线的拟合优度。

-

被解释变量Y的样本观测值与其平均值的离差平方和 ∑ ( Y i − Y ‾ ) 2 = ∑ y i 2 \sum{(Y_i-\overline{Y})2}=\sum{y_i2} ∑(Yi−Y)2=∑yi2,称为总变差或总离差平方和(total sum of squares)。用TSS表示。

-

被解释变量Y的样本估计值与其平均值的离差平方和 ∑ ( Y i ^ − Y ‾ ) 2 = ∑ y i ^ 2 \sum{(\hat{Y_i}-\overline{Y})}2=\sum{\hat{y_i}2} ∑(Yi−Y)2=∑yi2,称为回归解释平方和。是由模型回归线作出解释的变差,用ESS表示。

-

被解释变量观测值与估计值之间的平方和 ∑ ( Y i − Y i ^ ) 2 = ∑ e i 2 \sum{(Y_i-\hat{Y_i})}^2= \sum{e_i^2} ∑(Yi−Yi^)2=∑ei2,是回归线未作出解释的平方和,称为残差平方和(residualc sum of squares),用RSS*表示。(未解释平方和)

三者关系:

TSS=ESS+RSS

∑ ( Y i − Y ‾ ) 2 = ∑ ( Y i ^ − Y ‾ ) 2 + ∑ ( Y i − Y i ^ ) 2 \sum{(Y_i-\overline{Y})}2=\sum{(\hat{Y_i}-\overline{Y})}2+\sum{(Y_i-\hat{Y_i})}^2 ∑(Yi−Y)2=∑(Yi−Y)2+∑(Yi−Yi)2

∑ y i 2 = ∑ y i ^ 2 + ∑ e i 2 \sum{y_i2}=\sum{\hat{y_i}2}+\sum{e_i^2} ∑yi2=∑yi^2+∑ei2

TSS=ESS+RSS

1 = E S S T S S + R S S T S S = 解 释 平 方 和 的 权 重 + 未 解 释 平 方 和 的 权 重 1 = \frac{ESS}{TSS}+\frac{RSS}{TSS}=解释平方和的权重+未解释平方和的权重 1=TSSESS+TSSRSS=解释平方和的权重+未解释平方和的权重

其中解释平方和的权重可以作为综合度量回归模型对样本观测值拟合优度的指标,这一比例成为可决系数。在简单线性回归中一般用 r 2 r^2 r2或 R 2 R^2 R2表示,即

R 2 = ∑ ( Y i ^ − Y ‾ ) 2 ∑ ( Y i − Y ‾ ) 2 = y i 2 ^ y i 2 R2=\frac{\sum{(\hat{Y_i}-\overline{Y})}2}{\sum{(Y_i-\overline{Y})}2}=\frac{\hat{y_i2}}{y_i^2} R2=∑(Yi−Y)2∑(Yi−Y)2=yi2yi2

或 R 2 = 1 − ∑ ( Y i − Y i ^ ) 2 ∑ ( Y i − Y ‾ ) 2 = 1 − ∑ e i 2 ∑ y i 2 R2=1-\frac{\sum{(Y_i-\hat{Y_i})}2}{\sum{(Y_i-\overline{Y})2}}=1-\frac{\sum{e_i2}}{\sum{y_i^2}} R2=1−∑(Yi−Y)2∑(Yi−Yi^)2=1−∑yi2∑ei2

一元线性回归中,可决系数 R 2 R^2 R2在数值上,是简单线性相关系数r的平方。即

r = ± R 2 r=± \sqrt{R^2} r=±R2

但二者在概念上是明显区别的。

r X Y = ∑ ( X i − X ‾ ) ( Y i − Y ‾ ) ∑ ( X i − X ‾ ) 2 ∑ ( Y i − Y ‾ ) 2 r_{XY}=\frac{\sum(X_i-\overline X)(Y_i-\overline Y)}{\sqrt{\sum{(X_i-\overline{X})^2} \sum{(Y_i-\overline Y)^2}}} rXY=∑(Xi−X)2∑(Yi−Y)2 ∑(Xi−X)(Yi−Y)

R 2 = [ ∑ ( X i − X ‾ ) ( Y i − Y ‾ ) ] 2 ∑ ( X i − X ‾ ) 2 ∑ ( Y i − Y ‾ ) 2 R^2=\frac{[\sum(X_i-\overline X)(Y_i-\overline Y)]2}{\sum{(X_i-\overline{X})2} \sum{(Y_i-\overline Y)^2}} R2=∑(Xi−X)2∑(Yi−Y)2[∑(Xi−X)(Yi−Y)]2

可决系数取值范围为 0 ≤ R 2 ≤ 1 0≤R^2≤1 0≤R2≤1;不相关系数可正可负,取值范围为 − 1 ≤ r ≤ 1 -1≤r≤1 −1≤r≤1。

=====================================================================================

在古典假定条件下,假定随机扰动项 u i u_i ui服从正态分布,则 Y i Y_i Yi也服从正态分布。

又因为 β 1 ^ \hat{β_1} β1^, β 2 ^ \hat{β_2} β2^都是 Y i Y_i Yi的线性函数,所以即使在小样本情况下, β 1 ^ \hat{β_1} β1^和 β 2 ^ \hat{β_2} β2^也服从正态分布。在大样本情况下,即使 Y i Y_i Yi不服从正态分布, β 1 ^ \hat{β_1} β1^和 β 2 ^ \hat{β_2} β2^也会趋于正态分布。

β 1 ^ \hat{β_1} β1^和 β 2 ^ \hat{β_2} β2^的具体分布可表示为:

β 1 ^ \hat{β_1} β1^~ N ( β 1 , σ 2 ∑ X i 2 n ∑ x i 2 ) N(β_1,σ^2 \frac{\sum{X_i^2}}{n \sum{x_i^2}}) N(β1,σ2n∑xi2∑Xi2)

β 2 ^ \hat{β_2} β2^~ N ( β 2 , σ 2 Σ x i 2 ) N(β_2,\frac{σ2}{Σx_i2}) N(β2,Σxi2σ2)

将 β 1 ^ \hat{β_1} β1^和 β 2 ^ \hat{β_2} β2^做标准化转换:

z 1 = β 1 ^ − β 1 S E ( β 1 ^ ) z_1=\frac{\hat{β_1}-β_1}{SE(\hat{β_1})} z1=SE(β1)β1−β1~ N ( 0 , 1 ) N(0,1) N(0,1)

z 2 = β 2 ^ − β 2 S E ( β 2 ^ ) z_2=\frac{\hat{β_2}-β_2}{SE(\hat{β_2})} z2=SE(β2)β2−β2~ N ( 0 , 1 ) N(0,1) N(0,1)

β 1 ^ \hat{β_1} β1^和 β 2 ^ \hat{β_2} β2^的方差即标准正态变量 z 1 z_1 z1, z 2 z_2 z2的确定,都要涉及随机扰动项 u i u_i ui的方差 σ 2 σ^2 σ2,而总体随机扰动项 u i u_i ui是随机变量,其方差是未知的,只能通过 σ 2 ^ = ∑ e i 2 n − 2 \hat{σ^2}=\frac{\sum e_i^2}{n-2} σ2^=n−2∑ei2计算 σ 2 σ^2 σ2的无偏估计 σ 2 ^ \hat{σ^2} σ2^。

在大样本情况下,用无偏估计 σ 2 ^ \hat{σ^2} σ2^替代 σ 2 σ^2 σ2,可计算参数估计值的标准误差,这个时候标准化后的 z 1 z_1 z1, z 2 z_2 z2仍可视为标准正态分布变量。

小样本情况下,其不再服从正态分布,而是服从自由度为n-2的t分布。t~ t ( n − 2 ) t(n-2) t(n−2)

对回归系数假设检验的基本思路是,在所估计样本的回归系数概率分布性质已确定的基础上,在对总体回归系数某种原假设(或称零假设)成立的条件下,利用适当的有明确概率分布的统计量和给定的显著性水平α,构造一个小概率事件。判断原假设合理与否,是基于“小概率事件不会发生”的原理。如果小概率事件发生了,就拒绝原假设,不拒绝备择假设。

对总体参数假设检验可能有不同的要求,可以检验总体参数是否等于、大于或小于某特定数值 β ∗ β^* β∗,这时假设检验分别为 H 0 : β 2 = β 2 ∗ H_0:β_2=β_2^* H0:β2=β2∗、 H 0 : β 2 ≥ β 2 ∗ H_0:β_2≥β_2^* H0:β2≥β2∗、 H 0 : β 2 ≤ β 2 ∗ H_0:β_2≤β_2^* H0:β2≤β2∗。

也可以检验总体参数是否等于0。

原假设和备择假设的设定方式不同,判断是否拒绝区域的方式也不同。

最后

🍅 硬核资料:关注即可领取PPT模板、简历模板、行业经典书籍PDF。

🍅 技术互助:技术群大佬指点迷津,你的问题可能不是问题,求资源在群里喊一声。

🍅 面试题库:由技术群里的小伙伴们共同投稿,热乎的大厂面试真题,持续更新中。

🍅 知识体系:含编程语言、算法、大数据生态圈组件(Mysql、Hive、Spark、Flink)、数据仓库、Python、前端等等。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

819

819

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?