| 《云计算系统架构及应用》实验报告 | ||||

| 题目: | 熟悉常用的LINUX操作和hadoop部署相关操作 | 姓名 | 日期 | |

| 实验环境: 操作系统:Linux Hadoop版本:2.7.3 | ||||

| 实验内容与完成情况: (一)熟悉常用的Linux操作 请按要求上机实践如下linux基本命令。 cd命令:切换目录 (1)切换到目录 /usr/local

(2)去到目前的上层目录

(3)回到自己的主文件夹(/home/zkpk)

ls命令:查看文件与目录

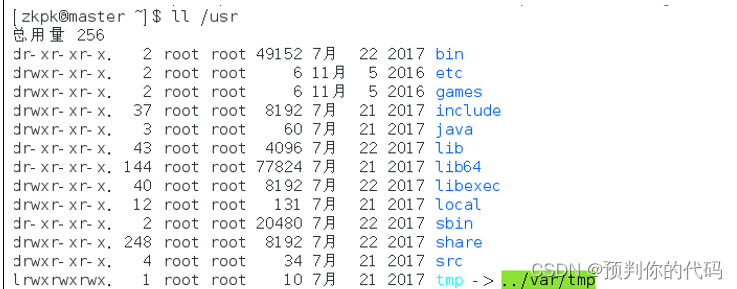

(4)查看目录/usr下所有的文件

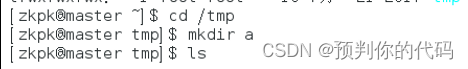

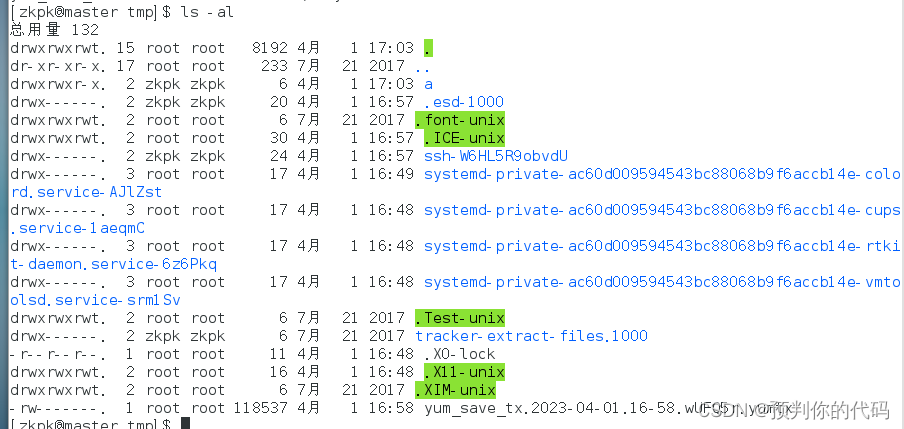

mkdir命令:新建新目录 (5)进入/tmp目录,创建一个名为a的目录,并查看有多少目录存在

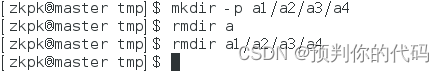

(6)进入/tmp目录,创建目录a1/a2/a3/a4 rmdir命令:删除空的目录

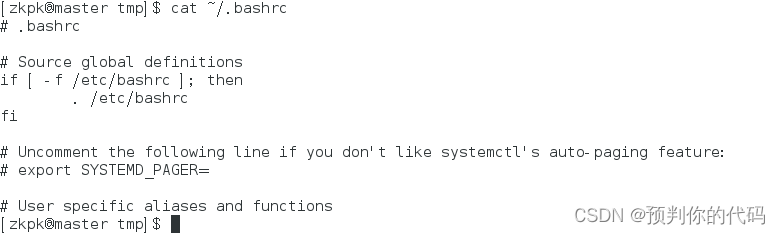

(7)将上例创建的目录a(/tmp下面)删除 (8)删除目录a1/a2/a3/a4 cp命令:复制文件或目录 (9)将主文件夹下的.bashrc复制到/usr下,命名为bashrc1 (10)在/tmp下新建目录test,再复制这个目录内容到/usr mv命令:移动文件与目录,或更名 (11)将上例文件bashrc1移动到目录/usr/test (12)将上例test目录重命名为test2 rm命令:移除文件或目录 (13)将上例复制的bashrc1文件删除 (14)将上例的test2目录删除 cat命令:查看文件内容 (15)查看主文件夹下的.bashrc文件内容

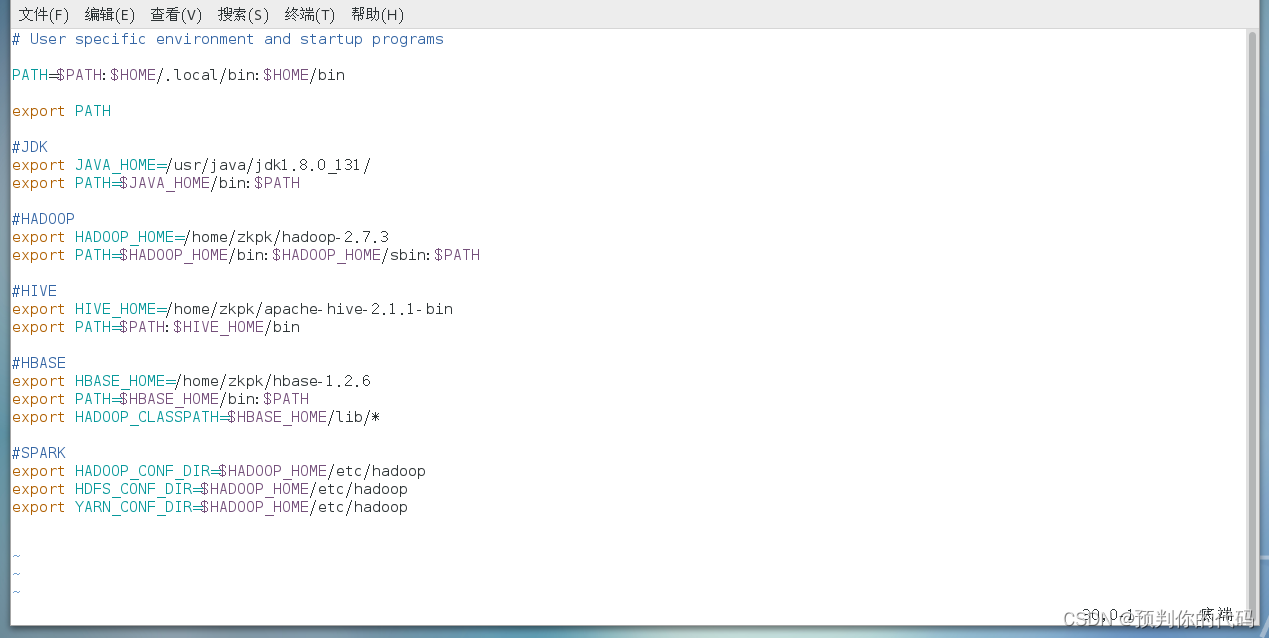

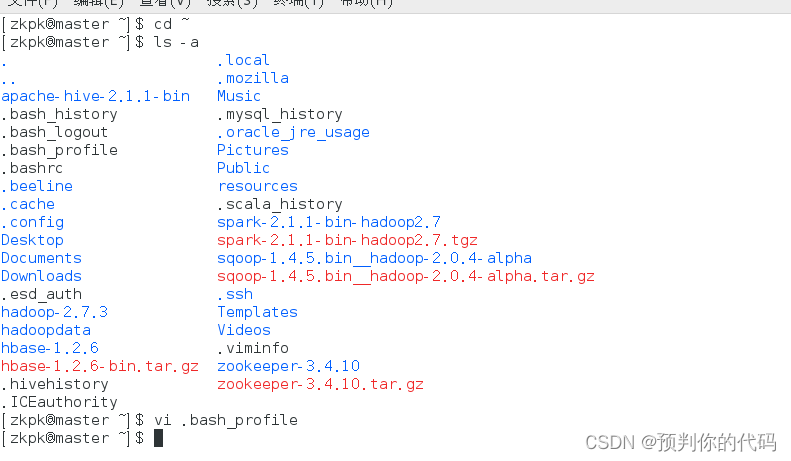

(16)配置Java环境变量,在~/.bashrc中设置 (1)用文本编辑器打开用户目录下的.bashrc文件

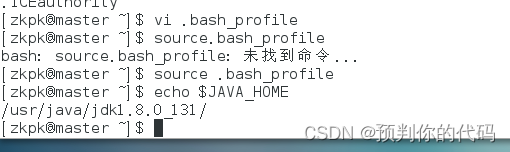

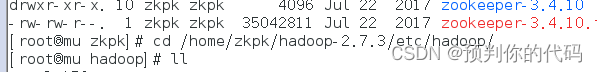

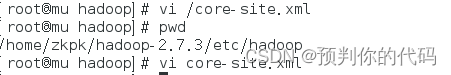

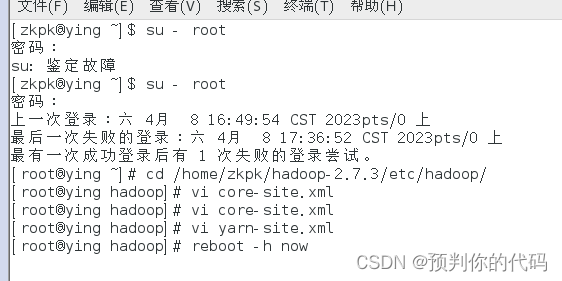

(2)在.bashrc文件末尾加入: set JAVA_HOME=/usr/share/jdk1.5.0_05 export JAVA_HOME set PATH=$JAVA_HOME/bin:$PATH export PATH set CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar export CLASSPATH (3)重新登录 (17)查看JAVA_HOME变量的值 (二)熟悉Hadoop部署时的相关操作 (1)请写出Hadoop部署时,可能会用到的配置文件,及所在路径。每个配置文件可能配置的属性有什么,及属性用途。 用到的配置文件:core-site.xml和hdfs-site.xml 路径:Hadoop 的配置文件位于 /home/zkpk/hadoop-2.7.3 配置属性:name 和 value hadoop.tmp.dir 持久化配置防止断电时丢失 fs.defaultFS 修改端口号 dfs.replication 设置备份系数 dfs.namenode.name.dir作用是存放hadoop的名称节点namenode里的metadata dfs.datanode.data.dir 是存放HDFS文件系统数据文件的目录,作用是存放hadoop的数据节点datanode里的多个数据块 (2)Hadoop部署为伪分布式模式后,若想改为单机模式,如何设置。 删除 core-site.xml 中的配置项 (3)Hadoop部署为伪分布式模式,没有配置yarn,是否会出错,若不出错,部署成功后,如何启动。 伪分布式不启动YARN也可以,一般不会影响程序执行Ok qidong hdfs 1.格式化:hdfs namenode -format 2.启动hadoop Start-dfs.sh Start-yarn.sh

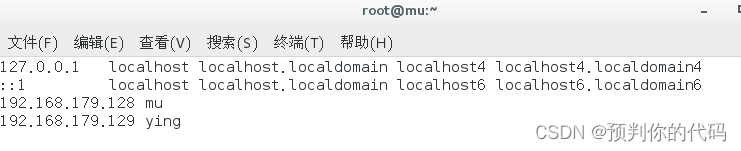

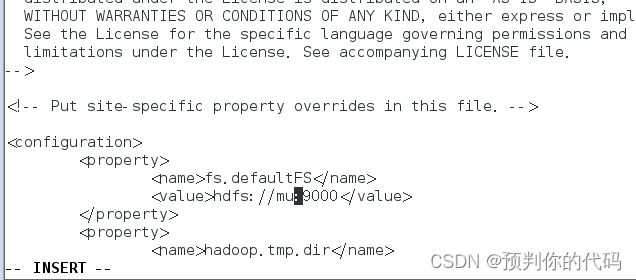

(4)Hadoop部署为伪分布式模式后,在此基础上,如何设置,就为分布式模式。 修改从节点文件 slaves 修改/home/zkpk/hadoop-2.7.3 1.slaves 将文件中原来的 localhost 删除,只添加一行内容:Slave1 2.core-site.xml

3.hdfs-site.xml Dfs.replication 设为1(一般是3) 4.mapred-site.xml

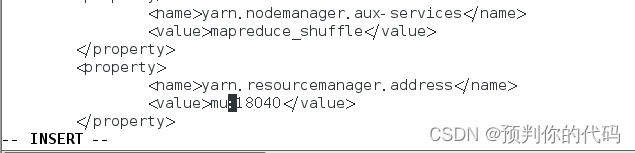

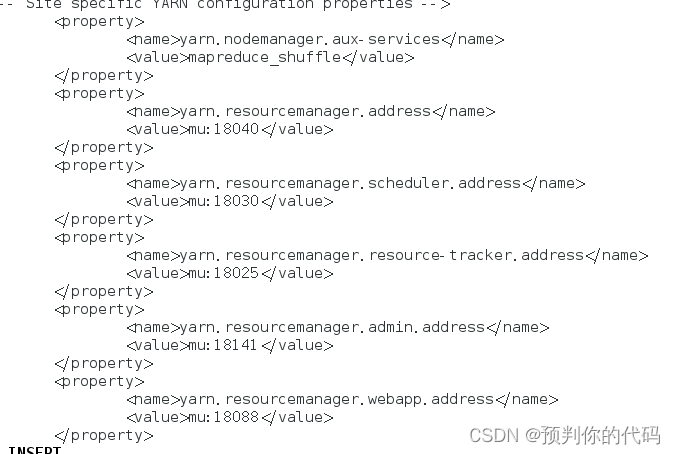

5.yarn-site.xml

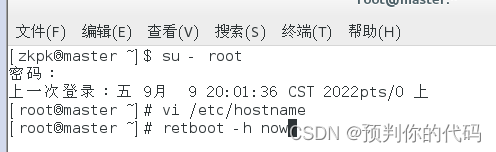

(5)在本机Hadoop实验环境下,修改主节点和从节点名称,主节点名称为你的姓(拼音),从节点的名称为你的名(拼音),主机名修改后,还要修改哪些设置内容,本机Hadoop实验环境才会正常运行。 1.以root身份修改/etc/hostname 的名字

2.重启

3.修改映射 vi/etc/hosts 4.修改配置文件

5.重启

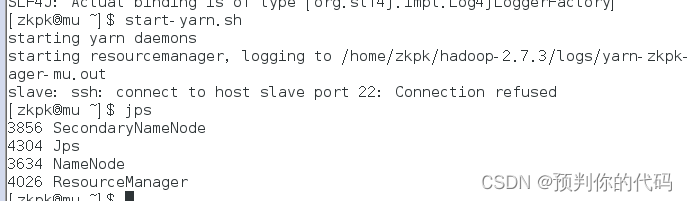

6.启动hadoop Start-dfs.sh Start-yarn.sh

7.修改从节点配置文件

| ||||

| 出现的问题:1.修改文件内容时没有权限,对于普通用户只是可读文件,要以root身份进入后修改文件 2.修改后要重启 3.配置文件不但要修改主节点的配置文件,还要修改从节点的配置文件 | ||||

| 解决方案(列出遇到的问题和解决办法,列出没有解决的问题):

| ||||

云计算 熟悉常用的LINUX操作和hadoop部署相关操作 实验报告

最新推荐文章于 2023-06-20 16:40:15 发布

5775

5775

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?