也许有的时候结果并不是最重要的,下面来看一下这个爬虫项目的反思,过程有的时候比结果更重要,更值得细细体会!

2.爬虫项目的分析

一个数据分析的过程,一般分几步,数据的爬取->数据的清洗->数据的存储->数据可视化分析->再深一点就是数据挖掘!

用到的知识其实非常多,我们一共分了3期走:

- 第一期是爬取

- 第二期是存储

- 第三期是数据可视化

非常有趣的一个项目,至少我自己是很感兴趣的。

1).安装环境和工具的准备

工欲善其事,必先利其器!第一步是安装环境,推荐Pycharm,当然有人喜欢用sublime,Atom等等都可以,你自己用的顺手就可以了!爬虫用的库可以有很多选择,我们主推requests,解析的库用bs4,xpath,pyquery这些都可以,看你自己用的爽,用的熟练就行!

2).目标网站的分析

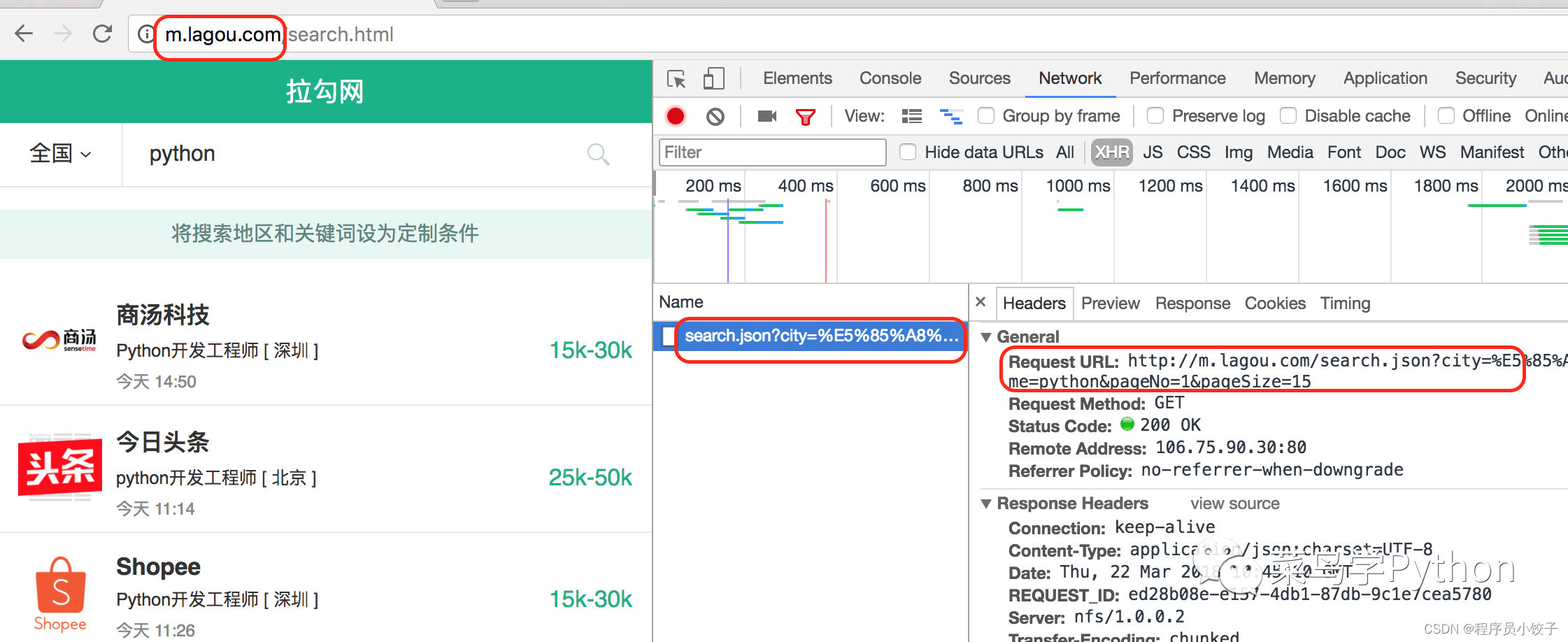

这次群里还请到了一位爬虫高手阿蔡的加入,以前一直玩爬虫的。加入了我们的实战群指点大家,拉勾的网站非常熟悉,我们可以有两种方法去爬取

- 手机网站的爬取,手机站点会容易很多,简单分析之后就可以得到网站的数据,几行代码就可以获取的json格式的职位数据集

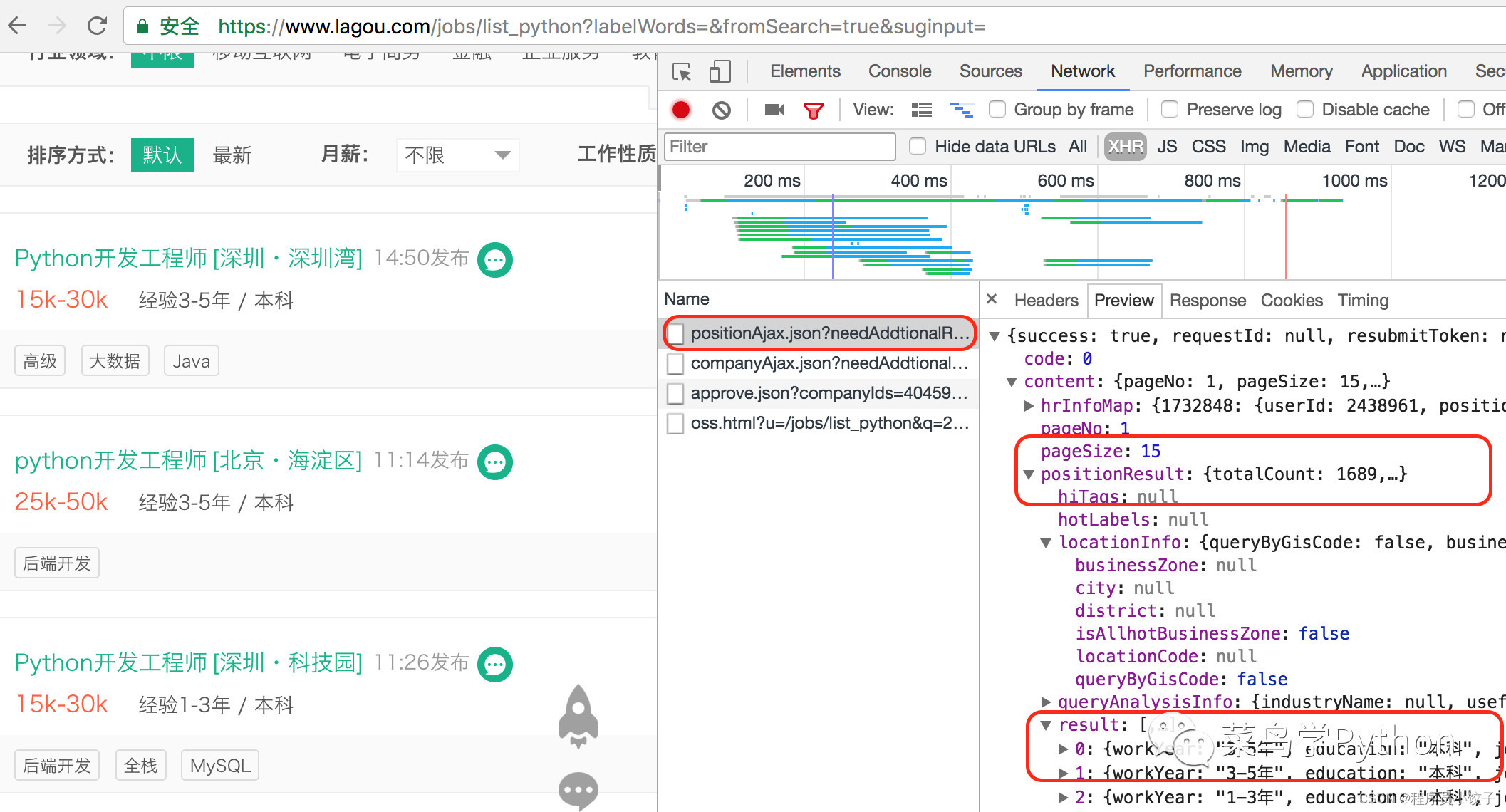

- PC网站的爬取,PC端会稍微复杂一些,因为数据是动态加载的,仔细的分析http请求内容,也很快可以找到入口

3).数据的解析

因为我们返回的是json数据,非常好分析,建议可以用pprint这款神器库先打印一下,找到我们要的职位的数据!

手机端的数据长这样:

{'city': '上海',

'company\_full\_names': '拉扎斯网络科技(上海)有限公司',

'company\_name': '饿了么',

'create\_time': '2018-03-20',

'positionId': 2779439,

'positionName': 'Python开发工程师(全栈)',

'salary': '15k-25k'}

PC端的数据会稍微丰富一些,长这样:

{

'businessZones': ['东四', '美术馆', '北新桥'],

'city': '北京',

'companyFullName': '凡普金科企业发展(上海)有限公司',

'companyLabelList': ['年底双薪', '节日礼物', '技能培训', '带薪年假'],

'createTime': '2018-03-22 10:41:03',

'education': '本科',

'linestaion': '5号线_东四;5号线_张自忠路;5号线_北新桥;6号线_东四;6号线_南锣鼓巷',

'positionName': 'Python工程师',

'salary': '25k-35k',

'secondType': '后端开发'}

解析字典的时候会区分一下,然后获取总的页数,一般解析第一页就可以看到页数.然后进行循环爬取,进行解析。比如我们要获取职位的名称,职位的公司,职位的薪水,职位的城市和发布日期,这几个特征值,然后保存在一个字典列表里面即可!

4).数据的保存

常见的数据的保存我们一般用csv和json文件保存,csv文件一般都是先写一个头部,然后再把上面的字典列表数据一行一行存储在里面.json文件更方便了, 我们直接建一个文件dump一下就可以保存了

上面走一遍,感觉是不是很容易啊!如果你只看到这里,那么你离进阶又失之交臂了!

2.技术的反思

1).单线程to多线程

- 上面的爬取都是单线程的爬取,职位不是很多,如果几万或者几十万的数据呢!你顺序爬取,很显然太慢,需要考虑并发!

- 并发有多进程,多线程,线程池,或者用协程并发

2).断点续爬

上面的爬取没有考虑异常情况,如果爬取的过程出错了!怎么办,你需要重头爬取,不是一个明智之举,如何断点续传呢:

- 比较常用的做法是保存文件,然后续爬的时候,先检测文件是否存在,如果存在查一下职位的id是否已经在文件中,不在则爬,在则跳过爬下一个!

- 那有没有更好的办法呢,阿蔡建议用Redis来处理,一个牛逼的非常快速的内存数据库,爬取的时候只要监听

redis数据,思路类似上面的文件爬取.

3).增量爬取

我们的爬取都是当天的数据,如何考虑增量爬取,我们首先要对日期进行处理!拉勾上的职位很多发布日期都是相对时间,比如今天12:10,昨天8:00,如果考虑时间序列的增量,必须要把这些相对时间在爬取的时候,做数据清洗!

3.细节的推敲

- 比如我们保存多个爬取的数据的时候,是用列表存储,还是用双向列表!

- 构建一个字典的时候,如果获取的数据的值为空,比如薪资异常,有没有考虑到用缺省字典

- 我们爬取的时候,有没有考虑异常处理,如果出现了403反爬,是否用了随机代理和构建一个代理池来处理

- 循环保存的时候,要不要用yield迭代器会不会更快一点

当然这些是我想到的一部分,也许还有更多的细节需要推敲和挖掘,把代码写的更好更美,好的代码应该是改出来的,需要不断的重构。

4.兴趣是最大的动力

做了那么多年开发,自学了很多门编程语言,我很明白学习资源对于学一门新语言的重要性,这些年也收藏了不少的Python干货,对我来说这些东西确实已经用不到了,但对于准备自学Python的人来说,或许它就是一个宝藏,可以给你省去很多的时间和精力。

别在网上瞎学了,我最近也做了一些资源的更新,只要你是我的粉丝,这期福利你都可拿走。

我先来介绍一下这些东西怎么用,文末抱走。

(1)Python所有方向的学习路线(新版)

这是我花了几天的时间去把Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

最近我才对这些路线做了一下新的更新,知识体系更全面了。

(2)Python学习视频

包含了Python入门、爬虫、数据分析和web开发的学习视频,总共100多个,虽然没有那么全面,但是对于入门来说是没问题的,学完这些之后,你可以按照我上面的学习路线去网上找其他的知识资源进行进阶。

(3)100多个练手项目

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了,只是里面的项目比较多,水平也是参差不齐,大家可以挑自己能做的项目去练练。

(4)200多本电子书

这些年我也收藏了很多电子书,大概200多本,有时候带实体书不方便的话,我就会去打开电子书看看,书籍可不一定比视频教程差,尤其是权威的技术书籍。

基本上主流的和经典的都有,这里我就不放图了,版权问题,个人看看是没有问题的。

(5)Python知识点汇总

知识点汇总有点像学习路线,但与学习路线不同的点就在于,知识点汇总更为细致,里面包含了对具体知识点的简单说明,而我们的学习路线则更为抽象和简单,只是为了方便大家只是某个领域你应该学习哪些技术栈。

(6)其他资料

还有其他的一些东西,比如说我自己出的Python入门图文类教程,没有电脑的时候用手机也可以学习知识,学会了理论之后再去敲代码实践验证,还有Python中文版的库资料、MySQL和HTML标签大全等等,这些都是可以送给粉丝们的东西。

这些都不是什么非常值钱的东西,但对于没有资源或者资源不是很好的学习者来说确实很不错,你要是用得到的话都可以直接抱走,关注过我的人都知道,这些都是可以拿到的。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

本文讲述了作者通过爬虫项目实践,反思了爬虫过程中的技术要点,如环境设置、目标网站分析、数据解析技巧,以及技术提升中的并发处理、错误处理和增量爬取策略。同时强调了系统学习资源的价值,包括Python学习路线、项目练手、电子书等,鼓励社群内的技术交流与合作。

本文讲述了作者通过爬虫项目实践,反思了爬虫过程中的技术要点,如环境设置、目标网站分析、数据解析技巧,以及技术提升中的并发处理、错误处理和增量爬取策略。同时强调了系统学习资源的价值,包括Python学习路线、项目练手、电子书等,鼓励社群内的技术交流与合作。

3073

3073

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?