先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

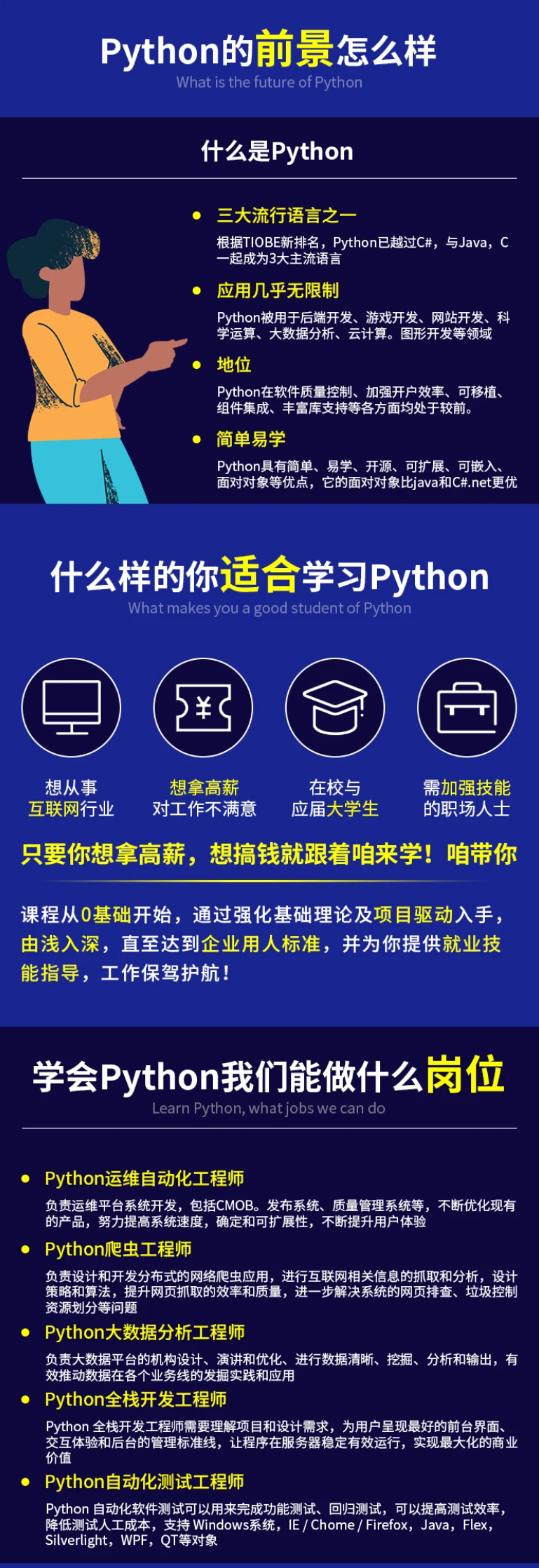

因此收集整理了一份《2024年最新Python全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上Python知识点,真正体系化!

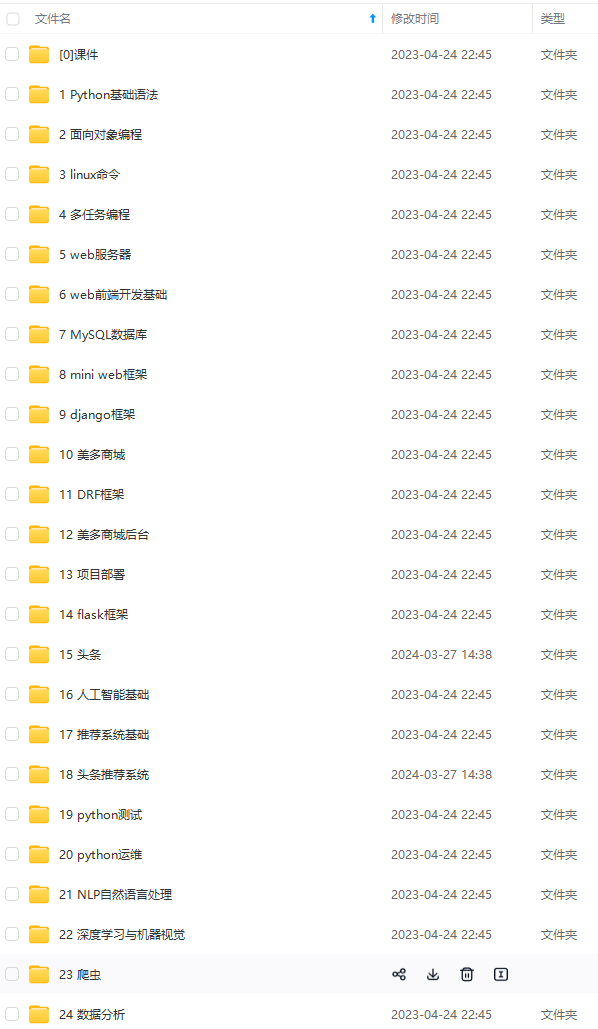

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

如果你需要这些资料,可以添加V获取:vip1024c (备注Python)

正文

日志片段文件的检查周期,查看它们是否达到了删除策略的设置(log.retention.hours或log.retention.bytes)

log.retention.check.interval.ms=60000

是否开启压缩

log.cleaner.enable=false

对于压缩的日志保留的最长时间

log.cleaner.delete.retention.ms = 1 day

对于segment日志的索引文件大小限制

log.index.size.max.bytes = 10 * 1024 * 1024

#y索引计算的一个缓冲区,一般不需要设置。

log.index.interval.bytes = 4096

############################# replica #############################

partition management controller 与replicas之间通讯的超时时间

controller.socket.timeout.ms = 30000

controller-to-broker-channels消息队列的尺寸大小

controller.message.queue.size=10

replicas响应leader的最长等待时间,若是超过这个时间,就将replicas排除在管理之外

replica.lag.time.max.ms = 10000

是否允许控制器关闭broker ,若是设置为true,会关闭所有在这个broker上的leader,并转移到其他broker

controlled.shutdown.enable = false

控制器关闭的尝试次数

controlled.shutdown.max.retries = 3

每次关闭尝试的时间间隔

controlled.shutdown.retry.backoff.ms = 5000

如果relicas落后太多,将会认为此partition relicas已经失效。而一般情况下,因为网络延迟等原因,总会导致replicas中消息同步滞后。如果消息严重滞后,leader将认为此relicas网络延迟较大或者消息吞吐能力有限。在broker数量较少,或者网络不足的环境中,建议提高此值.

replica.lag.max.messages = 4000

#leader与relicas的socket超时时间

replica.socket.timeout.ms= 30 * 1000

leader复制的socket缓存大小

replica.socket.receive.buffer.bytes=64 * 1024

replicas每次获取数据的最大字节数

replica.fetch.max.bytes = 1024 * 1024

replicas同leader之间通信的最大等待时间,失败了会重试

replica.fetch.wait.max.ms = 500

每一个fetch操作的最小数据尺寸,如果leader中尚未同步的数据不足此值,将会等待直到数据达到这个大小

replica.fetch.min.bytes =1

leader中进行复制的线程数,增大这个数值会增加relipca的IO

num.replica.fetchers = 1

每个replica将最高水位进行flush的时间间隔

replica.high.watermark.checkpoint.interval.ms = 5000

是否自动平衡broker之间的分配策略

auto.leader.rebalance.enable = false

leader的不平衡比例,若是超过这个数值,会对分区进行重新的平衡

leader.imbalance.per.broker.percentage = 10

检查leader是否不平衡的时间间隔

leader.imbalance.check.interval.seconds = 300

客户端保留offset信息的最大空间大小

offset.metadata.max.bytes = 1024

#############################Consumer #############################

Consumer端核心的配置是group.id、zookeeper.connect

决定该Consumer归属的唯一组ID,By setting the same group id multiple processes indicate that they are all part of the same consumer group.

group.id

消费者的ID,若是没有设置的话,会自增

consumer.id

一个用于跟踪调查的ID ,最好同group.id相同

client.id = <group_id>

对于zookeeper集群的指定,必须和broker使用同样的zk配置

zookeeper.connect=debugo01:2182,debugo02:2182,debugo03:2182

zookeeper的心跳超时时间,查过这个时间就认为是无效的消费者

zookeeper.session.timeout.ms = 6000

zookeeper的等待连接时间

zookeeper.connection.timeout.ms = 6000

zookeeper的follower同leader的同步时间

zookeeper.sync.time.ms = 2000

当zookeeper中没有初始的offset时,或者超出offset上限时的处理方式 。

smallest :重置为最小值

largest:重置为最大值

anything else:抛出异常给consumer

auto.offset.reset = largest

socket的超时时间,实际的超时时间为max.fetch.wait + socket.timeout.ms.

socket.timeout.ms= 30 * 1000

socket的接收缓存空间大小

socket.receive.buffer.bytes=64 * 1024

#从每个分区fetch的消息大小限制

fetch.message.max.bytes = 1024 * 1024

true时,Consumer会在消费消息后将offset同步到zookeeper,这样当Consumer失败后,新的consumer就能从zookeeper获取最新的offset

auto.commit.enable = true

自动提交的时间间隔

auto.commit.interval.ms = 60 * 1000

用于消费的最大数量的消息块缓冲大小,每个块可以等同于fetch.message.max.bytes中数值

queued.max.message.chunks = 10

当有新的consumer加入到group时,将尝试reblance,将partitions的消费端迁移到新的consumer中, 该设置是尝试的次数

rebalance.max.retries = 4

每次reblance的时间间隔

rebalance.backoff.ms = 2000

每次重新选举leader的时间

refresh.leader.backoff.ms

server发送到消费端的最小数据,若是不满足这个数值则会等待直到满足指定大小。默认为1表示立即接收。

fetch.min.bytes = 1

若是不满足fetch.min.bytes时,等待消费端请求的最长等待时间

fetch.wait.max.ms = 100

如果指定时间内没有新消息可用于消费,就抛出异常,默认-1表示不受限

consumer.timeout.ms = -1

#############################Producer#############################

核心的配置包括:

metadata.broker.list

request.required.acks

producer.type

serializer.class

消费者获取消息元信息(topics, partitions and replicas)的地址,配置格式是:host1:port1,host2:port2,也可以在外面设置一个vip

metadata.broker.list

#消息的确认模式

0:不保证消息的到达确认,只管发送,低延迟但是会出现消息的丢失,在某个server失败的情况下,有点像TCP

1:发送消息,并会等待leader 收到确认后,一定的可靠性

-1:发送消息,等待leader收到确认,并进行复制操作后,才返回,最高的可靠性

request.required.acks = 0

消息发送的最长等待时间

request.timeout.ms = 10000

socket的缓存大小

send.buffer.bytes=100*1024

key的序列化方式,若是没有设置,同serializer.class

key.serializer.class

分区的策略,默认是取模

partitioner.class=kafka.producer.DefaultPartitioner

消息的压缩模式,默认是none,可以有gzip和snappy

compression.codec = none

可以针对默写特定的topic进行压缩

学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。最后大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、学习软件

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

三、全套PDF电子书

书籍的好处就在于权威和体系健全,刚开始学习的时候你可以只看视频或者听某个人讲课,但等你学完之后,你觉得你掌握了,这时候建议还是得去看一下书籍,看权威技术书籍也是每个程序员必经之路。

四、入门学习视频

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

五、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

六、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip1024c (备注python)

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

e9.png)

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip1024c (备注python)

[外链图片转存中…(img-L16XePd3-1713699627628)]

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

732

732

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?