目录

一、分词器

- 分词器的作用是什么?

创建倒排索引时对文档分词

用户搜索时,对输入的内容分词

- IK分词器有几种模式?

ik_smart:智能切分,粗粒度

ik_max_word:最细切分,细粒度

- IK分词器如何拓展词条?如何停用词条?

利用config目录的IkAnalyzer.cfg.xml文件添加拓展词典和停用词典

在词典中添加拓展词条或者停用词条

ik分词器-拓展词库

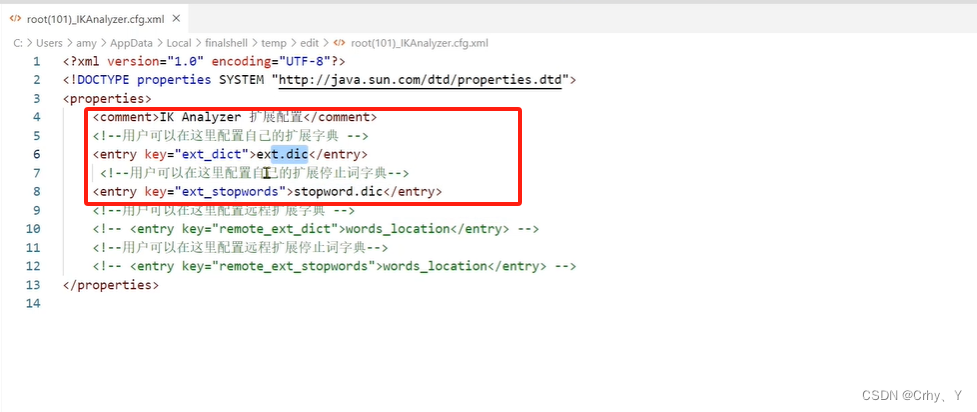

要拓展ik分词器的词库,只需要修改一个ik分词器目录中的config目录中的IkAnalyzer.cfq.xml文件

<?xml version="1." encoding="UTF-8"?>

<!DOCTYPE properties SYSTEM "http://java.sun.com/dtd/properties.dtd">

<properties><comment>IK Analyzer 扩展配置</comment>

<!--用户可以在这里配置自己的扩展字典 *** 添加扩展词典-->

<entry key="ext_dict">ext.dic</entry>

</properties>

ik分词器-停用词库

要禁用某些敏感词条,只需要修改一个ik分词器目录中的config目录中的IkAnalyzer.cfq.xml文件

<?xml version="1." encoding="UTF-8"?>

<!DOCTYPE properties SYSTEM "http://javasun.com/dtd/properties.dtd">

<properties>

<comment>IK Analyzer 扩展配置</comment><!--用户可以在这里配置自己的扩展字典-->

<entry key="ext_dict">ext.dic</entry>

<!--用户可以在这里配置自己的扩展停止词字典 *** 添加停用词词典-->

<entry key="ext_stopwords">stopword.dic</entry>

</properties>

二、分词器字典的扩展与停用

2.1 打开IkAnalyzer.cfq.xml文件

添加扩展词字典、停止词字典

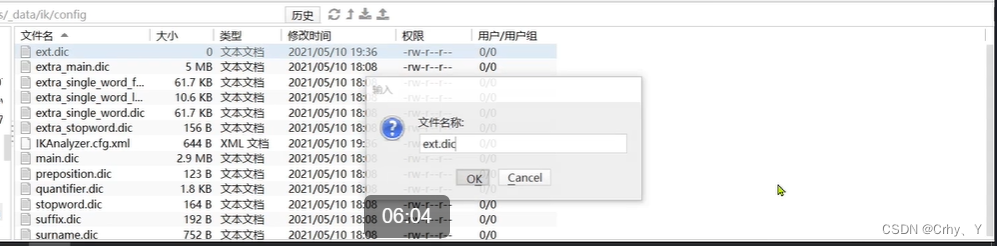

2.2 在同级目录下新建 ext.dic 文件(扩展词)

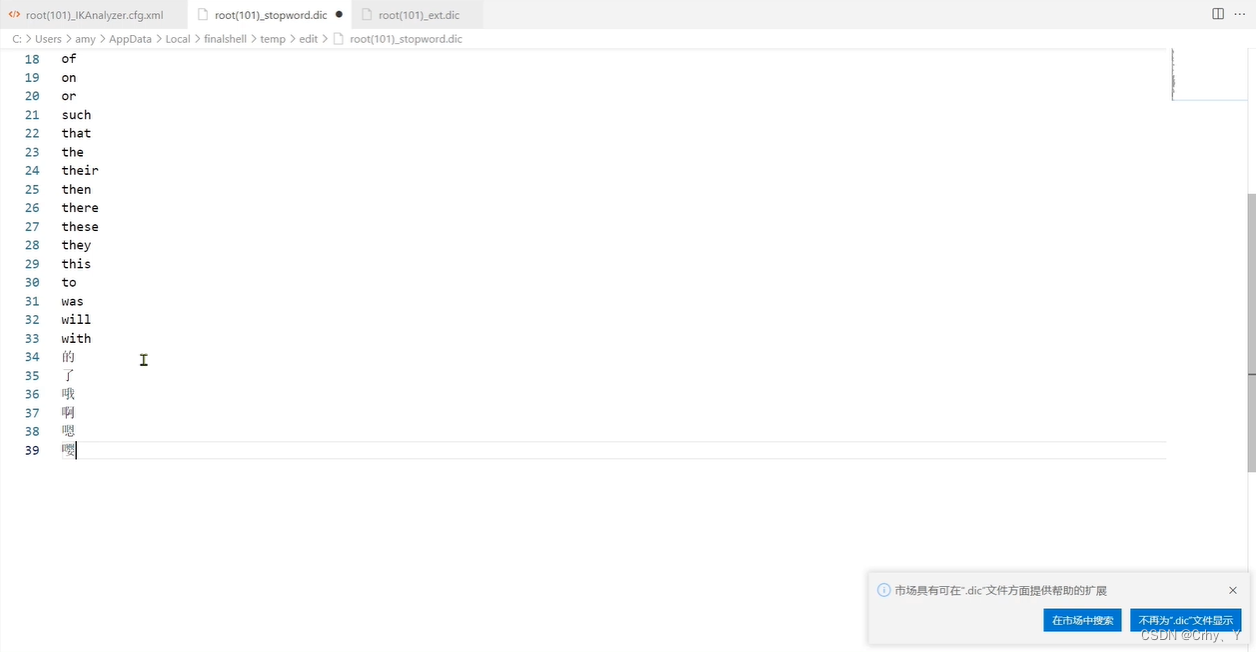

2.3 在同级目录下找到 stopword.dic 文件(禁用词)并编辑,用于禁用分词

2.3 在同级目录下找到 stopword.dic 文件(禁用词)并编辑,用于禁用分词

8468

8468

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?