先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年最新Python全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

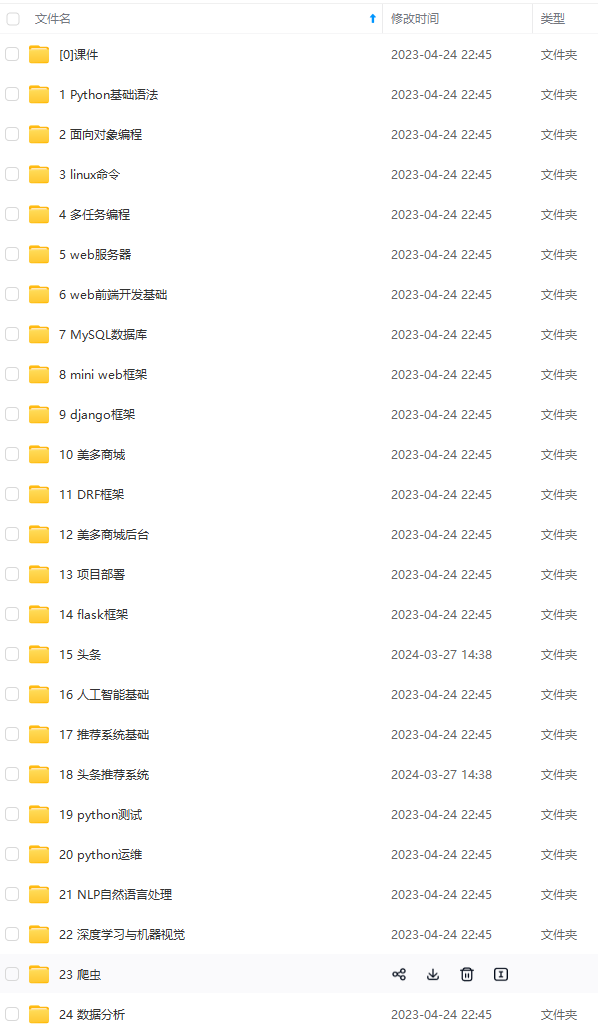

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上Python知识点,真正体系化!

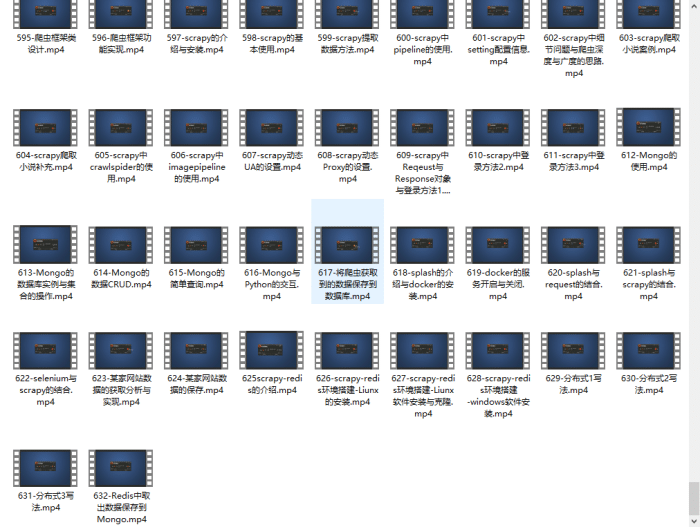

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

如果你需要这些资料,可以添加V获取:vip1024c (备注Python)

正文

循环检测结果

for i in np.arange(0, detections.shape[2]):

提取与数据相关的置信度(即概率)

预测

confidence = detections[0, 0, i, 2]

通过确保“置信度”来过滤掉弱检测

大于最小置信度

if confidence > confidence_ta:

从detections中提取类标签的索引,

然后计算物体边界框的 (x, y) 坐标

idx = int(detections[0, 0, i, 1])

box = detections[0, 0, i, 3:7] * np.array([w, h, w, h])

(startX, startY, endX, endY) = box.astype(“int”)

显示预测

label = “{}: {:.2f}%”.format(CLASSES[idx], confidence * 100)

print(“[INFO] {}”.format(label))

cv2.rectangle(image, (startX, startY), (endX, endY),

COLORS[idx], 2)

y = startY - 15 if startY - 15 > 15 else startY + 15

cv2.putText(image, label, (startX, y),

cv2.FONT_HERSHEY_SIMPLEX, 0.5, COLORS[idx], 2)

show the output image

cv2.imshow(“Output”, image)

cv2.imwrite(“output.jpg”, image)

cv2.waitKey(0)

循环检测,首先我们提取置信度值。

如果置信度高于我们的最小阈值,我们提取类标签索引并计算检测到的对象周围的边界框。

然后,提取框的 (x, y) 坐标,我们将很快使用它来绘制矩形和显示文本。

接下来,构建一个包含 CLASS 名称和置信度的文本标签。

使用标签,将其打印到终端,然后使用之前提取的 (x, y) 坐标在对象周围绘制一个彩色矩形。

通常,希望标签显示在矩形上方,但如果没有空间,我们会将其显示在矩形顶部下方。

最后,使用刚刚计算的 y 值将彩色文本覆盖到图像上。

运行结果:

=========================================================================

打开一个新文件,将其命名为 video_object_detection.py ,并插入以下代码:

video_name = ‘12.mkv’

prototxt = ‘MobileNetSSD_deploy.prototxt.txt’

model_path = ‘MobileNetSSD_deploy.caffemodel’

confidence_ta = 0.2

initialize the list of class labels MobileNet SSD was trained to

detect, then generate a set of bounding box colors for each class

CLASSES = [“background”, “aeroplane”, “bicycle”, “bird”, “boat”,

“bottle”, “bus”, “car”, “cat”, “chair”, “cow”, “diningtable”,

“dog”, “horse”, “motorbike”, “person”, “pottedplant”, “sheep”,

“sofa”, “train”, “tvmonitor”]

COLORS = np.random.uniform(0, 255, size=(len(CLASSES), 3))

load our serialized model from disk

print(“[INFO] loading model…”)

net = cv2.dnn.readNetFromCaffe(prototxt, model_path)

initialze the video stream, allow the camera to sensor to warmup,

and initlaize the FPS counter

print(‘[INFO] starting video stream…’)

vs = cv2.VideoCapture(video_name)

fps = 30 #保存视频的FPS,可以适当调整

size=(600,325)

fourcc=cv2.VideoWriter_fourcc(*‘XVID’)

videowrite=cv2.VideoWriter(‘output.avi’,fourcc,fps,size)

time.sleep(2.0)

定义全局参数:

-

video_name:输入视频的路径。

-

prototxt :Caffe prototxt 文件的路径。

-

model_path :预训练模型的路径。

-

confidence_ta :过滤弱检测的最小概率阈值。 默认值为 20%。

接下来,让我们初始化类标签和边界框颜色。

加载模型。

初始化VideoCapture对象。

设置VideoWriter对象以及参数。size的大小由下面的代码决定,需要保持一致,否则不能保存视频。

接下就是循环视频的帧,然后输入到检测器进行检测,这一部分的逻辑和图像检测一致。代码如下:

loop over the frames from the video stream

while True:

ret_val, frame = vs.read()

if ret_val is False:

break

frame = imutils.resize(frame, width=1080)

print(frame.shape)

grab the frame dimentions and convert it to a blob

(h, w) = frame.shape[:2]

blob = cv2.dnn.blobFromImage(cv2.resize(frame, (300, 300)), 0.007843, (300, 300), 127.5)

pass the blob through the network and obtain the detections and predictions

net.setInput(blob)

detections = net.forward()

loop over the detections

for i in np.arange(0, detections.shape[2]):

extract the confidence (i.e., probability) associated with

the prediction

confidence = detections[0, 0, i, 2]

filter out weak detections by ensuring the confidence is

greater than the minimum confidence

if confidence > confidence_ta:

extract the index of the class label from the

detections, then compute the (x, y)-coordinates of

the bounding box for the object

idx = int(detections[0, 0, i, 1])

box = detections[0, 0, i, 3:7] * np.array([w, h, w, h])

(startX, startY, endX, endY) = box.astype(“int”)

draw the prediction on the frame

label = “{}: {:.2f}%”.format(CLASSES[idx],

confidence * 100)

cv2.rectangle(frame, (startX, startY), (endX, endY),

COLORS[idx], 2)

y = startY - 15 if startY - 15 > 15 else startY + 15

cv2.putText(frame, label, (startX, y),

cv2.FONT_HERSHEY_SIMPLEX, 0.5, COLORS[idx], 2)

show the output frame

cv2.imshow(“Frame”, frame)

videowrite.write(frame)

key = cv2.waitKey(1) & 0xFF

if the q key was pressed, break from the loop

if key == ord(“q”):

break

videowrite.release()

do a bit of cleanup

cv2.destroyAllWindows()

vs.release()

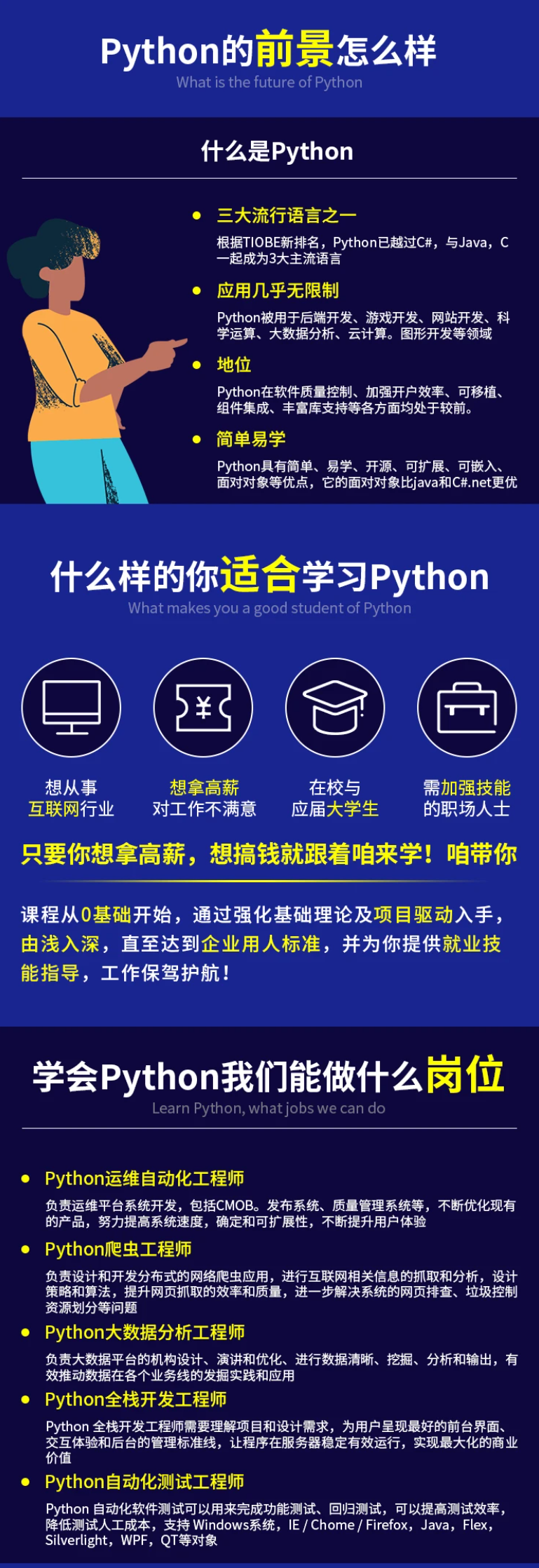

如果你也是看准了Python,想自学Python,在这里为大家准备了丰厚的免费学习大礼包,带大家一起学习,给大家剖析Python兼职、就业行情前景的这些事儿。

一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、学习软件

工欲善其必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

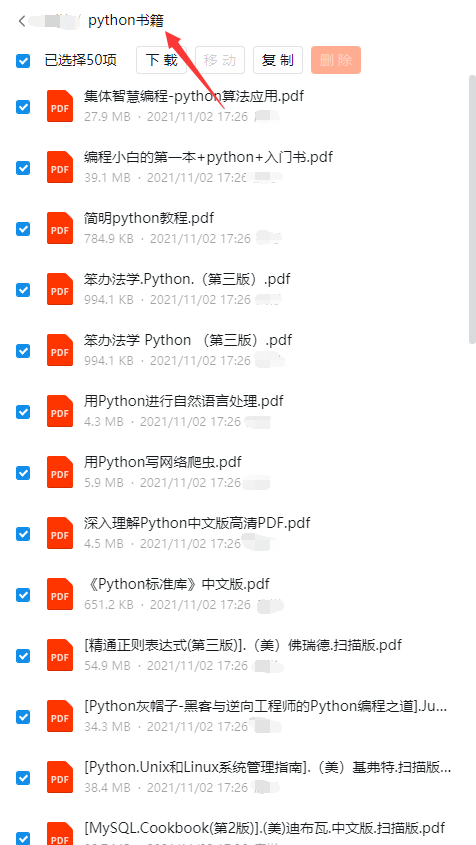

三、全套PDF电子书

书籍的好处就在于权威和体系健全,刚开始学习的时候你可以只看视频或者听某个人讲课,但等你学完之后,你觉得你掌握了,这时候建议还是得去看一下书籍,看权威技术书籍也是每个程序员必经之路。

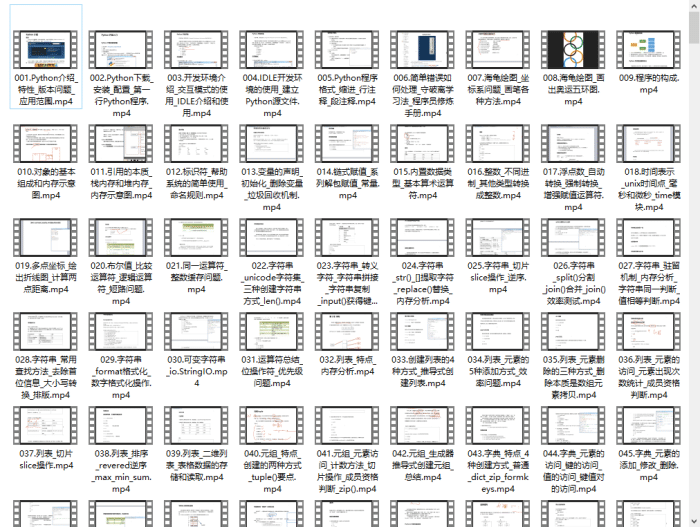

四、入门学习视频

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

四、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

五、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

成为一个Python程序员专家或许需要花费数年时间,但是打下坚实的基础只要几周就可以,如果你按照我提供的学习路线以及资料有意识地去实践,你就有很大可能成功!

最后祝你好运!!!

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip1024c (备注python)

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

g_convert/6c361282296f86381401c05e862fe4e9.png)

成为一个Python程序员专家或许需要花费数年时间,但是打下坚实的基础只要几周就可以,如果你按照我提供的学习路线以及资料有意识地去实践,你就有很大可能成功!

最后祝你好运!!!

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip1024c (备注python)

[外链图片转存中…(img-QzGZNcBY-1713092307283)]

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

577

577

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?