感谢每一个认真阅读我文章的人,看着粉丝一路的上涨和关注,礼尚往来总是要有的:

① 2000多本Python电子书(主流和经典的书籍应该都有了)

② Python标准库资料(最全中文版)

③ 项目源码(四五十个有趣且经典的练手项目及源码)

④ Python基础入门、爬虫、web开发、大数据分析方面的视频(适合小白学习)

⑤ Python学习路线图(告别不入流的学习)

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

Detectron2 前身就是鼎鼎大名的 Detectron,其实Detectron可以说是Facebook第一代检测工具箱。Detectron2 不仅支持 Detectron已有的目标检测、实例分割、姿态估计等任务,还支持语义分割和全景分割。

优点如下:

基于PyTorch:PyTorch可以提供更直观的命令式编程模型,开发者可以更快的进行迭代模型设计和实验。

模块化、可扩展:从Detectron2开始,Facebook引入了模块化设计,允许用户将自定义模块插入目标检测系统的几乎任何部分。这意味着许多新的研究项目和核心Detectron2库可以完全分开。其可扩展性也使得Detectron2更加灵活。

支持语义分割和全景分割。

实现质量:从头开始重写推出的Detectron2,使得能够重新审视低级设计决策并解决了原始Detectron中的几个实现问题。

速度和可扩展性:Detectron2比原始Detectron更快,而且可以更加方便进行GPU服务器的分布式训练。

Detectron2go:新增了将模型产品化部署的软件实现,包括标准的内部数据训练工作流实现、模型压缩量化、模型转化等。

总之,我们使用Detectron2很方便的实现模型的训练、测试以及模型转换。所以现在很多的新模型都是在Detectron2开发。

==============================================================================

我本地环境:

操作系统:win10、Cuda11.0。

创建虚拟环境,并激活环境。

conda create --name centernet2 python=3.7

activate centernet2

conda install pytorch1.7.1 torchvision0.8.2 torchaudio==0.7.2 cudatoolkit=11.0 -c pytorch

APEX是英伟达开源的,完美支持PyTorch框架,用于改变数据格式来减小模型显存占用的工具。其中最有价值的是amp(Automatic Mixed Precision),将模型的大部分操作都用Float16数据类型测试,一些特别操作仍然使用Float32。并且用户仅仅通过三行代码即可完美将自己的训练代码迁移到该模型。实验证明,使用Float16作为大部分操作的数据类型,并没有降低参数,在一些实验中,反而由于可以增大Batch size,带来精度上的提升,以及训练速度上的提升。

3.2.1 下载apex

网址 https://github.com/NVIDIA/apex,下载到本地文件夹。解压后进入到apex的目录安装依赖。在执行命令;

cd C:\Users\WH\Downloads\apex-master #进入apex目录

pip install -r requirements.txt

3.2.2 安装apex

依赖安装完后,打开cmd,cd进入到刚刚下载完的apex-master路径下,运行:

python setup.py install

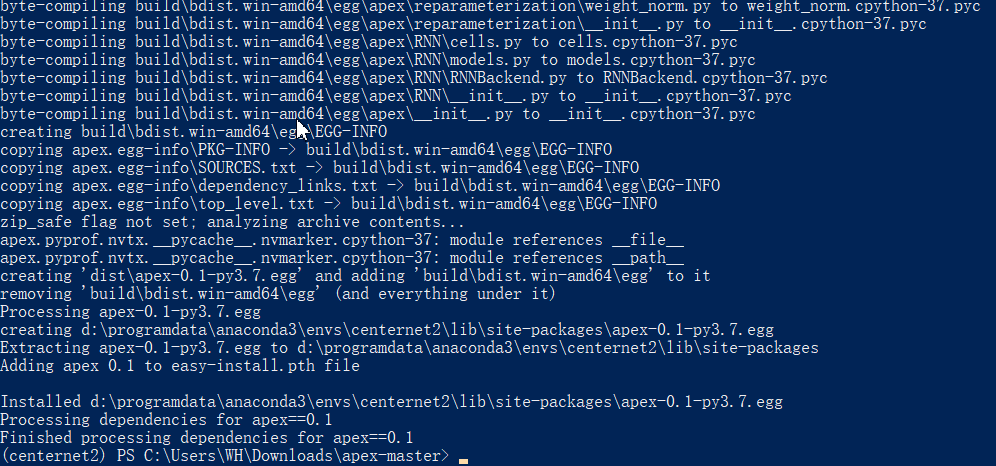

然后跑了一堆东西,最后是这样的:

安装完成!

fvcore库的简介

fvcore是一个轻量级的核心库,它提供了在各种计算机视觉框架(如Detectron2)中共享的最常见和最基本的功能。这个库基于Python 3.6+和PyTorch。这个库中的所有组件都经过了类型注释、测试和基准测试。Facebook 的人工智能实验室即FAIR的计算机视觉组负责维护这个库。

github地址:https://github.com/facebookresearch/fvcore

执行命令

conda install -c fvcore -c iopath -c conda-forge fvcore

安装pycocotools

pip install pycocotools

安装cv2

pip install opencv-python

安装 antlr4

pip install antlr4-python3-runtime

安装future

pip install future

安装protobuf

pip install protobuf

安装absl

pip install absl-py

3.5 编译CenterNet2

进入CenterNet2目录,目录根据自己的实际情况更改

cd D:\CenterNet2-master

编译

python setup.py install

=================================================================

新建imgs和imgout文件夹,imgs文件夹存放待测试的图片。

图片如下:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-ymnqnmPL-1632828249507)(https://gitee.com/wanghao1090220084/images/raw/master/img/image-20210928095744639.png)]

下载模型“CenterNet2_R50_1x.pth”(注:作者将模型放到谷歌的网盘上,这个国内访问不了,如果不能下载,关注我的公众号获取连接。),将其放到“projects/CenterNet2”目录下面。

执行命令:

python projects/CenterNet2/demo.py --config-file projects/CenterNet2/configs/CenterNet2_R50_1x.yaml --input imgs/ --output imgout --opts MODEL.WEIGHTS projects/CenterNet2/CenterNet2_R50_1x.pth

运行结果:

能够运行demo说明环境已经没有问题了。

==================================================================

本次采用的数据集是Labelme标注的数据集,地址:链接:https://pan.baidu.com/s/1nxo9-NpNWKK4PwDZqwKxGQ 提取码:kp4e,需要将其转为COCO格式的数据集。转换代码如下:

新建labelme2coco.py

import argparse

import json

import matplotlib.pyplot as plt

import skimage.io as io

import cv2

from labelme import utils

import numpy as np

import glob

import PIL.Image

REQUIRE_MASK = False

labels = {‘aircraft’: 1, ‘oiltank’: 2}

class labelme2coco(object):

def init(self, labelme_json=[], save_json_path=‘./new.json’):

‘’’

:param labelme_json: the list of all labelme json file paths

:param save_json_path: the path to save new json

‘’’

self.labelme_json = labelme_json

self.save_json_path = save_json_path

self.images = []

self.categories = []

self.annotations = []

self.data_coco = {}

self.label = []

self.annID = 1

self.height = 0

self.width = 0

self.require_mask = REQUIRE_MASK

self.save_json()

def data_transfer(self):

for num, json_file in enumerate(self.labelme_json):

if not json_file == self.save_json_path:

with open(json_file, ‘r’) as fp:

data = json.load(fp)

self.images.append(self.image(data, num))

for shapes in data[‘shapes’]:

print("label is ")

print(shapes[‘label’])

label = shapes[‘label’]

if label[1] not in self.label:

if label not in self.label:

print("find new category: ")

self.categories.append(self.categorie(label))

print(self.categories)

self.label.append(label[1])

self.label.append(label)

points = shapes[‘points’]

self.annotations.append(self.annotation(points, label, num))

self.annID += 1

def image(self, data, num):

image = {}

img = utils.img_b64_to_arr(data[‘imageData’])

height, width = img.shape[:2]

img = None

image[‘height’] = height

image[‘width’] = width

image[‘id’] = num + 1

image[‘file_name’] = data[‘imagePath’].split(‘/’)[-1]

self.height = height

self.width = width

return image

def categorie(self, label):

categorie = {}

categorie[‘supercategory’] = label

categorie[‘supercategory’] = label

categorie[‘id’] = labels[label] # 0 默认为背景

categorie[‘name’] = label

return categorie

def annotation(self, points, label, num):

annotation = {}

print(points)

x1 = points[0][0]

y1 = points[0][1]

x2 = points[1][0]

y2 = points[1][1]

contour = np.array([[x1, y1], [x2, y1], [x2, y2], [x1, y2]]) # points = [[x1, y1], [x2, y2]] for rectangle

contour = contour.astype(int)

area = cv2.contourArea(contour)

print("contour is ", contour, " area = ", area)

annotation[‘segmentation’] = [list(np.asarray([[x1, y1], [x2, y1], [x2, y2], [x1, y2]]).flatten())]

[list(np.asarray(contour).flatten())]

annotation[‘iscrowd’] = 0

annotation[‘area’] = area

annotation[‘image_id’] = num + 1

if self.require_mask:

annotation[‘bbox’] = list(map(float, self.getbbox(points)))

else:

x1 = points[0][0]

y1 = points[0][1]

width = points[1][0] - x1

height = points[1][1] - y1

annotation[‘bbox’] = list(np.asarray([x1, y1, width, height]).flatten())

annotation[‘category_id’] = self.getcatid(label)

annotation[‘id’] = self.annID

return annotation

def getcatid(self, label):

for categorie in self.categories:

if label[1]==categorie[‘name’]:

if label == categorie[‘name’]:

return categorie[‘id’]

return -1

def getbbox(self, points):

polygons = points

mask = self.polygons_to_mask([self.height, self.width], polygons)

return self.mask2box(mask)

def mask2box(self, mask):

np.where(mask==1)

index = np.argwhere(mask == 1)

rows = index[:, 0]

clos = index[:, 1]

left_top_r = np.min(rows) # y

left_top_c = np.min(clos) # x

right_bottom_r = np.max(rows)

right_bottom_c = np.max(clos)

return [left_top_c, left_top_r, right_bottom_c - left_top_c, right_bottom_r - left_top_r]

def polygons_to_mask(self, img_shape, polygons):

mask = np.zeros(img_shape, dtype=np.uint8)

mask = PIL.Image.fromarray(mask)

xy = list(map(tuple, polygons))

PIL.ImageDraw.Draw(mask).polygon(xy=xy, outline=1, fill=1)

mask = np.array(mask, dtype=bool)

return mask

def data2coco(self):

data_coco = {}

data_coco[‘images’] = self.images

data_coco[‘categories’] = self.categories

data_coco[‘annotations’] = self.annotations

return data_coco

def save_json(self):

print(“in save_json”)

self.data_transfer()

self.data_coco = self.data2coco()

print(self.save_json_path)

json.dump(self.data_coco, open(self.save_json_path, ‘w’), indent=4)

labelme_json = glob.glob(‘LabelmeData/*.json’)

from sklearn.model_selection import train_test_split

trainval_files, test_files = train_test_split(labelme_json, test_size=0.2, random_state=55)

import os

if not os.path.exists(“projects/CenterNet2/datasets/coco/annotations”):

os.makedirs(“projects/CenterNet2/datasets/coco/annotations/”)

if not os.path.exists(“projects/CenterNet2/datasets/coco/train2017”):

os.makedirs(“projects/CenterNet2/datasets/coco/train2017”)

if not os.path.exists(“projects/CenterNet2/datasets/coco/val2017”):

os.makedirs(“projects/CenterNet2/datasets/coco/val2017”)

labelme2coco(trainval_files, ‘projects/CenterNet2/datasets/coco/annotations/instances_train2017.json’)

labelme2coco(test_files, ‘projects/CenterNet2/datasets/coco/annotations/instances_val2017.json’)

import shutil

for file in trainval_files:

shutil.copy(os.path.splitext(file)[0] + “.jpg”, “projects/CenterNet2/datasets/coco/train2017/”)

for file in test_files:

shutil.copy(os.path.splitext(file)[0] + “.jpg”, “projects/CenterNet2/datasets/coco/val2017/”)

===================================================================

学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。最后大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、学习软件

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

三、全套PDF电子书

书籍的好处就在于权威和体系健全,刚开始学习的时候你可以只看视频或者听某个人讲课,但等你学完之后,你觉得你掌握了,这时候建议还是得去看一下书籍,看权威技术书籍也是每个程序员必经之路。

四、入门学习视频

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

五、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

六、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

9610

9610

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?