现在能在网上找到很多很多的学习资源,有免费的也有收费的,当我拿到1套比较全的学习资源之前,我并没着急去看第1节,我而是去审视这套资源是否值得学习,有时候也会去问一些学长的意见,如果可以之后,我会对这套学习资源做1个学习计划,我的学习计划主要包括规划图和学习进度表。

分享给大家这份我薅到的免费视频资料,质量还不错,大家可以跟着学习

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

price = div.xpath("//div[@class='text price2box']/span[2]/text()")

number = div.xpath("//div[@class='text'][1]/text()")

category = div.xpath("//div[@class='text'][2]/span[@class='cate']/text()")

term = div.xpath("//div[@class='text'][3]/text()")

groups = div.xpath("//div[@class='text'][4]/text()")

Range = div.xpath("//div[@class='text'][5]/text()")

img_url = div.xpath("//img[@class='img\_logo']/@src")

title = ' '.join(title).replace('\n', '').replace('\r', '').replace(' ','')

price = ' '.join(price)

number = ' '.join(number).replace('\n', '').replace('\r', '').replace(' ','')

category = ' '.join(category)

term = ' '.join(term).replace('\n', '').replace('\r', '').replace(' ','')

groups = ' '.join(groups).replace('\n', '').replace('\r', '').replace(' ','')

Range = ' '.join(Range).replace('\n', '').replace('\r', '').replace(' ','')

img_url = ' '.join(img_url)

item.append(title)

item.append(price)

item.append(number)

item.append(category)

item.append(term)

item.append(groups)

item.append(Range)

item.append(img_url)

item = tuple(item)

information.append(item)

#print(information)

return information

def insert\_sqlserver(self, information):

# 连接本地数据库服务,创建游标对象

db = pymssql.connect('.', 'sa', 'yuan427', 'test') #服务器名,账户,密码,数据库名

if db:

print("连接成功!")

cursor= db.cursor()

try:

# 插入sql语句

sql = "insert into MPSB (title,price,number,category,term,groups,Range,img\_url) values (%s,%s,%s,%s,%s,%s,%s,%s)"

# 执行插入操作

cursor.executemany(sql,information)

db.commit()

print('成功载入......' )

except Exception as e:

db.rollback()

print(str(e))

# 关闭游标,断开数据库

cursor.close()

db.close()

# 实现主要逻辑

def run(self):

for type_num in range(1,46):

# 1.拼接网页获取每个类别的页数page

url = self.baseurl % (1,type_num)

html_str = self.parse_url(url)

page = self.get_page_num(html_str) + 1

for i in range(1,page):

url = self.baseurl % (i,type_num)

x = 0

while x<1:

# 2.发送请求,获取相应

html_str = self.parse_url(url)

# 3.获取第一页中39个详情页地址

content_list= self.get_content_list(html_str)

# 4.获取39个详情页信息

information = self.get_information(content_list)

# 5.入库

self.insert_sqlserver(information)

x += 1

if name == “__main__”:

trademarkSpider = TrademarkSpider()

trademarkSpider.run()

**先讲讲我的整体思路再逐步解释**:

* 第一步:构造主页的URL地址

* 第二步:发送请求,获取响应

* 第三步:获取第一页中39个详情页地址

* 第四步:获取39个详情页信息

* 第五步:存入SqlServer数据库

* 第六步:实现主页翻页(1-91页)

### 1. 设置翻页

我们先手动翻页,1-3页:

http://www.mp.cc/search/1?category=25

http://www.mp.cc/search/2?category=25

http://www.mp.cc/search/3?category=25

可以看出来,网址只有中间一个数据在逐步递增,所以就可以构造主页地址,代码如下:

for i in range(1,92):

# 1.构造主页地址

url = self.baseurl % i

这里做了字符串拼接,baseurl在 `__init__(self)`中:

self.baseurl = “http://www.mp.cc/search/%s?category=25” #通过%s传数字进入

### 2. 获取代理ip

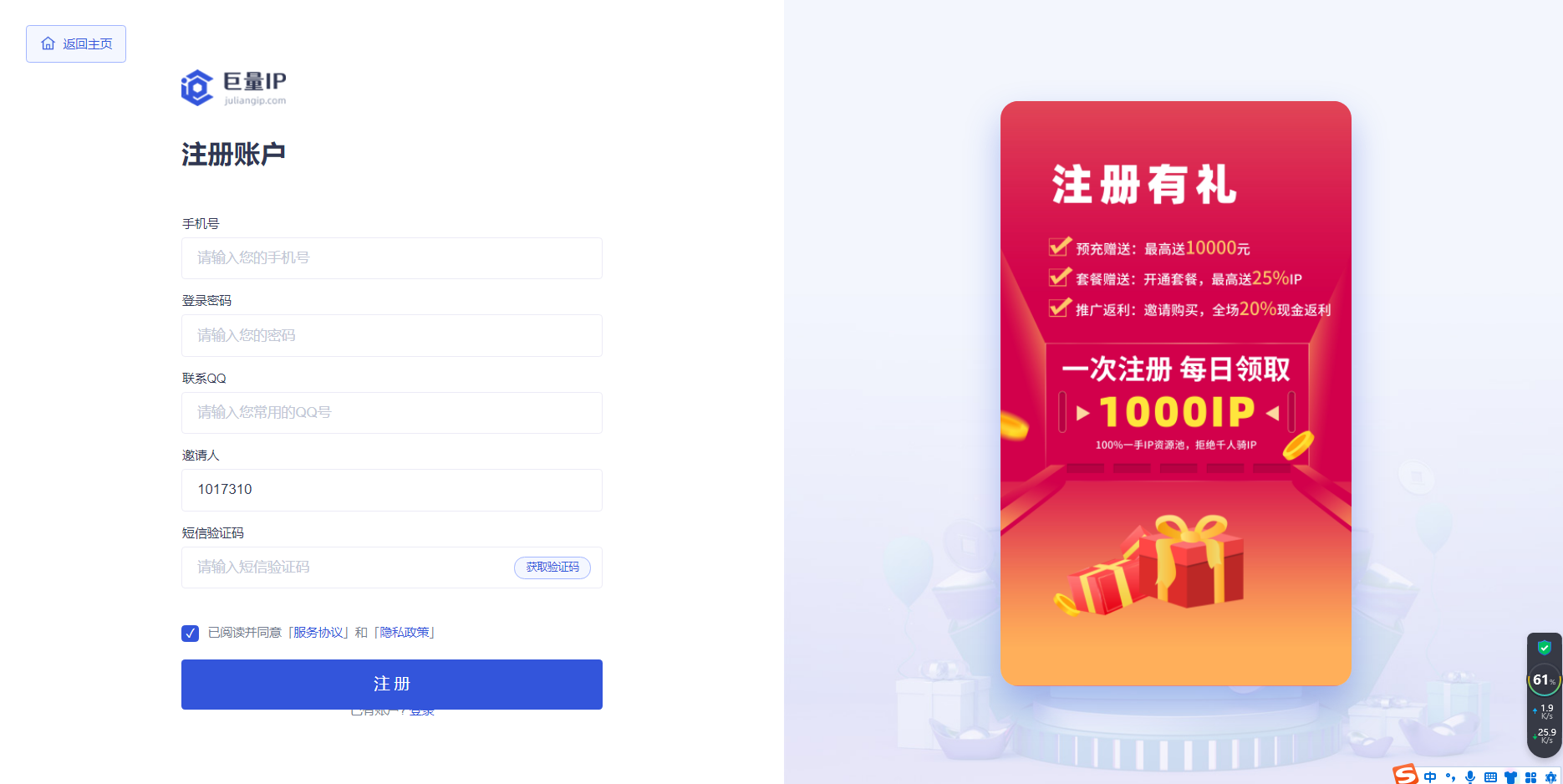

1、打开巨量IP官网:[巨量IP官网](https://bbs.csdn.net/topics/618317507)

2、输入账号信息进行注册:

3、这里需要进行实名认证,如果不会的可以看:[个人注册实名教程](https://bbs.csdn.net/topics/618317507):

4、进入会员中心,点击领取今日免费IP:

5、详细步骤看官方的教程文档:[巨量HTTP—免费代理ip套餐领取教程](https://bbs.csdn.net/topics/618317507),领取后如下图:

6、点击产品管理》动态代理(包时),可以看到我们刚才领取到的免费IP信息:

7、将自己电脑的IP添加为白名单能获取代理IP,点击授权信息:

8、依次点击修改授权》快速添加》确定

9、添加完成后,点击生成提取链接:

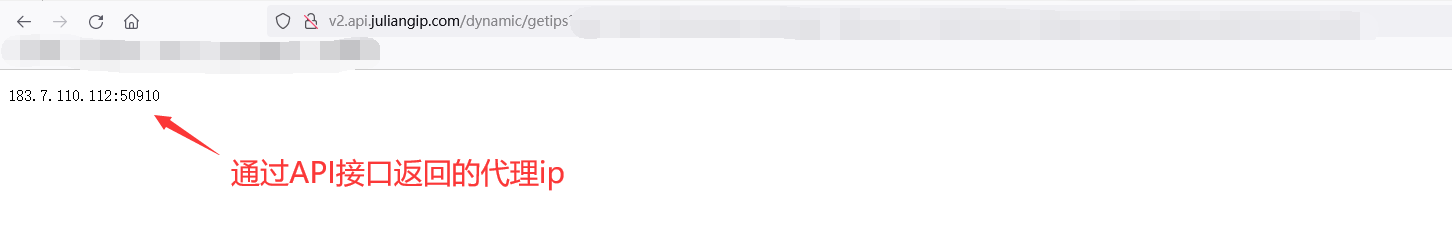

10、设置每次提取的数量,点击生成链接,并复制链接:

11、将复制链接,复制到地址栏就可以看到我们获取到的代理IP了:

12、通过爬虫去获取API接口的里面的代理IP(**注意:下面代理URL,换成自己的API链接**):

import requests

import time

import random

def get_ip():

url = “这里放你自己的API链接”

while 1:

try:

r = requests.get(url, timeout=10)

except:

continue

ip = r.text.strip()

if '请求过于频繁' in ip:

print('IP请求频繁')

time.sleep(1)

continue

break

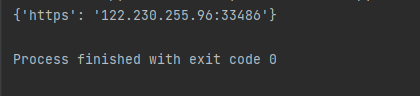

proxies = {

'https': '%s' % ip

}

return proxies

if name == ‘__main__’:

proxies = get_ip()

print(proxies)

运行结果,可以看到返回了接口中的代理IP:

### 3. 发送请求

**发送请求,获取响应**,代码如下:

def __init__(self) :

self.baseurl = “http://www.mp.cc/search/%s?category=25”

self.headers = {“User-Agent”: “Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/95.0.4638.69 Safari/537.36”}

发送请求,获取相应

def parse_url(self,url):

# 获取代理ip

proxies = get_ip()

# 使用代理ip和请求头

response = requests.get(url,headers=self.headers,proxies=proxies)

return response.content.decode() #返回网页代码,我们就在这里面提取数据

这会就有小伙伴不明白了,你`headers`什么意思啊?

* 防止服务器把我们认出来是爬虫,所以模拟浏览器头部信息,向服务器发送消息

* 这个 “装” 肯定必须是要装的!!!

### 4. 获取详情页地址

**获取第一页中39个详情页地址**,代码如下:

def get_content_list(self,html_str):

html = etree.HTML(html_str)

div_list = html.xpath(“//div[@class=‘item_wrapper’]”) # 根据div分组

item = {}

# 获取网页(只有半截,如:/brand/detail/36003501)

for div in div_list:

item["href"]= div.xpath("//a[@class='img-container']/@href")

# 拼接网页

for i in range(39):

item["href"][i] = 'http://www.mp.cc%s' % item["href"][i]

#遍历字典存入列表

for value in item.values():

content_list = value

print(content_list)

return content_list

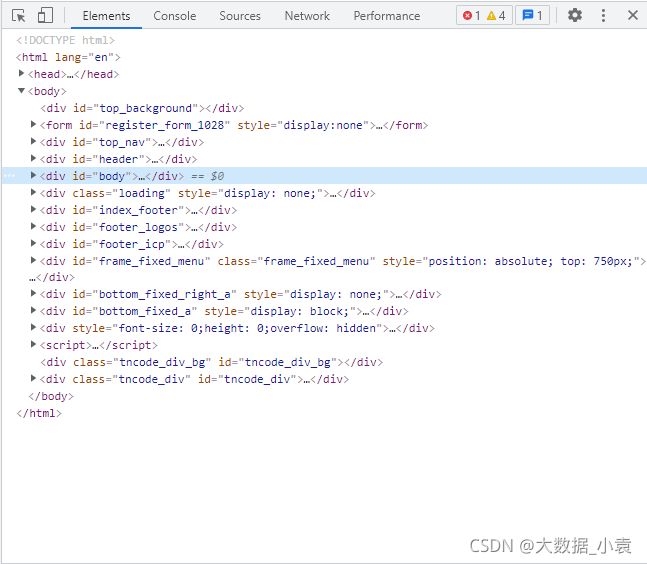

**1)我们先把获取到的主页代码转换为Elements对象,就和网页中的一样,如下图**: `html = etree.HTML(html_str)`

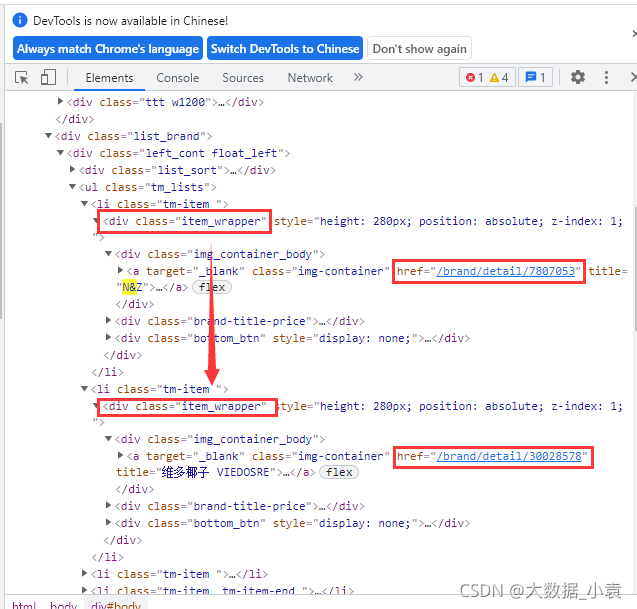

**2)写Xpath根据div分组**:`div_list = html.xpath("//div[@class='item_wrapper']")`

如图可以看出每个商标的详情地址都在`<div class="item_wrapper">`中

**3)提取地址**

item = {}

for div in div_list:

item[“href”]= div.xpath(“//a[@class=‘img-container’]/@href”)

拼接网页

for i in range(39):

item[“href”][i] = ‘http://www.mp.cc%s’ % item[“href”][i]

#遍历字典存入列表

for value in item.values():

content_list = value

**4)效果如下**:

[‘http://www.mp.cc/brand/detail/36449901’, ‘http://www.mp.cc/brand/detail/26298802’, ‘http://www.mp.cc/brand/detail/22048146’, ‘http://www.mp.cc/brand/detail/4159836’, ‘http://www.mp.cc/brand/detail/9603914’, ‘http://www.mp.cc/brand/detail/4156243’, ‘http://www.mp.cc/brand/detail/36575014’, ‘http://www.mp.cc/brand/detail/39965756’, ‘http://www.mp.cc/brand/detail/36594259’, ‘http://www.mp.cc/brand/detail/37941094’, ‘http://www.mp.cc/brand/detail/38162960’, ‘http://www.mp.cc/brand/detail/38500643’, ‘http://www.mp.cc/brand/detail/38025192’, ‘http://www.mp.cc/brand/detail/37755982’, ‘http://www.mp.cc/brand/detail/37153272’, ‘http://www.mp.cc/brand/detail/35335841’, ‘http://www.mp.cc/brand/detail/36003501’, ‘http://www.mp.cc/brand/detail/27794101’, ‘http://www.mp.cc/brand/detail/26400645’, ‘http://www.mp.cc/brand/detail/25687631’, ‘http://www.mp.cc/brand/detail/25592319’,

‘http://www.mp.cc/brand/detail/25593974’, ‘http://www.mp.cc/brand/detail/24397124’, ‘http://www.mp.cc/brand/detail/23793395’, ‘http://www.mp.cc/brand/detail/38517219’, ‘http://www.mp.cc/brand/detail/36921312’, ‘http://www.mp.cc/brand/detail/6545326_6545324’, ‘http://www.mp.cc/brand/detail/8281719’, ‘http://www.mp.cc/brand/detail/4040639’, ‘http://www.mp.cc/brand/detail/42819737’, ‘http://www.mp.cc/brand/detail/40922772’, ‘http://www.mp.cc/brand/detail/41085317’, ‘http://www.mp.cc/brand/detail/40122971’, ‘http://www.mp.cc/brand/detail/39200273’, ‘http://www.mp.cc/brand/detail/38870472’, ‘http://www.mp.cc/brand/detail/38037836’, ‘http://www.mp.cc/brand/detail/37387087’, ‘http://www.mp.cc/brand/detail/36656221’, ‘http://www.mp.cc/brand/detail/25858042’]

因为我们获取的详情页地址只有半截,所以在做一个拼接!

可能这里有小伙伴要问了为什么你要先存入字典再存列表呢???

可以自己试试如果直接存列表,所有的地址全部都挤在一起了,没法拼接!!!

### 5. 提取详情信息

**分别进行39个详情页,并获取信息**,代码如下:

获取39个详情页信息

def get_information(self,content_list):

information = []

for i in range(len(content_list)):

details_url = content_list[i]

html_str = self.parse_url(details_url)

html = etree.HTML(html_str)

div_list = html.xpath("//div[@class='d\_top']") # 根据div分组

item = []

for div in div_list:

title = div.xpath("///div[@class='d\_top\_rt\_right']/text()")

price = div.xpath("//div[@class='text price2box']/span[2]/text()")

number = div.xpath("//div[@class='text'][1]/text()")

category = div.xpath("//div[@class='text'][2]/span[@class='cate']/text()")

term = div.xpath("//div[@class='text'][3]/text()")

groups = div.xpath("//div[@class='text'][4]/text()")

Range = div.xpath("//div[@class='text'][5]/text()")

img = div.xpath("//img[@class='img\_logo']/@src")

title = ' '.join(title).replace('\n', '').replace('\r', '').replace(' ','')

price = ' '.join(price)

number = ' '.join(number).replace('\n', '').replace('\r', '').replace(' ','')

category = ' '.join(category)

term = ' '.join(term).replace('\n', '').replace('\r', '').replace(' ','')

groups = ' '.join(groups).replace('\n', '').replace('\r', '').replace(' ','')

Range = ' '.join(Range).replace('\n', '').replace('\r', '').replace(' ','')

img = ' '.join(img)

item.append(title)

item.append(price)

item.append(number)

item.append(category)

item.append(term)

item.append(groups)

item.append(Range)

item.append(img)

item = tuple(item)

information.append(item)

#print(information)

return information

**1)根据content\_list长度遍历(分别获取详情页地址),并调用parse\_url方法获取网页源码**

for i in range(len(content_list)):

details_url = content_list[i]

html_str = self.parse_url(details_url)

**2)根据div分组并获取数据**

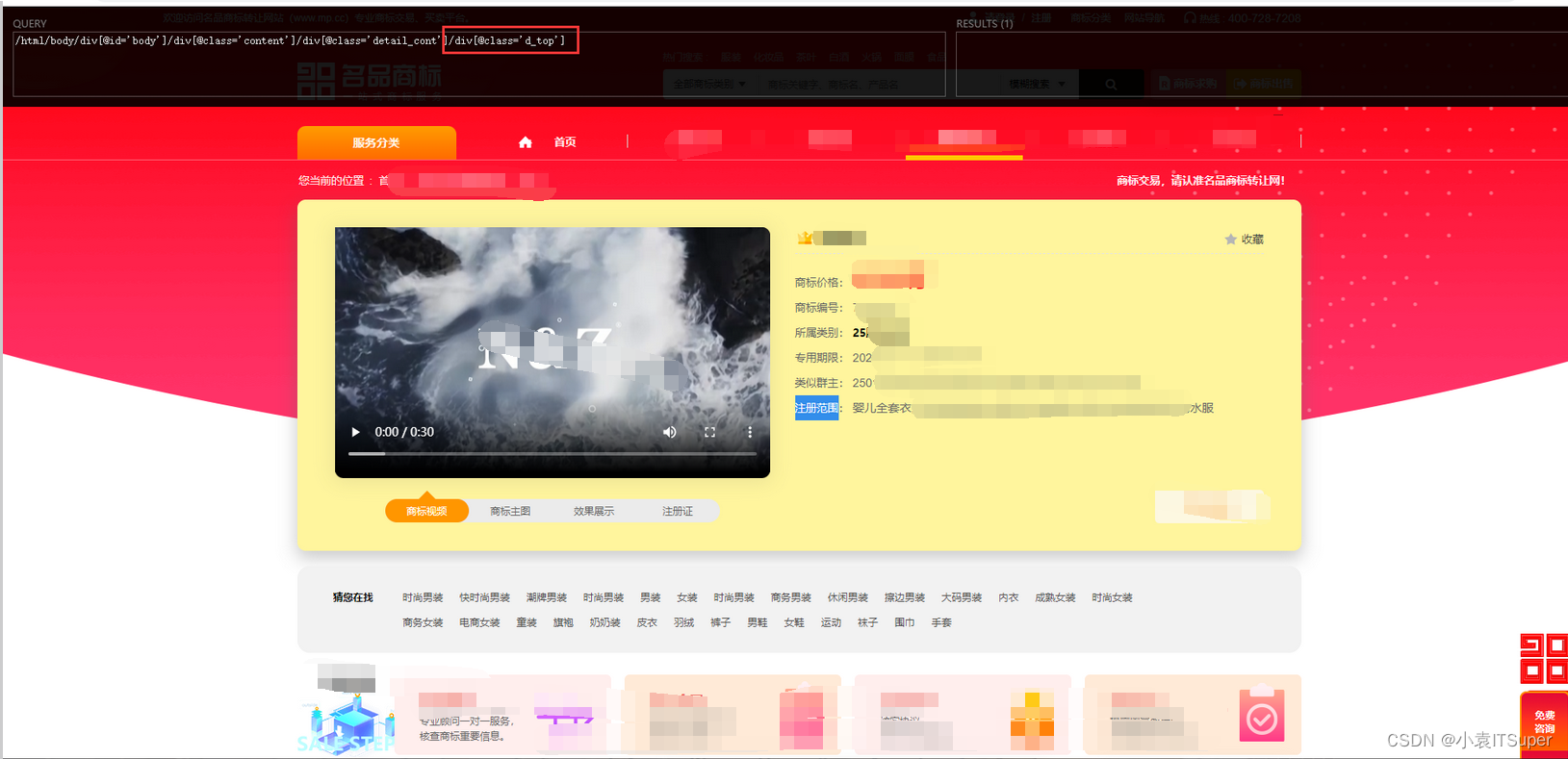

html = etree.HTML(html_str)

div_list = html.xpath(“//div[@class=‘d_top’]”) # 根据div分组

item = []

for div in div_list:

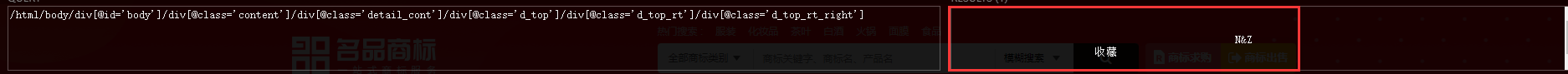

title = div.xpath("///div[@class='d\_top\_rt\_right']/text()")

price = div.xpath("//div[@class='text price2box']/span[2]/text()")

number = div.xpath("//div[@class='text'][1]/text()")

category = div.xpath("//div[@class='text'][2]/span[@class='cate']/text()")

term = div.xpath("//div[@class='text'][3]/text()")

groups = div.xpath("//div[@class='text'][4]/text()")

Range = div.xpath("//div[@class='text'][5]/text()")

img = div.xpath("//img[@class='img\_logo']/@src")

* 好了又要小伙伴要问了**XPath怎么写?**,这里我用的是XPath Helper工具,就是下图那个黑框可以帮我们写Xpath定位元素,有需要的我可以写个安装使用教程

**4)因为个别数据有空格换行符所以要先去掉,如图:**

title = ’ ‘.join(title).replace(’\n’, ‘’).replace(‘\r’, ‘’).replace(’ ‘,’‘)

price = ’ ‘.join(price)

number = ’ ‘.join(number).replace(’\n’, ‘’).replace(’\r’, ‘’).replace(’ ‘,’‘)

category = ’ ‘.join(category)

term = ’ ‘.join(term).replace(’\n’, ‘’).replace(’\r’, ‘’).replace(’ ‘,’‘)

groups = ’ ‘.join(groups).replace(’\n’, ‘’).replace(‘\r’, ‘’).replace(’ ‘,’')

学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。最后大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、学习软件

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

三、全套PDF电子书

书籍的好处就在于权威和体系健全,刚开始学习的时候你可以只看视频或者听某个人讲课,但等你学完之后,你觉得你掌握了,这时候建议还是得去看一下书籍,看权威技术书籍也是每个程序员必经之路。

四、入门学习视频

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

五、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

六、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?