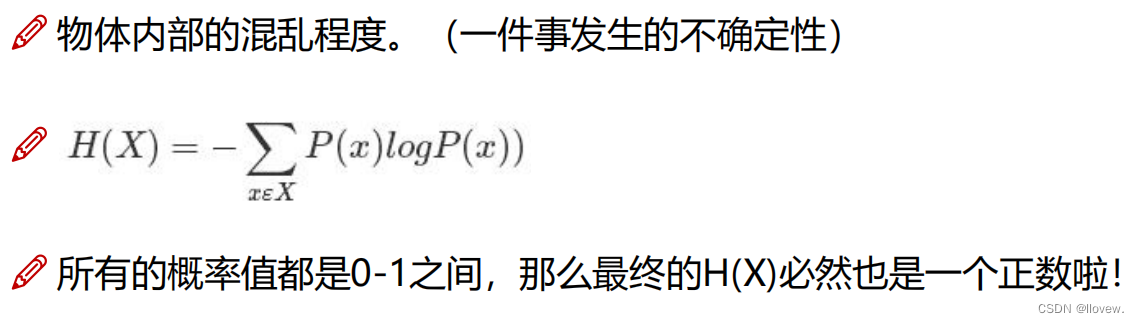

熵的概念

熵用来衡量一组数据的平均信息量或平均不确定性。如果数据的可能取值越多,即数据的分布越均匀,那么熵就越大;相反,如果数据的可能取值越少,即数据的分布越集中,熵就越小。

熵的计算公式可以表示为H(X) = -Σ(p(x) * log2(p(x))),其中X是随机变量,p(x)是X取值为x的概率。这个公式将每个可能取值的概率与其对应的信息量(以2为底的对数)相乘,并对所有可能取值进行求和。熵的单位通常以比特(bit)来衡量。

例如,考虑一个硬币投掷的例子。如果硬币是公平的,即正面和反面的概率均为0.5,那么熵最大,因为我们无法确定硬币会落在哪一面,信息量最大。另一方面,如果硬币是偏向正面的,例如正面的概率为0.9,那么熵较小,因为我们可以预期硬币更有可能落在正面。

熵的大小意味着什么

熵是衡量信息或数据的不确定性和随机性的量化指标。熵的大小与不确定性成正比,即越大的熵表示数据越随机、越不确定。而越小的熵则表示数据越有序、越确定。可以将熵看作数据中所包含的信息量,当熵最大时,数据中的每个元素都是等概率出现的,难以从中获得有用的信息;而当熵最小时,数据中的每个元素都具有确定性,从中获得的信息量很小。

在机器学习中,熵经常用于衡量分类问题中的不确定性。在决策树算法中,通过计算每个特征的熵来选择分裂节点,以达到最佳的分类效果。熵可以帮助我们理解数据的分布情况和模型的性能,同时也可以作为评估模型预测结果质量的指标之一。

激活函数

激活函数是机器学习和深度学习中的一种非线性函数,它被应用于神经网络的隐藏层或输出层,用于引入非线性变换和增加网络的表达能力。激活函数接受输入值,并将其转换为神经元的输出值。

通过引入非线性变换,激活函数允许神经网络学习和表示更加复杂的模式和关系。如果使用线性激活函数(如恒等函数),多层神经网络的组合仍然可以表示为一个线性函数,无法有效地拟合非线性关系。因此,使用非线性激活函数是非常重要的。

常见的激活函数包括:

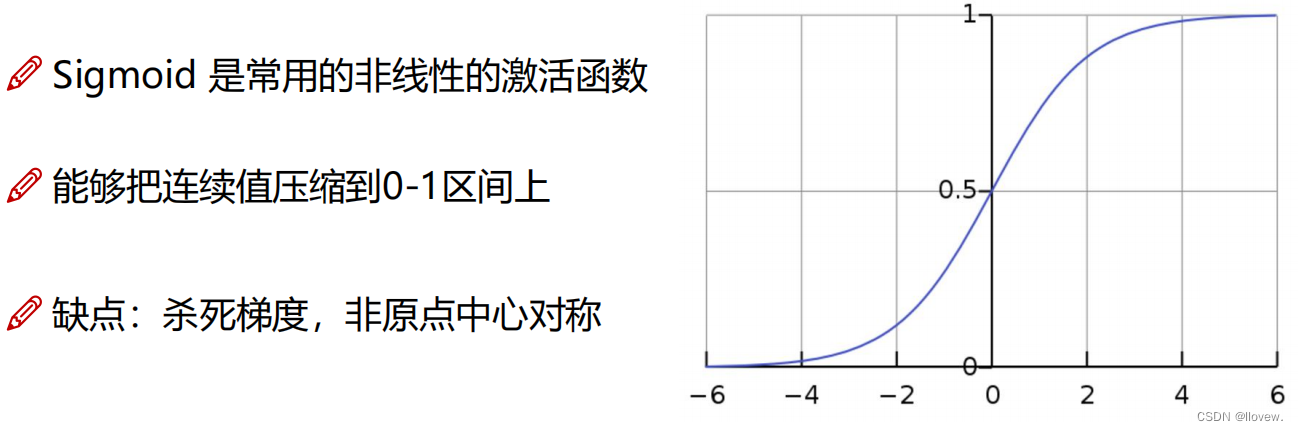

Sigmoid函数(Logistic函数):

将输入值压缩到0和1之间的连续输出。它主要用于二分类问题或作为输出层的激活函数。

双曲正切函数(Tanh函数):

类似于Sigmoid函数,但将输入值映射到-1和1之间,具有更大的输出幅度范围。

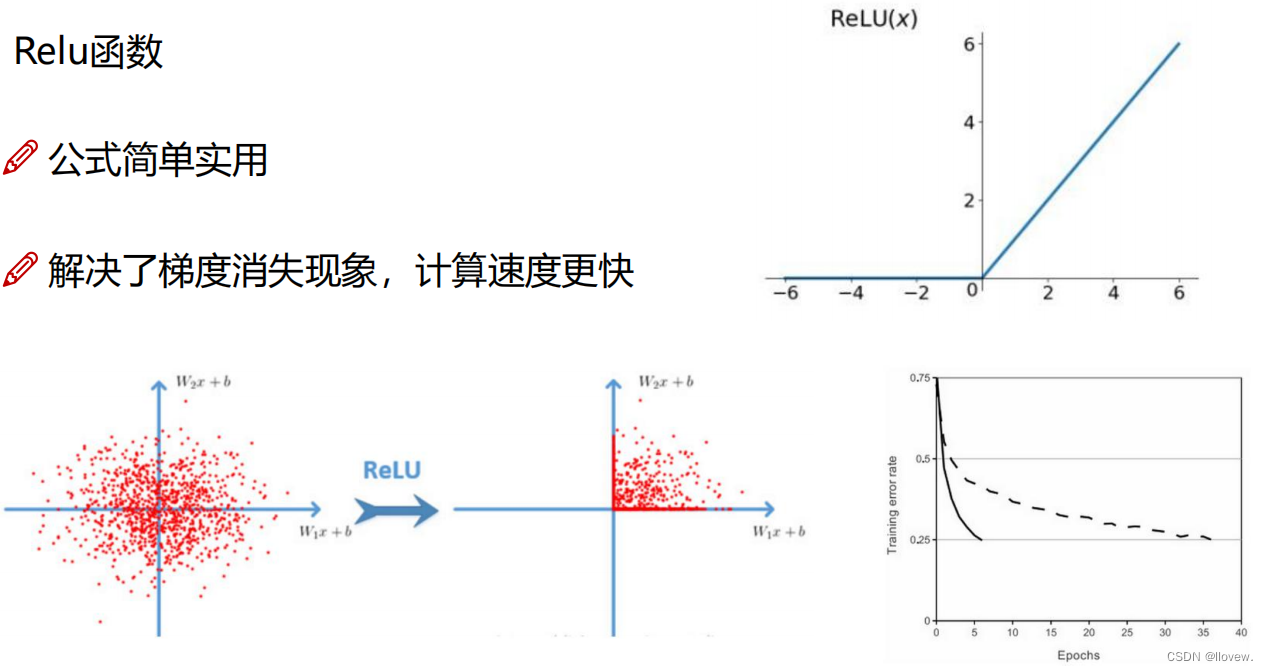

ReLU函数(Rectified Linear Unit):

在输入大于零时输出输入值,而在输入小于或等于零时输出零。ReLU函数的计算速度快,但可能存在神经元死亡问题,即某些神经元永远不会被激活。

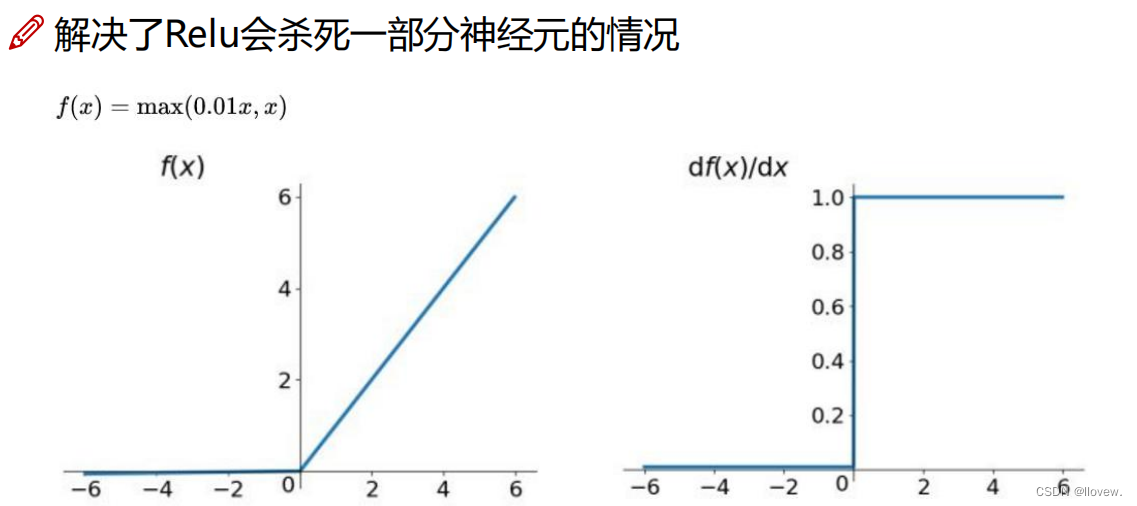

Leaky ReLU函数:

ReLU激活函数使得输出为负值的神经元永久性dead,这个问题可以通过对ReLU函数负半轴的输出进行调整,使其不为0,从而得到解决。Leaky Relu、elu、selu等函数则是采用这种思路解决神经元永久性dead问题。

在输入小于零时输出一个较小但非零的斜率,以解决ReLU函数神经元死亡的问题。

softmax函数:

softmax激活函数是sigmoid激活函数的扩展,如下式所示,通常用于多分类网络最后的输出层。softmax通过指数归一化方式,可以强化各项之间的区分度。主要用于多分类问题的输出层,将输入值转化为表示概率分布的向量。

选择合适的激活函数取决于任务的性质和网络的结构,因此在建模过程中需要进行仔细的选择和调试。不同的激活函数适用于不同的问题和网络架构,而现在还有更多新型的激活函数被提出用于提高模型性能和稳定性。

4956

4956

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?