ctfshow—web题解

web1

题目提示

开发注释未及时删除

那就找开发注释咯,可以用F12来查看,也可以Ctrl+U直接查看源代码呢

就拿到flag了

web2

题目提示

js前台拦截 === 无效操作

沿用web1的思路,发现右键点不了了,F12也没反映了,这样可不行,我要拿到我最爱的flag!qwq

但是Ctrl+U还是可以正常用的

在 JavaScript 中,=== 是严格相等运算符,用于比较两个值的类型和数值。如果前台拦截中提示 “===

无效操作”,可能是因为在拦截的代码中,使用了不正确的语法或者操作方式导致了这个错误。

在进源码拿到flag的同时,发现

> window.oncontextmenu = function(){

return false};

> window.onselectstart = function(){

return false};

> window.onkeydown = function(){

if (event.keyCode==123){

event.keyCode=0;event.returnValue=false;}};

分析易得这段代码是用来禁止在网页上右键点击(禁用上下文菜单)、禁止选择文本和禁止按下 F12 键打开开发者工具的操作。具体功能解释如下:

window.oncontextmenu:这行代码将右键点击事件的默认行为禁止,即禁用了浏览器的上下文菜单。

window.onselectstart:这行代码阻止了文本被选中,使得用户无法通过鼠标选择页面上的文本内容。

window.onkeydown:这行代码捕获键盘按下事件,当按下的键为 F12 时,将其事件码设置为 0 并且取消默认行为,从而阻止了按下F12 键打开浏览器的开发者工具。

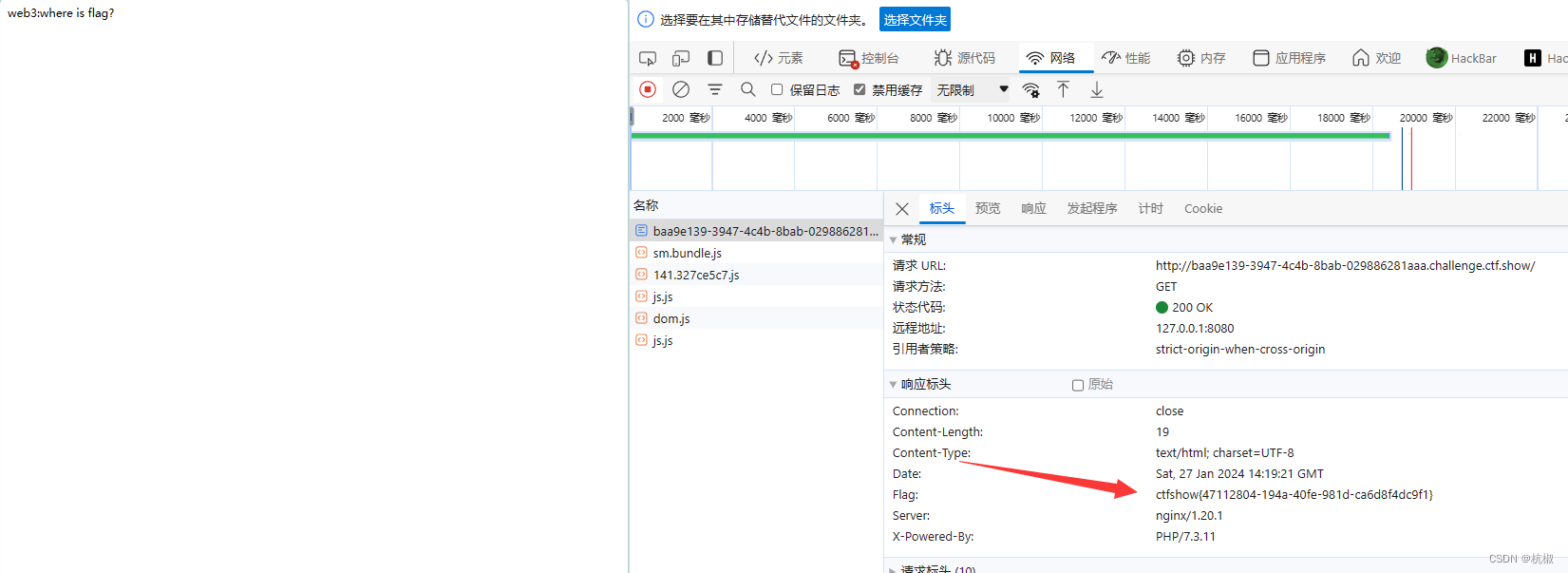

web3

题目提示

没思路的时候抓个包看看,可能会有意外收获

他让我们抓包那就抓吧,打开抓包工具burpsuite,再熟练的打开代理

肯定有人说这也没啥啊,

确实没啥,那就点点看呗,点到hex里面的时候,发现藏在这里的flag,拿下

当然在前端的网络里面也可以看到这个flag

web4

题目提示

总有人把后台地址写入

robots,帮黑阔大佬们引路。

那就得知道在网络上的robots是什么

robots.txt是一种文本文件,用于向网络爬虫(如搜索引擎的爬虫)提供网站访问的指导。它位于网站的根目录下,通过规定哪些页面可以被爬虫访问,以及哪些页面应该被忽略,来控制搜索引擎对网站内容的抓取和索引。

通过编辑robots.txt文件,网站管理员可以告诉搜索引擎爬虫哪些页面应该被排除在外,以保护隐私或防止搜索引擎浪费资源爬取不必要的页面。同时,也可以使用robots.txt来指示搜索引擎爬虫对特定页面的抓取频率限制,以避免对服务器造成过大负担。

然而,需要注意的是,robots.txt只是一种约定和建议,而并非强制规定。善意的搜索引擎会尊重robots.txt文件的指示,但恶意的爬虫可能会无视这些规则。

就拿百度的看看https://www.baidu.com/robots.txt

这里面的内容是这样的,大多数就是一些目录,如下图

知道这个就好做了,直接在后面加上robots.txt

发现个关于flag的文件,继续拼接,成功拿下flag。

web5

题目提示

phps源码泄露有时候能帮上忙

疑惑?什么是phps

phps即为 PHP So

文章讲述了在一系列CTF(CaptureTheFlag)挑战中,参与者通过解决Web安全问题、JavaScript编程、权限控制、robots.txt理解、PHP源码分析、DNS技巧、加密解密、数据库安全等方面的知识,寻找并获取隐藏的flag。每个题目涉及的具体技术点包括但不限于开发者工具、源代码查看、网络抓包、文件类型识别和加密解密等。

文章讲述了在一系列CTF(CaptureTheFlag)挑战中,参与者通过解决Web安全问题、JavaScript编程、权限控制、robots.txt理解、PHP源码分析、DNS技巧、加密解密、数据库安全等方面的知识,寻找并获取隐藏的flag。每个题目涉及的具体技术点包括但不限于开发者工具、源代码查看、网络抓包、文件类型识别和加密解密等。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

719

719

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?