一、MCP协议的定义与基本概念

1.1 什么是MCP协议

MCP(Model Context Protocol,模型上下文协议)是由Anthropic公司在2024年推出并开源的一种协议标准,旨在标准化应用程序如何为大型语言模型(LLMs)提供上下文信息。简单来说,MCP就像是AI应用的USB-C接口,提供了一种统一的方式将AI模型连接到各种数据源和工具。

正如官方所描述的:

"MCP是一种开放协议,标准化了应用程序如何为LLMs提供上下文。可以把MCP想象成AI应用的USB-C端口。正如USB-C为将设备连接到各种外设和配件提供了标准化方法,MCP为连接AI模型到不同数据源和工具提供了标准化方法。"

Model Context Protocol

1.2 MCP协议的主要目的

MCP协议的主要目的在于解决当前AI模型因数据孤岛限制而无法充分发挥潜力的难题。具体来说,MCP试图解决以下问题:

1.解决数据连接碎片化:在MCP出现前,每个AI应用都需要为不同的数据源和工具开发专用的连接器,导致集成工作繁重且难以维护。2.提供统一的数据访问机制:MCP使得AI应用能够通过同一套协议访问本地资源(如文件系统、数据库)和远程服务(如API、网络服务)。3.增强AI模型的上下文获取能力:通过MCP,LLM可以获得更丰富的上下文信息,从而生成更准确、更有价值的回答。4.促进AI生态系统标准化:作为一种开放协议,MCP旨在成为AI行业的标准,推动不同工具、平台之间的互操作性。

1.3 MCP协议的发展历程

MCP协议是AI领域相对较新的技术标准,其发展历程主要包括:

•2024年初:Anthropic公司首次公开介绍MCP协议的概念。•2024年11月:MCP协议正式开源,并发布了Python、TypeScript和Java/Kotlin等多种语言的SDK。•2025年3月:MCP协议规范更新,引入基于OAuth 2.1的身份验证框架,以及使用Streamable HTTP传输取代HTTP+SSE传输。•2025年4月:越来越多的开发者和公司开始采用MCP协议,各种MCP服务器和客户端实现蓬勃发展。

二、MCP协议的技术架构

2.1 客户端-服务器架构

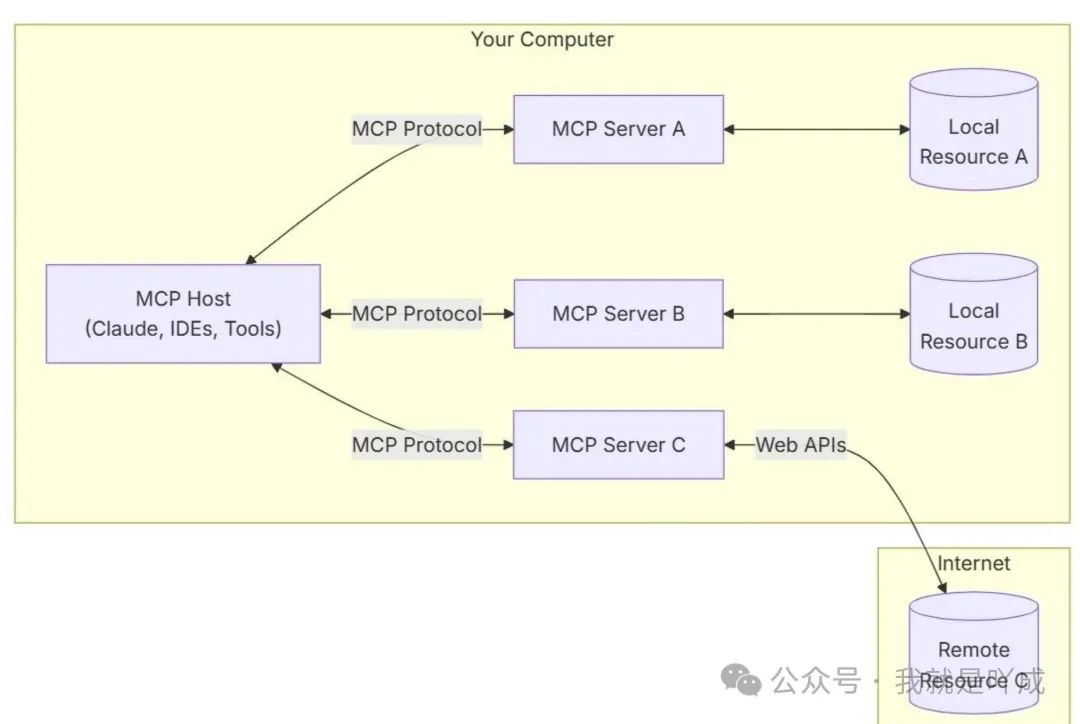

MCP采用典型的客户端-服务器(CS)架构,将系统分为三个主要组件:

1.MCP Host(主机):包括Claude Desktop、各种IDE(如Cursor、Windsurf)或其他需要通过MCP访问资源的AI应用程序。2.MCP Client(客户端):协议客户端,与服务器保持一对一连接,负责处理MCP协议的通信。3.MCP Server(服务器):轻量级程序,负责暴露特定的数据源或工具功能,并通过标准化协议与客户端交互。

这种架构使得一个MCP Host可以连接多个MCP Server,从而访问各种不同的数据源和工具,而无需为每种资源开发专用的连接器。

2.2 通信机制

MCP协议支持两种主要的通信机制:

1.基于标准输入输出(stdio)的本地通信:适用于MCP Client与Server在本地运行的场景,通过进程间的标准输入输出流进行通信。这种方式简单高效,适合本地应用。2.基于SSE(Server-Sent Events)的远程通信:在2025年3月的更新中替换为Streamable HTTP传输,适用于远程通信场景,支持Client与远程Server之间的通信。

这两种机制都使用JSON-RPC 2.0格式进行消息传输,确保消息交换的一致性和可扩展性。JSON-RPC 2.0支持三种主要消息类型:请求、响应和通知。

一个典型的JSON-RPC请求示例:

{"jsonrpc": "2.0","id": 1,"method": "read_resource","params": {"uri": "file:///home/user/document.txt"}}

2.3 四大编程模型

MCP协议定义了四种主要的编程模型,用于不同类型的交互:

1.Resources(资源):类似文件的数据,可以被客户端读取,例如文件系统中的文档、数据库中的记录等。2.Tools(工具):服务器暴露可执行的功能,如搜索、计算、API调用等,客户端可以调用这些工具来执行特定任务。3.Prompts(提示):服务器可以为特定任务提供预定义的提示模板,增强LLM的输出质量和一致性。4.Sampling(采样):允许服务器通过客户端请求LLM执行特定生成任务,这种交互模式使服务器能够利用LLM的能力。

这四种编程模型为MCP提供了丰富的交互方式,满足不同应用场景的需求。

三、MCP协议的对接方法

3.1 搭建MCP服务器

3.1.1 使用Python实现MCP服务器

Python是实现MCP服务器最简单的方式之一,下面是一个基本的MCP服务器实现示例(官网示例):

from mcp.server import FastMCPimport os# 创建MCP服务器实例app = FastMCP("file-system-server")# 定义一个工具,用于列出目录中的文件@app.tool()async def list_files(directory: str) -> list:"""列出指定目录中的所有文件Args:directory: 要列出文件的目录路径Returns:目录中的文件列表"""try:files = os.listdir(directory)return filesexcept Exception as e:return {"error": str(e)}# 定义一个资源读取功能@app.resource()async def read_text_file(uri: str) -> str:"""读取文本文件的内容Args:uri: 文件URI,格式如 file:///path/to/file.txtReturns:文件内容字符串"""# 从URI中解析文件路径if uri.startswith("file://"):path = uri[7:]else:path = uritry:with open(path, 'r', encoding='utf-8') as file:content = file.read()return contentexcept Exception as e:return {"error": str(e)}# 启动服务器if __name__ == "__main__":app.run(transport="stdio")

以上代码创建了一个简单的文件系统MCP服务器,提供了列出目录文件和读取文本文件的功能。通过@app.tool()和@app.resource()装饰器,我们可以轻松定义工具和资源。

3.1.2 使用TypeScript实现MCP服务器

对于习惯使用TypeScript的开发者,MCP也提供了完整的TypeScript SDK:

import { Server } from "@modelcontextprotocol/sdk/server/index.js";import { StdioServerTransport } from "@modelcontextprotocol/sdk/server/stdio.js";import { ListResourcesRequestSchema, ReadResourceRequestSchema } from "@modelcontextprotocol/sdk/protocol.js";import * as fs from "fs";import * as path from "path";// 创建服务器实例const server = new Server({name: "typescript-file-server",version: "1.0.0",}, {capabilities: {resources: {}}});// 实现资源列表请求处理server.setRequestHandler(ListResourcesRequestSchema, async (request) => {const directoryPath = "./documents";const files = fs.readdirSync(directoryPath);return {resources: files.map(file => ({uri: `file://${path.resolve(directoryPath, file)}`,name: file,})),};});// 实现资源读取请求处理server.setRequestHandler(ReadResourceRequestSchema, async (request) => {let filePath = request.params.uri;if (filePath.startsWith("file://")) {filePath = filePath.substring(7);}try {const content = fs.readFileSync(filePath, { encoding: "utf-8" });return {contents: [{uri: request.params.uri,mimeType: "text/plain",text: content,},],};} catch (error) {throw new Error(`Resource not found: ${error.message}`);}});// 启动服务器const transport = new StdioServerTransport();server.connect(transport).catch(console.error);

3.2 客户端集成

MCP客户端的集成通常涉及两个主要步骤:选择支持MCP的应用程序,以及配置MCP服务器连接。

3.2.1 支持MCP的客户端应用

目前支持MCP的主要客户端应用包括:

1.Claude Desktop App:Anthropic官方桌面应用,提供最完整的MCP支持。2.Cursor:AI驱动的代码编辑器,内置MCP支持。3.Windsurf:基于MCP的AI编程环境。4.Zed:高性能代码编辑器,通过提示模板和工具集成支持MCP。5.Sourcegraph Cody:通过OpenCTX集成MCP支持。

3.2.2 配置客户端连接MCP服务器

以Claude Desktop为例,配置MCP服务器连接的步骤如下:

1.安装Claude Desktop应用。2.找到Claude Desktop的配置文件,通常位于:

•Windows: %AppData%\Claude\claude_desktop_config.json•macOS: ~/Library/Application Support/Claude/claude_desktop_config.json3.编辑配置文件,添加MCP服务器配置:

{"mcp_servers": [{"name": "文件系统服务器","command": "python path/to/your/file_system_server.py","enabled": true},{"name": "数据库服务器","command": "node path/to/your/database_server.js","enabled": true}]}

1.保存配置文件并重启Claude Desktop应用。

此外,对于像Cursor这样的开发工具,通常可以在其设置界面中找到MCP配置选项,直接添加服务器配置。

3.3 多语言支持

除了Python和TypeScript外,MCP还提供了其他编程语言的支持:

1.Java/Kotlin SDK:适用于Java和Android开发者。2.C# SDK:为.NET开发者提供MCP实现。3.Go SDK:支持Go语言开发MCP服务器。

这些SDK都遵循相同的MCP协议规范,但在API设计和实现细节上可能有所不同。例如,Java SDK使用注解(Annotations)而不是装饰器来定义工具和资源,Go SDK则使用接口实现。

四、MCP协议的使用案例

4.1 文档搜索与问答系统

MCP协议可以极大地简化文档搜索和问答系统的实现。通过实现一个文档搜索MCP服务器,LLM可以直接访问、搜索和理解文档内容,从而提供更准确的回答。

一个基本的文档搜索MCP服务器示例:

from mcp.server import FastMCPimport osfrom typing import List, Dict, Anyapp = FastMCP("document-search-server")# 简单向量数据库模拟documents = {"doc1.txt": "MCP是一种开放协议,标准化了应用程序如何为大型语言模型提供上下文。","doc2.txt": "MCP协议采用客户端-服务器架构,包括主机、客户端和服务器三个组件。","doc3.txt": "使用MCP可以轻松构建智能文档搜索和问答系统。"}@app.tool()async def search_documents(query: str, max_results: int = 3) -> List[Dict[str, Any]]:"""搜索文档库并返回相关文档Args:query: 搜索查询词max_results: 最大返回结果数Returns:匹配文档列表"""results = []# 简单关键词匹配,实际应用中可以使用向量搜索for doc_id, content in documents.items():if query.lower() in content.lower():results.append({"document_id": doc_id,"content": content,"relevance": 1.0 # 简单相关度分数})return results[:max_results]@app.resource()async def get_document(uri: str) -> str:"""获取文档内容Args:uri: 文档URI,格式如 doc://doc1.txtReturns:文档内容"""if uri.startswith("doc://"):doc_id = uri[6:]if doc_id in documents:return documents[doc_id]return {"error": "文档不存在"}if __name__ == "__main__":app.run(transport="stdio")

使用这个MCP服务器,大模型可以直接进行文档搜索和获取文档内容,从而回答关于文档内容的问题。

4.2 数据库集成与查询

MCP协议也可以用于连接数据库系统,使大模型能够查询结构化数据。以下是一个简单的数据库MCP服务器实现:

from mcp.server import FastMCPimport sqlite3from typing import List, Dict, Anyapp = FastMCP("database-server")# 连接到SQLite数据库conn = sqlite3.connect("example.db")cursor = conn.cursor()# 创建示例表cursor.execute('''CREATE TABLE IF NOT EXISTS users (id INTEGER PRIMARY KEY,name TEXT,email TEXT,age INTEGER)''')conn.commit()# 插入示例数据sample_users = [(1, "张三", "zhangsan@example.com", 28),(2, "李四", "lisi@example.com", 32),(3, "王五", "wangwu@example.com", 45)]try:cursor.executemany("INSERT INTO users VALUES (?, ?, ?, ?)", sample_users)conn.commit()except sqlite3.IntegrityError:# 数据可能已存在,忽略错误pass@app.tool()async def query_database(sql: str) -> Dict[str, Any]:"""执行SQL查询并返回结果Args:sql: SQL查询语句Returns:查询结果"""try:# 仅允许SELECT查询if not sql.strip().lower().startswith("select"):return {"error": "只允许SELECT查询"}cursor.execute(sql)columns = [col[0] for col in cursor.description]results = cursor.fetchall()formatted_results = []for row in results:formatted_results.append(dict(zip(columns, row)))return {"columns": columns,"rows": formatted_results,"row_count": len(formatted_results)}except Exception as e:return {"error": str(e)}if __name__ == "__main__":app.run(transport="stdio")

通过这个MCP服务器,大模型可以查询数据库并基于查询结果回答问题,例如"查找年龄大于30的用户"或"计算所有用户的平均年龄"。

4.3 RAG技术增强与优化

检索增强生成(Retrieval-Augmented Generation,RAG)是当前大模型应用的热门方向,而MCP协议为RAG提供了更灵活、更高效的实现方式。与传统RAG不同,MCP+数据库的方式允许大模型通过SQL等查询语言直接与数据源交互,实现更精确的检索。

一个基于MCP的增强型RAG服务器示例:

from mcp.server import FastMCPimport faissimport numpy as npfrom sentence_transformers import SentenceTransformerfrom typing import List, Dict, Anyimport jsonimport osapp = FastMCP("enhanced-rag-server")# 加载文本嵌入模型model = SentenceTransformer('all-MiniLM-L6-v2')# 准备索引index_dimension = 384 # 模型输出维度index = faiss.IndexFlatL2(index_dimension)# 文档仓库documents = []document_embeddings = []# 加载示例文档def load_documents(directory):for filename in os.listdir(directory):if filename.endswith('.txt'):path = os.path.join(directory, filename)with open(path, 'r', encoding='utf-8') as file:content = file.read()documents.append({'id': len(documents),'filename': filename,'content': content})# 计算嵌入embedding = model.encode(content)document_embeddings.append(embedding)# 将嵌入添加到索引if document_embeddings:index.add(np.array(document_embeddings))# 假设文档在docs目录下if os.path.exists('docs'):load_documents('docs')@app.tool()async def semantic_search(query: str, top_k: int = 3) -> List[Dict[str, Any]]:"""执行语义搜索并返回最相关的文档Args:query: 搜索查询top_k: 返回结果数量Returns:最相关的文档列表"""# 编码查询query_embedding = model.encode(query)query_embedding = np.array([query_embedding])# 执行搜索distances, indices = index.search(query_embedding, min(top_k, len(documents)))results = []for i, doc_idx in enumerate(indices[0]):if doc_idx >= 0 and doc_idx < len(documents): # 确保索引有效doc = documents[doc_idx]results.append({'document_id': doc['id'],'filename': doc['filename'],'snippet': doc['content'][:200] + '...' if len(doc['content']) > 200 else doc['content'],'relevance_score': float(1 / (1 + distances[0][i])) # 将距离转换为相关性分数})return results@app.resource()async def get_document_content(uri: str) -> str:"""获取完整文档内容Args:uri: 文档URI,格式如 doc://1Returns:文档内容"""if uri.startswith('doc://'):try:doc_id = int(uri[6:])if 0 <= doc_id < len(documents):return documents[doc_id]['content']except ValueError:passreturn {"error": "无效的文档URI"}if __name__ == "__main__":app.run(transport="stdio")

这个增强型RAG服务器结合了向量检索和MCP协议,使大模型能够更灵活地与知识库交互。与传统的RAG不同,模型可以先了解文档摘要,然后根据需要请求完整文档,实现更高效的知识检索。

4.4 本地文件系统访问与管理

MCP协议的一个重要应用是允许AI安全地访问本地文件系统,这对于代码编辑、文档处理等场景非常有用。

from mcp.server import FastMCPimport osimport shutilfrom typing import List, Dict, Anyapp = FastMCP("filesystem-manager")@app.tool()async def list_directory(path: str) -> Dict[str, Any]:"""列出目录内容Args:path: 目录路径Returns:目录内容列表"""try:items = os.listdir(path)result = {"files": [],"directories": []}for item in items:item_path = os.path.join(path, item)if os.path.isfile(item_path):result["files"].append({"name": item,"size": os.path.getsize(item_path),"modified": os.path.getmtime(item_path)})elif os.path.isdir(item_path):result["directories"].append({"name": item,"modified": os.path.getmtime(item_path)})return resultexcept Exception as e:return {"error": str(e)}@app.tool()async def create_directory(path: str) -> Dict[str, Any]:"""创建目录Args:path: 目录路径Returns:操作结果"""try:os.makedirs(path, exist_ok=True)return {"success": True, "message": f"目录已创建: {path}"}except Exception as e:return {"success": False, "error": str(e)}@app.tool()async def delete_item(path: str, recursive: bool = False) -> Dict[str, Any]:"""删除文件或目录Args:path: 文件或目录路径recursive: 是否递归删除目录Returns:操作结果"""try:if os.path.isfile(path):os.remove(path)return {"success": True, "message": f"文件已删除: {path}"}elif os.path.isdir(path):if recursive:shutil.rmtree(path)return {"success": True, "message": f"目录已递归删除: {path}"}else:os.rmdir(path)return {"success": True, "message": f"目录已删除: {path}"}else:return {"success": False, "error": "文件或目录不存在"}except Exception as e:return {"success": False, "error": str(e)}@app.resource()async def read_file(uri: str) -> str:"""读取文件内容Args:uri: 文件URI,格式如 file:///path/to/file.txtReturns:文件内容"""if uri.startswith("file://"):path = uri[7:]else:path = uritry:with open(path, 'r', encoding='utf-8') as file:content = file.read()return contentexcept Exception as e:return {"error": str(e)}@app.tool()async def write_file(path: str, content: str) -> Dict[str, Any]:"""写入文件内容Args:path: 文件路径content: 文件内容Returns:操作结果"""try:with open(path, 'w', encoding='utf-8') as file:file.write(content)return {"success": True, "message": f"文件已写入: {path}"}except Exception as e:return {"success": False, "error": str(e)}if __name__ == "__main__":app.run(transport="stdio")

通过这个文件系统MCP服务器,大模型可以安全地浏览、读取、创建和修改本地文件,大大增强了它在本地环境中的能力。

五、MCP的最佳实践

5.1 安全性考量

5.1.1 身份验证和授权

在实现MCP服务器时,应特别注意身份验证和授权机制:

1.采用标准化协议:使用OAuth 2.0/OAuth 2.1或OpenID Connect等标准化协议进行认证。2.安全存储凭据:使用加密数据库(如CyberArk Conjur、HashiCorp Vault)安全存储凭据。3.安全令牌处理:使用JWT,实施令牌轮换和安全存储。4.实施授权检查:使用基于角色的访问控制(RBAC)和访问控制列表(ACL)。

5.1.2 数据安全

保护MCP服务器和客户端之间交换的数据至关重要:

1.使用TLS加密:确保所有网络传输使用TLS加密,并验证证书的有效性。2.数据清理:使用适当的库对输入数据进行验证和清理,防止SQL注入、命令注入等攻击。3.敏感数据处理:避免在日志中记录敏感信息,并实施适当的数据屏蔽机制。

5.1.3 网络安全

保护MCP服务器免受网络攻击:

1.速率限制:实施请求速率限制,防止滥用。2.超时设置:设置合理的连接和读取超时,防止资源耗尽。3.DoS保护:实施断路器和流量节流机制,防止拒绝服务攻击。4.异常监控:通过SIEM工具监控异常行为和请求模式。5.防火墙配置:适当配置防火墙规则和网络分段,限制对MCP服务器的访问。

5.2 性能优化

5.2.1 内存管理

MCP服务器的内存管理对于性能至关重要:

1.资源池化:对于数据库连接、HTTP客户端等资源,使用连接池来减少资源创建和销毁的开销。2.缓存机制:实现适当的缓存机制,缓存常用的查询结果、文件内容等,减少重复操作。3.内存限制:设置服务器的内存使用限制,防止单个请求消耗过多资源。

5.2.2 异步处理

利用异步处理提高MCP服务器的性能:

1.异步IO:使用异步IO操作处理文件读写,避免阻塞主线程。2.任务队列:对于耗时操作,考虑使用任务队列和工作线程池。3.流式处理:对于大文件或大数据集,使用流式处理而不是全部加载到内存。

5.3 错误处理与日志记录

健壮的错误处理和全面的日志记录对于MCP服务器的可维护性至关重要:

1.错误分类:将错误分为可恢复和不可恢复两类,对于可恢复错误实施重试策略。2.详细错误信息:提供详细的错误信息,但避免泄露敏感信息。3.结构化日志:使用结构化日志格式,便于分析和监控。4.请求跟踪:为每个请求分配唯一ID,便于跟踪整个请求生命周期。5.性能指标:记录关键性能指标,如请求处理时间、资源使用情况等。

Python示例:

import loggingimport uuidfrom contextvars import ContextVarimport time# 配置结构化日志logging.basicConfig(level=logging.INFO,format='%(asctime)s [%(levelname)s] %(request_id)s - %(message)s')# 请求ID上下文变量request_id_var = ContextVar('request_id', default=None)# 日志过滤器,添加请求IDclass RequestIdFilter(logging.Filter):def filter(self, record):record.request_id = request_id_var.get() or '-'return Truelogger = logging.getLogger('mcp_server')logger.addFilter(RequestIdFilter())async def handle_request(method, params):# 生成并设置请求IDrequest_id = str(uuid.uuid4())request_id_var.set(request_id)start_time = time.time()logger.info(f"Received request: {method} with params: {params}")try:# 处理请求...result = await process_request(method, params)elapsed = time.time() - start_timelogger.info(f"Request completed in {elapsed:.3f}s")return resultexcept Exception as e:elapsed = time.time() - start_timelogger.error(f"Request failed after {elapsed:.3f}s: {str(e)}", exc_info=True)raise

六、MCP与其他技术的对比

6.1 MCP vs Function Calling

MCP协议和Function Calling都是允许大模型与外部工具交互的机制,但它们有一些关键区别:

| 特性 | MCP | Function Calling |

| 架构模式 | 客户端-服务器架构 | 内置于模型API中 |

| 跨模型兼容性 | 高(与模型无关) | 低(每个模型供应商有自己的实现) |

| 本地资源访问 | 原生支持 | 有限,通常需要自定义集成 |

| 互操作性 | 高,标准化协议 | 有限,依赖特定模型API |

| 数据安全 | 更安全,数据可保留在本地 | 可能需要将数据发送到模型供应商 |

| 复杂性 | 需要额外的服务器组件 | 相对简单,直接调用API |

从大的角度来看,MCP和Function Calling是互补的:MCP解决的是"理解"(为模型提供上下文),而Function Calling解决的是"行动"(模型调用函数执行操作)。在实际应用中,两者可以结合使用,提供更完整的解决方案。

6.2 MCP vs Agent-to-Agent Protocol

MCP协议与Google的Agent-to-Agent(A2A)协议都是致力于提高AI系统互操作性的标准,但它们有不同的关注点:

| 特性 | MCP | A2A |

| 主要目的 | 连接AI模型与外部数据和工具 | 促进不同AI代理之间的通信和协作 |

| 架构模式 | 客户端-服务器架构 | 对等通信架构 |

| 使用场景 | 单一AI访问外部资源 | 多个AI代理协作完成任务 |

| 协议复杂性 | 相对简单,专注于数据访问 | 更复杂,包含状态管理和协作机制 |

| 实现成熟度 | 较成熟,有多种语言的SDK | 相对新兴,生态系统仍在发展中 |

MCP和A2A可以看作是互补的协议:MCP让AI与数据源和工具交互,而A2A让不同的AI代理之间进行协作。在复杂的AI系统中,两种协议可以结合使用,MCP处理资源访问,A2A处理代理协作。

6.3 MCP在AI应用生态中的定位

MCP作为一种开放标准,在AI应用生态中扮演着重要角色:

1.统一接口层:MCP为AI模型提供了统一的接口,简化了与各种数据源和工具的集成。2.生态系统催化剂:MCP促进了工具和服务的生态系统发展,开发者可以构建可复用的MCP服务器,供不同的AI应用使用。3.本地优先的AI基础设施:MCP使得构建尊重隐私的本地优先AI应用变得更加容易,数据可以保持在用户设备上。4.跨模型互操作性:通过MCP,开发者可以构建不依赖于特定AI模型供应商的应用,实现更大的灵活性。5.专业开发的桥梁:MCP使AI领域的专业开发者和工具开发者能够更紧密地协作,后者可以专注于打造优秀的工具,前者可以无缝集成这些工具。

七、总结与展望

7.1 MCP的当前状态

MCP协议作为一种新兴的标准,正在逐渐获得广泛的接受和采用。当前,MCP已经有了丰富的工具和服务:

1.多种语言的SDK:包括Python、TypeScript、Java/Kotlin、C#等。2.丰富的客户端应用:如Claude Desktop、Cursor、Windsurf等。3.多样化的服务器实现:从文件系统到数据库,从网络工具到生产力应用。4.活跃的开发者社区:不断贡献新的工具和改进。

7.2 MCP的发展趋势

展望未来,MCP协议可能沿着以下方向发展:

1.安全性增强:更强大的身份验证和授权机制,更严格的资源访问控制。2.性能优化:更高效的通信协议,更智能的缓存机制。3.生态系统扩展:更多的预构建MCP服务器,覆盖更广泛的应用场景。4.跨协议集成:与A2A等其他协议的无缝集成,构建更复杂的AI系统。5.标准化和认证:可能会出现MCP兼容性认证,确保不同实现之间的互操作性。

7.3 MCP的应用前景

MCP协议的应用前景非常广阔,可能影响多个领域:

1.企业AI应用:MCP使企业能够安全地连接内部数据源和工具,构建强大的AI应用。2.个人生产力工具:基于MCP的个人AI助手可以访问本地文件和应用,提供个性化服务。3.开发工具链:MCP可以将AI深度集成到开发工具链中,提高开发者生产力。4.智能家居与物联网:MCP可用于连接智能设备和传感器,构建更智能的家居系统。5.教育和研究:MCP可以让教育工具和研究平台更容易集成AI功能,促进知识传播和科学发现。

八、参考资源

1.Model Context Protocol官方网站2.MCP GitHub仓库3.Anthropic MCP文档4.MCP规范5.awesome-mcp-servers

MCP协议代表了AI应用开发的一个重要趋势:通过标准化接口将AI模型与外部世界连接起来。随着越来越多的开发者和企业采用这一协议,我们可以期待看到更多创新的AI应用出现,这些应用能够更智能、更安全、更有效地与用户的数据和工具交互。无论是开发者、企业还是最终用户,都将从这一开放标准带来的互操作性和生态系统中受益。

如何学习AI大模型?

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?