论文题目:A Conditional Diffusion Model With Fast Sampling Strategy for Remote Sensing Image Super-Resolution

论文链接:https://ieeexplore.ieee.org/document/10677485

论文代码:https://github.com/Meng-333/FastDiffSR

checkpoint:百度网盘 https://pan.baidu.com/s/1VMSjKKCu3VqKUOV-wycMDA?pwd=0115 or 谷歌网盘 https://drive.google.com/drive/folders/16e4WKUxFNz3H0Dafrc8pFSnU54pKI8l4?usp=drive_link

发表时间:2024.9.11

其它说明:如果我们的论文或代码对您有所帮助,请引用致谢!

1. 背景

超分辨率方法有潜力增强低分辨率遥感影像的空间细节,对于细节至关重要的应用尤为重要。根据输入影像的数量,超分辨率方法分为多幅和单幅超分算法两种。考虑到遥感观测容易受到云、掩体和物体运动的影响,大多数情况下很难在指定位置上同时获取多幅可用的遥感影像。单幅遥感影像超分辨率算法的适用性更强,更便捷。因此开展单幅遥感影像超分辨率算法研究,不仅可以为遥感实际应用提供更广泛的数据基础,也有望提升遥感影像在影像分类、目标识别、变化监测等应用的应用精度和应用水平。近年来,扩散模型作为一种深度生成模型,在图像生成、视频生成任务中表现优异,为遥感影像超分辨率方法研究提供了新的方向。

2. 摘要

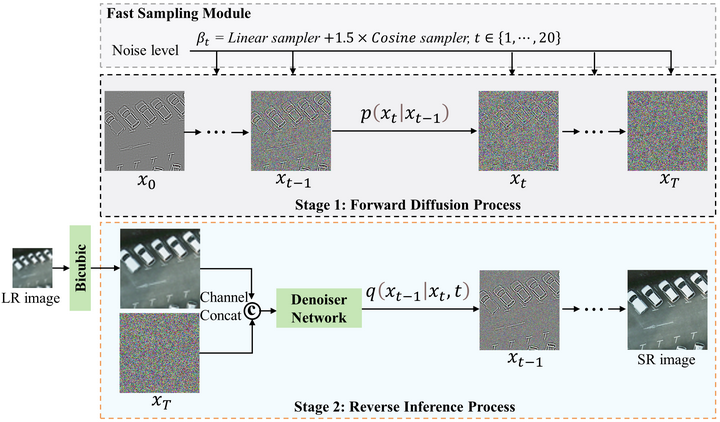

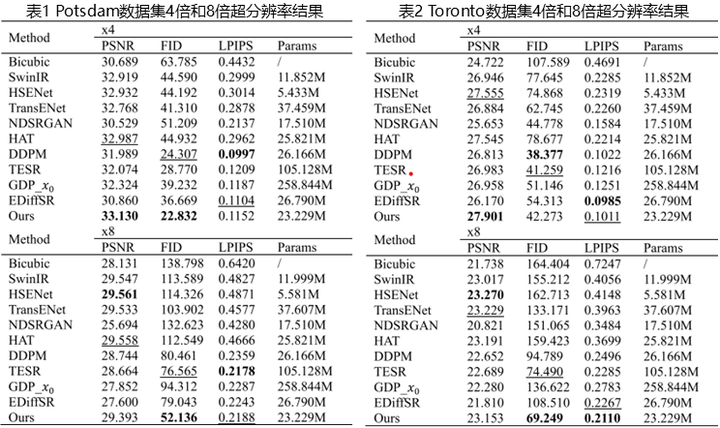

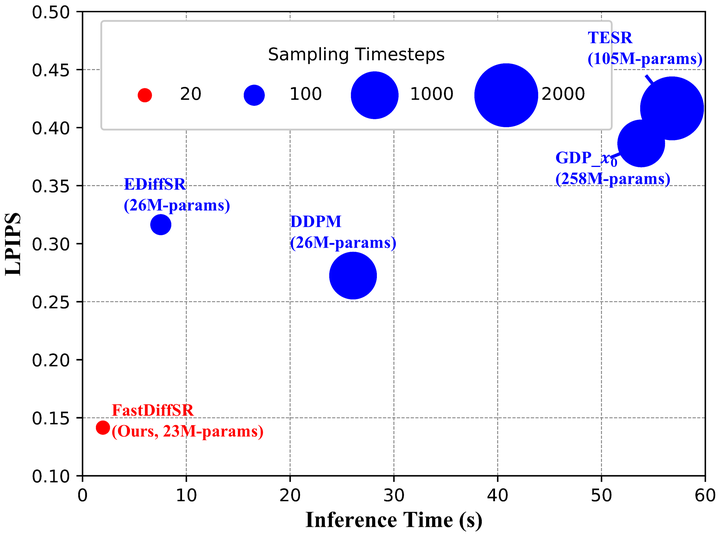

传统的基于深度学习的单幅遥感影像超分辨率 (SRSISR) 方法取得了显著进展。然而,这些方法的超分辨率 (SR) 输出在视觉质量方面尚未令人足够满意。最近基于扩散模型的生成式深度学习模型能够增强输出图像的视觉质量,但由于其采样效率而限制了这种能力。在本文中,我们提出了一种基于条件扩散模型的 SRSISR 方法(FastDiffSR)。具体而言,我们设计了一种新颖的采样策略来减少扩散模型所需的采样步数,同时保证了采样质量。此外,提出了一个23M参数量的去噪网络,该网络使用残差图像作为输入,以降低计算成本并提高噪声预测的准确性。与最先进的CNN-based, GAN-based,和Transformer-based的 SR 方法相比,我们的 FastDiffSR 将视觉质量指标learned perceptual image patch similarity (LPIPS) 提高了 0.1-0.2,并在某些真实世界场景中取得了更满意的推理结果。与现有的Diffusion-based的 SR 方法相比,我们的FastDiffSR 在具有较小模型参数的情况下,在像素级评估指标峰值信噪比 (PSNR) 方面取得了显著的提升,并且在 Vaihingen 数据上获得了更接近地面实况的 SR 结果,推理时间缩短了 3-28倍,表现出出色的泛化能力和时间效率。

3. 方法

本文提出了一种基于条件扩散模型的单幅遥感影像超分辨率重建加速框架,结合设计的快速采样策略,在2个高空间分辨率、多场景类别的遥感数据集进行验证,该方法有效降低了扩散模型所需的采样步数同时保证了模型的采样质量,有望助力扩散模型与其他遥感下游视觉任务相结合的应用研究。

4. 数据集和评价指标

本文获取了22,852个高分辨率遥感影像样本(256×256大小),其中训练集18,304个样本,测试集4,548个样本。涵盖多种类型遥感场景的高分辨率遥感影像,包括建筑物、草地、汽车、停车场、树木、道路等遥感场景。

研究使用五种广泛使用的图像质量评估指标,包括包括峰值信噪比(PSNR)、弗雷歇距离指数(FID)、图像感知相似性(LPIPS) 、无参考平均梯度(AG)和无参考自然图像质量评估(NIQE)。

Dataset Link: https://pan.baidu.com/s/1VOBxWpqXCJIZeoBwKqSe6w?pwd=0115 or https://drive.google.com/drive/folders/1W_ZWHp8BhoeLdEKLF3eAsZTneaVJVgLy?usp=sharing

5. 实验

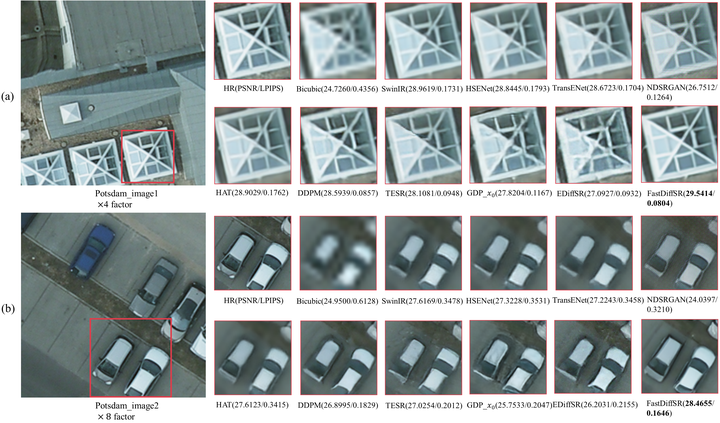

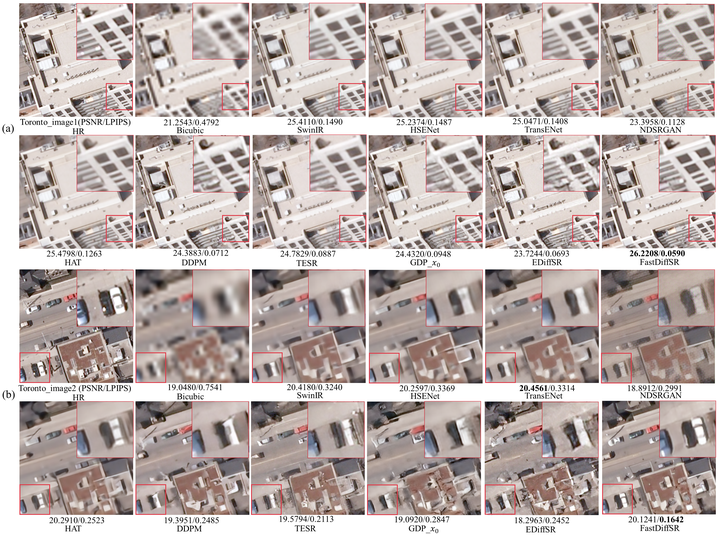

实验结果表明,本文提出的FastDiffSR方法在多组超分辨率任务上均表现优异,在高质量视觉重建和时间效率方面具有优势。

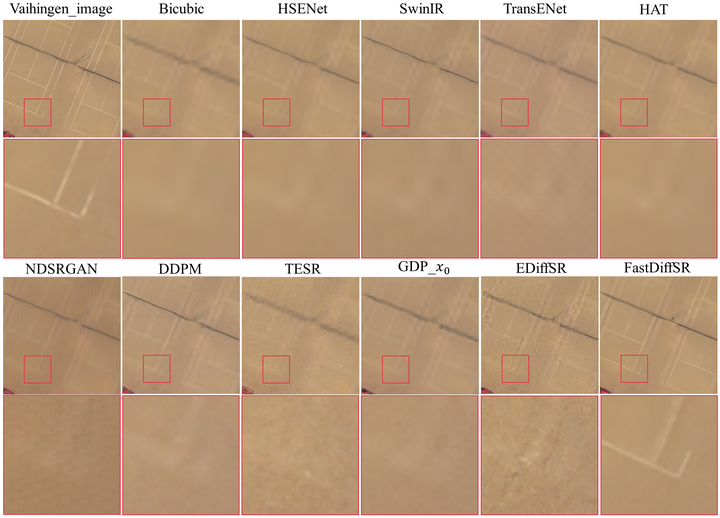

为了验证所提方法的效率优势和泛化性能,本文在Vaihingen影像上开展了8倍超分辨率重建实验。与主流Diffusion-based方法相比,本文FastDiffSR模型的采样步数降低了5倍以上,推理时间缩短了 3-28倍,表现出出色的效率优势。

此外,本文方法也获得了更接近地面实况的 SR 结果,在评价指标和视觉效果两方面均优于现有代表性的超分辨率模型NDSRGAN、 HAT和最新模型EDiffSR。

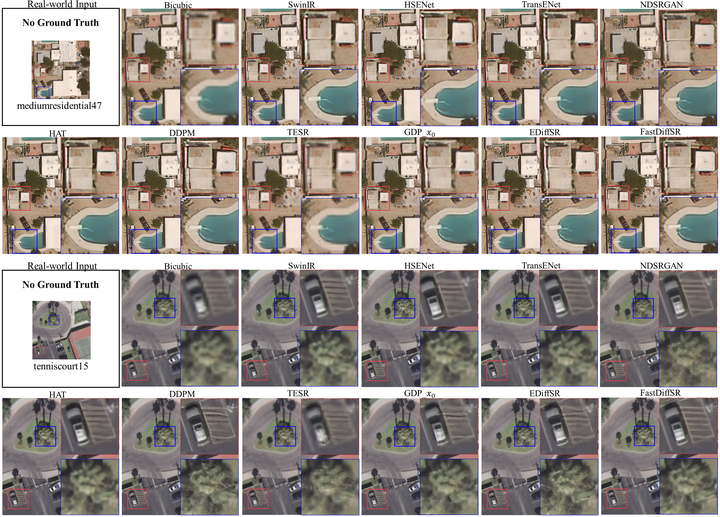

为了检验所提方法在复杂场景下的应用前景,本文在多张UC Merced影像上开展了推理实验,可以看出该方法有效提升了其空间分辨率,生成了更满意的超分辨率结果。

6. 结论

我们提出了一种新的条件扩散模型(FastDiffSR)方法来生成高视觉质量的遥感影像,同时提高采样效率。与现有的diffusion-based的方法相比,我们开发了一种新的采样技术来减少扩散模型的采样步骤数。具体来说,我们结合了线性采样器和余弦采样器,在确保采样质量的同时实现了 20 步骤采样。为了降低计算成本,我们还引入了残差图像,并证明使用通道注意力和空间注意力可以进一步提高 LPIPS指标分数。在两个基准数据集上的实验表明,我们的方法在视觉质量方面优于CNN-based, GAN-based和Transformer-based的方法,定量结果优于SOTA diffusion-based的方法,同时模型尺寸更小。此外,FastDiffSR在某些真实场景中比其他 SOTA SR 方法生成了更好的 SR 结果。在 Vaihingen 数据上获得了更准确的 SR 结果,推理时间比diffusion-based的方法快 3-28 倍,表现出出色的泛化能力和效率优势。未来,我们计划将 FastDiffSR 扩展到多种退化因素的遥感影像盲超分辨率任务,以提高其现实世界的实际应用水平。

3751

3751

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?