来写作业了

要使用Selenium和第三方浏览器驱动(如ChromeDriver)来完成搜狐网页的信息爬取,首先需要确保已经安装了Selenium库,并且下载了与你的Chrome浏览器版本相匹配的ChromeDriver。

安装Selenium包和ChromeDriver驱动

安装Selenium库

在命令行输入 pip install Selenium 或在anaconda prompt 中输入conda install Selenium。

安装 chromedriver

先查看chrome浏览器的版本

这里是 123.0.6312.106 版

然后在http://npm.taobao.org/mirrors/chromedriver/或者https://googlechromelabs.github.io/chrome-for-testing/

中下载对应版本的chromediver

由于没有106版的这里下的是122版,试过了也可以。

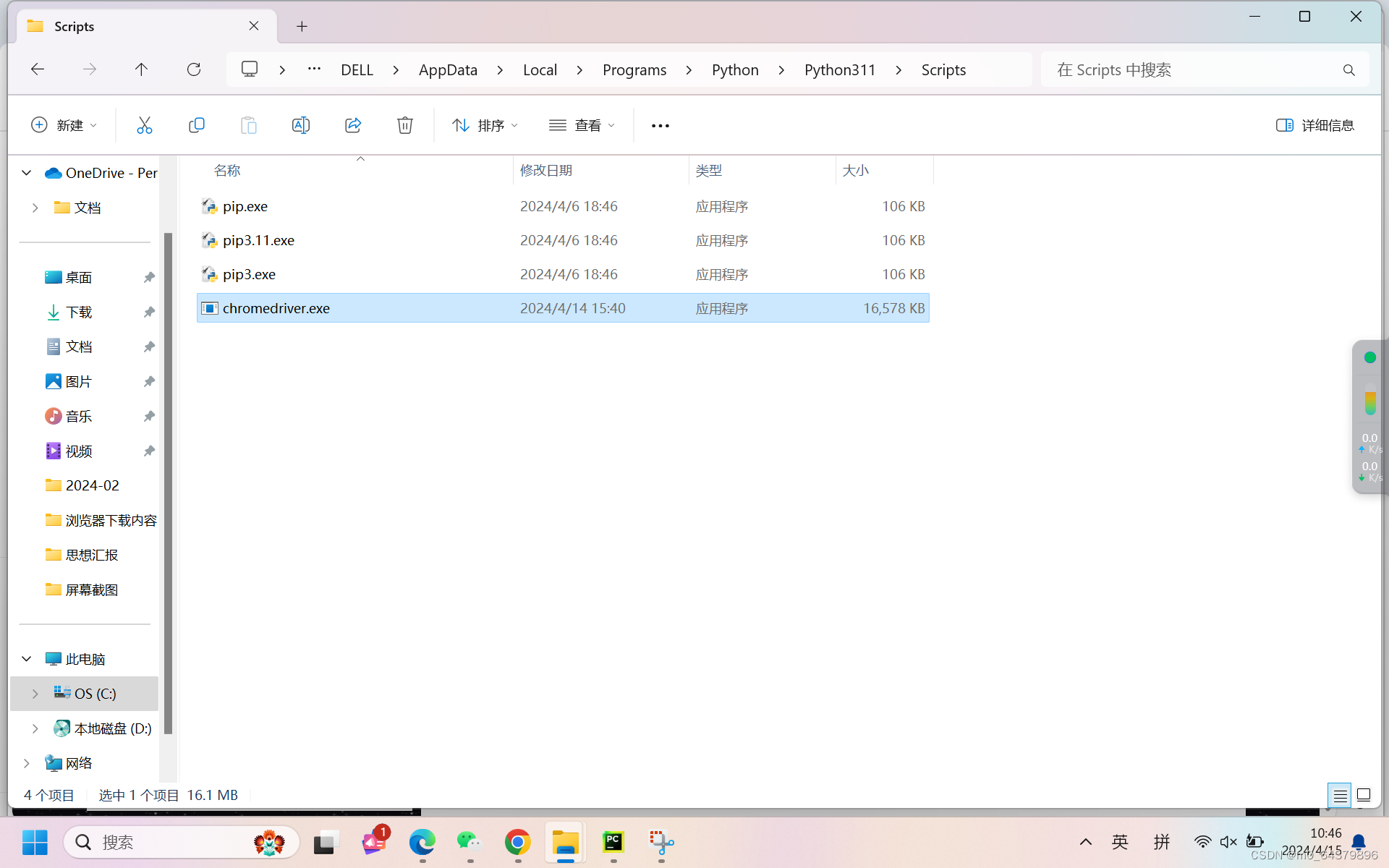

下载解压后

把exe文件复制到chrome浏览器的安装目录和python的安装目录scripts文件夹下

测试

from selenium import webdriver

browser=webdriver.Chrome()

browser.get('https://www.sohu.com/')

自动打开搜狐网页

代码实现

导入包

import re

import time

from selenium import webdriver

from selenium.webdriver.chrome.service import Service

from selenium.webdriver.chrome.options import Options

from selenium.webdriver.common.by import By

配置ChromeDriver 的路径并启动浏览器

# 设置 ChromeDriver 的路径

chrome_driver_path = 'D:\浏览器下载内容\chromedriver-win64\chromedriver-win64\chromedriver.exe'

# 创建 Chrome WebDriver

# 创建 Chrome Options 对象

# chrome_options = Options()

# chrome_options.add_argument('--headless') # 无头模式,即不显示浏览器窗口

service = Service(chrome_driver_path)

driver = webdriver.Chrome(service=service)

# 打开搜狐网站

driver.get("https://www.sohu.com/")

time.sleep(2)获取当前页面的Html源码

html_source = driver.page_source

print("HTML 源码:")

print(html_source)运行结果

获取当前页面的URL

# 获取当前网页的 URL

current_url = driver.current_url

print("\n当前网页的 URL:")

print(current_url)运行结果

获取classname为‘txt’的页面元素

# 使用 find_elements 方法查找 class 属性为 'txt' 的元素

txt_elements = driver.find_elements(By.CLASS_NAME, "txt")

print("txt")

# 遍历输出每个元素的文本内容

for element in txt_elements:

print(element.text)

运行结果

获取 标签 属性为 ‘footer’ 的元素文本

# 使用 find_elements 方法查找 标签 属性为 'footer' 的元素

txt_elements = driver.find_elements(By.TAG_NAME, "footer")

print("footer")

# 遍历输出每个元素的文本内容

for element in txt_elements:

print(element.text)运行结果

获取 class 属性为 ‘titleStyle’ 的元素的文本及href链接

# 使用 find_elements 方法查找 class 属性为 'titleStyle' 的元素

title_elements = driver.find_elements(By.CLASS_NAME, "titleStyle")

# 遍历输出每个元素的文本内容

for element in title_elements:

text = element.text

href = element.get_attribute("href")

print(f"Text: {text}, Href: {href}")

运行结果

获取 xpath 搜狐首页的导航栏标签 及 href链接

# 使用 find_elements 方法查找 xpath 搜狐首页的导航栏标签

title_elements = driver.find_elements(By.XPATH, "/html/body/div[2]/div/nav[@class='nav area']//a")

print("xpath")

# 遍历输出每个元素的文本内容

for element in title_elements:

inner_html = element.get_attribute("innerHTML")

text = re.sub(r'<[^>]*>', '', inner_html).strip()

if text:

href = element.get_attribute("href")

print(f"Text: {text}, Href: {href}")运行结果

关闭webDriver

# 关闭 WebDriver

driver.close()

driver.quit()完整代码

import re

import time

from selenium import webdriver

from selenium.webdriver.chrome.service import Service

from selenium.webdriver.chrome.options import Options

from selenium.webdriver.common.by import By

chrome_driver_path = 'D:\浏览器下载内容\chromedriver-win64\chromedriver-win64\chromedriver.exe'

# 创建 Chrome WebDriver

# # 创建 Chrome Options 对象

# chrome_options = Options()

# chrome_options.add_argument('--headless') # 无头模式,即不显示浏览器窗口

service = Service(chrome_driver_path)

driver = webdriver.Chrome(service=service)

# 打开搜狐网站

driver.get("https://www.sohu.com/")

time.sleep(2)

# 获取当前网页的 HTML 源码

html_source = driver.page_source

print("HTML 源码:")

print(html_source)

# 获取当前网页的 URL

current_url = driver.current_url

print("\n当前网页的 URL:")

print(current_url)

# 使用 find_elements 方法查找 class 属性为 'txt' 的元素

txt_elements = driver.find_elements(By.CLASS_NAME, "txt")

print("txt")

# 遍历输出每个元素的文本内容

for element in txt_elements:

print(element.text)

# 使用 find_elements 方法查找 标签 属性为 'footer' 的元素

txt_elements = driver.find_elements(By.TAG_NAME, "footer")

print("footer")

# 遍历输出每个元素的文本内容

for element in txt_elements:

print(element.text)

# 使用 find_elements 方法查找 标签 属性为 'Keywords' 的元素

# 使用 find_elements 方法查找 class 属性为 'titleStyle' 的元素

title_elements = driver.find_elements(By.CLASS_NAME, "titleStyle")

print("titlestyle")

# 遍历输出每个元素的文本内容

for element in title_elements:

text = element.text

href = element.get_attribute("href")

print(f"Text: {text}, Href: {href}")

# # 使用 find_elements 方法查找 xpath 搜狐首页的导航栏标签

# title_elements = driver.find_elements(By.XPATH, "/html/body/div[2]/div/nav[@class='nav area']//a")

# # 遍历输出每个元素的文本内容

# for element in title_elements:

# text = element.get_attribute("innerHTML").strip()

# if text:

# href = element.get_attribute("href")

# print(f"Text: {text}, Href: {href}")

# 使用 find_elements 方法查找 xpath 搜狐首页的导航栏标签

title_elements = driver.find_elements(By.XPATH, "/html/body/div[2]/div/nav[@class='nav area']//a")

print("xpath")

# 遍历输出每个元素的文本内容

for element in title_elements:

inner_html = element.get_attribute("innerHTML")

text = re.sub(r'<[^>]*>', '', inner_html).strip()

if text:

href = element.get_attribute("href")

print(f"Text: {text}, Href: {href}")

# 关闭 WebDriver

driver.close()

driver.quit()

本文参考这位大佬 原文链接:https://blog.csdn.net/m0_68319844/article/details/137515463

274

274

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?