目录

Local下的角色分布:

资源管理:

Master:Local进程本身

Worker:Local进程本身

任务执行:

Driver:Local进程本身

Executor:不存在,没有独立的Executor角色, 由Local进程(也就是Driver)内的线程提供计算能力

Anaconda On Linux 安装 (单台服务器)

1.下载+安装

在https://www.anaconda.com/download/success中下载安装包并上传到linux服务器上

我的对应的是python3.12

使用命令

sh ./Anaconda3-2024.06-1-Linux-x86_64.sh输入yes后就安装完成了

安装完成后,,退出SecureCRT重新进来,看到开头有Base表面安装好了

base是默认的虚拟环境

2.国内源

在/root下新建文件.bashrc,加入以下内容

channels:

- defaults

show_channel_urls: true

default_channels:

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/r

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/msys2

custom_channels:

conda-forge: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

msys2: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

bioconda: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

menpo: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

pytorch: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

simpleitk: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud下载Spark安装包

1.下载

在https://spark.apache.org/downloads.html中下载spark并把压缩包上传到linux服务器上。

我将其放在/export/server目录下

2.解压

使用命令

tar -zxvf spark-3.5.2-bin-hadoop3.tgz -C /export/server将spark目录解压到/export/server目录下

3.环境变量

配置Spark由如下5个环境变量需要设置

- SPARK_HOME: 表示Spark安装路径在哪里

- PYSPARK_PYTHON: 表示Spark想运行Python程序, 那么去哪里找python执行器

- JAVA_HOME: 告知Spark Java在哪里

- HADOOP_CONF_DIR: 告知Spark Hadoop的配置文件在哪里

- HADOOP_HOME: 告知Spark Hadoop安装在哪里

PYSPARK_PYTHON在Anaconda目录下的/bin/python3.12

这5个环境变量 都需要配置在: /etc/profile中

PYSPARK_PYTHON和 JAVA_HOME 需要同样配置在: /root/.bashrc中

测试

转到$SPARK_HOME/bin目录,输入./pyspark,当出现一下界面说明启动成功。

执行一个pyspark代码体验一下

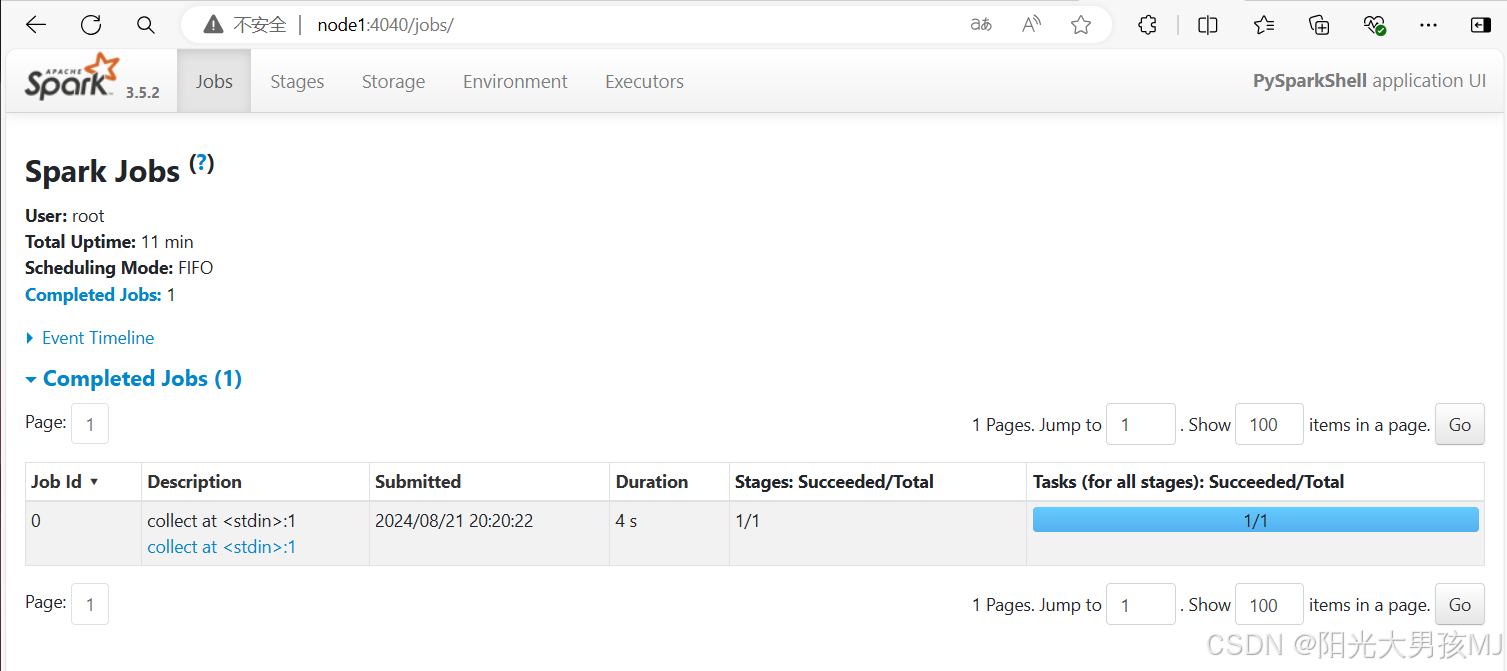

监控

我们可以在标记的地方看到一个地址,这个地址可以查看Driver的运行情况。

输入地址可以看到这样的界面

在这里可以看到里面记录了一个任务就是刚刚进行数组元素加一的任务。

572

572

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?