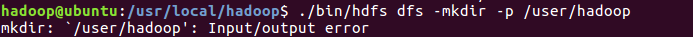

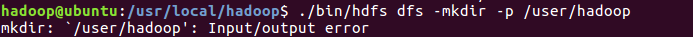

这个问题是关于配置文件没有配好,在路径 /usr/local/hadoop/etc/hadoop中有两个配置文件,hdfs-site.xml和core-site.xml,配置成如下图(图一为hdfs,图二为core)

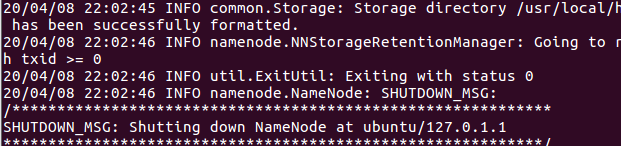

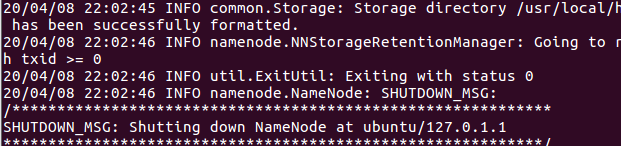

然后进入usr/local/hadoop/bin目录,进行格式化,格式化语句为./hdfs namenode -format(这是第一次使用的时候这么用,后面用hdfs fds xxxx),

出现status 0才行,如下图

接下来就很顺利了

这个问题是关于配置文件没有配好,在路径 /usr/local/hadoop/etc/hadoop中有两个配置文件,hdfs-site.xml和core-site.xml,配置成如下图(图一为hdfs,图二为core)

然后进入usr/local/hadoop/bin目录,进行格式化,格式化语句为./hdfs namenode -format(这是第一次使用的时候这么用,后面用hdfs fds xxxx),

出现status 0才行,如下图

接下来就很顺利了

1777

1777

648

648

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?