ELK日志分析系统

一、ELK概述

1、ELK日志分析系统

ELK是由Elasticsearch、Logstash、Kiban三个开源软件的组合。在实时数据检索和分析场合,三者通常是配合共用,而且又都先后归于 Elastic.co 公司名下,故有此简称。

2.、ELK中日志处理步骤

1.将日志进行集中化管理(beats)

2.将日志格式化(Logstash),然后将格式化后的数据输出到Elasticsearch

3.对格式化后的数据进行索引和存储(Elasticsearch)

4.前端数据的展示(Kibana)

二、ELK简介

1、ElasticSearch介绍

Elasticsearch是一个基于Lucene的搜索服务器。它提供了一个分布式多用户能力的全文搜索引擎,基于RESTful web接口。Elasticsearch是用Java开发的,并作为Apache许可条款下的

开放源码发布,是第二流行的企业搜索引擎。设计用于云计算中,能够达到实时搜索,稳定,可革,快速,安装使用方便。

2、ElasticSearch核心概念

(1)Elasticsearch的特性

接近实时的搜索

集群

节点

索引

索引(库)→类型(表)→文档(记录)

分片和副本

(2)分片和副本

在上述特性中,最重要的就是分片和副本,也是让es数据库(Elasticsearch)成为百度这些主流搜索引擎的主要原因,理论上能提升4倍的性能。

结合实际情况分析:索引存储的数据可能超过单个节点的硬件限制,如一个10亿文档需1TB空间可能不适合存储在单个节点的磁盘上,或者从单个节点搜索请求太慢了,为了解决这个问

题,elasticsearch提供将索引分成多个分片的功能,当在创建索引时,可以定义想要分片的数量。每个分片就是一个全功能的独立索引,可以位于集群中任何节点上。

分片的特点:

水平分割扩展,增大存储量

分布式并行跨分片操作,提供性能和吞吐量

分布式分片的机制和搜索请求的文档如何汇总完全是有elasticsearch控制的,这些对用户而言是透明的

网络问题等等其他问题可以在任何时候不期而至,为了健壮性,强烈建议要有个故障切换机制,无论何种故障以防止分片或者节点不可用,为此,elasticsearch让我们将索引分片复制一

份或多份,称为分片副本或副本

副本的特点:

高可用性,以应对分片或者节点故障,出于这个原因,分片副本要在不同的节点上

性能加强,增加吞吐量,搜索可以并行在所有副本上执行

3、LogStash概述

一款强大的数据处理工具

可实现数据传输、格式处理、格式化输出

数据输入、数据加工(如过滤,改写等)以及数据输出

常用插件:Input、Filter Plugin、Output

Input:收集源数据(访问日志、错误日志等)

Filter Plugin:用于过滤日志和格式处理

4、Kibana概述

一个针对Elasticsearch的开源分析及可视化平台

搜索、查看存储在Elasticsearch索引中的数据

通过各种图表进行高级数据分析及展示

Kibana主要功能

Elasticsearch无缝之集成

Kibana架构为Elasticsearch定制,可以将任何结构化和非结构化数据加入Elasticsearch索引。Kibana还充分利用了Elasticsearch强大的搜索和分析功能。

整合数据

Kibana能够更好地处理海量数据,并据此创建柱形图、折线图、散点图、直方图、饼图和地图。

复杂数据分析

Kibana提升了Elasticsearch分析能力,能够更加智能地分析数据,执行数学转换并且根据要求对数据切割分块。

让更多团队成员收益

强大的数据库可视化接口让各业务岗位都能够从数据集合受益。

接口灵活,分享更容易

使用Kibana可以更加方便地创建、保存、分享数据,并将可视化数据快速交流。

配置简单

Kibana的配置和启用非常简单,用户体验非常友好。Kibana自带Web服务器,可以快速启动运行。

可视化多数据源

Kibana可以非常方便地把来自Logstash、ES-Hadoop、Beats或第三方技术的数据整合到Elasticsearch,支持的第三方技术包括Apache flume、 Fluentd 等。

简单数据导出

Kibana可以方便地导出感兴趣的数据,与其它数据集合并融合后快速建模分析,发现新结果。

三、部署ELK日志分析系统

| node1 | 192.168.224.100 | Elasticsearch 、 Kibana |

| node2 | 192.168.224.103 | Elasticsearch |

| Apache | 192.168.224.104 | Logstash Apache |

1、安装ElasticSearch

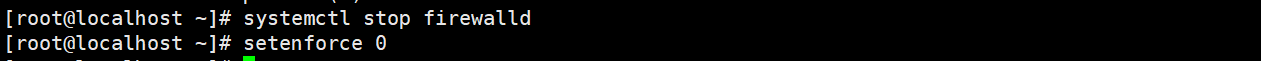

systemctl stop firewalld

#关闭防火墙

setenforce 0

java -version

#查看jdk环境

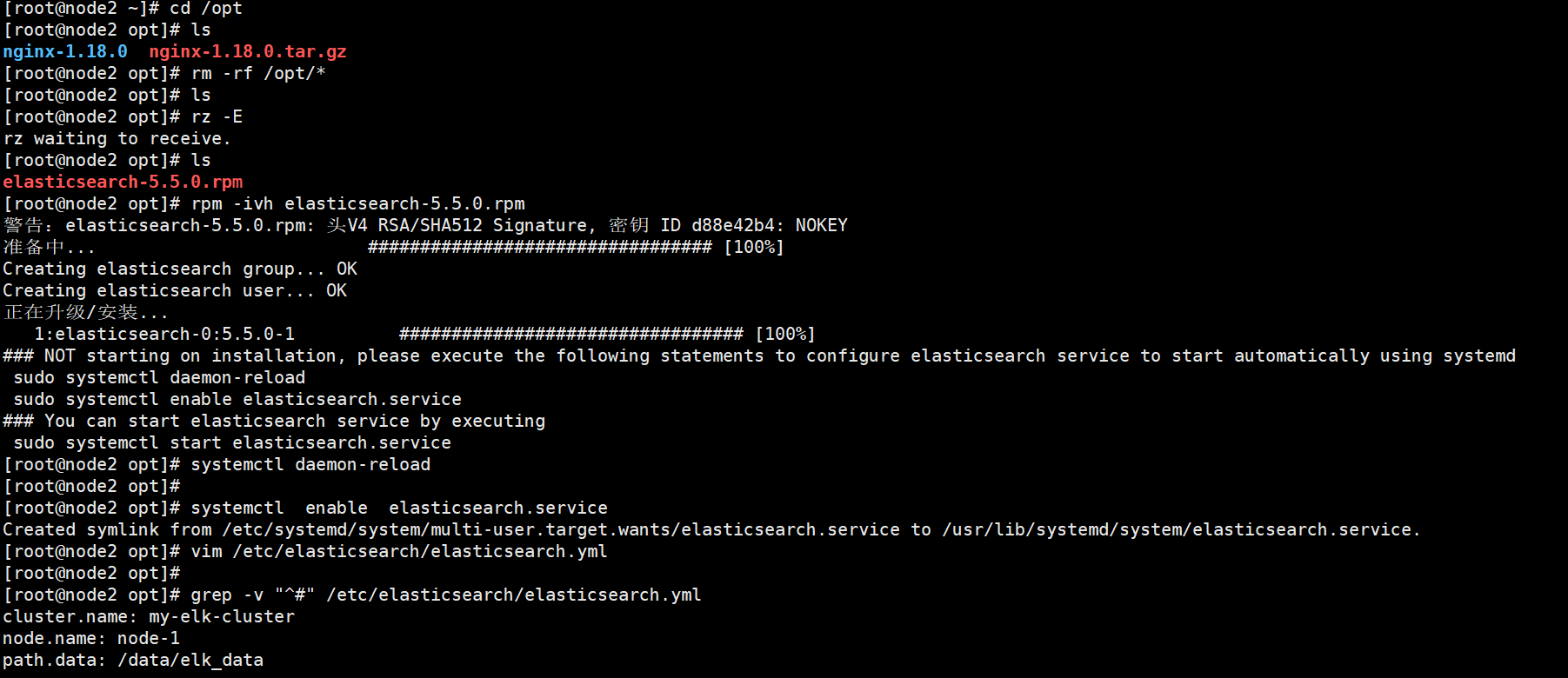

cd /opt

#切换到opt目录下

rpm -ivh elasticsearch-5.5.0.rpm

#安装elasticsearch

systemctl daemon-reload

#重新加载system管理

systemctl enable elasticsearch.service

#设置服务开机自启

vim /etc/elasticsearch/elasticsearch.yml

#修改elasticsearch配置文件

添加内容:

cluster.name: my-elk-cluster

#设置es集群名称

node.name: node2

#设置本机节点名称

path.data: /data/elk_data

#指定数据存放路径

path.logs: /var/log/elasticsearch

#指定日志存放路径

bootstrap.memory_lock: false

#启动时不锁定内存

network.host: "0.0.0.0"

#监听地址所有

http.port: 9200

#监听端口为9200ES的默认端口

discovery.zen.ping.unicast.hosts: ["node1", "node2"]

#集群发现通过单播实现,指定要发现的节点名,保存退出

grep -v "^#" /etc/elasticsearch/elasticsearch.yml

#过滤非#开头的行检查配置是否有问题

mkdir -p /data/elk_data

chown elasticsearch:elasticsearch /data/elk_data

#创建数据存放路径并授权

systemctl start elasticsearch.service

#启动服务

systemctl status elasticsearch.service

#查看服务状态

2.安装logstash

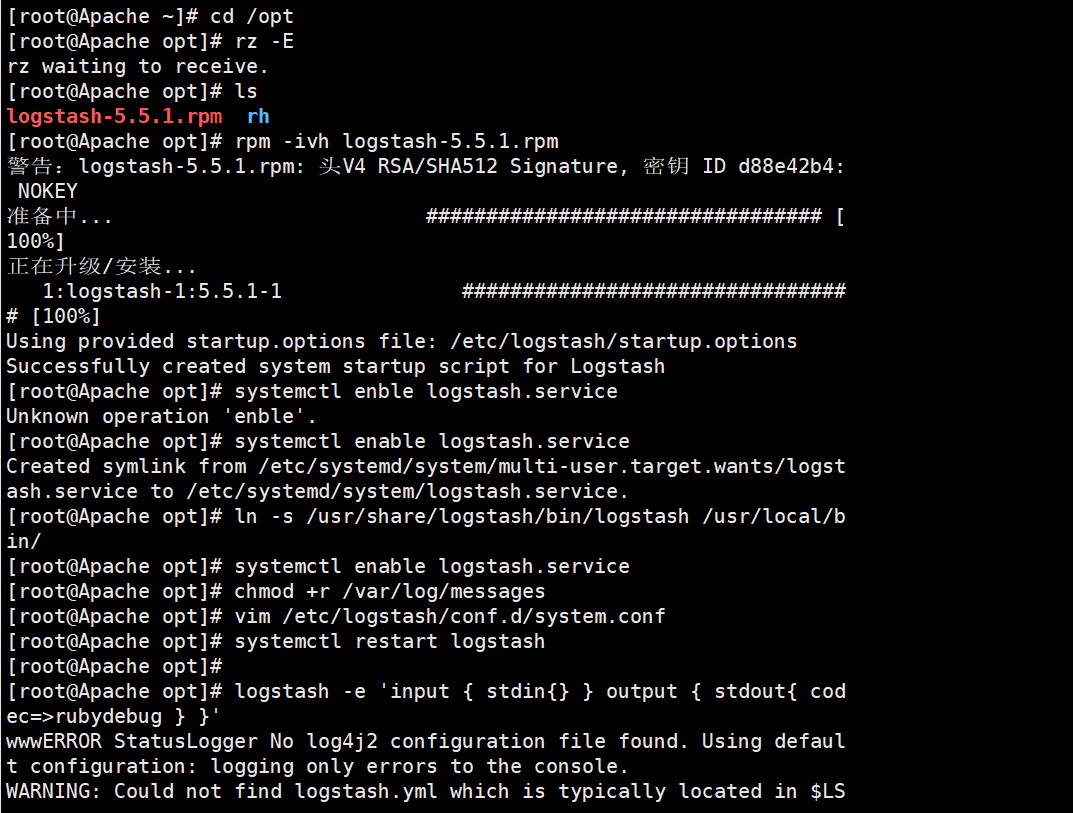

cd /opt

#切换到opt

rpm -ivh logstash-5.5.1.rpm

#安装logstash

systemctl enable logstash.service --now

#设置开机自启logstash并立即启动

ln -s /usr/share/logstash/bin/logstash /usr/local/bin/

#配置logstash命令全局可用

chmod +r /var/log/messages

#设置任何人可读此日志

vim /etc/logstash/conf.d/system.conf

#编辑一个新的logstash子配置文件读取

文件内容:

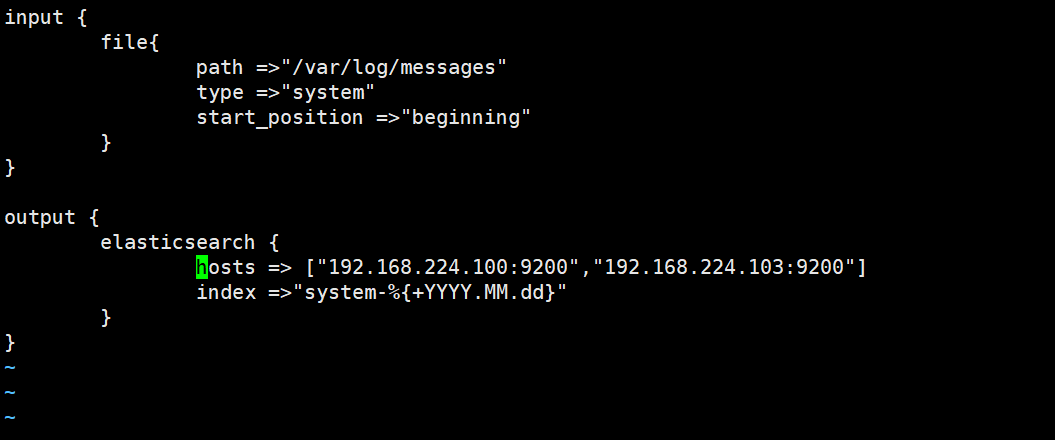

input {

file{

path =>"/var/log/messages" #指定要收集的日志的位置

type =>"system" #自定义日志类型标识

start_position =>"beginning" #表示从开始处收集

}

}

output {

elasticsearch { #输出到 elasticsearch

hosts => ["192.168.224.100:9200","192.168.224.103:9200"] #指定 elasticsearch 服务器的地址和端口

index =>"system-%{+YYYY.MM.dd}" #指定输出到 elasticsearch 的索引格式

}

}

systemctl restart logstash

#开启logstach

739

739

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?