爬虫基础入门

爬虫的分类

网络爬虫按照系统结构和实现技术,大致可分为4类,即通用网络爬虫、聚焦网络爬虫、增量网络爬虫和深层次网络爬虫。

1.通用网络爬虫:搜索引擎的爬虫

比如用户在百度搜索引擎上检索对应关键词时,百度将对关键词进行分析处理,从收录的网页中找出相关的再根据一定的排名规则进行排序后展现给用户,那么就需要尽可能多的互联网的优质网页。

从互联网中搜集网页,采集信息,这些网页信息用于为搜索引擎建立索引从而提供支持,它决定着整个引擎系统的内容是否丰富,信息是否即时,因此其性能的优劣直接影响着搜索引擎的效果。

2.聚焦网络爬虫:针对特定网页的爬虫

也叫主题网络爬虫,爬取的 目标网页定位在与主题相关的页面中 ,主要为某一类特定的人群提供服务,可以节省大量的服务器资源和带宽资源。聚焦爬虫在实施网页抓取时会对内容进行处理筛选,尽量保证只抓取与需求相关的网页信息。

比如要获取某一垂直领域的数据或有明确的检索需求,此时需要过滤掉一些无用的信息。

例如:那些比较价格的网站,就是爬取的其他网站的商品。

3.增量式网络爬虫

增量式网络爬虫(Incremental Web Crawler),所谓增量式,即增量式更新。增量式更新指的是再更新的时候只更新改变的地方,而为改变的地方则不更新,所以该爬虫只爬取内容发生变化的网页或者新产生的网页。

比如:招聘网爬虫

4.深层网络爬虫

深层网络爬虫(Deep Web Crawler),首先,什么是深层页面?

在互联网中,网页按存在方式划分为表层页面和深层页面。所谓表层页面,指的是不需要提交表单,使用静态的链接能够到达的静态页面;而深层页面是需要调教一定的关键词之后才能获取的页面。在互联网中,深层页面数量往往比表层页面多得多。

深层网络爬虫主要由URL列表、LVS【虚拟服务器】列表、爬行控制器、解析器、LVS控制器、表单分析器、表单处理器、响应分析器等构成。

后面我们主要学习聚焦爬虫,聚焦爬虫学会了,其他类型的爬虫也就能轻而易举的写出来

4.通用爬虫与聚焦爬虫的原理

通用爬虫:

第一步:抓取网页(url)

- start_url发送请求,在获取响应解析;

- 从响应解析中获取到了需要的新的url,将这些URL放入待抓取URL队列;

- 取出待抓取URL,解析DNS得到主机的IP,并将URL对应的网页下载下来,存储进已下载网页库中,并且将这些URL放进已抓取URL队列。

- 分析已抓取URL队列中的URL,分析其中的其他URL,并且将URL放入待抓取URL队列,从而进入下一个循环…

第二步:数据存储

搜索引擎通过爬虫爬取到的网页,将数据存入原始页面数据库。其中的页面数据与用户浏览器得到的HTML是完全一样的。

搜索引擎蜘蛛在抓取页面时,也做一定的重复内容检测,一旦遇到访问权重很低的网站上有大量抄袭、采集或者复制的内容,很可能就不再爬行。

第三步:预处理

搜索引擎将爬虫抓取回来的页面,进行各种步骤的预处理。

- 提取文字

- 中文分词

- 消除噪音(比如版权声明文字、导航条、广告等……)

- 索引处理

- 链接关系计算

- 特殊文件处理

- …

除了HTML文件外,搜索引擎通常还能抓取和索引以文字为基础的多种文件类型,如 PDF、Word、WPS、XLS、PPT、TXT 文件等。我们在搜索结果中也经常会看到这些文件类型。

但搜索引擎还不能处理图片、视频、Flash 这类非文字内容,也不能执行脚本和程序。

第四步:提供检索服务,网站排名

搜索引擎在对信息进行组织和处理后,为用户提供关键字检索服务,将用户检索相关的信息展示给用户。

聚焦爬虫:

第一步:start_url 发送请求

第二步:获取响应(response)

第三步:解析响应,若响应中有需要的新的url地址,重复第二步;

第四步:提取数据

第五步:保存数据

通常,我们会把获取响应,解析放在一个步骤中完成,所以说,聚焦爬虫的步骤,通俗的来讲一共四步

1.Http与Https

HTTP协议(HyperText Transfer Protocol,超文本传输协议):是一种发布和接收 HTML页面的方法。

HTTPS(Hypertext Transfer Protocol over Secure Socket Layer)简单讲是HTTP的安全版,在HTTP下加入SSL层。

SSL(Secure Sockets Layer 安全套接层)主要用于Web的安全传输协议,在传输层对网络连接进行加密,保障在Internet上数据传输的安全。

HTTP的端口号为80,HTTPS的端口号为443

HTTP通信由两部分组成: 客户端请求消息 与 服务器响应消息

浏览器发送HTTP请求的过程

-

当用户在浏览器的地址栏中输入一个URL并按回车键之后,浏览器会向HTTP服务器发送HTTP请求。HTTP请求主要分为“Get”和“Post”两种方法。

统一资源定位符:URL(Uniform / Universal Resource Locator的缩写)是用于完整地描述Internet上网页和其他资源的地址的一种标识方法。

-

当我们在浏览器输入URL http://www.baidu.com 的时候,浏览器发送一个Request请求去获取 http://www.baidu.com 的html文件,服务器把Response文件对象发送回给浏览器。

-

浏览器分析Response中的 HTML,发现其中引用了很多其他文件,比如Images文件,CSS文件,JS文件。 浏览器会自动再次发送Request去获取图片,CSS文件,或者JS文件。

-

当所有的文件都下载成功后,网页会根据HTML语法结构,完整的显示出来了。

基本格式:scheme://host[:port#]/path/…/[?query-string][#anchor]

协议://主机:[端口号]/路径/?[请求or查询参数]…/[#锚点]

- scheme:协议(例如:http, https, ftp)

- host:服务器的IP地址或者域名

- port#:服务器的端口(如果是走协议默认端口,缺省端口80)

- path:访问资源的路径

- query-string:参数,发送给http服务器的数据

- anchor:锚(用于页面 内跳转)

例如:

- ftp://192.168.0.116:8080/index

- http://www.baidu.com

- http://item.jd.com/11936238.html#product-detail

HTTP请求主要分为Get和Post两种方法

- GET是从服务器上获取数据,POST是向服务器传送数据

- GET请求参数显示,都显示在浏览器网址上,HTTP服务器根据该请求所包含URL中的参数来产生响应内容,即“Get”请求的参数是URL的一部分。 例如:

http://www.baidu.com/s?wd=Chinese - POST请求参数在请求体当中,消息长度没有限制而且以隐式的方式进行发送,通常用来向HTTP服务器提交量比较大的数据(比如请求中包含许多参数或者文件上传操作等),请求的参数包含在“Content-Type”消息头里,指明该消息体的媒体类型和编码,

注意:避免使用Get方式提交表单,因为有可能会导致安全问题。 比如说在登陆表单中用Get方式,用户输入的用户名和密码将在地址栏中暴露无遗。

当然,让我帮你进行一些调整以提高笔记的可读性和美观程度:

常用的请求报头

1. Host (主机和端口号)

-

Host:对应网址URL中的Web名称和端口号,用于指定被请求资源的Internet主机和端口号,通常属于URL的一部分。

2. Connection (链接类型)

- Connection:表示客户端与服务连接类型

- Client 发起一个包含

Connection:keep-alive的请求,HTTP/1.1使用keep-alive为默认值。 - Server收到请求后:

- 如果 Server 支持 keep-alive,回复一个包含 Connection:keep-alive 的响应,不关闭连接;

- 如果 Server 不支持 keep-alive,回复一个包含 Connection:close 的响应,关闭连接。

- 如果client收到包含

Connection:keep-alive的响应,向同一个连接发送下一个请求,直到一方主动关闭连接。 - keep-alive在很多情况下能够重用连接,减少资源消耗,缩短响应时间,比如当浏览器需要多个文件时(比如一个HTML文件和相关的图形文件),不需要每次都去请求建立连接。

- Client 发起一个包含

3. Upgrade-Insecure-Requests (升级为HTTPS请求)

- Upgrade-Insecure-Requests:升级不安全的请求,意思是会在加载 http 资源时自动替换成 https 请求,让浏览器不再显示https页面中的http请求警报。

- HTTPS 是以安全为目标的 HTTP 通道,所以在 HTTPS 承载的页面上不允许出现 HTTP 请求,一旦出现就是提示或报错。

4. User-Agent (浏览器名称)

- User-Agent:是客户浏览器的名称,通过这个名称网站才能了解到你使用的是什么设备,如果是非法设备会判断403

5. Accept (传输文件类型)

- Accept:指浏览器或其他客户端可以接受的MIME(Multipurpose Internet Mail Extensions(多用途互联网邮件扩展))文件类型,服务器可以根据它判断并返回适当的文件格式。

- 举例:

Accept: */*:表示什么都可以接收。Accept:image/gif:表明客户端希望接受GIF图像格式的资源;Accept:text/html:表明客户端希望接受html文本。Accept: text/html, application/xhtml+xml;q=0.9, image/*;q=0.8:表示浏览器支持的 MIME 类型分别是 html文本、xhtml和xml文档、所有的图像格式资源。- q是权重系数,范围 0 =< q <= 1,q 值越大,请求越倾向于获得其“;”之前的类型表示的内容。若没有指定q值,则默认为1,按从左到右排序顺序;若被赋值为0,则用于表示浏览器不接受此内容类型。

- 举例:

6. Referer (页面跳转处)

- Referer:表明产生请求的网页来自于哪个URL,用户是从该 Referer页面访问到当前请求的页面。这个属性可以用来跟踪Web请求来自哪个页面,是从什么网站来的等。

- 有时候遇到下载某网站图片,需要对应的referer,否则无法下载图片,那是因为人家做了防盗链,原理就是根据referer去判断是否是本网站的地址,如果不是,则拒绝,如果是,就可以下载;

7. Accept-Encoding(文件编解码格式)

- Accept-Encoding:指出浏览器可以接受的编码方式。编码方式不同于文件格式,它是为了压缩文件并加速文件传递速度。浏览器在接收到Web响应之后先解码,然后再检查文件格式,许多情形下这可以减少大量的下载时间。

- 如果请求消息中没有设置这个域服务器假定客户端对各种内容编码都可以接受。

- *举例:Accept-Encoding:gzip;q=1.0, identity; q=0.5, ;q=0

8. Accept-Language(语言种类)

- Accept-Langeuage:指出浏览器可以接受的语言种类,如en或en-us指英语,zh或者zh-cn指中文,当服务器能够提供一种以上的语言版本时要用到。

9. Accept-Charset(字符编码)

- Accept-Charset:指出浏览器可以接受的字符编码。

- 举例:Accept-Charset:iso-8859-1,gb2312,utf-8

- ISO8859-1:通常叫做Latin-1。Latin-1包括了书写所有西方欧洲语言不可缺少的附加字符,英文浏览器的默认值是ISO-8859-1.

- gb2312:标准简体中文字符集;

- utf-8:UNICODE 的一种变长字符编码,可以解决多种语言文本显示问题,从而实现应用国际化和本地化。

- 如果在请求消息中没有设置这个域,缺省是任何字符集都可以接受。

- 举例:Accept-Charset:iso-8859-1,gb2312,utf-8

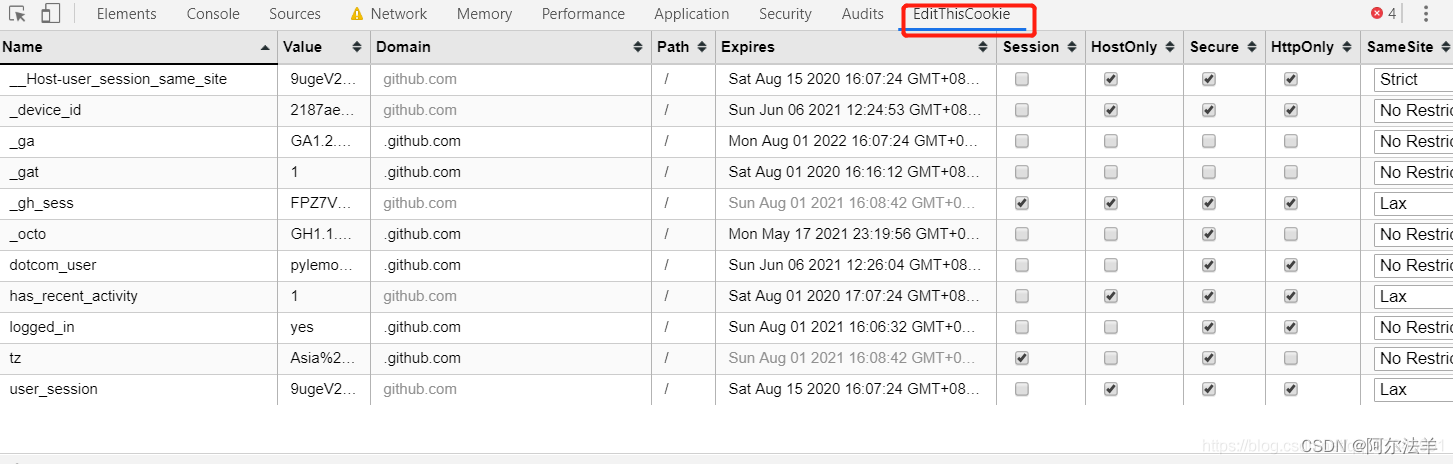

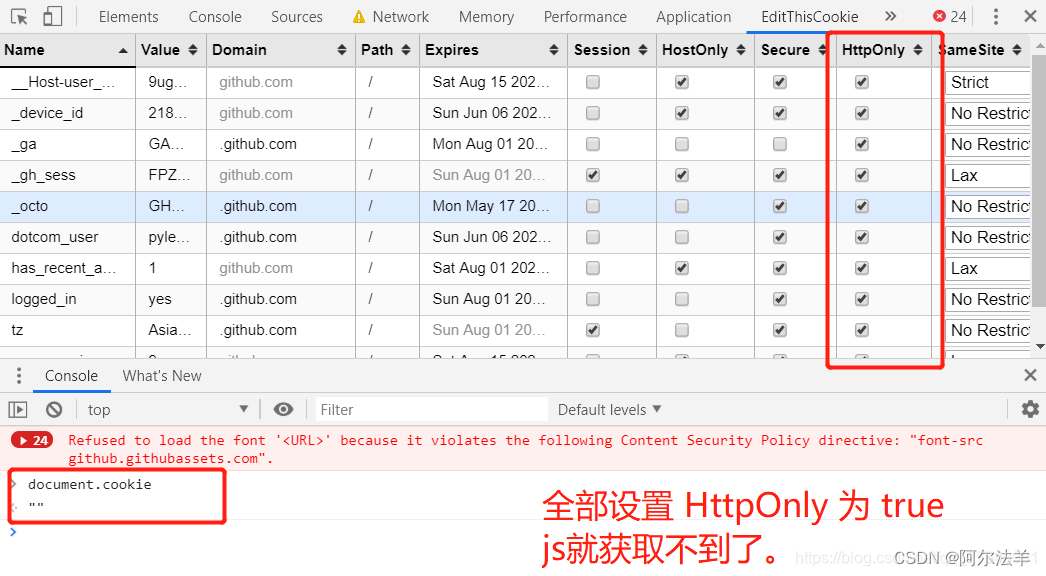

10. Cookie (Cookie)

- Cookie:浏览器用这个属性向服务器发送Cookie。Cookie是在浏览器中寄存的小型数据体,它可以记载和服务器相关的用户信息,也可以用来实现会话功能

11. Content-Type (POST数据类型)

-

Content-Type:POST请求里用来表示的内容类型。

服务端HTTP响应

HTTP响应也由四个部分组成,分别是: 状态行、消息报头、空行、响应正文

HTTP/1.1 200 OK

Server: Tengine

Connection: keep-alive

Date: Wed, 30 Nov 2016 07:58:21 GMT

Cache-Control: no-cache

Content-Type: text/html;charset=UTF-8

Keep-Alive: timeout=20

Vary: Accept-Encoding

Pragma: no-cache

X-NWS-LOG-UUID: bd27210a-24e5-4740-8f6c-25dbafa9c395

Content-Length: 180945

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" ....

理论上所有的响应头信息都应该是回应请求头的。但是服务端为了效率,安全,还有其他方面的考虑,会添加相对应的响应头信息,从上图可以看到:

1. Cache-Control:must-revalidate, no-cache, private。

这个值告诉客户端,服务端不希望客户端缓存资源,在下次请求资源时,必须要从新请求服务器,不能从缓存副本中获取资源。

- Cache-Control是响应头中很重要的信息,当客户端请求头中包含Cache-Control:max-age=0请求,明确表示不会缓存服务器资源时,Cache-Control作为作为回应信息,通常会返回no-cache,意思就是说,“那就不缓存呗”。

- 当客户端在请求头中没有包含Cache-Control时,服务端往往会定,不同的资源不同的缓存策略,比如说oschina在缓存图片资源的策略就是Cache-Control:max-age=86400,这个意思是,从当前时间开始,在86400秒的时间内,客户端可以直接从缓存副本中读取资源,而不需要向服务器请求。

2. Connection:keep-alive

这个字段作为回应客户端的Connection:keep-alive,告诉客户端服务器的tcp连接也是一个长连接,客户端可以继续使用这个tcp连接发送http请求。

3. Content-Encoding:gzip

告诉客户端,服务端发送的资源是采用gzip编码的,客户端看到这个信息后,应该采用gzip对资源进行解码。

4. Content-Type:text/html;charset=UTF-8

告诉客户端,资源文件的类型,还有字符编码,客户端通过utf-8对资源进行解码,然后对资源进行html解析。通常我们会看到有些网站是乱码的,往往就是服务器端没有返回正确的编码。

5. Date:Sun, 21 Sep 2016 06:18:21 GMT

这个是服务端发送资源时的服务器时间,GMT是格林尼治所在地的标准时间。http协议中发送的时间都是GMT的,这主要是解决在互联网上,不同时区在相互请求资源的时候,时间混乱问题。

6. Expires:Sun, 1 Jan 2000 01:00:00 GMT

这个响应头也是跟缓存有关的,告诉客户端在这个时间前,可以直接访问缓存副本,很显然这个值会存在问题,因为客户端和服务器的时间不一定会都是相同的,如果时间不同就会导致问题。所以这个响应头是没有Cache-Control:max-age=*这个响应头准确的,因为max-age=date中的date是个相对时间,不仅更好理解,也更准确。

7. Pragma:no-cache

这个含义与Cache-Control等同。

8.Server:Tengine/1.4.6

这个是服务器和相对应的版本,只是告诉客户端服务器的信息。

9. Transfer-Encoding:chunked

这个响应头告诉客户端,服务器发送的资源的方式是分块发送的。一般分块发送的资源都是服务器动态生成的,在发送时还不知道发送资源的大小,所以采用分块发送,每一块都是独立的,独立的块都能标示自己的长度,最后一块是0长度的,当客户端读到这个0长度的块时,就可以确定资源已经传输完了。

10. Vary: Accept-Encoding

告诉缓存服务器,缓存压缩文件和非压缩文件两个版本,现在这个字段用处并不大,因为现在的浏览器都是支持压缩的。

Cookie 和 Session

服务器和客户端的交互仅限于请求/响应过程,结束之后便断开,在下一次请求时,服务器会认为新的客户端。

为了维护他们之间的链接,让服务器知道这是前一个用户发送的请求,必须在一个地方保存客户端的信息。

Cookie:通过在 客户端 记录的信息确定用户的身份。

Session:通过在 服务器端 记录的信息确定用户的身份。

响应状态码

响应状态代码有三位数字组成,第一个数字定义了响应的类别,且有五种可能取值。

常见状态码:

100~199:表示服务器成功接收部分请求,要求客户端继续提交其余请求才能完成整个处理过程。200~299:表示服务器成功接收请求并已完成整个处理过程。常用200(OK 请求成功)。300~399:为完成请求,客户需进一步细化请求。例如:请求的资源已经移动一个新地址、常用302(所请求的页面已经临时转移至新的url)、307和304(使用缓存资源)。400~499:客户端的请求有错误,常用404(服务器无法找到被请求的页面)、403(服务器拒绝访问,权限不够)。500~599:服务器端出现错误,常用500(请求未完成。服务器遇到不可预知的情况)。

网页的两种加载方法

- 同步加载:改变网址上的某些请求参数会导致网页发生改变,例如:www.itjuzi.com/company?page=1(改变page=后面的数字,网页会发生改变)

- 异步加载:改变网址上的请求参数不会使网页发生改变,例如:www.lagou.com/gongsi/(翻页后网址不会发生变化)

认识网页源码的构成

在网页中右键点击查看网页源码,可以查看到网页的源代码信息。

源代码一般由三个部分组成,分别是:

- html:描述网页的内容结构

- css:描述网页的排版布局(高深的反爬,css)

- JavaScript(js文件):描述网页的事件处理,即鼠标或键盘在网页元素上的动作后的程序

爬虫协议(了解)

robots协议:网站通过robots协议,告诉我们搜索引擎哪些页面可以抓取,哪些页面不能抓取,但它仅仅是道德层面上的约束。

2.Request模块

Requests的简单了解

虽然Python的标准库中 urllib 模块已经包含了平常我们使用的大多数功能,但是它的 API 使用起来让人感觉不太好,而 Requests 自称 “HTTP for Humans”,说明使用更简洁方便。

Requests 唯一的一个非转基因的 Python HTTP 库,人类可以安全享用:)

Requests 继承了urllib的所有特性。Requests支持HTTP连接保持和连接池,支持使用cookie保持会话,支持文件上传,支持自动确定响应内容的编码,支持国际化的 URL 和 POST 数据自动编码。

requests 的底层实现其实就是 urllib

Requests的文档非常完备,中文文档也相当不错。Requests能完全满足当前网络的需求,支持Python 2.6–3.5,而且能在PyPy下完美运行。

开源地址:https://github.com/kennethreitz/requests

中文文档 API: http://docs.python-requests.org/zh_CN/latest/index.html

为什么重点学习requests模块,而不是urllib

-

requests的底层实现就是urllib

-

requests在python2和python3中通用,方法完全一样

-

requests简单易用

-

requests能够自动帮助我们解压(gzip压缩的等)网页内容

基本GET请求

1.最基本的get请求

response = requests.get("http://www.baidu.com/")

# 也可以这么写

url="http://www.baidu.com/"

response = requests.get(url)

2.headers头部和params参数

如果想添加 headers,可以传入headers参数来增加请求头中的headers信息。如果要将参数放在url中传递,可以利用 params 参数。

import requests

parmas = {'wd':'长城'}

headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/54.0.2840.99 Safari/537.36"}

# params 接收一个字典或者字符串的查询参数,字典类型自动转换为url编码,不需要urlencode()

response = requests.get("http://www.baidu.com/s?", params = parmas, headers = headers)

# 查看响应内容,response.text 返回的是Unicode格式的数据

print (response.text) # <html><head>...

# 查看响应内容,response.content返回的字节流数据

print (response.content) # b'\xe9\x95\xbf\xe5\x9f\x8e'

# 查看完整url地址

print (response.url) # http://www.baidu.com/s?wd=%E9%95%BF%E5%9F%8E

# 查看响应头部字符编码

print (response.encoding) # utf-8

# 查看响应码

print (response.status_code) # 200

基本POST请求(DATA参数)

- 最基本post方法

response = requests.post("http://www.baidu.com/", data = data)

- 传入data数据

对于 POST 请求来说,我们一般需要为它增加一些参数。那么最基本的传参方法可以利用 data 这个参数。

import requests

formdata = {

"type":"AUTO",

"i":"i love python",

"doctype":"json",

"xmlVersion":"1.8",

"keyfrom":"fanyi.web",

"ue":"UTF-8",

"action":"FY_BY_ENTER",

"typoResult":"true"

}

url = "http://fanyi.youdao.com/translate?smartresult=dict&smartresult=rule&smartresult=ugc&sessionFrom=null"

headers={ "User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/51.0.2704.103 Safari/537.36"}

response = requests.post(url, data = formdata, headers = headers)

print (response.text)

# **【如果是json文件可以直接显示】**

print (response.json())

代理(proxies) 参数

如果需要使用代理,你可以通过为任意请求方法提供 proxies 参数来配置单个请求:

import requests

# **【根据协议类型,选择不同的代理】**

proxies = {

"http": "http://12.34.56.79:9527",

"https": "http://12.34.56.79:9527",

}

response = requests.get("http://www.baidu.com", proxies = proxies)

print response.text

也可以通过本地环境变量 HTTP_PROXY 和 HTTPS_PROXY 来配置代理:

export HTTP_PROXY="http://12.34.56.79:9527"

export HTTPS_PROXY="https://12.34.56.79:9527"

私密代理验证 和 Web客户端验证

私密代理

import requests

# **【如果代理需要使用HTTP Basic Auth,可以使用下面这种格式:】**

proxy = { "http": "mr_mao_hacker:sffqry9r@61.158.163.130:16816" }

response = requests.get("http://www.baidu.com", proxies = proxy)

print (response.text)

web客户端验证

如果是Web客户端验证,需要添加 auth = (账户名, 密码)

import requests

auth=('test', '123456')

response = requests.get('http://192.168.199.107', auth = auth)

print (response.text)

Cookies 和 Sission

【1.1 cookie和session的区别】

cookie数据存放在客户的浏览器上,session数据放在服务器上

cookie不是很安全,别人可以分析存放在本地的cookie并进行cookie欺骗

session会在一定时间内保存在服务器上,当访问增多,会比较占用你服务器的性能

单个cookie保存的数据不能超过4k,很多浏览器都限制一个站点最多保存20个cookie

【1.2 爬虫中问什么要使用cookie】

带上cookie的好处:

【能够访问登录后的页面】

【正常的浏览器在请求服务器的时候会带上cookie(第一次请求除外),所以对方服务器有可能会通过是否携带cookie来判断我们是否是一个爬虫,对应的能起到一定的反爬效果】

带上cookie的坏处:

【一套cookie往往对应的是一个用户的信息,请求太频繁有更大可能性被对方识别为爬虫】

【那么,面对这种情况如何解决----使用多个账号】

【1.3 requests处理cookie相关的请求之session】

requests提供了一个叫做session类,来实现客户端和服务端的会话保持

会话保持有两个内涵:

【保存cookie】

【实现和服务器的长连接】

Cookies

如果一个响应中包含了cookie,那么我们可以利用 cookies参数拿到:

import requests

response = requests.get("http://www.baidu.com/")

# **【返回CookieJar对象:】**

cookiejar = response.cookies

# **【将CookieJar转为字典:】**

cookiedict = requests.utils.dict_from_cookiejar(cookiejar)

print (cookiejar)

print (cookiedict)

运行结果:

<RequestsCookieJar[<Cookie BDORZ=27315 for .baidu.com/>]>

{'BDORZ': '27315'}

session

在 requests 里,session对象是一个非常常用的对象,这个对象代表一次用户会话:从客户端浏览器连接服务器开始,到客户端浏览器与服务器断开。

会话能让我们在跨请求时候保持某些参数,比如在同一个 Session 实例发出的所有请求之间保持 cookie 。

实现人人网登录

import requests

# **【创建session对象,可以保存Cookie值】**

ssion = requests.session()

# **【处理 headers】**

headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/54.0.2840.99 Safari/537.36"}

# **【需要登录的用户名和密码】**

data = {"email":"mr_mao_hacker@163.com", "password":"alarmchime"}

# **【发送附带用户名和密码的请求,并获取登录后的Cookie值,保存在ssion里】**

ssion.post("http://www.renren.com/PLogin.do", data = data)

# **【ssion包含用户登录后的Cookie值,可以直接访问那些登录后才可以访问的页面】**

response = ssion.get("http://www.renren.com/410043129/profile")

# **【打印响应内容】**

print (response.text)

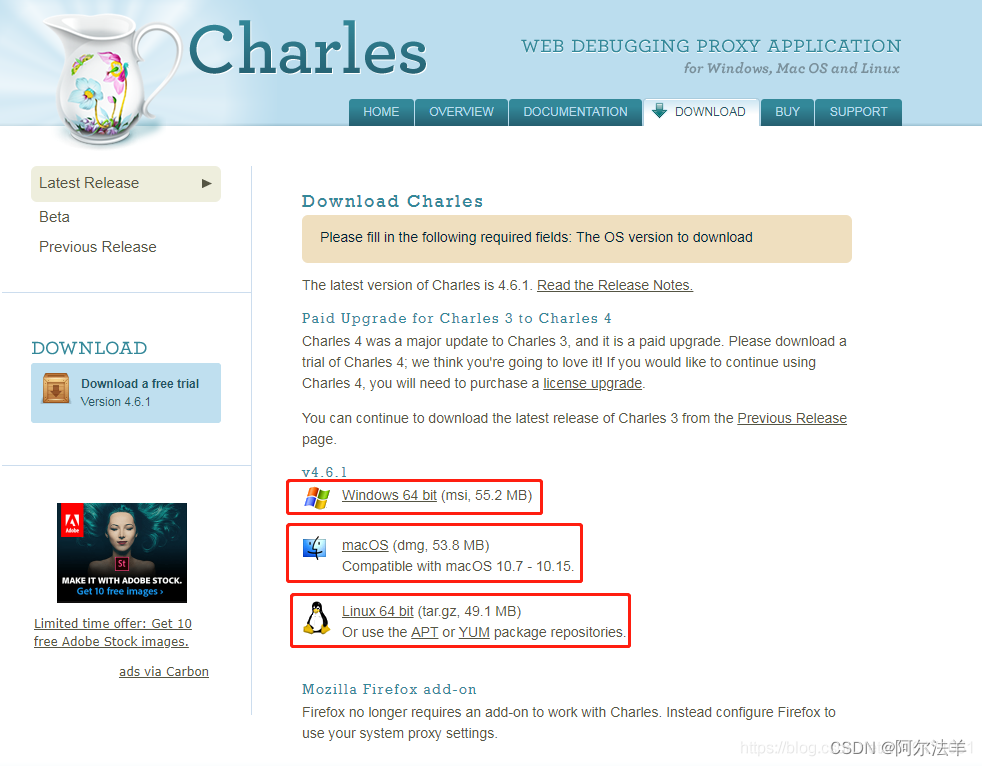

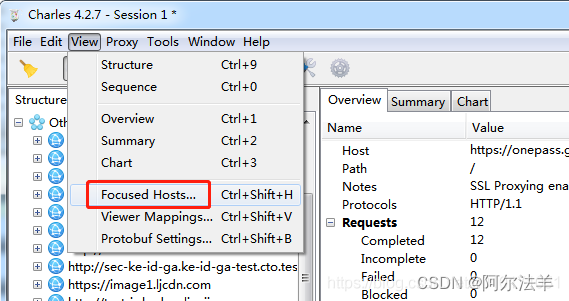

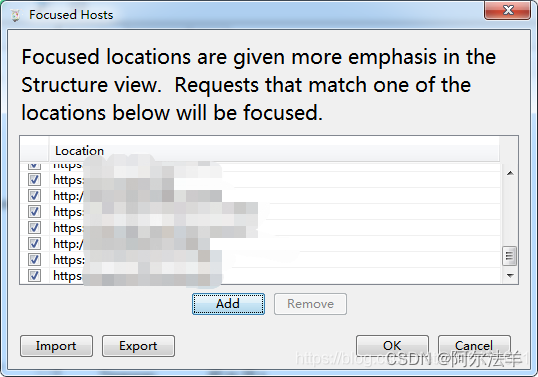

3.chrome抓包

目标:掌握chrome在爬虫中的使用

1. 新建隐身窗口(无痕窗口)

作用:在打开无痕窗口的时候,第一次请求某个网站是没有携带cookie的,和代码请求一个网站一样,这样就能够尽可能理解代码请求某个网站的结果,除非数据是通过js加密加载出来的,不然爬虫请求到的数据和浏览器请求到的数据大部分时候是相同的

2. chrome中network的更多功能

2.1 Perserve log

默认情况下,页面发生跳转之后,之前的请求url地址信息都会消失,勾选perserve log后,之前的请求都会被保留

2.2 filter过滤

在url地址很多的时候,可以在filter中输入部分url地址,对所有的url地址起到一定的过滤效果,具体位置在上面的图中2号位置

2.3 观察特定种类的请求

图中有很多选项,默认是选择all,即会观察到所有种类的请求,很多时候处于自己的目的的可以选择all右边的其他选项,比如常见的选项:

XHR:大部分情况表示ajax请求

JS:js请求

CSS:css请求

但是很多时候我们并不能保证我们需要的请求是什么类型,特别是我们不清楚一个请求是否为ajax请求的时候,直接选择all,从前往后观察即可,其中js,css,图片等不去观察即可

不要被浏览器中的一堆请求吓到了,这些请求中除了js,css,图片请求外,请他的请求并没有多少个

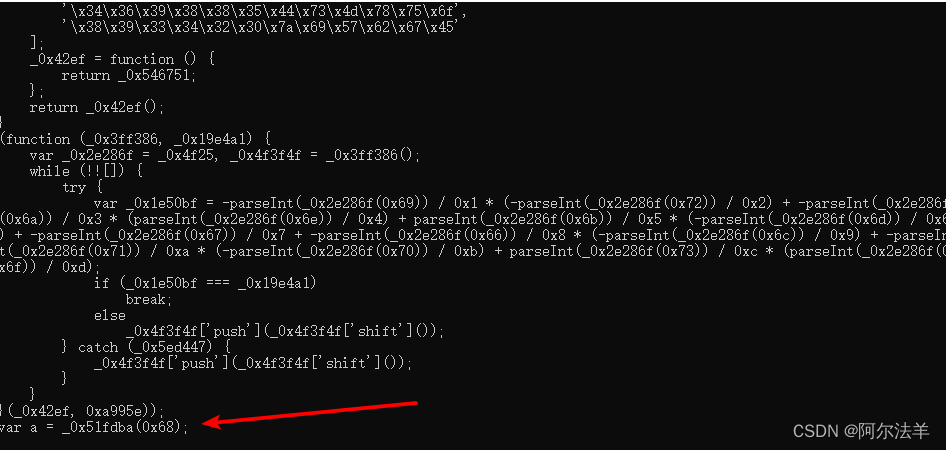

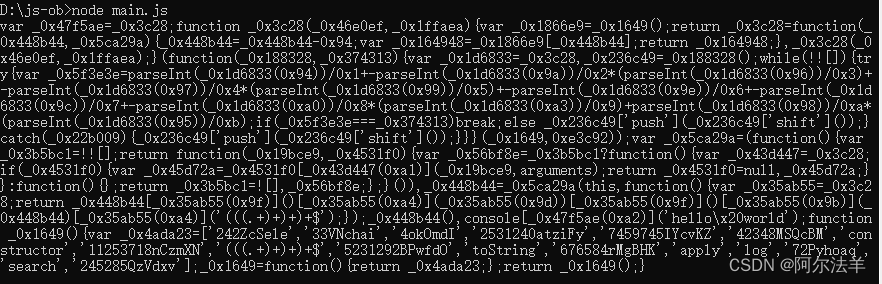

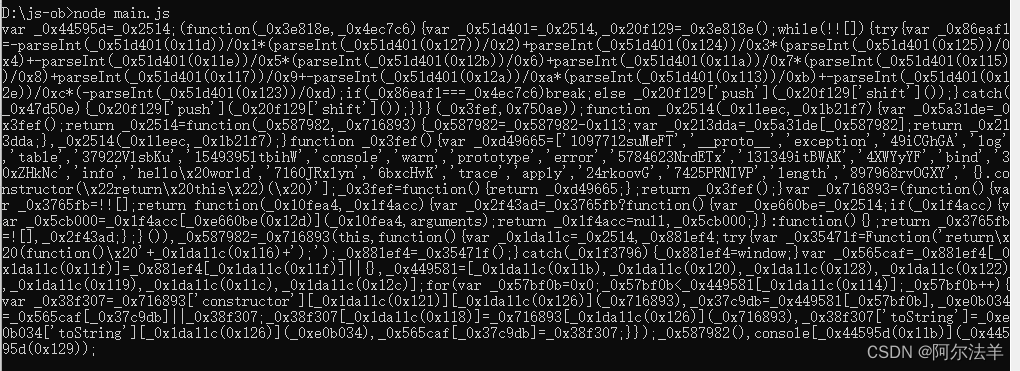

2.4 其他方法

search all file

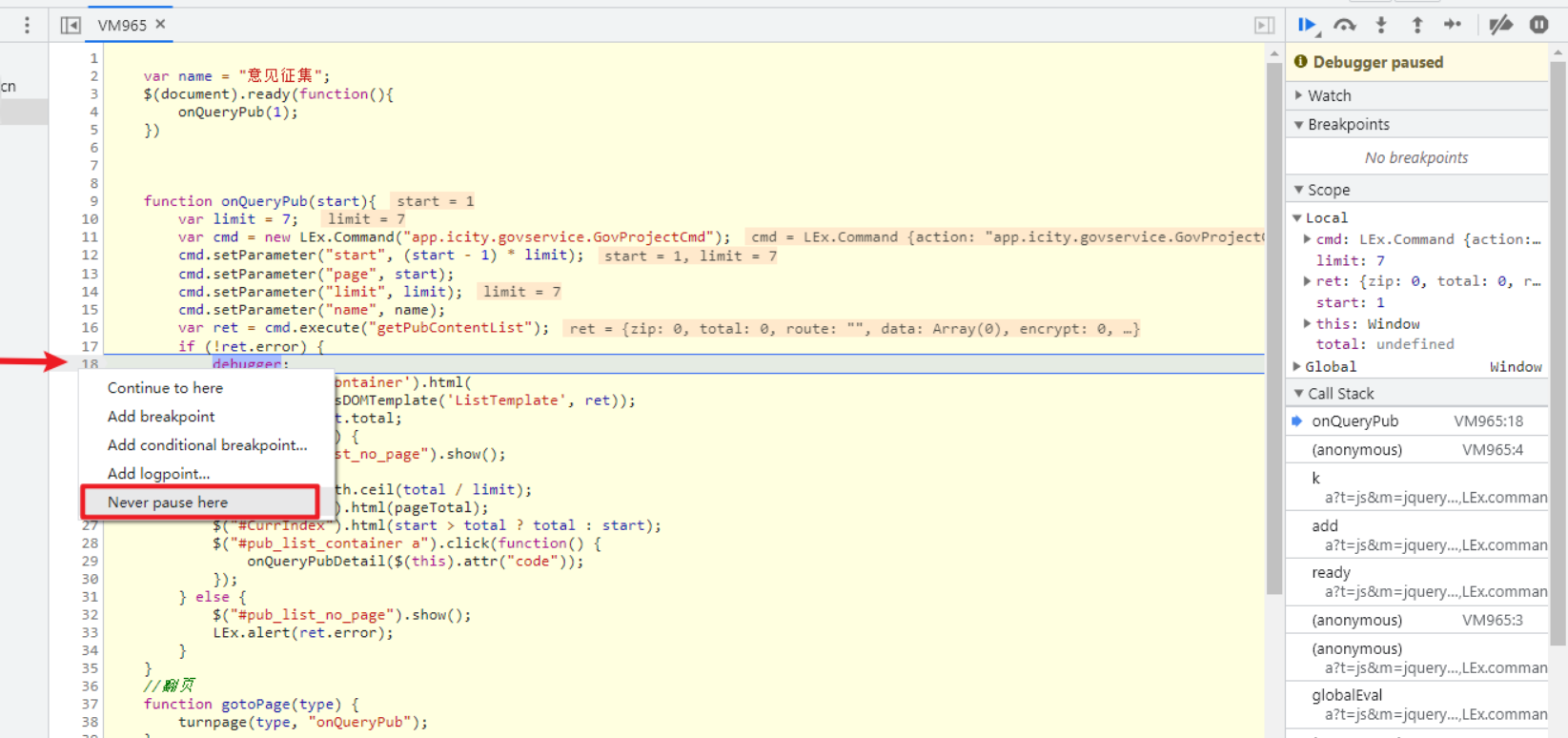

确定js文件位置

js中添加断点

3. 抓包分析说明

通常,我们所抓的第一个包,就是我们访问这个url地址的响应,在点击所抓的第一个包,右边的headers里面包含了,请求所携带的请求头,响应头等等信息,爬虫在遇到反爬的时候,可以通过查看判断分析,加入缺少的请求信息即可

response里面放入的是请求这个url地址的响应,通常是请求url地址的源码或者json数据

4. 寻找登录接口

4.1 寻找action对的url地址

回顾之前人人网的爬虫我们找到了一个登陆接口,那么这个接口从哪里找到的呢?

可以发现,这个地址就是在登录的form表单中action对应的url地址,回顾前端的知识点,可以发现就是进行表单提交的地址,对应的,提交的数据,仅仅需要:用户名的input标签中,name的值作为键,用户名作为值,密码的input标签中,name的值作为键,密码作为值即可

思考:

如果action对应的没有url地址的时候可以怎么做?

4.2 通过抓包寻找登录的url地址

通过抓包可以发现,在这个url地址和请求体中均有参数,比如uniqueTimestamp和rkey以及加密之后的password

这个时候我们可以观察手机版的登录接口,是否也是一样的

可以发现在手机版中,依然有参数,但是参数的个数少一些,这个时候,我们可以使用手机版作为参看,来学习如何分析js

4.数据解析

正则表达式

正则表达式几十个符号,看似很复杂,但如果能否分清楚类别和作用,就没那么复杂了。

-

字符类别表达 - 表达某一类字符,比如数字,字母,1到9之间的任何数字等(我是大脑瘫记忆法)

正则 匹配 \w 一个字母数字下划线 \s 一个空格 \d 一个数字 \n 一个换行符 \t 一个制表符 \W 不取数字字母下划线 \S 不取空格 \D 不取数字 [abcf] 取abcf中的任意一个字符 [a-f] 上面的简写形式 [^a-f] 不取这其中的字符 . 通配符:除了换行\n之外的任意字符

- 字符的重复次数,也叫做量词。比如身份证是数字重复15或18次,也就是:\d{15}或者\d{18}。

| 正则 | 匹配 |

|---|---|

| * | 0个或者多个 |

| + | 1个或者多个 |

| ? | 0个或者1个 |

| {2} | 2个 |

| {2,5} | 2到5个 |

| {2,} | 至少两个,无上限 |

| {,5} | 最多五个 |

- 组合模式:把多个简单的模式组合在一起,可以是拼接,也可以是二者选其一。

| 正则 | 匹配 |

|---|---|

| \d{6}[a-z]{6} | 表示六个数字后面跟着六个小写英文字母 |

| \d{3}|[a-z]{4} | 表示三个数字或者四个小写字母都可以 |

| (abc){3} | 分组:表示abc abc abc为一组,一共会分出来三组 |

Python正则模块re的用法

re模块是 Python 中用于处理正则表达式的标准库之一。它提供了一系列函数用于对字符串进行模式匹配和搜索,以及对字符串进行替换和分割。

| 方法 | 简介 |

|---|---|

| re.compile | 编译正则表达式 |

| re.search | 搜索匹配模式 |

| re.match | 开头匹配模式 |

| re.findall | 查找所有匹配项 |

| re.finditer | 迭代查找匹配项 |

| re.sub | 替换匹配部分 |

| re.split | 分割字符串 |

| re.fullmatch | 完全匹配字符串 |

详细介绍

re.compile(pattern, flags=0): 编译正则表达式模式,返回一个正则表达式对象。re.match(pattern, string, flags=0): 从字符串的开头开始匹配给定的模式。如果字符串的开头与模式匹配,则返回一个匹配对象;否则返回 None。这意味着match只会在字符串的开头进行匹配。re.search(pattern, string, flags=0): 在字符串中搜索匹配给定的模式。如果字符串中任意位置有匹配项,则返回第一个匹配对象;否则返回 None。search会搜索整个字符串,找到第一个匹配项即返回。re.findall(pattern, string, flags=0): 在字符串中查找所有匹配给定的模式的项,并以列表形式返回所有匹配项。不同于search和match,findall不返回匹配对象,而是返回匹配的字符串列表。re.finditer(pattern, string, flags=0): 在字符串中查找所有匹配的模式,返回一个包含所有匹配项的迭代器。re.sub(pattern, repl, string, count=0, flags=0): 在字符串中搜索给定的模式,并将匹配的部分替换为指定的字符串。re.split(pattern, string, maxsplit=0, flags=0): 根据给定的模式将字符串分割成列表。re.fullmatch(pattern, string, flags=0): 尝试匹配整个字符串,如果字符串与模式完全匹配,则返回一个匹配对象,否则返回 None。

因此,match 主要用于检查字符串的开头是否匹配模式,search 用于在字符串中查找任意位置的匹配项,而 findall 则用于查找字符串中所有的匹配项。

flag能给定的参数:

re.IGNORECASE(或re.I):忽略大小写匹配。re.MULTILINE(或re.M):多行匹配,影响^和$的行为。re.DOTALL(或re.S):使.匹配任何字符,包括换行符。re.VERBOSE(或re.X):忽略空白和注释,使正则表达式更易读。re.ASCII(或re.A):使\w,\W,\b,\B,\d,\D,\s,\S只匹配 ASCII 字符。re.UNICODE(或re.U):使\w,\W,\b,\B,\d,\D,\s,\S匹配 Unicode 字符。re.LOCALE(或re.L):使\w,\W,\b,\B取决于当前区域设置。

注意:贪婪模式和惰性模式

1.贪婪模式:在整个表达式匹配成功的前提下,尽可能多的匹配(.*)

2.惰性模式:在整个表达式匹配成功的前提下,尽可能少的匹配(.*?)

3.python里数词默认是贪婪的

- 使用贪婪的数量词的正则表达式:

<div>.*</div> - 匹配结果:

<div>test1</div>bb<div>test2</div>

这里采用的是贪婪模式。在匹配到第一个"

</div>“时已经可以使整个表达式匹配成功,但是由于采用的是贪婪模式,所以仍然要向右尝试匹配,查看是否还有更长的可以成功匹配的子串。匹配到第二个”</div>“后,向右再没有可以成功匹配的子串,匹配结束,匹配结果为”<div>test1</div>bb<div>test2</div>"

- 使用非贪婪的数量词的正则表达式:

<div>.*?</div> - 匹配结果:

<div>test1</div>

正则表达式二采用的是非贪婪模式,在匹配到第一个"

</div>“时使整个表达式匹配成功,由于采用的是非贪婪模式,所以结束匹配,不再向右尝试,匹配结果为”<div>test1</div>"。

BS4

和 lxml 一样,Beautiful Soup 也是一个HTML/XML的解析器,主要的功能也是如何解析和提取 HTML/XML 数据。

lxml 只会局部遍历,而Beautiful Soup 是基于HTML DOM的,会载入整个文档,解析整个DOM树,因此时间和内存开销都会大很多,所以性能要低于lxml。

BeautifulSoup 用来解析 HTML 比较简单,API非常人性化,支持CSS选择器、Python标准库中的HTML解析器,也支持 lxml 的 XML解析器。

Beautiful Soup 3 目前已经停止开发,推荐现在的项目使用Beautiful Soup 4。使用 pip 安装即可:

pip install beautifulsoup4

| 抓取工具 | 速度 | 使用难度 | 安装难度 |

|---|---|---|---|

| 正则 | 最快 | 困难 | 无(内置) |

| BeautifulSoup | 慢 | 最简单 | 简单 |

| lxml | 快 | 简单 | 一般 |

四大对象种类

Beautiful Soup将复杂HTML文档转换成一个复杂的树形结构,每个节点都是Python对象,所有对象可以归纳为4种:

1. Tag (标签)

Tag 通俗地说就是 HTML 中的一个个标签,例如:

<head><title>The Dormouse's story</title></head>

<a class="sister" href="http://example.com/elsie" id="link1"><!-- Elsie --></a>

<p class="title" name="dromouse"><b>The Dormouse's story</b></p>

上面的 <title>、<head>、<a>、<p> 等 HTML 标签加上里面包括的内容就是 Tag。通过 Beautiful Soup 来获取 Tags:

from bs4 import BeautifulSoup

html = """

<html><head><title>The Dormouse's story</title></head>

<body>

<p class="title" name="dromouse"><b>The Dormouse's story</b></p>

<p class="story">Once upon a time there were three little sisters; and their names were

<a href="http://example.com/elsie" class="sister" id="link1"><!-- Elsie --></a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

"""

# 创建 Beautiful Soup 对象

soup = BeautifulSoup(html)

print(soup.title)

# <title>The Dormouse's story</title>

print(soup.head)

# <head><title>The Dormouse's story</title></head>

print(soup.a)

# <a class="sister" href="http://example.com/elsie" id="link1"><!-- Elsie --></a>

print(soup.p)

# <p class="title" name="dromouse"><b>The Dormouse's story</b></p>

print(type(soup.p))

# <class 'bs4.element.Tag'>

对于 Tag,它有两个重要的属性,是 name 和 attrs:

print(soup.name)

# [document] # soup 对象本身比较特殊,它的 name 即为 [document]

print(soup.head.name)

# head # 对于其他内部标签,输出的值即为标签本身的名称

print(soup.p.attrs)

# {'class': ['title'], 'name': 'dromouse'}

# 在这里,我们把 p 标签的所有属性打印输出了出来,得到的类型是一个字典。

print(soup.p['class']) # soup.p.get('class')

# ['title'] # 还可以利用 get 方法,传入属性的名称,二者是等价的

soup.p['class'] = "newClass"

print(soup.p) # 可以对这些属性和内容进行修改

# <p class="newClass" name="dromouse"><b>The Dormouse's story</b></p>

del soup.p['class'] # 还可以对这个属性进行删除

print(soup.p)

# <p name="dromouse"><b>The Dormouse's story</b></p>

2. NavigableString (可遍历字符串)

NavigableString 对象表示标签内部的文字,可以通过 .string 属性获取。

print(soup.p.string)

# The Dormouse's story

print(type(soup.p.string))

# <class 'bs4.element.NavigableString'>

3. BeautifulSoup

BeautifulSoup 对象表示整个文档的内容,可以当作 Tag 对象,但是有些属性会有所不同。

print(type(soup.name))

# <class 'str'>

print(soup.name)

# [document]

print(soup.attrs) # 文档本身的属性为空

# {}

4. Comment (文档注释)

Comment 对象是一个特殊类型的 NavigableString 对象,其内容是 HTML 文档中的注释。

print(soup.a)

# <a class="sister" href="http://example.com/elsie" id="link1"><!-- Elsie --></a>

print(soup.a.string)

# Elsie

print(type(soup.a.string))

# <class 'bs4.element.Comment'>

a 标签里的内容实际上是注释,但是如果我们利用 .string 来输出它的内容时,注释符号已经被去掉了。

遍历文档树

1. 直接子节点 :.contents .children 属性

.content

tag 的 .content 属性可以将标签的子内容以列表的样式输出出来

print soup.head.contents

#[<title>The Dormouse's story</title>]

输出方式为列表,我们可以用列表索引来获取它的某一个元素

print soup.head.contents[0]

#<title>The Dormouse's story</title>

.children

它返回的不是一个 list,不过我们可以通过遍历获取所有子节点。

我们打印输出 .children 看一下,可以发现它是一个 list 生成器对象

print soup.head.children

#<listiterator object at 0x7f71457f5710>

for child in soup.body.children:

print child

2. 所有子孙节点: .descendants 属性

.contents 和 .children 属性仅包含tag的直接子节点,.descendants 属性可以对所有tag的子孙节点进行递归循环,和 children类似,我们也需要遍历获取其中的内容。

for child in soup.descendants:

print child

3. 节点内容: .string 属性

如果tag只有一个 NavigableString 类型子节点,那么这个tag可以使用 .string 得到子节点。如果一个tag仅有一个子节点,那么这个tag也可以使用 .string 方法,输出结果与当前唯一子节点的 .string 结果相同。

通俗点说就是:如果一个标签里面没有标签了,那么 .string 就会返回标签里面的内容。如果标签里面只有唯一的一个标签了,那么 .string 也会返回最里面的内容。例如:

print soup.head.string

#The Dormouse's story

print soup.title.string

#The Dormouse's story

搜索文档树

1.find_all(name, attrs, recursive, text, **kwargs)

参数解释:

-

name: 可以是字符串、正则表达式、列表,用来查找所有名字为 name 的标签。

A.传字符串 :

soup.find_all('b') # [<b>The Dormouse's story</b>]B.传正则表达式:

import re for tag in soup.find_all(re.compile("^b")): print(tag.name) # body # bC.传列表

soup.find_all(["a", "b"]) #找到所有的a和b标签D.keyword 参数

soup.find_all(id='link2') # [<a class="sister" href="http://example.com/lacie" id="link2">Lacie</a>] -

attrs: 用于传入字典参数,查找具有特定属性的标签。

-

recursive: 布尔值,指定是否递归搜索子孙节点,默认为 True。

-

text: 可以是字符串、正则表达式、列表,用于搜索文档中的字符串内容。

-

kwargs: 关键字参数,用于匹配具有指定属性值的标签。

CSS选择器

这就是另一种与 find_all 方法有异曲同工之妙的查找方法.

- 写 CSS 时,标签名不加任何修饰,类名前加

.,id名前加# - 在这里我们也可以利用类似的方法来筛选元素,用到的方法是

soup.select(),返回类型是list - (1)通过标签名查找

print soup.select('title')

#[<title>The Dormouse's story</title>]

print soup.select('a')

#[<a class="sister" href="http://example.com/elsie" id="link1"><!-- Elsie --></a>, <a class="sister" href="http://example.com/lacie" id="link2">Lacie</a>, <a class="sister" href="http://example.com/tillie" id="link3">Tillie</a>]

print soup.select('b')

#[<b>The Dormouse's story</b>]

(2)通过类名查找

print soup.select('.sister')

#[<a class="sister" href="http://example.com/elsie" id="link1"><!-- Elsie --></a>, <a class="sister" href="http://example.com/lacie" id="link2">Lacie</a>, <a class="sister" href="http://example.com/tillie" id="link3">Tillie</a>]

(3)通过 id 名查找

print soup.select('#link1')

#[<a class="sister" href="http://example.com/elsie" id="link1"><!-- Elsie --></a>]

(4)组合查找

组合查找即和写 class 文件时,标签名与类名、id名进行的组合原理是一样的,例如查找 p 标签中,id 等于 link1的内容,二者需要用空格分开

print soup.select('p #link1')

#[<a class="sister" href="http://example.com/elsie" id="link1"><!-- Elsie --></a>]

直接子标签查找,则使用 > 分隔

print soup.select("head > title")

#[<title>The Dormouse's story</title>]

(5)属性查找

查找时还可以加入属性元素,属性需要用中括号括起来,注意属性和标签属于同一节点,所以中间不能加空格,否则会无法匹配到。

print soup.select('a[class="sister"]')

#[<a class="sister" href="http://example.com/elsie" id="link1"><!-- Elsie --></a>, <a class="sister" href="http://example.com/lacie" id="link2">Lacie</a>, <a class="sister" href="http://example.com/tillie" id="link3">Tillie</a>]

print soup.select('a[href="http://example.com/elsie"]')

#[<a class="sister" href="http://example.com/elsie" id="link1"><!-- Elsie --></a>]

同样,属性仍然可以与上述查找方式组合,不在同一节点的空格隔开,同一节点的不加空格

print soup.select('p a[href="http://example.com/elsie"]')

#[<a class="sister" href="http://example.com/elsie" id="link1"><!-- Elsie --></a>]

(6) 获取内容

以上的 select 方法返回的结果都是列表形式,可以遍历形式输出,然后用 get_text() 方法来获取它的内容。

soup = BeautifulSoup(html, 'lxml')

print type(soup.select('title'))

print soup.select('title')[0].get_text()

for title in soup.select('title'):

print title.get_text()

Xpath

我正则用的不好,处理HTML文档很累,有没有其他的方法?

有!那就是XPath,我们可以先将 HTML文件 转换成 XML文档,然后用 XPath 查找 HTML 节点或元素。

1. 什么是XML

- XML 指可扩展标记语言

- XML 是一种标记语言,很类似 HTML

- XML 的设计宗旨是传输数据,而非显示数据

- XML 的标签需要我们自行定义

2. XML和HTML的区别

| 数据格式 | 描述 | 设计目标 |

|---|---|---|

| XML | Extensible Markup Language (可扩展标记语言) | 被设计为传输和存储数据,其焦点是数据的内容。 |

| HTML | HyperText Markup Language (超文本标记语言) | 显示数据以及如何更好显示数据。 |

| HTML DOM | Document Object Model for HTML (文档对象模型) | 通过 HTML DOM,可以访问所有的 HTML 元素,连同它们所包含的文本和属性。可以对其中的内容进行修改和删除,同时也可以创建新的元素。 |

3.什么是XPath?

XPath (XML Path Language) 是一门在 XML 文档中查找信息的语言,可用来在 XML 文档中对元素和属性进行遍历。

W3School官方文档:http://www.w3school.com.cn/xpath/index.asp

4.XPath语法

选取节点

XPath使用路径来指定在XML文档中选择节点的方法。这些路径表达式类似于我们在文件夹系统中看到的路径,用来定位并选择特定的节点。

| 表达式 | 描述 |

|---|---|

| nodename | 选取此节点的所有子节点。 |

| / | 从根节点选取。 |

| // | 从匹配选择的当前节点选择文档中的节点,而不考虑它们的位置。 |

| . | 选取当前节点。 |

| … | 选取当前节点的父节点。 |

| @ | 选取属性。 |

谓语(Predicates)

谓语用来查找某个特定的节点或者包含某个指定的值的节点,被嵌在方括号中。

| 路径表达式 | 结果 |

|---|---|

| /bookstore/book[1] | 选取属于 bookstore 子元素的第一个 book 元素。 |

| /bookstore/book[last()] | 选取属于 bookstore 子元素的最后一个 book 元素。 |

| /bookstore/book[last()-1] | 选取属于 bookstore 子元素的倒数第二个 book 元素。 |

| /bookstore/book[position()❤️] | 选择 bookstore 元素下的前两个 book 元素 |

| //title[@lang] | 选取所有拥有名为 lang 的属性的 title 元素。 |

| //title[@lang=’eng’] | 选取所有 title 元素,且这些元素拥有值为 eng 的 lang 属性。 |

选取未知节点

XPath 通配符可用来选取未知的 XML 元素

| 通配符 | 描述 |

|---|---|

| * | 匹配任何元素节点。 |

| @* | 匹配任何属性节点。 |

| node() | 匹配任何类型的节点,包括元素、文本、注释、处理指令等 |

如下:

| 路径表达式 | 结果 |

|---|---|

| /bookstore/* | 选取 bookstore 元素的所有子元素。 |

| //* | 选取文档中的所有元素。 |

| html/node()/meta/@* | 选择html下面任意节点下的meta节点的所有属性 |

| //title[@*] | 选取所有带有属性的 title 元素。 |

选取若干路径

通过在路径表达式中使用“|”运算符,您可以选取若干个路径。

| 路径表达式 | 结果 |

|---|---|

| //book/title | //book/price | 选取 book 元素的所有 title 和 price 元素。 |

| //title | //price | 选取文档中的所有 title 和 price 元素。 |

| /bookstore/book/title | //price | 选取属于 bookstore 元素的 book 元素的所有 title 元素,以及文档中所有的 price 元素。 |

JSON

JSON(JavaScript Object Notation) 是一种轻量级的数据交换格式,它使得人们很容易的进行阅读和编写。同时也方便了机器进行解析和生成。适用于进行数据交互的场景,比如网站前台与后台之间的数据交互。

JSON和XML的比较可谓不相上下。

Python 2.7中自带了JSON模块,直接import json就可以使用了。

官方文档:http://docs.python.org/library/json.html

Json在线解析网站:http://www.json.cn/

JSON

json简单说就是javascript中的对象和数组,所以这两种结构就是对象和数组两种结构,通过这两种结构可以表示各种复杂的结构

- 对象:对象在js中表示为

{ }括起来的内容,数据结构为{ key:value, key:value, ... }的键值对的结构,在面向对象的语言中,key为对象的属性,value为对应的属性值,所以很容易理解,取值方法为 对象.key 获取属性值,这个属性值的类型可以是数字、字符串、数组、对象这几种。- 数组:数组在js中是中括号

[ ]括起来的内容,数据结构为["Python", "javascript", "C++", ...],取值方式和所有语言中一样,使用索引获取,字段值的类型可以是 数字、字符串、数组、对象几种。

json模块提供了四个功能:dumps、dump、loads、load,用于字符串 和 python数据类型间进行转换。

您的解释基本正确,但对一些细节进行了纠正和补充:

1. json.loads()

作用:把 JSON 格式的字符串转为 Python 数据类型

import json

strList = '[1, 2, 3, 4]'

strDict = '{"city": "北京", "name": "大猫"}'

# 把 JSON 字符串转为 Python 列表

python_list = json.loads(strList)

print(python_list) # [1, 2, 3, 4]

# 把 JSON 字符串转为 Python 字典

python_dict = json.loads(strDict)

print(python_dict) # {'city': '北京', 'name': '大猫'}

2. json.dumps()

作用:把 Python 数据类型转换为 JSON 格式的字符串

import json

# json.dumps()之前

item = {'name': 'QQ', 'app_id': 1}

print('before dumps:', type(item)) # <class 'dict'>

# json.dumps()之后

item_json = json.dumps(item, ensure_ascii=False)

print('after dumps:', type(item_json)) # <class 'str'>

print('JSON string:', item_json) # {"name": "QQ", "app_id": 1}

3. json.dump()

作用:把 Python 数据类型转为 JSON 格式的字符串,并写入文件

# 示例1

import json

item = {'name': 'QQ', 'app_id': 1}

with open('xiaomi.json', 'w', encoding='utf-8') as f:

json.dump(item, f, ensure_ascii=False)

# 示例2

import json

item_list = []

for i in range(3):

item = {'name': 'QQ', 'id': i}

item_list.append(item)

with open('xiaomi_list.json', 'w', encoding='utf-8') as f:

json.dump(item_list, f, ensure_ascii=False)

4. json.load()

作用:从 JSON 文件中读取数据,并转为 Python 数据类型

import json

with open('xiaomi_list.json', 'r', encoding='utf-8') as f:

data = json.load(f)

print(data) # [{'name': 'QQ', 'id': 0}, {'name': 'QQ', 'id': 1}, {'name': 'QQ', 'id': 2}]

JsonPath(了解)

JsonPath 是一种信息抽取类库,是从JSON文档中抽取指定信息的工具,提供多种语言实现版本,包括:Javascript, Python, PHP 和 Java。

JsonPath 对于 JSON 来说,相当于 XPATH 对于 XML。

下载地址:https://pypi.python.org/pypi/jsonpath

安装方法:点击

Download URL链接下载jsonpath,解压之后执行python setup.py install

JsonPath与XPath语法对比:

Json结构清晰,可读性高,复杂度低,非常容易匹配,下表中对应了XPath的用法。

| XPath | JSONPath | 描述 |

|---|---|---|

/ | $ | 根节点 |

. | @ | 现行节点 |

/ | .or[] | 取子节点 |

.. | n/a | 取父节点,Jsonpath未支持 |

// | .. | 就是不管位置,选择所有符合条件的条件 |

* | * | 匹配所有元素节点 |

@ | n/a | 根据属性访问,Json不支持,因为Json是个Key-value递归结构,不需要。 |

[] | [] | 迭代器标示(可以在里边做简单的迭代操作,如数组下标,根据内容选值等) |

| | | [,] | 支持迭代器中做多选。 |

[] | ?() | 支持过滤操作. |

| n/a | () | 支持表达式计算 |

() | n/a | 分组,JsonPath不支持 |

示例:

我们以拉勾网城市JSON文件 http://www.lagou.com/lbs/getAllCitySearchLabels.json 为例,获取所有城市。

# jsonpath_lagou.py

import requests

import jsonpath

import json

import chardet

url = 'http://www.lagou.com/lbs/getAllCitySearchLabels.json'

response = equests.get(url)

html = response.text

# 把json格式字符串转换成python对象

jsonobj = json.loads(html)

# 从根节点开始,匹配name节点

citylist = jsonpath.jsonpath(jsonobj,'$..name')

print citylist

print type(citylist)

fp = open('city.json','w')

content = json.dumps(citylist, ensure_ascii=False)

print content

fp.write(content.encode('utf-8'))

fp.close()

拼接连接的库

from urllib.parse import urljoin

parsel库

parsel是一个python的第三方库,相当于css选择器+xpath+re。

parsel由scrapy团队开发,是将scrapy中的parsel独立抽取出来的,可以轻松解析html,xml内容,获取需要的数据,相比于BeautifulSoup,xpath,parsel效率更高,使用更简单

CSS选择器

无论是使用css选择器,还是xpath,re,都需要先创建一个parsel.Selector对象

from parsel import Selector

# html 可以是请求某个网页的源码,也可以是html,xml格式的字符串

selector = Selector(html)

创建Selector对象之后就可以开始使用了

tags = selector.css('.content')

# 我们平时使用的css中,对某一个标签进行修饰时,使用的是 .class_attr

#在这里也是如此

# .content 就是指查询所有 class 为 content 的标签

# 查询的结果是一个特殊的对象,不能直接得到需要的数据

将css()函数查询到的结果转换为字符串或者列表,需要使用一个函数

get():将css() 查询到的第一个结果转换为str类型getall()将css() 查询到的全部结果转换为list类型

html = """

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8">

<title>标签选择器</title>

</head>

<body>

<p>css标签选择器的介绍</p>

<p class='p'>标签选择器、类选择器、ID选择器</p>

<a href="https://www.baidu.com" title="百度搜索">百度一下</a>

<span> 我是一个span标签</span>

<div id="map">

<p class="content">早上祝您端午节快乐!</p>

</div>

<span id="map">

<p class="content">晚上祝您端午节快乐!</p>

</span>

<span id="text">你好,我是一行文字</span>

</body>

</html>

"""

# 选取所有的p标签

p_tags = selector.css('p')

print(p_tags.get())

# <p>css标签选择器的介绍</p>

print(p_tags.getall())

# 结果

# ['<p>css标签选择器的介绍</p>',

# '<p class="p">标签选择器、类选择器、ID选择器</p>',

# '<p>我是 div > p 标签的文字,我是div 标签的儿子标签</p>',

# '<p class="content">早上祝您端午节快乐!</p>',

# '<p>我是div > span > p 标签中的文字,我是div 标签的孙子标签</p>',

# '<p class="content">晚上祝您端午节快乐!</p>']

# 选择所有class为content的标签

tags = selector.css('.content')

print(type(tags.get()))

# <class 'str'>

print(tags.get())

# <p class="content">早上祝您端午节快乐!</p>

print(type(tags.getall()))

# <class 'list'>

print(tags.getall())

# ['<p class="content">早上祝您端午节快乐!</p>', '<p class="content">晚上祝您端午节快乐!</p>']

# 选取id为text的所有标签

text = selector.css('#text')

print(text.get())

# <span id="text">你好,我是一行文字</span>

# 属性提取器

# 分别提取a标签中的href和title属性值

href_value = selector.css('a::attr(href)').get()

print(href_value)

# https://www.baidu.com

title_value = selector.css('a::attr(title)').get()

print(title_value)

# 百度搜索

# 提取文字

string = selector.css('#text::text').get()

print(string)

# 你好,我是一行文字

# id为map的标签内的p标签,且p标签的class为content,提取出该标签的文字

content = selector.css('#map p.content::text').getall()

print(content)

# ['早上祝您端午节快乐!', '晚上祝您端午节快乐!']

# id为map的span标签,该标签内的p标签,且该p标签的class为content,提取出该标签的文字

content2 = selector.css('span#map p.content::text').getall()

print(content2)

# ['晚上祝您端午节快乐!']

# id为map的标签,该标签内class为content的标签,提取出该标签的文字

content3 = selector.css('#map .content::text').getall()

print(content3)

# ['早上祝您端午节快乐!', '晚上祝您端午节快乐!']

# 子选择器和孙子选择器

son_tags = selector.css('#map > p')

pprint(son_tags.getall())

# ['<p>我是 div > p 标签的文字,我是div 标签的儿子标签</p>',

# '<p class="content">早上祝您端午节快乐!</p>',

# '<p class="content">晚上祝您端午节快乐!</p>']

sunzi_tags = selector.css('#map p')

pprint(sunzi_tags.getall())

# ['<p>我是 div > p 标签的文字,我是div 标签的儿子标签</p>',

# '<p class="content">早上祝您端午节快乐!</p>',

# '<p>我是div > span > p 标签中的文字,我是div 标签的孙子标签</p>',

# '<p class="content">晚上祝您端午节快乐!</p>']

5.高效率爬虫

在爬虫中进程、线程、协程用的其实并不多,在你遇到需要下载图片、视频、文件等操作的时候可以采用进程、线程、协程等方式来加速爬取的需求,但是一般的网站是有访问的限制的,在使用的时候也要注意,在网络编程详细的学过了进程、线程、协程的知识点,其实在爬虫中进程、线程使用的大部分都是线程池、进程池

9.1多线程

多线程的本质就是在程序中开辟多个助手协助运行,所以在下载图片、视频等操作的时候,一个人下载一定是比不上一群人下载的,但是在爬虫的使用场景,因为我们还要涉及到管理线程的问题,所以直接使用线程池即可

from concurrent.futures import ThreadPoolExecutor as ThreadPool

'''

多线程爬取4k壁纸网

'''

import requests

from bs4 import BeautifulSoup

import time

import os

from concurrent.futures import ThreadPoolExecutor as ThreadPool

from urllib.parse import urljoin

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/125.0.0.0 Safari/537.36 Edg/125.0.0.0'

}

# 下载图片

def download_image(img_url,title):

try:

resp = requests.get(img_url, headers=headers)

resp.encoding = 'gbk'

filename = title + '.jpg'

if not os.path.exists('./img/'):

os.makedirs('./img/')

with open('./img/' + filename, 'wb') as f:

f.write(resp.content)

print("下载完成:" + filename)

except Exception as e:

print(f"下载失败:{img_url},错误信息:{e}")

# 内部壁纸页面

def process_wallpaper_page(href,title):

try:

response = requests.get(href, headers=headers)

response.encoding = 'gbk'

soup = BeautifulSoup(response.text, 'html.parser')

img_url = soup.find('div', attrs={"class": "photo-pic"}).find("img").get('src')

img_url = urljoin(href, img_url)

download_image(img_url,title)

except Exception as e:

print(f"处理页面失败:{href},错误信息:{e}")

def get_pic(url):

response = requests.get(url, headers=headers)

response.encoding = 'gbk'

soup = BeautifulSoup(response.text, 'html.parser')

a_list = soup.find('ul', attrs={"class": "clearfix"}).find_all("a")

print("共有" + str(len(a_list)) + "张壁纸")

with ThreadPool(max_workers=10) as pool:

for a in a_list:

href = a.get("href")

title = a.find("b").text

href = urljoin(url, href)

pool.submit(process_wallpaper_page, href,title)

if __name__ == '__main__':

start_time = time.time()

for i in range(2, 11):

url = f'https://pic.netbian.com/4kdongman/index_{i}.html'

print(f"正在下载第{i}页")

get_pic(url)

end_time = time.time()

print(f"下载完成,耗时 {end_time - start_time:.2f} 秒")

9.2多进程

因为进程是额外开辟程序,所以一般情况下进程是不单独使用的,会使用上生产消费者模型搭配线程一起使用

'''

多进程爬取4K壁纸网

生产者-消费者模型

'''

import requests

import os

from urllib.parse import urljoin

from concurrent.futures import ThreadPoolExecutor

from multiprocessing import Process

from lxml import etree

import time

from multiprocessing import Queue # 进程间通信队列

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.132 Safari/537.36'

}

# 生产者

def get_url(q):

for page in range(1, 10):

url = f'https://pic.netbian.com/4kdongman/index_{page}.html'

resp = requests.get(url, headers=headers)

resp.encoding = 'gbk'

html = etree.HTML(resp.text) #type: etree._Element

img_urls = html.xpath('//div[@class="slist"]//a//@href')

# /tupian/34379.html

for img_url in img_urls:

img_url = urljoin('https://pic.netbian.com/', img_url)

q.put(img_url)

print(f'开始下载第{page}页图片')

q.put('没数据了,快走吧') # 通知消费者结束

# 队列中转站

def img_producer(q):

with ThreadPoolExecutor(max_workers=4) as executor:

while True:

img_url = q.get()

if img_url == '没数据了,快走吧':

break

executor.submit(download_img, img_url)

# 消费者

def download_img(img_url):

'''

下载图片

'''

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.132 Safari/537.36'

}

resp = requests.get(img_url, headers=headers)

resp.encoding = 'gbk'

html = etree.HTML(resp.text) #type: etree._Element

img_url = html.xpath('//div[@class="photo-pic"]//img//@src')[0]

# 拼接完整的url

img_url = urljoin('https://pic.netbian.com/', img_url)

resp = requests.get(img_url, headers=headers)

# 下载图片

img_name = img_url.split('/')[-1]

if os.path.exists(f'./img/{img_name}'):

print(f'{img_name}已存在')

return

with open(f'./img/{img_name}', 'wb') as f:

f.write(resp.content)

print(f'{img_name}下载完成')

if __name__ == '__main__':

start_time = time.time()

q = Queue() # 准备一个队列

p1 = Process(target=get_url, args=(q,))

p2 = Process(target=img_producer, args=(q,))

p1.start()

p2.start()

p1.join()

p2.join()

end_time = time.time()

print(f'总共耗时{end_time-start_time:.2f}秒')

# 多进程 总共耗时3.96秒

9.3异步协程

下载图片、最强、最快的一种模式,遇到IO就切换

'''

异步爬取小说网站

1.拿到主页面的源代码(不需要异步)

2.解析主页面的源代码,获取小说的链接

3.建立一个字典、将小说的章节标题、章节、链接作为键值对存入字典

4.根据字典中的链接,异步抓取每个章节的源代码,并解析出章节标题、章节内容

5.异步下载每个章节的内容,并保存到本地

'''

import os

import requests

import asyncio

# ===外部库======

import aiohttp

from lxml import etree

import aiofiles

# ===全局变量====

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/79.0.3945.130 Safari/537.36'

}

# ===函数定义====

def get_novel_url(url):

result = []

resp = requests.get(url, headers=headers)

resp.encoding = 'utf-8'

if resp.status_code == 200:

html = etree.HTML(resp.text) #type: etree._Element

divs = html.xpath("//div[@class='mulu']")

print(f'{url}共有{len(divs)}章') # 打印出小说的章节数

for div in divs:

main_title = div.xpath(".//table//tr")

# 主标题

title = main_title[0].xpath(".//a/text()")

title = ''.join(title).strip().replace(':', '_')

for t in main_title[1:]:

# 这样太乱了,我们改进一下

# text = t.xpath("./td//text()")

# urls = t.xpath("./td//a/@href")

# print(title, text,urls)

tds = t.xpath("./td")

for td in tds:

text = td.xpath(".//text()")

href = td.xpath(".//@href")

text = ''.join(text).replace(' ', '').strip()

href = ''.join(href).strip()

dic = {

'title': title,

'text': text,

'href': href

}

result.append(dic)

return result

async def download_one(url,file_name):

print(f'开始下载{file_name}')

async with aiohttp.ClientSession() as session:

async with session.get(url,headers=headers) as response:

if response.status == 200:

page_content = await response.text('utf-8')

container = etree.HTML(page_content)

content = container.xpath("//div[@class='content']/p//text()")

content = ''.join(content).strip()

# 写入文件

async with aiofiles.open(file_name,'w',encoding='utf-8') as f:

await f.write(content)

print(f'{file_name}下载完成')

async def download_chapter(url):

tasks = []

for chapter in url:

title = chapter['title'] #文件夹名

text = chapter['text'] #文件名

href = chapter['href'] #用来下载

if not os.path.exists(title):

os.makedirs(title)

file_name = f'{title}/{text}.txt'

t = asyncio.create_task(download_one(href,file_name))

tasks.append(t)

await asyncio.wait(tasks)

def main():

url = 'https://www.mingchaonaxieshier.com/'

novel_list = get_novel_url(url)

print(f'{novel_list}')

# 异步抓取小 说内容

loop = asyncio.get_event_loop()

loop.run_until_complete(download_chapter(novel_list))

loop.close()

if __name__ == '__main__':

main()

6.selenium

selenium本身是一个自动化测试工具。它可以让python代码调用浏览器。并获取到浏览器中加载的各种资源。 我们可以利用selenium提供的各项功能。 帮助我们完成数据的抓取。

我们在抓取一些普通网页的时候requests基本上是可以满足的. 但是, 如果遇到一些特殊的网站. 它的数据是经过加密的. 但是呢, 浏览器却能够正常显示出来. 那我们通过requests抓取到的内容可能就不是我们想要的结果了.

1.对页面进行操作

-

1.1 初始化浏览器对象

get('url'): 启动一个浏览器页面并打开指定的URL。

from selenium.webdriver import Edge import time # 启动Edge引擎 web = Edge() # 访问百度首页 web.get('https://www.baidu.com/') # 关闭浏览器 web.close() # 挂载页面 time.sleep(9999) -

1.2设置浏览器窗口大小

set_window_size(width, height): 设置浏览器窗口的宽度和高度。maximize_window(): 将浏览器窗口最大化。

from selenium import webdriver import time browser = webdriver.Chrome() # 设置浏览器大小:全屏 browser.maximize_window() browser.get('https://www.baidu.com') time.sleep(2) # 设置分辨率 500*500 browser.set_window_size(500,500) time.sleep(2) # 关闭浏览器 browser.close() -

1.3浏览器前进和后退

back(): 后退到浏览历史中的上一个页面。forward(): 前进到浏览历史中的下一个页面。refresh(): 刷新当前页面。

from selenium.webdriver import Edge from time import sleep web = Edge() # 访问b站首页 web.get('https://www.bilibili.com/?spm_id_from=333.999.0.0') sleep(2) # 访问B站个人主页 web.get('https://space.bilibili.com/361040115?spm_id_from=333.788.0.0') sleep(2) # 返回(后退)到b站首页 web.back() sleep(2) web.forward() sleep(2) # 刷新该页面 web.refresh() web.refresh() web.refresh() web.refresh() web.refresh() sleep(999) -

1.4浏览器窗口切换

-

虽然视觉效果上窗口的确有切换,但是selenium内核并没有进行切换操作,所以需要切换句柄来让它能够识别到该页面

window_handles: 获取当前打开的所有窗口句柄。switch_to.window(handle): 切换到指定句柄对应的窗口。

# 获取打开的多个窗口句柄 windows = web.window_handles # 切换到当前最新打开的窗口 web.switch_to.window(windows[-1]) # 切换到第一个打开的页面 web.switch_to.window(windows[0]) -

1.5iframe切换

switch_to.frame(frame_reference): 切换到指定的iframe。

from selenium.webdriver import Chrome

from selenium.webdriver.common.by import By

web = Chrome()

web.get("http://www.wbdy.tv/play/42491_1_1.html")

# 找到那个iframe

iframe = web.find_element(By.XPATH, '//iframe[@id="mplay"]')

web.switch_to.frame(iframe)

val = web.find_element(By.XPATH, '//input[@class="dplayer-comment-input"]').get_attribute("placeholder")

print(val)

# 调整回上层结构

web.switch_to.parent_frame()

xxx = web.find_element(By.XPATH, '/html/body/div[2]/div[3]/div[2]/div/div[2]/h2').text

print(xxx)

-

1.6获取页面基础属性

-

当我们用selenium打开某个页面,有一些基础属性如网页标题、网址、浏览器名称、页面源码等信息

from selenium import webdriver browser = webdriver.Chrome() browser.get('https://www.baidu.com') # 网页标题 print(browser.title) # 当前网址 print(browser.current_url) # 浏览器名称 print(browser.name) # 网页源码 print(browser.page_source)

-

2. 常见操作

find_element(by, value): 查找页面上符合条件的第一个元素。find_elements(by, value): 查找页面上符合条件的所有元素,返回列表。- By后的属性如下

| 属性 | 函数 |

|---|---|

| CLASS | find_element(by=By.CLASS_NAME, value=‘’) |

| XPATH | find_element(by=By.XPATH, value=‘’) |

| LINK_TEXT | find_element(by=By.LINK_TEXT, value=‘’) |

| PARTIAL_LINK_TEXT | find_element(by=By.PARTIAL_LINK_TEXT, value=‘’) |

| TAG | find_element(by=By.TAG_NAME, value=‘’) |

| CSS | find_element(by=By.CSS_SELECTOR, value=‘’) |

| ID | find_element(by=By.ID, value=‘’) |

is_displayed(): 判断元素是否可见。send_keys(*value): 向元素发送键盘输入。web.implicitly_wait(10):隐式等待十秒钟

from selenium import webdriver

from time import sleep

from selenium.webdriver.common.keys import Keys

web = webdriver.Edge()

web.get('https://www.bilibili.com/?spm_id_from=333.999.0.0')

sleep(2)

web.implicitly_wait(10)

# 定位搜索输入框

text_label = web.find_element(by='xpath', value='//*[@id="nav-searchform"]/div[1]/input')

# 在搜索框中输入 Dream丶Killer

text_label.send_keys('Dream丶Killer', Keys.ENTER)

sleep(2)

# 输出搜索框元素是否可见

print(text_label.is_displayed()) #return bool

# 输出placeholder(页面上显示的提示信息)的值

print(text_label.get_attribute('placeholder'))

3. 鼠标控制

既然是模拟浏览器操作,自然也就需要能模拟鼠标的一些操作了,这里需要导入ActionChains 类。

from selenium.webdriver.common.action_chains import ActionChains

| 操作 | 函数 |

|---|---|

| 右击 | context_click() |

| 双击 | double_click() |

| 拖拽 | double_and_drop() |

| 悬停 | move_to_element() |

| 执行 | perform() |

-

鼠标移动至元素位置:

-

move_to_element(to_element): 将鼠标移动至指定元素的位置。 -

move_to_element_with_offset(to_element, xoffset, yoffset): 将鼠标移动至指定元素位置的偏移量处。from selenium.webdriver.common.action_chains import ActionChains # 移动至元素位置 element = web.find_element(By.XPATH, '//button[@id="button"]') ActionChains(web).move_to_element(element).perform() #==================适用xy坐抓取b站点选验证码======================================= from selenium.webdriver import Edge from selenium.webdriver.common.by import By # 动作链 from selenium.webdriver.common.action_chains import ActionChains from time import sleep import requests import base64 import json def base64_api(uname, pwd, img, typeid): with open(img, 'rb') as f: base64_data = base64.b64encode(f.read()) b64 = base64_data.decode() data = {"username": uname, "password": pwd, "typeid": typeid, "image": b64} result = json.loads(requests.post("http://api.ttshitu.com/predict", json=data).text) if result['success']: return result["data"]["result"] else: return result["message"] web = Edge() web.get('https://www.bilibili.com/?spm_id_from=333.999.0.0') web.implicitly_wait(10) # 隐式等待 web.find_element(By.XPATH,'//*[@class="header-login-entry"]').click() web.find_element(By.XPATH,'/html/body/div[4]/div/div[4]/div[2]/form/div[1]/input').send_keys('2561561') web.find_element(By.XPATH,'/html/body/div[4]/div/div[4]/div[2]/form/div[3]/input').send_keys('123456') # 点击登录按钮 web.find_element(By.XPATH,'/html/body/div[4]/div/div[4]/div[2]/div[2]/div[2]').click() sleep(2) img = web.find_element(By.XPATH,'//*[@class="geetest_widget"]') img.screenshot('captcha.png') result = base64_api('Prorsie', 'Maicol7896', 'captcha.png', 27) print(result) # 101,80|156,236|251,92|165,165 res = result.split('|') for i in res: x, y = i.split(',') print(x,y) x = int(x) y = int(y) # 移动鼠标到验证码位置 ActionChains(web).move_to_element_with_offset(img, x, y).click().perform()

-

-

点击鼠标左键:

-

click(on_element=None): 在当前鼠标位置左键单击。如果提供了元素参数,则在该元素位置左键单击。from selenium.webdriver.common.action_chains import ActionChains # 单击元素 element = web.find_element(By.XPATH, '//button[@id="button"]') ActionChains(web).click(element).perform()

-

-

点击鼠标右键:

-

context_click(on_element=None): 在当前鼠标位置右键单击。如果提供了元素参数,则在该元素位置右键单击。from selenium.webdriver.common.action_chains import ActionChains # 右键单击元素 element = web.find_element(By.XPATH, '//button[@id="button"]') ActionChains(web).context_click(element).perform()

-

-

双击鼠标左键:

-

double_click(on_element=None): 在当前鼠标位置双击左键。如果提供了元素参数,则在该元素位置双击左键。from selenium.webdriver.common.action_chains import ActionChains # 双击元素 element = web.find_element(By.XPATH, '//button[@id="button"]') ActionChains(web).double_click(element).perform()

-

-

拖拽操作:

-

drag_and_drop(source, target): 将源元素拖拽至目标元素。 -

drag_and_drop_by_offset(source, xoffset, yoffset): 将源元素拖拽至指定偏移量处。from selenium.webdriver.common.action_chains import ActionChains # 拖拽元素至指定位置 source_element = web.find_element(By.XPATH, '//div[@id="source"]') target_element = web.find_element(By.XPATH, '//div[@id="target"]') ActionChains(web).drag_and_drop(source_element, target_element).perform()

-

-

长按与释放鼠标:

-

click_and_hold(on_element=None): 在当前鼠标位置按住左键。如果提供了元素参数,则在该元素位置按住左键。 -

release(on_element=None): 释放鼠标左键。如果提供了元素参数,则在该元素位置释放左键。from selenium.webdriver.common.action_chains import ActionChains # 在元素位置释放鼠标左键 element = web.find_element(By.XPATH, '//button[@id="button"]') ActionChains(web).click_and_hold(element).release().perform()

-

4.模拟键盘操作

引入Keys类

from selenium.webdriver.common.keys import Keys

| 操作 | 函数 |

|---|---|

| 删除键 | send_keys(Keys.BACK_SPACE) |

| 空格键 | send_keys(Keys.SPACE) |

| 制表键 | send_keys(Keys.TAB) |

| 回退键 | send_keys(Keys.ESCAPE) |

| 回车 | send_keys(Keys.ENTER) |

| 全选 | send_keys(Keys.CONTRL,‘a’) |

| 复制 | send_keys(Keys.CONTRL,‘c’) |

| 剪切 | send_keys(Keys.CONTRL,‘x’) |

| 粘贴 | send_keys(Keys.CONTRL,‘x’) |

| 键盘F1 | send_keys(Keys.F1) |

5. 延时等待

如果遇到使用ajax加载的网页,页面元素可能不是同时加载出来的,这个时候尝试在get方法执行完成时获取网页源代码可能并非浏览器完全加载完成的页面。所以,这种情况下需要设置延时等待一定时间,确保全部节点都加载出来。 三种方式:强制等待、隐式等待和显式等待。

所需导入的模块和包

-

selenium.webdriver: 包含浏览器驱动程序 -

selenium.webdriver.support.ui.WebDriverWait: 用于显式等待 -

selenium.webdriver.support import expected_conditions as EC: 包含各种预期条件 -

selenium.webdriver.common.by import By: 用于元素定位 -

time: 用于强制等待#包含浏览器驱动程序 from selenium.webdriver import Edge #用于显式等待 from selenium.webdriver.support import expected_conditions as EC #包含各种预期条件 from selenium.webdriver.support.ui import WebDriverWait #用于元素定位 from selenium.webdriver.common.by import By #用于强制等待 import time

5.1 强制等待

直接使用 time.sleep(n) 强制等待n秒,在执行get方法之后执行。

5.2 隐式等待

implicitly_wait() 设置等待时间,如果到时间有元素节点没有加载出来,就会抛出异常。

5.3 显式等待

设置一个等待时间和一个条件,在规定时间内,每隔一段时间查看下条件是否成立,如果成立那么程序就继续执行,否则就抛出一个超时异常。

WebDriverWait的参数说明:WebDriverWait(driver, timeout, poll_frequency=0.5, ignored_exceptions=None)

-

driver: 浏览器驱动,控制浏览器的操作。

-

timeout: 超时时间,等待的最长时间(同时要考虑隐性等待时间)。

-

poll_frequency: 每次检测的间隔时间,默认是0.5秒。

-

ignored_exceptions: 超时后的异常信息,默认情况下抛出

NoSuchElementException异常。以下的内容直接复制即可

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

from selenium.webdriver.common.by import By

# 示例使用 until 方法等待元素可见

element = WebDriverWait(driver, 10).until(

EC.visibility_of_element_located((By.ID, 'element_id')),

message='Element not visible within the given timeout'

)

# 示例使用 until_not 方法等待元素消失

WebDriverWait(driver, 10).until_not(

EC.presence_of_element_located((By.ID, 'element_id')),

message='Element still present within the given timeout'

)

5.4判断预期

from selenium.webdriver.support import expected_conditions as EC

# 判断标题是否和预期的一致

title_is

# 判断标题中是否包含预期的字符串

title_contains

# 判断指定元素是否加载出来

presence_of_element_located

# 判断所有元素是否加载完成

presence_of_all_elements_located

# 判断某个元素是否可见. 可见代表元素非隐藏,并且元素的宽和高都不等于0,传入参数是元组类型的locator

visibility_of_element_located

# 判断元素是否可见,传入参数是定位后的元素WebElement

visibility_of

# 判断某个元素是否不可见,或是否不存在于DOM树

invisibility_of_element_located

# 判断元素的 text 是否包含预期字符串

text_to_be_present_in_element

# 判断元素的 value 是否包含预期字符串

text_to_be_present_in_element_value

# 判断frame是否可切入,可传入locator元组或者直接传入定位方式:id、name、index或WebElement

frame_to_be_available_and_switch_to_it

# 判断是否有alert出现

alert_is_present

# 判断元素是否可点击

element_to_be_clickable

# 判断元素是否被选中,一般用在下拉列表,传入WebElement对象

element_to_be_selected

# 判断元素是否被选中

element_located_to_be_selected

# 判断元素的选中状态是否和预期一致,传入参数:定位后的元素,相等返回True,否则返回False

element_selection_state_to_be

# 判断元素的选中状态是否和预期一致,传入参数:元素的定位,相等返回True,否则返回False

element_located_selection_state_to_be

# 判断一个元素是否仍在DOM中,传入WebElement对象,可以判断页面是否刷新了

staleness_of

6.对Cookie操作

cookies 是识别用户登录与否的关键,爬虫中常常使用 selenium + requests 实现 cookie持久化,即先用 selenium 模拟登陆获取 cookie ,再通过 requests 携带 cookie 进行请求。

webdriver 提供 cookies 的几种操作:读取、添加删除。

get_cookies:以字典的形式返回当前会话中可见的 cookie 信息。

get_cookie(name):返回 cookie 字典中 key == name 的 cookie 信息

add_cookie(cookie_dict):将 cookie 添加到当前会话中

delete_cookie(name):删除指定名称的单个

cookie delete_all_cookies():删除会话范围内的所有cookie

from selenium import webdriver

browser = webdriver.Chrome()

# 知乎发现页

browser.get('https://www.zhihu.com/explore')

# 获取cookie

print(f'Cookies的值:{browser.get_cookies()}')

# 添加cookie

browser.add_cookie({'name':'才哥', 'value':'帅哥'})

print(f'添加后Cookies的值:{browser.get_cookies()}')

# 删除cookie

browser.delete_all_cookies()

print(f'删除后Cookies的值:{browser.get_cookies()}')

# 总结

7.高级用法

7.1.execute_script方法

比如下拉进度条,模拟javaScript,使用execute_script方法来实现。

1.1 判断元素是否存在

def is_element_exist(browser,xpath):

try:

element=browser.find_element(by=By.XPATH,value=xpath)

flag=True

except:

flag=False

return flag

1.2 滑动滚轮到页面底端

temp_height=0

x=1000

y=1000

while True:

js="var q=document.getElementsByClassName('cdk-virtual-scroll-viewport')[0].scrollTop={}".format(x)

browser.excute_script(js)

time.sleep(0.5)

x+=y

check_height=browser.excute_script("return document.getElementsByClassName('cdk-virtual-scroll-viewport')[0].scrollTop;")

if check_height=temp_height:

break

temp_height=check_height

1.3 滑动滚轮至页面元素出现

temp_height=0

x=1000

y=1000

while True:

js="var q=document.getElementsByClassName('cdk-virtual-scroll-viewport')[0].scrollTop={}".format(x)

browser.excute_script(js)

time.sleep(0.5)

x+=y

check_height=browser.excute_script("return document.getElementsByClassName('cdk-virtual-scroll-viewport')[0].scrollTop;")

if check_height=temp_height:

break

temp_height=check_height

1.4 滑动至动态元素可见

当我们需要定位的元素是动态元素,或者我们不确定它在哪时,可以先找到这个元素然后再使用JS操作

target = driver.find_element_by_id('id')

driver.execute_script("arguments[0].scrollIntoView();", target)

8.无头浏览器

我们已经基本了解了selenium的基本使用了. 但是呢, 不知各位有没有发现, 每次打开浏览器的时间都比较长. 这就比较耗时了. 我们写的是爬虫程序. 目的是数据. 并不是想看网页. 那能不能让浏览器在后台跑呢? 答案是可以的.

需要导入如下的包附上代码:

from selenium.webdriver import Edge

# 专门处理网页的<Select>标签

from selenium.webdriver.support.select import Select

from selenium.webdriver.chrome.options import Options

from selenium.webdriver.common.by import By

import time

# 设置无头模式

opt = Options()

opt.add_argument("--headless")

opt.add_argument('--disable-gpu')

opt.add_argument("--window-size=4000,1600") # 设置窗口大小

web = Edge(options=opt)

web.get('https://www.endata.com.cn/BoxOffice/BO/Year/index.html')

# 切换select

sel = Select(web.find_element(By.XPATH,'//*[@id="OptionDate"]'))

for i in range(len(sel.options)):

sel.select_by_index(i) # 按照索引位置切换

time.sleep(1)

table = web.find_element(By.XPATH,'//*[@id="TableList"]/table')

print("===========================================")

print(table.text)

9.图鉴

图片识别-广告识别-目标检测-图鉴网络科技有限公司 (ttshitu.com)

import base64

import json

import requests

# 一、图片文字类型(默认 3 数英混合):

# 1 : 纯数字

# 1001:纯数字2

# 2 : 纯英文

# 1002:纯英文2

# 3 : 数英混合

# 1003:数英混合2

# 4 : 闪动GIF

# 7 : 无感学习(独家)

# 11 : 计算题

# 1005: 快速计算题

# 16 : 汉字

# 32 : 通用文字识别(证件、单据)

# 66: 问答题

# 49 :recaptcha图片识别

# 二、图片旋转角度类型:

# 29 : 旋转类型

#

# 三、图片坐标点选类型:

# 19 : 1个坐标

# 20 : 3个坐标

# 21 : 3 ~ 5个坐标

# 22 : 5 ~ 8个坐标

# 27 : 1 ~ 4个坐标

# 48 : 轨迹类型

#

# 四、缺口识别

# 18 : 缺口识别(需要2张图 一张目标图一张缺口图)

# 33 : 单缺口识别(返回X轴坐标 只需要1张图)

# 五、拼图识别

# 53:拼图识别

def base64_api(uname, pwd, img, typeid):

with open(img, 'rb') as f:

base64_data = base64.b64encode(f.read())

b64 = base64_data.decode()

data = {"username": uname, "password": pwd, "typeid": typeid, "image": b64}

result = json.loads(requests.post("http://api.ttshitu.com/predict", json=data).text)

if result['success']:

return result["data"]["result"]

else:

return result["message"]

if __name__ == "__main__":

img_path = "C:/Users/Administrator/Desktop/file.jpg"

result = base64_api(uname='Prorsie', pwd='Maicol7896', img=img_path, typeid=3)

print(result)

10.绕过服务器检测自动化

from selenium.webdriver.chrome.options import Options

# 亲测, 88版本以后可以用.

option = Options()

option.add_experimental_option('excludeSwitches', ['enable-automation'])

option.add_argument('--disable-blink-features=AutomationControlled')

# 亲测, 88版本之前可以用.

# web = Chrome()

#

# web.execute_cdp_cmd("Page.addScriptToEvaluateOnNewDocument", {

# "source": """

# navigator.webdriver = undefined

# Object.defineProperty(navigator, 'webdriver', {

# get: () => undefined

# })

# """

# })

7.简单的反爬虫机制

反爬虫机制:

- 封IP:监控短时间内同一地址的请求次数过大

- 登录及验证码:对于监控后封IP之后短时间内继续的大量请求,要求登陆或验证码通过验证之后才能继续进行。

- 健全账号体制:即核心数据只能通过账号登录后才能进行访问。

- 动态加载数据:数据通过js进行加载,增加网站分析难度。

应对策略:

- 伪造请求头(伪装浏览器):故意告诉浏览器我不是爬虫程序我是浏览器。

- 代理IP访问:针对同一时间内大量请求网站数据遭到封IP,使用代理IP不断更换请求地址,迷惑网站,躲过反制措施。

- 请求过于频繁会触发验证码,则模拟用户操作,限制爬虫请求次数及频率,降低验证码机制的风险

- 使用对应的验证码识别手段通过网站验证

- 使用第三方工具完全模拟浏览器操作(selenium+webdriver)

常见反爬机制1:代理IP

- 定义及作用

- 定义: 代替你原来的IP地址去对接网络的IP地址

- 作用: 隐藏自身真实IP,避免被封

- 获取代理IP的网站

- 西刺代理、快代理、全网代理、代理精灵、… …

- 代理IP的分类

- 透明代理: 服务端能看到 - (用户真实IP 以及 代理IP)

- 普通代理(匿名代理): - (服务端能知道有人通过此代理IP访问了网站,但不知用户真实IP)

- 高匿代理: - (服务端不能看到代理IP)

- 常用代理IP类型的特点

- 普通代理: 可用率低、速度慢、不稳定、免费或价格便宜

- 私密代理: 可用率高、速度较快、价格适中、爬虫常用

- 独享代理: 可用率极高、速度快、价格贵

默认添加:

1、语法结构

proxies = {

'协议':'协议://IP:端口号'

}

2、示例

proxies = {

'http':'http://IP:端口号',

'https':'https://IP:端口号'

}

# 私密代理+独享代理

1、语法结构

proxies = {

'协议':'协议://用户名:密码@IP:端口号'

}

2、示例

proxies = {

'http':'http://用户名:密码@IP:端口号',

'https':'https://用户名:密码@IP:端口号'

}

# 普通代理

import requests

url = 'http://httpbin.org/get'

headers = {

'User-Agent':'Mozilla/5.0'

}

# 定义代理,在代理IP网站中查找免费代理IP

proxies = {

'http':'http://112.85.164.220:9999',

'https':'https://112.85.164.220:9999'

}

html = requests.get(url,proxies=proxies,headers=headers,timeout=5).text

print(html)

# 私密代理

import requests

url = 'http://httpbin.org/get'

proxies = {

'http': 'http://用户名:密码@106.75.71.140:16816',

'https':'https://用户名:密码@106.75.71.140:16816',

}

headers = {

'User-Agent' : 'Mozilla/5.0',

}

html = requests.get(url,proxies=proxies,headers=headers,timeout=5).text

print(html)

代理IP池

'''

思路:

1. 采集免费代理IP:写爬虫、储存在redis

2. 去验证这些ip是否可用:从redis读取到ip简单发送一个请求测试

如果请求可用那就吧IP的score提升

如果请求不可用,那就把IP的score降低

3. 给用户提供可以访问的api接口:提供可用的ip地址

这是三件事,所以需要用到多进程来分别干这些事情

'''

一些默认的设置:可供用户调整

'''

存放配置的地方

'''

# REDIS配置

REDIS_HOST = '127.0.0.1'

REDIS_PORT = 6379

REDIS_DB = 0

REDIS_PASSWORD = '123456'

# REDIS的KEY

REDIS_KEY = 'proxy_ip'

(1)首先解决redis的逻辑问题,这也是最难的一步

- 1.通过init函数建立数据库连接

- 2.在

add_proxy_ip方法中,通过zscore方法判断数据库中是否存在该IP - 3.在

get_proxy_ip方法中,通过zrange方法获取所有IP - 4.在

set_max_score方法中,通过zadd方法设置IP的最高分值(验证成功) - 5.在

desc_score方法中,通过zincrby方法减少分数,如果分数减少到0或以下,通过zrem方法删除IP - 6.在

get_valid_ip方法中,通过zrangebyscore方法获取分数在80到100之间的IP,然后随机选择一个

'''

提供有关redis操作的方法

1.查询

2.新增、增加分数

3.删除

'''

from redis import Redis

# 导入setting里的默认参数

from settings import *

import random

class ProxyRedis(object):

# self.redis 连接

def __init__(self):

self.redis = Redis(

host=REDIS_HOST,

port=REDIS_PORT,

db=REDIS_DB,

password=REDIS_PASSWORD,

decode_responses=True

)

def add_proxy_ip(self,ip):

# 1.判断是否有ip

if not self.redis.zscore(REDIS_KEY,ip):

self.redis.zadd(REDIS_KEY,{ip:10})

print(f'采集到新的IP地址:{ip} ')

else:

print(f'IP地址已存在:{ip}')

def get_proxy_ip(self):

'''获取所有IP'''

return self.redis.zrange(REDIS_KEY,0,-1)

def set_max_score(self,ip):

'''设置有效IP为最高分数'''

self.redis.zadd(REDIS_KEY,{ip:100})

def desc_score(self,ip):

'''减少分数'''

# 1.判断分数、若扣光了,则删除

score = self.redis.zscore(REDIS_KEY,ip)

if score > 0:

self.redis.zincrby(REDIS_KEY,-2,ip)

else:

self.redis.zrem(REDIS_KEY,ip)

def get_valid_ip(self):

'''获取有效IP'''

ips = self.redis.zrangebyscore(REDIS_KEY, 80, 100, 0, -1)

if ips:

return random.choice(ips)

return None

(2)IP采集

'''

负责IP采集

'''

import time

import requests

from lxml import etree

import re

# 导入Redis的类

from ip_redis import ProxyRedis

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/74.0.3729.131 Safari/537.36'}

def get_kuai_ip(url,redis):

resp = requests.get(url,headers=headers)

html = etree.HTML(resp.text)

# 使用XPath找到包含JavaScript数据的<script>标签

script_tag = html.xpath('//script[contains(text(), "var $postBtn")]')

for s in script_tag:

# 提取出IP

ip_list = re.findall(r'"ip": "(.*?)"',s.text)

pors_list = re.findall(r'"port": "(.*?)"',s.text)

if not ip_list and pors_list:

continue

ip = ip_list[0]

port = pors_list[0]

proxy = ip+':'+port

print(proxy)

# 调用redis类的采集方法

redis.add_proxy_ip(proxy)

def run():

red = ProxyRedis()

for u in range(1, 50):

url = 'https://www.kuaidaili.com/free/intr/' + str(u)

get_kuai_ip(url, red)

time.sleep(1)

if __name__ == '__main__' :

run()

(3)IP验证

'''

负责IP的验证工作

'''

from ip_redis import ProxyRedis

import asyncio

import aiohttp

import time

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

async def verify_ip(ip, sem, red):

print(f'开始验证{ip}的可用性....')

timeout = aiohttp.ClientTimeout(total=10)

async with sem:

try:

# 验证IP

async with aiohttp.ClientSession() as session:

async with session.get('https://www.baidu.com/',proxy='http://'+ip,timeout=timeout,headers=headers) as response:

page_source = await response.text()

if response.status in [200,302,301,304]:

# 验证通过

red.set_max_score(ip)

print(f'{ip}验证通过')

else:

red.desc_score(ip)

print(f'{ip}验证失败')

except Exception as e:

red.desc_score(ip)

print(f'{ip}验证有错误',e)

async def main(red):

# 获取所有的IP

all_proxies = red.get_proxy_ip()

sem = asyncio.Semaphore(30)

task = []

for ip in all_proxies:

task.append(asyncio.create_task(verify_ip(ip,sem,red)))

if task:

await asyncio.gather(*task)

def run():

red = ProxyRedis()

# 初始等待

time.sleep(10)

while True:

try:

asyncio.run(main(red))

time.sleep(40)

except Exception as e:

print('在验证IP时出错', e)

time.sleep(10)

if __name__ == '__main__':

run()

主程序:

from ip_collection import run as ip_collection_run

from ip_veryify import run as ip_veryify_run

from ip_redis import ProxyRedis

from msultiprocessing import Process

import requests

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/88.0.4324.150 Safari/537.36'}

def get_proxy():

redis = ProxyRedis()

url = redis.get_valid_ip()

# resp = requests.get(url,headers=headers)

dic = {

'ip': url,

}

proxy = {

'http': 'http://' + str(dic['ip']),

}

return proxy

proxy = get_proxy()

print(f"可用的代理ip:{proxy['http']}")

def run():

p1 = Process(target=ip_collection_run)

p2 = Process(target=ip_veryify_run)

p1.start()

p2.start()

if __name__ == '__main__':

run()

常见反爬机制2:动态页面爬虫技术

控制台抓包思路

-

静态页面

一种常见的网站、网页类型。我们爬虫所关注的特点是:该类网站的一次html请求的response中包含部分或所有所需的目标数据。

注意:静态网页目前来看存在于:

- 确确实实没什么技术含量的小网站…

- 对安全性关注度不高的某些数据,采用静态页面直接渲染出来。

特点:此类静态页面包含的数据对企业或机构来说无关痛痒,即不是那么的重要,而静态页面直接渲染的方式相对来说对技术要求又不高,成本较低,所以直接渲染出来,你爱爬你就爬无所谓

-

动态网页

一种常见的网站、网页类型。此类网页才是WWW中最常见的网页。基本现在但凡是个规模的网站,大部分都采用了动态页面技术。动态页面不会将数据直接渲染在response中,且不会一次刷新就全部加载完毕,而是伴随用户对页面的操作实现局部刷新。

动态页面的核心特点是:

- 数据不会直接渲染于response中;

- 大部分动态页面都会采用AJAX异步请求进行局部刷新;

- 结合以上特点,对响应的数据进行处理,通常采用js进行加载,且处理过程通常伴随着加密。

所以,动态页面在爬取的过程中难度就增大了,不仅要对响应页面做处理,更重要的是要追踪js加载方式甚至追踪js代码,深层次剖析请求及响应的数据体,进而采用Python进行模拟js操作,实现获取真实数据及破解加密。

如何判断一个页面是静态页面还是动态页面?

一般具有以下几个特征的页面,基本就是动态页面了:

- 几乎统一采用json格式字符串传递;

- 往往伴随着用户对网页的某些操作,比如鼠标事件,键盘事件等;

- 几乎无法直接在html的response中直观看到数据;

- html的response中不存在所需数据怎么办?

如果当前页面的html请求的response中不存在所需数据,但elements选项中能够使用re或xpath解析到我们所需要的数据,则所需数据一定是进行了响应处理,则可以通过控制台抓包分析查找所需数据。

控制台抓包分析

- 打开浏览器,F12打开控制台,找到Network选项卡

- 控制台常用选项

- Network: 抓取网络数据包

- ALL: 抓取所有的网络数据包

- XHR:抓取异步加载的网络数据包

- JS : 抓取所有的JS文件

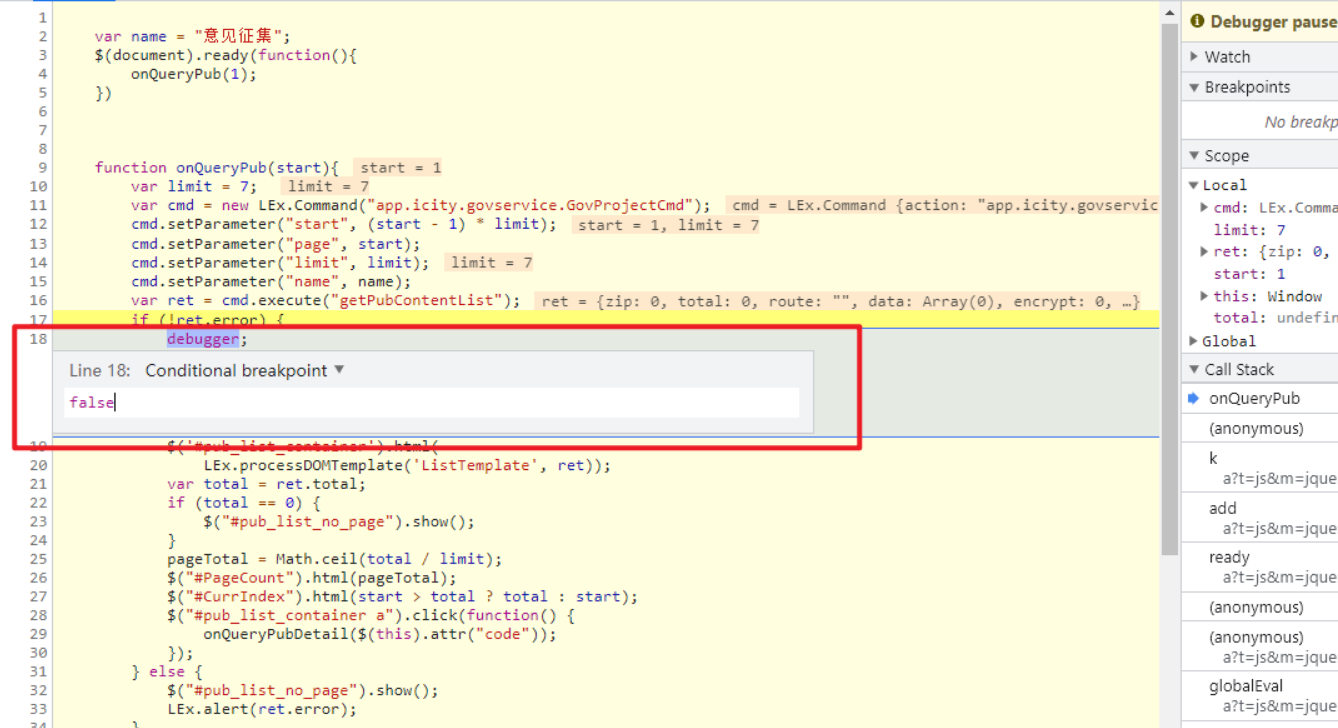

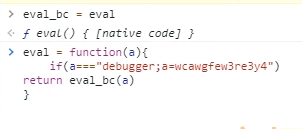

- Sources: 格式化输出并打断点调试JavaScript代码,助于分析爬虫中一些参数

- Console: 交互模式,可对JavaScript中的代码进行测试

- Network: 抓取网络数据包

取具体网络数据包后

- 单击左侧网络数据包地址,进入数据包详情,查看右侧

- 右侧:

- Headers: 整个请求信息:General、Response Headers、Request Headers、Query String、Form Data

- Preview: 对响应内容进行预览

- Response:响应内容

动态加载页面的数据爬取-AJAX

AJAX(Asynchronous JavaScript And XML):异步的JavaScript and XML。通过在后台与服务器进行商量的数据交换,Ajax可以使网页实现异步更新,这意味着可以在不重新加载整个网页的情况下,对网页的某部分进行更新。传统的网页(不使用Ajax)如果需要更新内容,必须重载整个网页页面。又因为传统的数据传输格式使用的是XML语法,因此叫做Ajax。但现如今的数据交互方式,基本上都选择使用JSON格式的字符串,其目的就是为了达到数据传输格式的统一。因为json支持几乎所有编程语言。使用Ajax加载的数据,即使有对应的JS脚本,能够将数据渲染到浏览器中,在查看网页源码时还是不能看到通过Ajax加载的数据,只能看到使用这个url加载的HTML代码。

动态页面数据抓取固定套路

- 请求目标url;

- F12打开控制台进行抓包分析;F12 – network – XHR/JS – 网页操作 – / 查看新增请求项 – 分析数据及规律

- 确定目标数据url/接口

- 发请求,获得response;

- 解析数据(大部分情况下解析的是json数据)

- 持久化存储

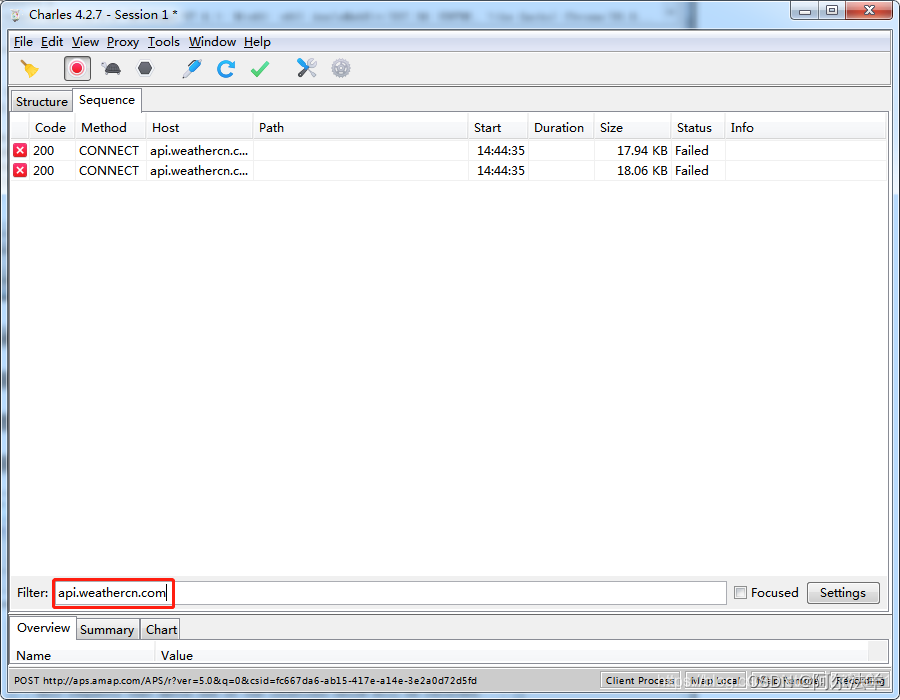

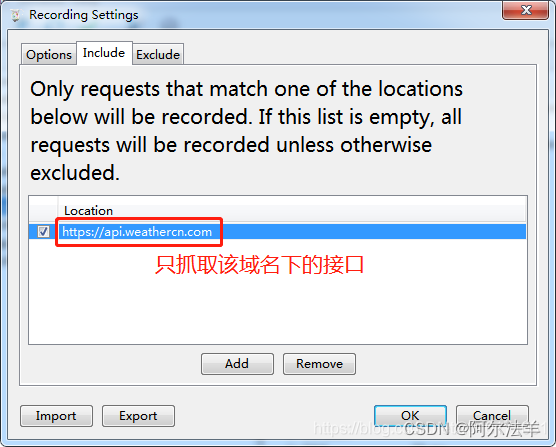

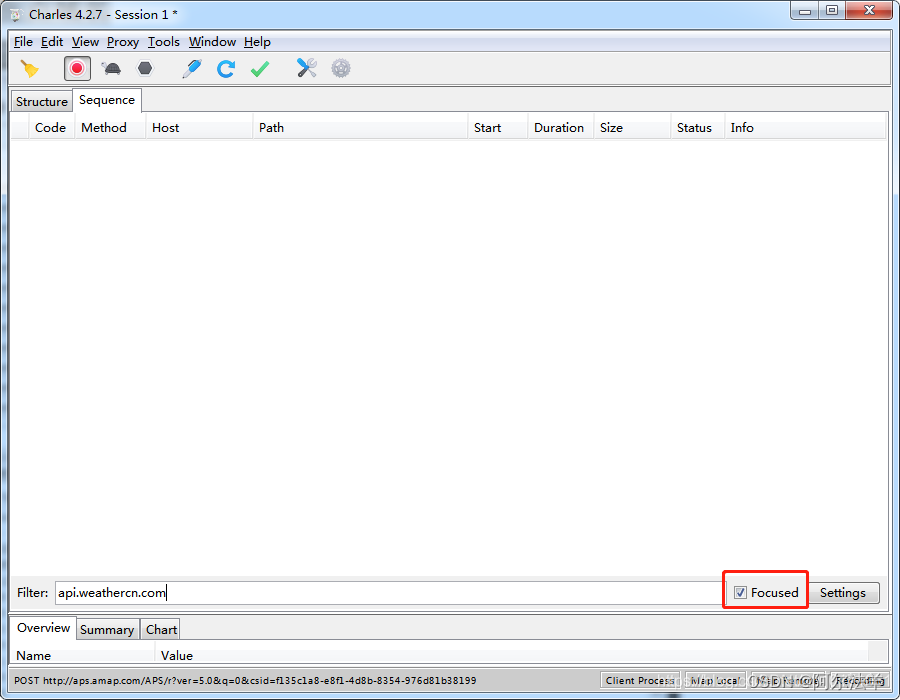

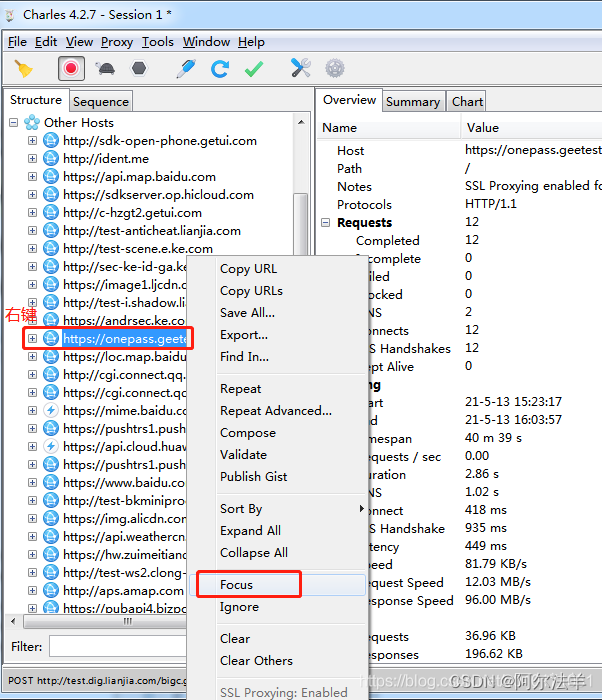

总结:常见基本反制爬虫策略(反爬机制)及处理方式

- Headers反爬虫 :Cookie、Referer、User-Agent

- 解决方案: 在浏览器控制台(F12打开)获取请求头(headers)中的对应参数,通过requests库请求该站点时携带这些参数即可

- IP限制 :网站根据IP地址访问频率进行反爬,短时间内限制IP访问

- 解决方案:

- 构造自己IP代理池,每次访问随机选择代理,经常更新代理池

- 购买开放代理或私密代理IP

- 降低爬取的速度

- 解决方案:

- User-Agent限制 :类似于IP限制

- 解决方案: 构造自己的User-Agent池,每次访问随机选择

- 对响应内容做处理

- 解决方案: 打印并查看响应内容,用xpath或正则做处理

- 动态页面技术:采用AJAX异步加载数据包,增加数据获取难度

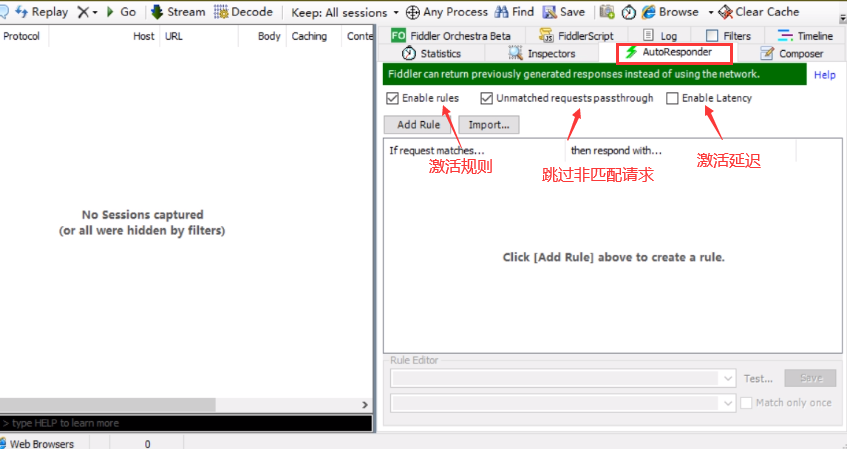

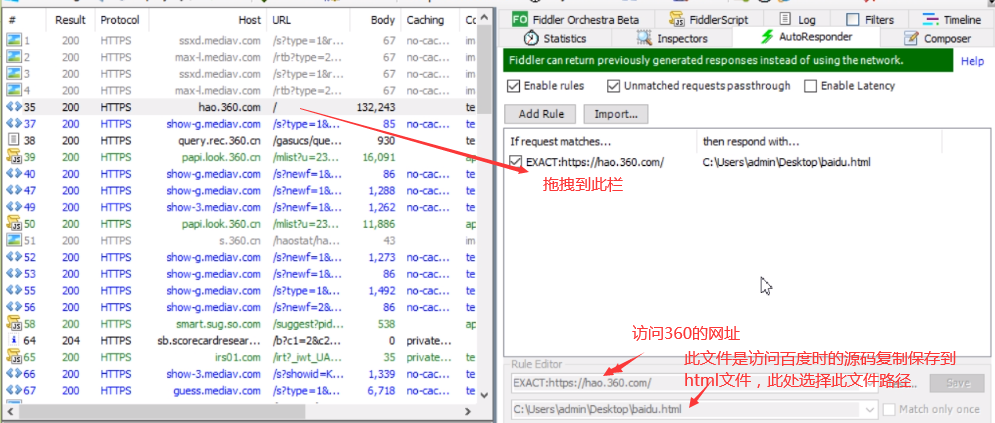

- 解决方案:借助控制台、fiddler或其他抓包工具抓取XHR数据包,分析其请求URL及参数,最终确定所需数据的获取方式

常见处理方法

1. 通过headers字段来反爬

1.1.通过headers中的user-agent字段来反爬

反爬原理:爬虫默认情况下没有user-agent,而是使用模块默认设置

解决方法:请求之前添加user-agent即可,更好的方式是使用user-agent池来解决(收集一堆的user-agent的方式,或者是随机生成user-agent)

import random

def get_ua():

first_num = random.randint(55, 62)

third_num = random.randint(0, 3200)

fourth_num = random.randint(0, 140)

os_type = [

'(Windows NT 6.1; WOW64)', '(Windows NT 10.0; WOW64)', '(X11; Linux x86_64)',

'(Macintosh; Intel Mac OS X 10_12_6)'

]

chrome_version = 'Chrome/{}.0.{}.{}'.format(first_num, third_num, fourth_num)

ua = ' '.join(['Mozilla/5.0', random.choice(os_type), 'AppleWebKit/537.36',

'(KHTML, like Gecko)', chrome_version, 'Safari/537.36']

)

return ua

1.2.通过referer字段或者是其他字段来反爬

反爬原理:爬虫默认情况下不会带上referer字段,服务器通过判断请求发起的源头,以此判断请求是否合法

解决方法:添加referer字段 (表示一个来源,告知服务器用户的来源页面)

1.3.通过cookie来反爬

反爬原理:会话(Session)跟踪是Web程序中常用的技术,用来跟踪用户的整个会话。常用的会话跟踪技术是Cookie与Session。Cookie通过在客户端记录信息确定用户身份,Session通过在服务器端记录信息确定用户身份

- session机制:

-

除了使用Cookie,Web应用程序中还经常使用Session来记录客户端状态。Session是服务器端使用的一种记录客户端状态的机制,使用上比Cookie简单一些,相应的也增加了服务器的存储压力

-

Session是另一种记录客户状态的机制,不同的是Cookie保存在客户端浏览器中,而Session保存在服务器上。客户端浏览器访问服务器的时候,服务器把客户端信息以某种形式记录在服务器上。这就是Session。客户端浏览器再次访问时只需要从该Session中查找该客户的状态就可以了。

-

如果说Cookie机制是通过检查客户身上的“通行证”来确定客户身份的话,那么Session机制就是通过检查服务器上的“客户明细表”来确认客户身份。Session相当于程序在服务器上建立的一份客户档案,客户来访的时候只需要查询客户档案表就可以了

-

**cookie模拟登录适用场景 **: 需要登录验证才能访问的页面

-

cookie模拟登录实现的三种方法

# 方法1(利用cookie) 1、先登录成功1次,获取到携带登陆信息的Cookie(处理headers) 2、利用处理的headers向URL地址发请求 # 方法2(利用requests.get()中cookies参数) 1、先登录成功1次,获取到cookie,处理为字典 2、res=requests.get(xxx,cookies=cookies) # 方法3(利用session会话保持) 1、实例化session对象 session = requests.session() 2、先post : session.post(post_url,data=post_data,headers=headers) 1、登陆,找到POST地址: form -> action对应地址 2、定义字典,创建session实例发送请求 # 字典key :<input>标签中name的值(email,password) # post_data = {'email':'','password':''} 3、再get : session.get(url,headers=headers)方法1(利用cookie)

首先,通过登录获取包含登录信息的Cookie,然后将其包含在headers中向目标URL发请求。

import requests # 1. 登录获取Cookie login_url = "http://example.com/login" login_data = { "username": "your_username", "password": "your_password" } response = requests.post(login_url, data=login_data) # 假设成功登录后,服务器返回的Cookie存储在响应对象的cookies属性中 cookies = response.cookies # 2. 使用获取到的Cookie进行后续请求 url = "http://example.com/protected_page" headers = { "User-Agent": "Mozilla/5.0", "Cookie": f"sessionid={cookies['sessionid']}" } response = requests.get(url, headers=headers) print(response.content)方法2(利用requests.get()中的cookies参数)

通过登录获取Cookie并处理为字典形式,然后在后续请求中使用

cookies参数。import requests # 1. 登录获取Cookie login_url = "http://example.com/login" login_data = { "username": "your_username", "password": "your_password" } response = requests.post(login_url, data=login_data) # 处理为字典形式 cookies_dict = response.cookies.get_dict() # 2. 使用获取到的Cookie进行后续请求 url = "http://example.com/protected_page" response = requests.get(url, cookies=cookies_dict) print(response.content)

-

方法3(利用session会话保持)

使用requests的session对象来保持会话,从而避免在每个请求中手动处理Cookie。

import requests

# 1. 创建session对象

session = requests.session()

# 2. 通过POST请求登录

login_url = "http://example.com/login"

login_data = {

"username": "your_username",

"password": "your_password"

}

headers = {

"User-Agent": "Mozilla/5.0"

}

session.post(login_url, data=login_data, headers=headers)

# 3. 使用session对象进行后续请求

url = "http://example.com/protected_page"

response = session.get(url, headers=headers)

print(response.content)

8.responses模拟请求

responses模块是一个用于测试HTTP请求的Python库。它允许你在不进行实际网络请求的情况下测试和模拟HTTP请求和响应。responses非常适合在单元测试中使用,尤其是当你需要测试与外部API的交互而不想依赖实际的网络请求时

要使用responses库,我们需要:

- 导入

responses库。 - 使用

@responses.activate装饰器来启用模拟。 - 使用

responses.add()方法来添加模拟的请求和响应。

模拟GET请求

import requests

import responses

@responses.activate

def test():

# 模拟一个GET请求

responses.add(

responses.GET, "http://maishu.com/api/data", json={"name": "maishu"}, status=200

)

# 发送实际请求

response = requests.get("http://maishu.com/api/data")

print(response.url)

print(response.status_code)

print(response.json())

if __name__ == "__main__":

test()

============================

http://maishu.com/api/data

200

{'name': 'maishu'}

@responses.activate:这个装饰器用于启用responses库的功能,使其可以拦截和模拟HTTP请求。

responses.add():这个方法用于添加一个模拟的请求和响应。请求方式和响应码也可根据自己需求进行更改。

responses模块还提供了更多高级功能,例如:

模拟不同HTTP方法

你可以模拟各种HTTP方法,如GET、POST、PUT、DELETE等:

@responses.activate

def test_post_example():

responses.add(

responses.POST,

'http://example.com/api',

json={'status': 'success'},

status=201

)

response = requests.post('http://example.com/api', json={'key': 'value'})

assert response.status_code == 201

assert response.json() == {'status': 'success'}

模拟不同状态码

你可以模拟不同的HTTP状态码,以测试你的代码如何处理不同的响应:

@responses.activate

def test_404_example():

responses.add(

responses.GET,

'http://example.com/notfound',

status=404

)

response = requests.get('http://example.com/notfound')

assert response.status_code == 404

模拟延迟响应

你可以模拟延迟响应,以测试你的代码在网络延迟情况下的表现:

@responses.activate

def test_delay_example():

responses.add(

responses.GET,

'http://example.com/delay',

body='Delayed response',

status=200,

adding_headers={'Content-Type': 'text/plain'},

stream=True,

content_type='text/plain',

delay=3 # 延迟3秒

)

response = requests.get('http://example.com/delay')

assert response.status_code == 200

assert response.text == 'Delayed response'

验证请求

你可以验证模拟的请求是否被正确调用:

@responses.activate

def test_request_validation():

responses.add(

responses.GET,

'http://example.com',

json={'message': 'Hello, world!'},

status=200

)

response = requests.get('http://example.com')

assert len(responses.calls) == 1

assert responses.calls[0].request.url == 'http://example.com/'

assert responses.calls[0].response.json() == {'message': 'Hello, world!'}

结论

responses模块是一个强大的工具,可以帮助你在测试中模拟和控制HTTP请求和响应。它允许你在不进行实际网络请求的情况下测试你的代码,从而提高测试的可靠性和速度。通过使用responses,你可以轻松地测试与外部API的交互,确保你的代码在各种网络条件下都能正常运行。

爬虫数据持久化存储

open方法

- 方法名称及参数

**open(file, mode='r', buffering=None, encoding=None, errors=None, newline=None, closefd=True)**

**file** 文件的路径,需要带上文件名包括文件后缀(c:\\1.txt)

**mode** 打开的方式(r,w,a,x,b,t,r+,w+,a+,U)

**buffering** 缓冲的buffering大小, 0,就不会有寄存。1,寄存行。大于 1 的整数,寄存区的缓冲大小。负值,寄存区的缓冲大小为系统默认。

**encoding** 文件的编码格式(utf-8,GBK等)

- 常用的文件打开方式

r 以只读方式打开文件。文件的指针会放在文件的开头。

w 以写入方式打开文件。文件存在覆盖文件,文件不存在创建一个新文件。

a 以追加方式打开文件。如果文件已存在,文件指针放在文件末尾。如果文件不存在,创建新文件并可写入。

r+ 打开一个文件用于读写。文件指针会放在文件的开头

w+ 打开一个文件用于读写。文件存在覆盖文件,文件不存在创建一个新文件。

a+ 打开一个文件用于读写。如果文件已存在,文件指针放在文件末尾。如果文件不存在,创建新文件并可写入。

记忆方法:记住r读,w写,a追加,每个模式后加入+号就变成可读写。

文件的读取及写入

- 读取文件

file.read([size]):读取文件(读取size个字节,默认读取全部)

file.readline()):读取一行

file.readlines():读取完整的文件,返回每一行所组成的列表

- 写入文件

file.write(str):将字符串写入文件

file.writelines(lines):将多行文本写入文件中,lines为字符串组成的列表或元组

csv文件

作用:将爬取的数据存放到本地的csv文件中

- 使用流程

1、导入模块

2、打开csv文件

3、初始化写入对象

4、写入数据(参数为列表)

import csv

with open('film.csv','w') as f:

writer = csv.writer(f)

writer.writerow([])

- 示例:创建 test.csv 文件,在文件中写入数据

# 单行写入(writerow([]))

import csv

with open('test.csv','w',newline='') as f:

writer = csv.writer(f)

writer.writerow(['步惊云','36'])

writer.writerow(['超哥哥','25'])

# 多行写入(writerows([(),(),()]

import csv

with open('test.csv','w',newline='') as f:

writer = csv.writer(f)

writer.writerows([('聂风','36'),('秦霜','25'),('孔慈','30')])

pymysql

常用方法

| 方法 | 说明 |

|---|---|

connect() | 建立与数据库的连接 |

cursor() | 创建一个游标对象 |

execute() | 执行 SQL 语句 |

executemany(sql,values) | 批量执行SQL语句 |

fetchone() | 获取查询结果集的下一行 |

fetchall() | 获取查询结果集的所有行 |