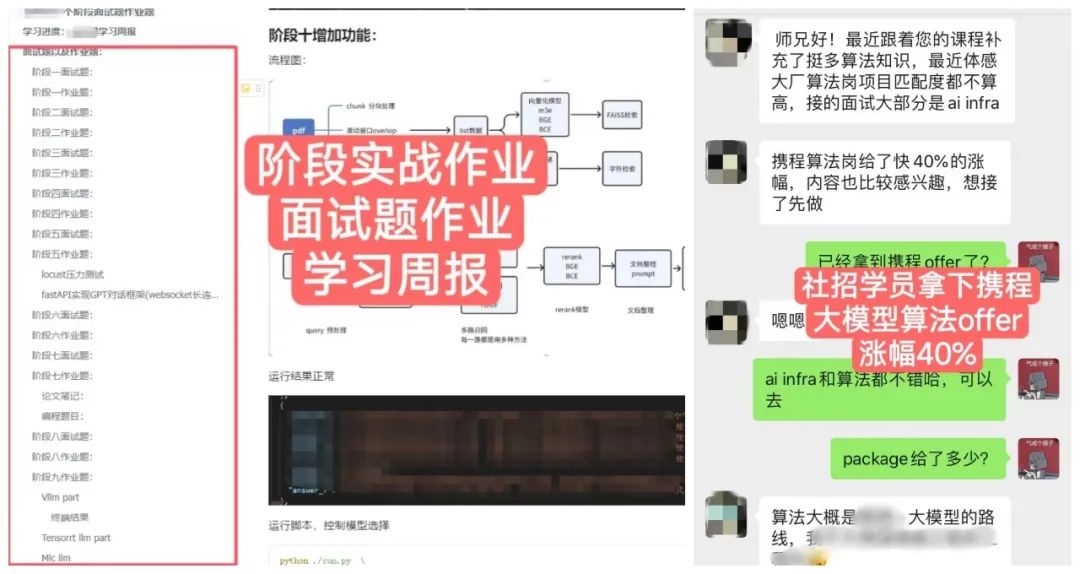

offer捷报

恭喜训练营的一位社招学员拿下携程大模型算法offer,涨幅40%。

太戏剧了!攻击字节训练集群的实习生,居然刚刚获得了 NeurIPS 2024 最佳论文奖?虽然看起来像爽文剧情,但这位高材生接下来的路,应该是难走了。

刚刚,恶意攻击字节训练集群的实习生田柯宇,获得了 NeurIPS 2024 的最佳论文奖。

更巧的是,这篇获奖论文,恰恰就是他在字节商业化技术部门实习期间与团队合作发表的。

甚至,这篇论文还是 NeurIPS 2024 第六高分的论文(7,8,8,8)。

事情在网上曝出的时候,网友们都震惊了:太有戏剧性了,这是什么短剧的大反转剧情!

根据网友的说法,田柯宇的这篇论文也是国内第二篇 NeurIPS Best Paper,含金量很高。

在此之前,他就已经有多篇论文中稿顶会。

比如被引次数最多的「Designing BERT for Convolutional Networks: Sparse and Hierarchical Masked Modeling」,就是 ICLR 2023 的 Spotlight。

此外还有,NeurIPS 2021 和 2020 的 Poster,ECCV 2020 的 Poster。

据新智元了解,字节商业化技术团队早在去年就把视觉自回归模型作为重要的研究方向,团队规划了 VAR 为高优项目,投入研究小组和大量资源。

除了 VAR,团队还发表了 LlamaGen 等相关技术论文,新的研究成果也将在近期陆续放出。

01

事件始末:恶意注入代码,投毒模型训练

回看整件事情,可谓反转又反转。

两个月前,圈内人都被这样一条消息惊掉下巴:「字节跳动大模型训练被北大实习生攻击,损失巨大」。

什么仇什么怨,要做这样的事?

网友们扒出来,事情起因是这位北大高材生在字节实习期间对团队感到不满,一气之下选择了「投毒」。

具体来说,他利用了 Huggingface的load ckpt 函数漏洞,craft 了一个看似正常的 ckpt 文件,但其实是加了 payload 进去,然后就可以远程执行代码,修改参数了。

这种攻击方式,可以通过修改或注入恶意代码,使模型在加载时被篡改模型权重、修改训练参数或截取模型数据。

根据大V「Jack Cui」猜测,这位实习生所用的大概就是这个方法,注入代码动态修改别人的 optimer,修改参数梯度的方向,以及在各种地方随机 sleep 了一小段时间。

修改梯度方向,意味着模型反向传播过程中计算出的梯度被篡改,就导致模型一直朝错误的方向优化;而 sleep 操作,也会明显降低模型训练的速度。

甚至有人提到,该实习生可能修改了自己的预训练模型,因为模型参数是用 ckpt 文件保存的,其他人训练时会加载这个注入恶意代码的 ckpt 文件,因此也会导致模型训练出问题。

就在全网叹为观止之时,田本人却出来「辟谣」称这事和自己没关系——他发完论文后已经从字节离职了,此时有另一个人钻了漏洞修改模型代码,然后趁他离职把锅扣在他头上。

结果一个多月后,此事再一次迎来反转。

有媒体报道称,法院已经正式受理字节跳动对前实习生田某某的起诉。

法院判令田某某赔偿侵权损失 800 万元及合理支出 2 万元,同时要求其公开赔礼道歉。

字节官方也澄清说,涉事实习生破坏的是团队研究项目,并不影响商业化正式项目,也不涉及字节跳动大模型等其他业务。

最终,这位实习生被字节辞退,交由校方处理。

资料显示,田柯宇本科毕业于北航软件学院,研究生就读于北大,师从王立威教授,研究兴趣为深度学习的优化与算法。

自 2021 年起,开始在字节跳动实习研究,具体包括超参数优化、强化学习算法、自监督的新型算法。

超越扩散,VAR 开启视觉自回归模型新范式

这项研究中,他们提出了一种全新范式——视觉自回归建模(Visual Autoregressive Modeling,VAR)。

论文地址:https://arxiv.org/abs/2404.02905

与传统的光栅扫描「下一个 token预测」方法有所不同,它重新定义了图像上的自回归学习,采用粗到细的「下一个尺度预测」或「下一个分辨率预测」。

这种简单直观的方法使得自回归(AR)Transformer 能够快速学习视觉分布,并且具有较好的泛化能力:VAR 首次使得类似 GPT 的 AR 模型在图像生成中超越了扩散 Transformer。

当前,自回归模型(AR)主要用于语言模型从左到右、逐字顺序生成文本 token。

同时,也用于图像生成中,即以光栅扫描的顺序从左到右,从上到下顺序生成图像 token。

不过,这些 AR 模型的 scaling law 未得到充分的探索,而且性能远远落后于扩散模型,如下图 3 所示。

与语言模型所取得成就相比,计算机视觉中的自回归模型的强大能力却被「禁锢」了起来。

而自回归建模需要定义数据的顺序,北大字节团队研究中重新考虑了如何「排序」图像:人类通常以分层方式感知或创建图像,首先捕获全局结构,然后捕获局部细节。

这种多尺度、由从粗到细的本质,为图像提供了一种「秩序」。

同样,受到广泛使用的多尺度设计的启发,研究人员将图像的自回归学习定义为图2©中的「下一个尺度预测」,不同于传统图2(b)中的「下一个 token 的预测」。

VAR 方法首先将图像编码为多尺度的token映射,然后,自回归过程从 1×1token 映射开始,并逐步扩展分辨率。

在每一步中,Transformer 会基于之前所有的 token 映射去预测下一个更高分辨率的 token 映射。

由此,研究人员将此称为视觉自回归建模(VAR)。

VAR 包括两个独立的训练阶段:在图像上训练多尺度 VQVAE,在 token 上训练 VAR Transformer。

第一阶段,多尺度 VQ 自动编码器将图像编码为 K 个 token 映射 R=(r_1,r_2,…,r_K),并通过复合损失函数进行训练。

第二阶段,通过下一尺度预测对 VAR Transformer 进行训练:它以低分辨率 token 映射 ([s],r_1,r_2,…,r_K−1)作为输入,预测更高分辨率的 token 映射 (r_1,r_2,r_3,…,r_K)。

训练过程中,使用注意力掩码确保每个 r_k 仅能关注 r_≤k。训练目标采用标准的交叉熵损失函数,用于优化预测精度。

田柯宇团队在 ImageNet 256×256 和 512×512 条件生成基准上测试了深度为 16、20、24 和 30 的 VAR 模型,并将其与最先进的图像生成模型家族进行比较,包括生成对抗网络(GAN)、扩散模型(Diff.)、BERT 风格的掩码预测模型(Mask.)和 GPT 风格的自回归模型(AR)。

在 ImageNet 256×256 基准测试中,VAR 显著提高了 AR 基准性能,将 Fréchet Inception 距离(FID)从 18.65 降低到 1.73,Inception 得分(IS)从 80.4 提高到 350.2,同时推理速度提高了 20 倍。

如上表所示,VAR 不仅在 FID/IS 上达到了最佳成绩,还在图像生成速度上表现出色。VAR 还保持了良好的精度和召回率,证明了其语义一致性。

这些优势在 512×512 合成基准测试中同样得到了体现。

实验证明,VAR 在多个维度上超越了扩散 Transformer(DiT),包括图像质量、推理速度、数据效率和可扩展性。

VAR 模型的扩展表现出了类似于大语言模型(LLM)的清晰幂律缩放规律,线性相关系数接近 −0.998,这提供了强有力的证据。

VAR 还在下游任务中展示了零样本泛化能力,包括图像修复、图像外延和图像编辑等。

这些结果表明,VAR 初步模仿了大语言模型的两个重要特性:缩放规律和零样本泛化能力。

田柯宇团队已在 GitHub 上发布了所有模型和代码,现已斩获 4.4k 星。

项目地址:https://github.com/FoundationVision/VAR

02

AI 顶会 NeurIPS,录用率 25.8%

NeurIPS 全称神经信息处理系统大会(The Conference on Neural Information Processing Systems),是人工智能(AI)、机器学习(ML)和数据科学领域最负盛名且最具影响力的会议之一。

它于 1987 年首次举办,当时名字是「神经信息处理系统」(NIPS),主要为快速兴起的神经网络领域提供一个交流思想的平台。

随着会议范围逐渐扩大,涵盖了人工智能和机器学习更广泛的主题,会议名称于 2018 年更改为 NeurIPS。

今年,是 NeurIPS 第 38 届年会,将于下周 12 月 9 日-15 日在温哥华召开。

NeurIPS 顶会同样以严格的同行评审过程而著称,2023 年录用率为 26.1%,2022 年为 25.6%。

NeurIPS 历年接收率

今年,顶会一共接受了 15671 篇论文,录用率为 25.8%,其中评审最低分 2.2,最高分 8.7。

具体来说:

-

Oral 61 篇(0.39%)

-

Spotlight 326 篇(2.08%)

-

Poster 3650 篇(23.29%)

如何学习AI大模型 ?

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。【保证100%免费】🆓

CSDN粉丝独家福利

这份完整版的 AI 大模型学习资料已经上传CSDN,朋友们如果需要可以扫描下方二维码&点击下方CSDN官方认证链接免费领取 【保证100%免费】

读者福利: 👉👉CSDN大礼包:《最新AI大模型学习资源包》免费分享 👈👈

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

👉1.大模型入门学习思维导图👈

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

对于从来没有接触过AI大模型的同学,我们帮你准备了详细的学习成长路线图&学习规划。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。(全套教程文末领取哈)

👉2.AGI大模型配套视频👈

很多朋友都不喜欢晦涩的文字,我也为大家准备了视频教程,每个章节都是当前板块的精华浓缩。

👉3.大模型实际应用报告合集👈

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(全套教程文末领取哈)

👉4.大模型落地应用案例PPT👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。(全套教程文末领取哈)

👉5.大模型经典学习电子书👈

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。(全套教程文末领取哈)

👉6.大模型面试题&答案👈

截至目前大模型已经超过200个,在大模型纵横的时代,不仅大模型技术越来越卷,就连大模型相关的岗位和面试也开始越来越卷了。为了让大家更容易上车大模型算法赛道,我总结了大模型常考的面试题。(全套教程文末领取哈)

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习

CSDN粉丝独家福利

这份完整版的 AI 大模型学习资料已经上传CSDN,朋友们如果需要可以扫描下方二维码&点击下方CSDN官方认证链接免费领取 【保证100%免费】

读者福利: 👉👉CSDN大礼包:《最新AI大模型学习资源包》免费分享 👈👈

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?