在深度学习的模型训练过程中,优化算法起着至关重要的作用。RMSProp是一种基于自适应学习率的优化算法,它通过适应性地更新学习率,有效地解决了普通随机梯度下降(SGD)算法中学习率过大或过小的问题。本文将对RMSProp算法进行详细解释,并介绍其工作原理、核心思想、使用方法以及在深度学习中的应用和优势。

第一部分:RMSProp概述

一、概念与定义

RMSProp是一种自适应学习率的优化算法。它通过计算梯度平方的移动平均值来调整学习率,从而为每个参数提供不同的学习率,并在训练过程中自适应地调整。

二、算法原理

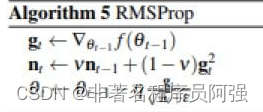

RMSProp算法的核心思想是利用历史梯度的指数衰减平均来自适应地调整学习率。具体步骤如下:

1. 初始化参数:初始学习率、衰减率、小数值常数。

2. 计算梯度:计算当前参数对应的梯度。

3. 更新历史梯度平方的指数加权平均:通过指数衰减平均方法计算历史梯度的平方的移动平均值。

4. 更新参数:根据自适应的学习率公式来更新参数。

第二部分:RMSProp的优势和应用

一、优势

1. 自适应学习率:RMSProp能够自动调整每个参数的学习率,根据其梯度历史信息来合理调整学习速率。

2. 解决学习率过大或过小的问题:RMSProp可以有效地解决学习率过大导致震荡和学习率过小导致收敛缓慢的问题。

3. 具备较好的收敛性和性能:RMSProp通过自适应学习率调整策略,提高了模型的收敛性和泛化能力。

二、应用

RMSProp广泛应用于深度学习中的各个领域,如图像分类、目标检测、语音识别等。它被证明在不同类型的网络和任务中表现出良好的优化性能。

第三部分:RMSProp的使用和调优技巧

一、使用方法

使用RMSProp算法相对简单,只需一些基本的设置和步骤:

1. 初始化:设置初始学习率、衰减率和小数值常数。

2. 计算梯度:使用训练样本计算模型参数的梯度。

3. 更新历史梯度平方指数加权平均:利用指数衰减平均计算历史梯度的平方的移动平均值。

4. 更新参数:使用自适应的学习率公式根据计算的历史梯度平方指数加权平均更新参数。

二、调优技巧

在使用RMSProp算法时,可以尝试以下调优技巧:

1. 调整学习率:根据不同任务和模型的要求,进行合适的学习率设置,以加快收敛并提高性能。

2. 衰减率的选择:通过调整衰减率,可以影响历史梯度平方指数加权平均的忘记程度,从而对学习率进行适当的调整。

3. 分析学习率曲线:通过观察学习率的变化曲线,判断学习率是否合适,可以进一步优化和调整优化算法。

第四部分:总结与展望

本文介绍了RMSProp算法的概念、工作原理、优势、应用以及使用和调优技巧。作为一种基于自适应学习率的优化算法,RMSProp通过考虑参数梯度的历史信息,提供了自适应的学习率,解决了普通SGD算法中学习率过大或过小的问题。RMSProp在深度学习中广泛应用,并具备良好的收敛性和性能。

未来,我们可以进一步研究和改进RMSProp算法,以进一步提高深度学习模型的优化效果。同时,也可以探索其他新的自适应学习率优化算法,以满足不断发展的深度学习需求。深度学习优化算法的研究将继续引领着深度学习的发展,并为我们提供更好的性能和效果。

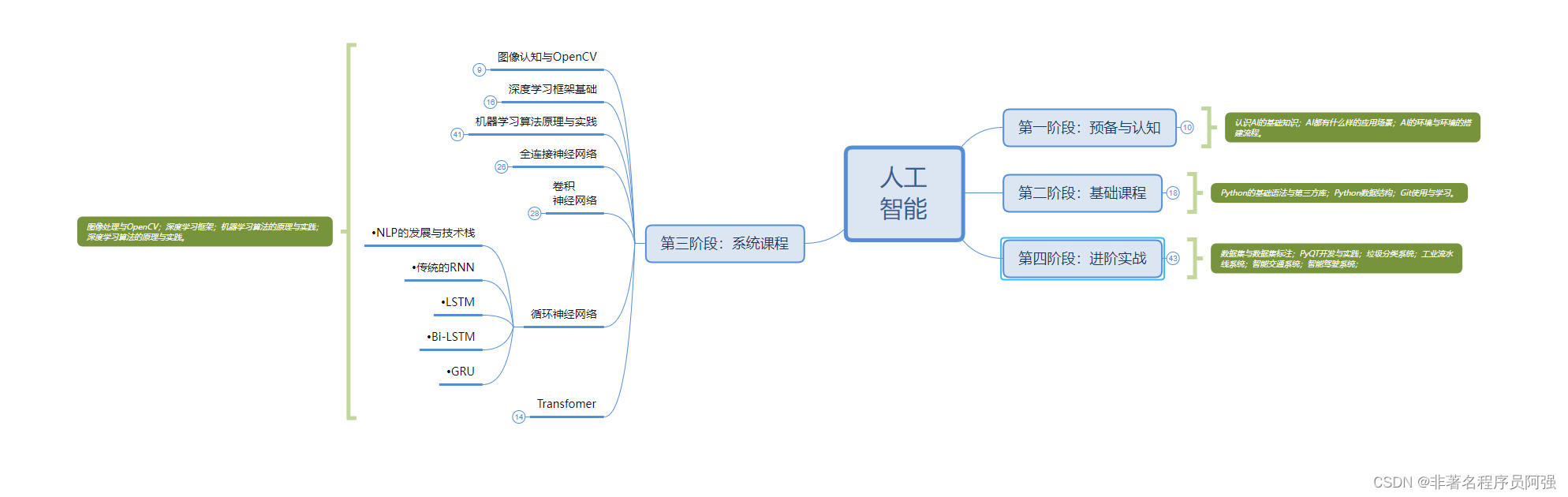

人工智能的学习之路非常漫长,不少人因为学习路线不对或者学习内容不够专业而举步难行。不过别担心,我为大家整理了一份600多G的学习资源,基本上涵盖了人工智能学习的所有内容。点击下方链接,0元进群领取学习资源,让你的学习之路更加顺畅!记得点赞、关注、收藏、转发哦!扫码进群领资料

3195

3195

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?