做过多模态研究的同学都懂那种挫败感,不同模态数据要么“话不投机”,图像的稠密特征和点云的稀疏特征根本无法适配;要么“一损俱损”,SAR图像的斑噪、传感器同步误差会直接搞砸融合结果,想做出稳定又精准的模型难如登天。不过近期ICLR 2025、Information Fusion等成果让人眼前一亮,向量量化、动态交互等新方案彻底打破了这些瓶颈,如今这方向已成自动驾驶、智能感知领域的必争之地。

新方案的核心是精准对齐+智能过滤,国防科大团队提出的VQ双分支架构,用两套码本分别锁定全局语义和局部纹理,把异常噪声直接挡在融合门外,让可见光-SAR融合图的斑点噪声肉眼几乎不可见;而顶会提出的跨模态动态注意力机制,能实时平衡激光雷达与摄像头的特征权重,在Waymo数据集上把3D检测mAP提升了6.7%。在自动驾驶场景中,这类融合模型更是将极端天气下的目标误检率降低41%,比传统后融合方案鲁棒性强太多。

想入局发论文的同学,建议重点盯这几个方向:向量量化的跨模态适配、多传感器时序融合优化、轻量化动态权重架构。为了帮大家少走弯路,我整理了相关顶会/顶刊核心论文,涵盖不同时序任务的实现方案,部分还附带复现代码打包免费送,感兴趣的同学工种号 沃的顶会 扫码回复 “多模态融合” 领取。

Enhanced Cloud Detection Using a Unified Multimodal Data Fusion Approach in Remote Images

文章解析

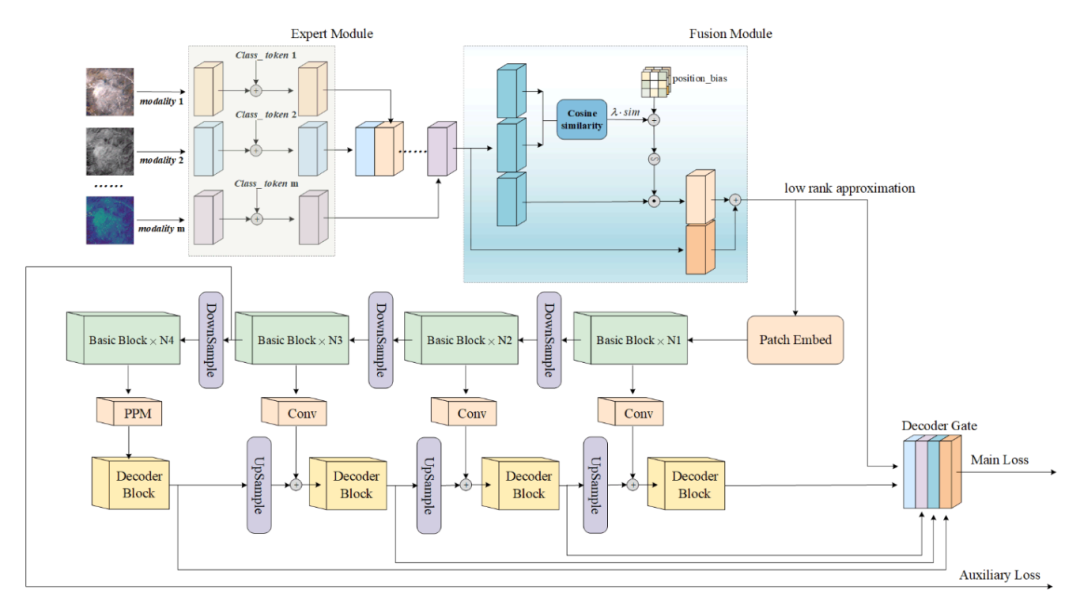

本文提出了一种名为M2Cloud的统一多模态云检测模型,旨在解决多模态云检测任务中网络架构设计复杂和计算效率低下的问题。该模型通过新颖的多模态数据融合方法,实现了对任意数量模态数据的高效处理,并在公共数据集上达到了或超越了现有最佳性能。

创新点

提出了一种新型的多模态数据融合方法,无需为新模态修改网络架构,显著降低了计算成本。

设计的多模态数据融合模块具有强大的泛化能力,能够以即插即用的方式集成到其他网络架构中。

采用余弦相似性自适应学习不同模态间的互补特征,减少冗余信息,提升模型性能。

研究方法

构建了具有共享但独立权重的特征提取模块,为每种模态保留其固有特征。

通过余弦相似性计算不同模态间的互补特征,增强模型对多模态数据的融合能力。

设计了包含CNN和Transformer的混合基础模块作为网络骨干,提升特征提取能力。

引入解码器门控机制,结合浅层特征图作为指导,优化云检测的细节表达。

研究结论

M2Cloud模型在WHUS2-CD和WHUS2-CD+数据集上达到了或超越了现有最佳性能,验证了其在统一多模态云检测任务中的有效性。

多模态融合模块显著提升了模型对复杂场景(如云与冰雪区分)的检测能力,尤其是在降低误检率方面表现出色。

该模型为多模态数据融合和云检测领域提供了新的技术思路和理论支持,具有重要的理论和应用价值,但未来仍需进一步优化计算效率和模型泛化能力。

UniEmbedding:Learning Universal Multi-Modal Multi-Domain Item Embeddings via User-View Contrastive Learning

文章解析

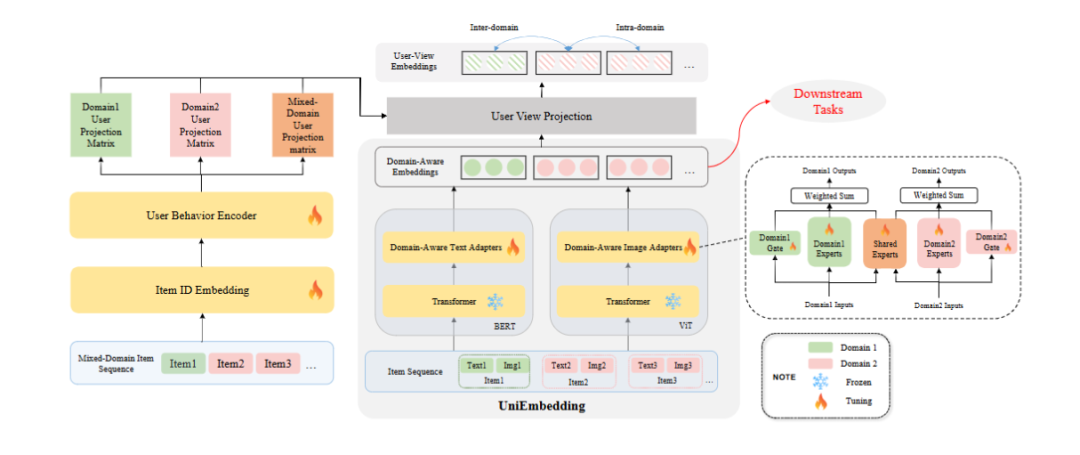

文章提出UniEmbedding预训练框架,旨在学习通用多模态多域物品嵌入。通过实验验证其在匹配和排序任务中的有效性,且已在华为多个推荐应用中部署,为推荐系统发展提供新方向。

创新点

设计领域感知多模态适配器,统一跨域物品表示,兼顾不同领域物品的共性与特性。

引入用户视图投影模块,解耦物品嵌入为全局和用户视图特定表示,提升嵌入针对性。

提出多域对比损失函数,利用跨域和域内协同信号,增强物品嵌入预训练效果。

研究方法

选取公开电商数据集Xmarket和华为内部工业数据集,按9:1划分训练集和测试集。

选择多种基于不同技术的方法作为基线模型,对比评估UniEmbedding性能。

利用预训练模型获取物品多模态嵌入,基于RecBole和FuxiCTR框架构建模型。

采用HR@K、MRR@K、NDCG@K、AUC和logloss等指标评估模型在匹配和排序任务中的表现

研究结论

UniEmbedding在匹配和排序下游任务中性能卓越,优于多种基线模型,通用性强

实验表明用户视图投影模块和多域对比学习损失对提升模型性能有效。

该框架在处理长尾物品和跨域推荐方面表现出色,能显著提升工业推荐系统效果。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?