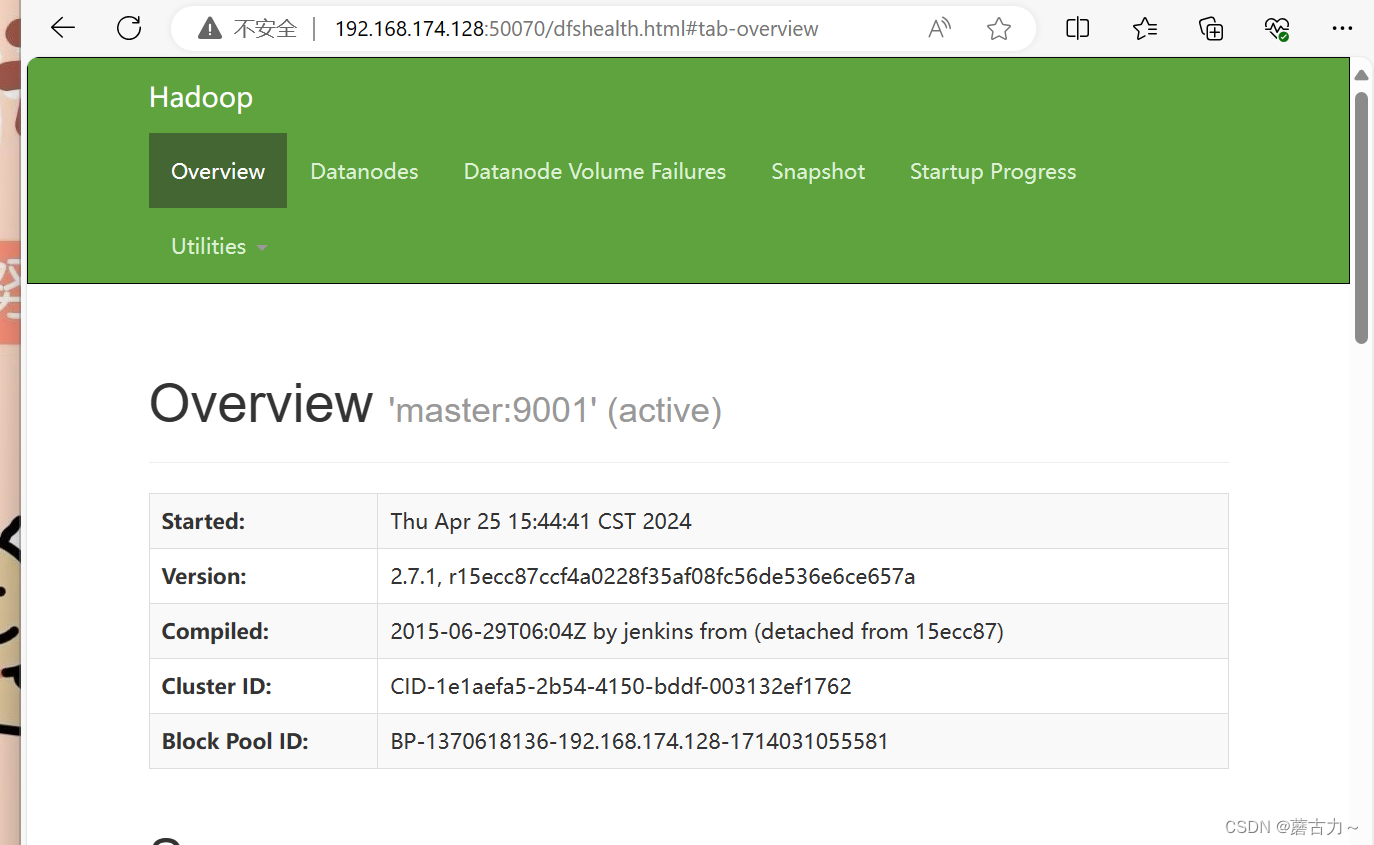

1、这个请看上一篇文章hadoop(先写这个,再看下文)

下载spark和Scala

步骤:

官网网址

scala网址

spark网址

https://dlcdn.apache.org/spark/

可以先下载好Scala与Spark的包

Scala部署与安装

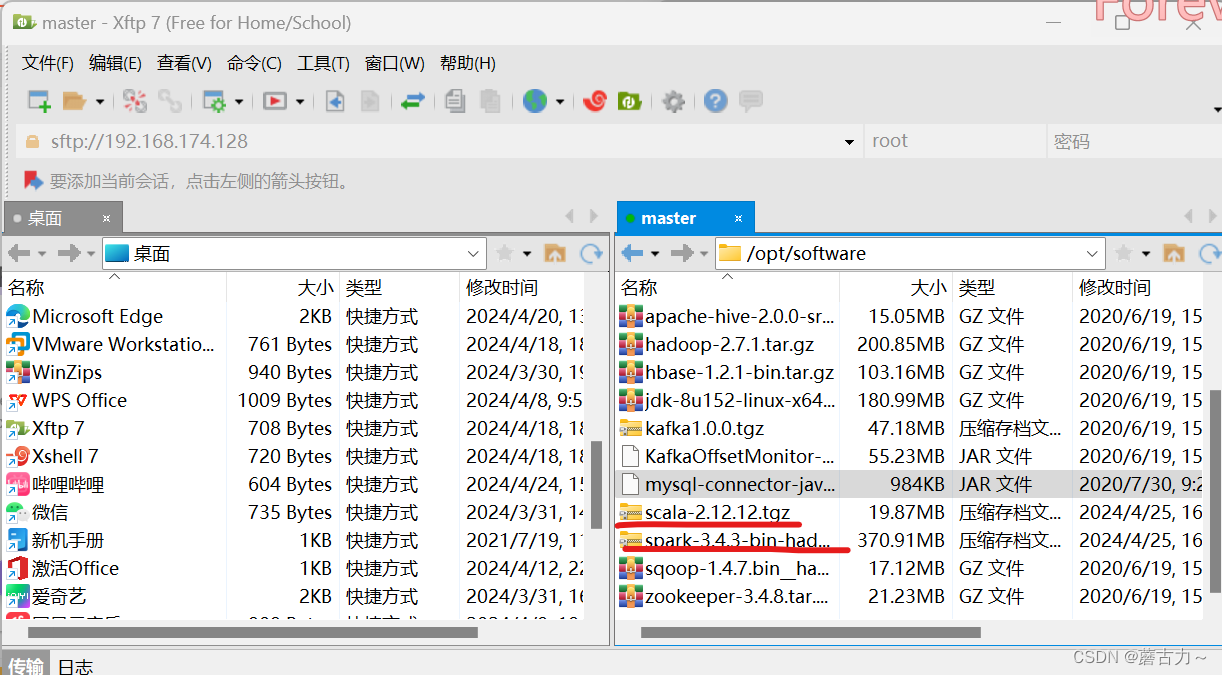

(1)打开xshell,连接虚拟机,找到xftp进行文件传输

然后进行文件的托拽到(/opt/software)目录下,也可以复制哦(可以两个包一起导入)

(2)进入 /opt/software/ 查看是否导入scala、spark包

cd /opt/software/

进去之后可以看到我们的安装包![]()

然后用tar命令解压文件,解压到/usr/local/src/目录下

tar -zxvf /opt/software/scala-2.12.12.tgz -C /usr/local/src/

![]()

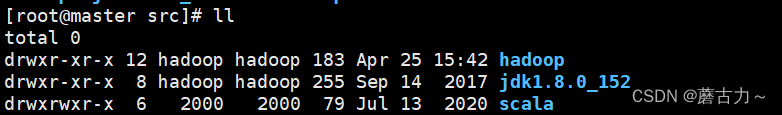

(3)之后就进入/usr/local/src/目录

cd /usr/local/src

进行改名字

mv scala-2.12.12/ scala

![]()

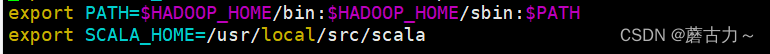

(4)配置scala的环境变量

vim进入 /etc/profile目录

vim /etc/profile

插入俩行配置文件(在最后面,键盘输入“a”,进行插入)

(这要注意路径问题,如果自己的路径与我不一样就需要改成你放Scala的目录下,还有空格的书写)

export SCALA_HOME=/usr/local/src/scala

export PATH=$PATH:${SCALA_HOME}/bin

然后用source重启环境文件

source /etc/profile

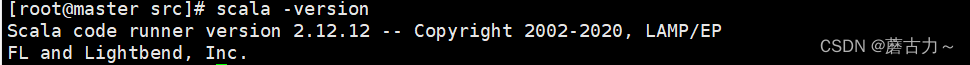

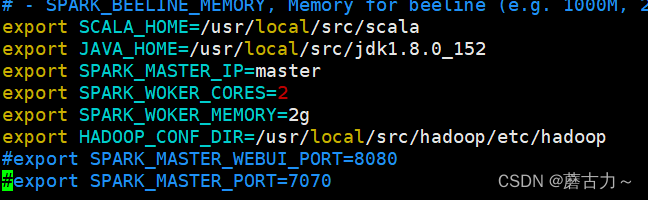

(6)Scala的查看

用version查看

scala -version

输入scala后,看出现一下就说明搭建成功

spark部署与安装

(1)

进入 /opt/software/ 查看是否导入scala、spark包(刚开始就导入包了,这里直接查看)

然后用tar命令解压文件,解压到/usr/local/src/目录下

ll

tar -zxvf /opt/software/spark-3.4.3-bin-hadoop3\ \(1\).tgz -C /usr/local/src/

![]()

把文件名改为spark

mv spark-3.4.3-bin-hadoop3/ spark

![]()

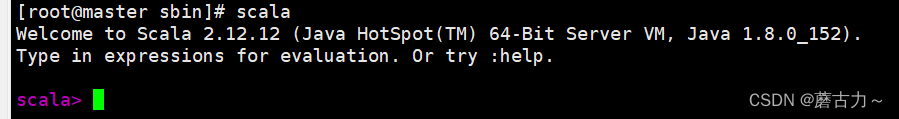

(2)配置spark的环境变量

用vim修改/etc/profile文件

vim /etc/profile

输入环境变量

export SPARK_HOME=/usr/local/src/spark

export PATH=$PATH:${SPARK_HOME}/bin

export PATH=$PATH:${SPARK_HOME}/sbin

保存好后就(重启)source一下配置文件

source /etc/profile

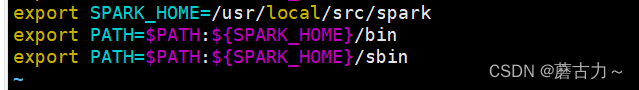

(3)修改配置文件

先备份文件cp spark-env.sh.template文件

进入到/conf目录下

cd /usr/local/src//spark/conf/

备份

cp spark-env.sh.template spark-env.sh

进行配置spark配置文件

vim spark-env.sh

内容:

export SCALA_HOME=/usr/local/src/scala

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

export SPARK_MASTER_IP=master

export SPARK_WOKER_CORES=2

export SPARK_WOKER_MEMORY=2g

export HADOOP_CONF_DIR=/usr/local/src/hadoop/etc/hadoop

#export SPARK_MASTER_WEBUI_PORT=8080

#export SPARK_MASTER_PORT=7070

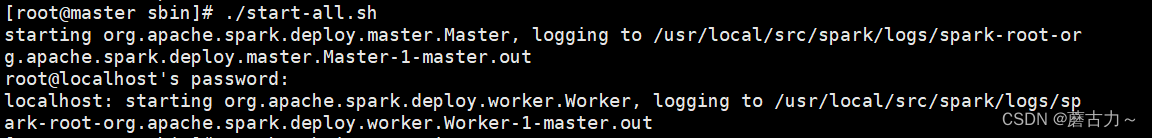

(4)进入spark/sbin 启动spark ./start-all.sh

cd /usr/local/src/spark/sbin

./start-all.sh

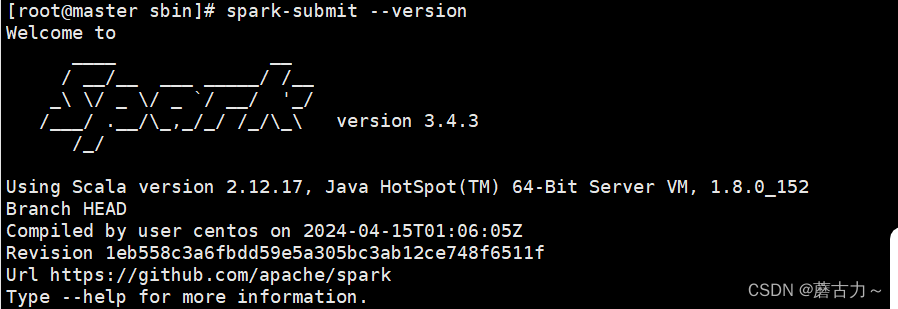

(5)查看spark

spark-submit --version

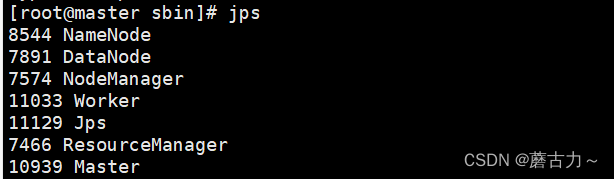

jps命令后,出现Worker与Master说明spark、scala安装成功了并启动了

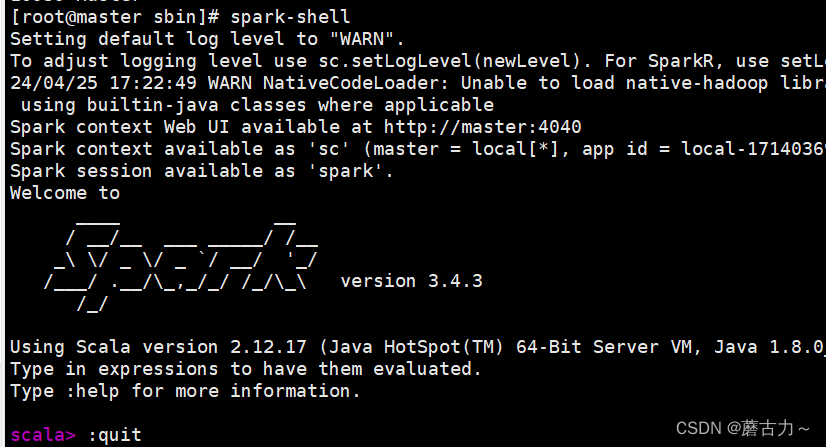

(6)输入spark-shell命令测试

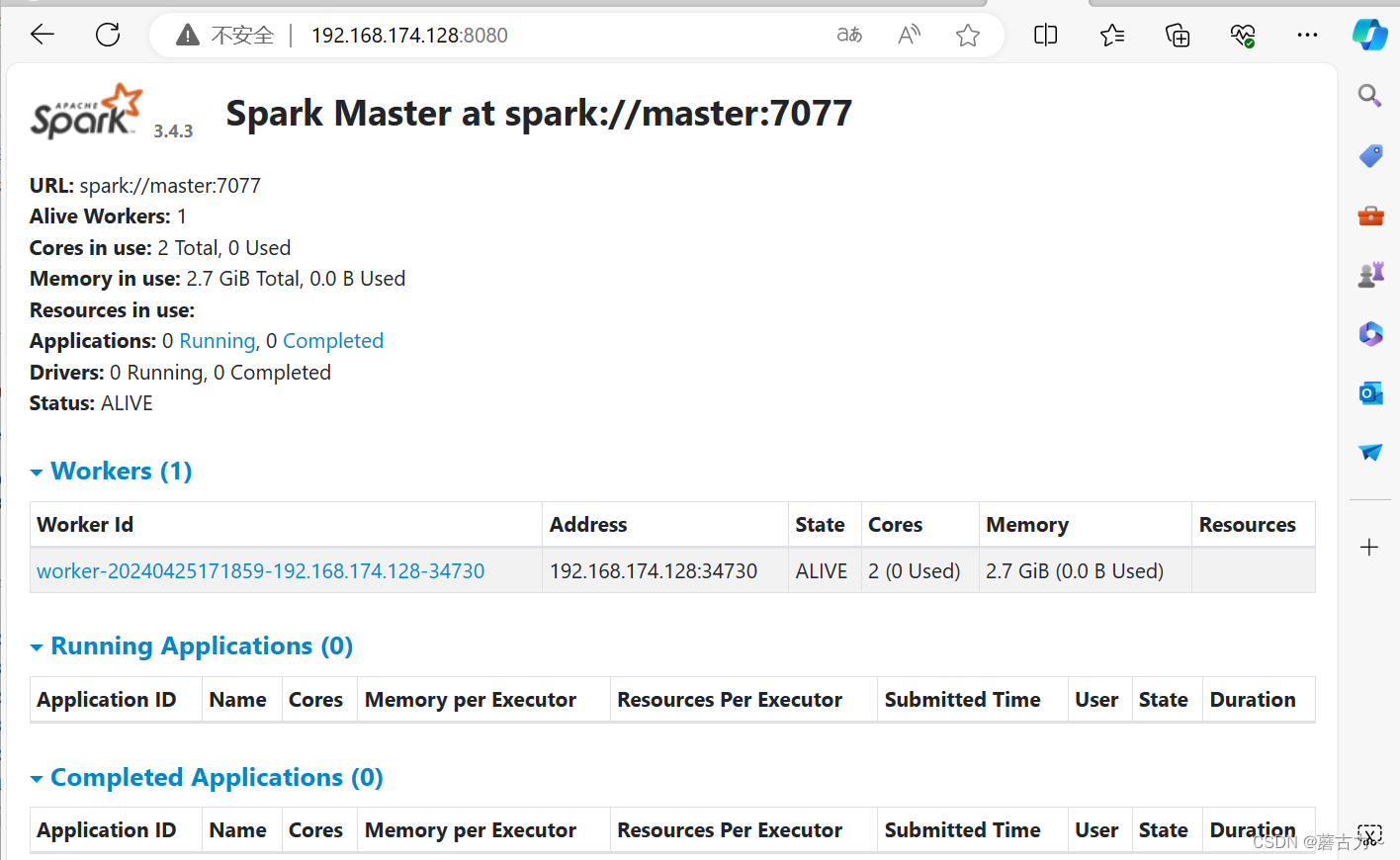

(7)网页访问,输入mastarIP地址+8080端口号

192.168.174.128:8080

本文详细介绍了如何在Linux环境下下载并安装Scala和Spark,包括文件传输、解压、环境变量配置、Spark环境启动和验证的步骤,确保Hadoop和Spark的顺利部署。

本文详细介绍了如何在Linux环境下下载并安装Scala和Spark,包括文件传输、解压、环境变量配置、Spark环境启动和验证的步骤,确保Hadoop和Spark的顺利部署。

8095

8095

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?