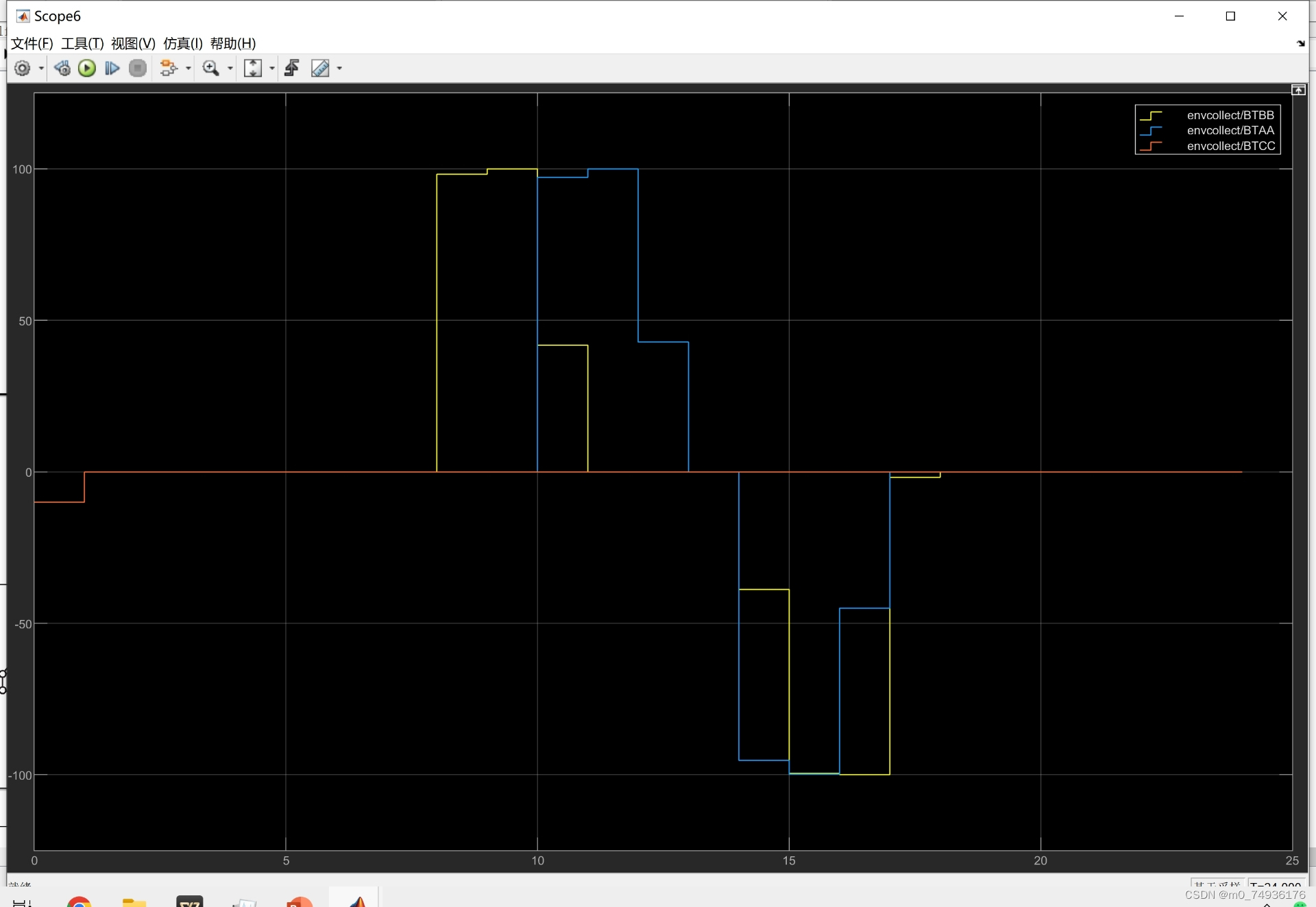

MATLAB代码:p2p 微电网 MADRL 多智体强化学习

关键词:p2p 微电网 MADRL 多智体强化学习 IEEE TSG

参考文档:《Peer-to-Peer Energy Trading and Energy Conversion in Interconnected Multi-Energy Microgrids Using Multi-Agent Deep Reinforcement Learning》2021 SCI一区 IEEE Transactions on Smart Grid 大致复现

仿真平台:MATLAB 2022a起步

主要内容: 主要研究了互联住宅、商业和工业地图地图中的外部P2P能源交易问题和内部能源转换问题。

这两个问题是具有大量高维数据和不确定性的复杂决策问题,因此提出了一种将多智能体行为批评算法与双延迟深度确定性策略梯度算法相结合的多智能体深度强化学习方法。

该方法可以处理高维连续作用空间,并符合具有多模量图的P2P能量交易的性质。

基于三个真实世界的MG数据集的仿真结果表明,该方法显著降低了每个MG的平均每小时运行成本。

同时还考虑了碳税定价的影响。

ID:272000680967893842 电气代码小铺

电气代码小铺

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5722

5722

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?