ai绘画,一个最近半年发展迅速的一个AIGC板块,它的出现,让一个普通人看到把自己喜欢的角色用符合自己偏好(xp)的方式重现出来的希望,所以我陆陆续续学习了一个月的ai绘画。个人在学习过程中,基本要从零碎的教学和信息去学自己想要的相关东西,有时难免觉得麻烦。等到个人感觉学习ai绘画相关的内容差不多入门了,可以基本实现自己想要的图像了,就有了想做一篇相关这种帮助小白入门的文章,包括生成一张自己想要图片一些知识的集合(其中也有初学者会感觉难一点的知识,多看几遍就懂了)。也有自己的一些经验,写这个也算是对自己的一个阶段性总结。

认真看完并且理解的话应该对ai绘画有一个大概的把握,能够实现一定的xp自由(doge),但也只能算是基础教学。个人能力有限,不足之处,欢迎大家指出。使用的是秋葉大大的一键包。

感兴趣的小伙伴,赠送全套AIGC学习资料和安装工具,包含AI绘画、AI人工智能等前沿科技教程,模型插件,具体看下方。

需要的可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

1.最基本实现AI绘画

要画一张画,首先要有一个会画画的画师。在ai绘画这就是checkpoint模型,也就是所说的大模型。然后你得告诉ai你大概想要画面中出现什么元素,也就是你要在相应框里写提示词prompt,内容一般称作tag,当然你也可以用句子描述。然后其它默认,点生成就可以出图了。当然,这一般与你想要的效果差的有点多。想要生成满意的效果,可以先掌握出比较高质量的图的一些设置。

2.画一张比较好的画,以及学会界面上基本设置

在上面基础上,在你的提示词前面加上masterpiece, best quality等一些质量提示词。

在负面提示词加上(bad-artist:1.0), (loli:1.6), (worst quality, low quality:1.4), bad-hands-5, deformed, bad anatomy, disfigured, poorly drawn face, mutation, mutated, extra limb, ugly, disgusting, poorly drawn hands, missing limb, floating limbs, disconnected limbs, malformed hands, blurry, watermark, watermarked, oversaturated, censored, (bloom:1.5),EasyNegative。

(其实网络上有很多这种负面提示词咒语,使用感觉上对手的修复作用都有限,用一个自己觉得好的就行)

其中easynegative是一个embedding模型,后面会介绍。这样基本上不会出古神了,出的图乍看就挺好了,配合加上自己想要元素的tag,就可以一定程度实现想要的效果。但是要实现出自己喜欢的图片,这还只是刚刚开始。

下面正式开始介绍界面的一些按钮选项以及慢慢深入了解sd。

那种一看就懂的界面就不介绍了,先介绍生成按钮下的5个按键作用。

第一个按钮在复制别人参数时也会用到,复制全参到提示词那个框,点第一个按钮就复制好了。第二个按钮就是删除当前框里的所有正负提示词。第三个小红书后面介绍。第四个会配合约预设样式用到,第五个就保存当前正负提示词到预设样式。

预设样式那里可以调用你用第五个按钮保存的一些预设,一键包里也有一个基础起手式预设。点开就是下面这样。

这里是我自己搞的一些预设,有些是记录lora触发词用的

点击预设到上面这样就算是应用上了,点第四个按钮可以复制到提示词框进行修改。

重点说一下5个中间那个小红书,新手使用建议先在这个界面把默认的缩略模式改为卡片,这样方便早期用图片记忆各个模型作用。

改完成卡牌模型就是下面这样

换完后效果是这样

这样也可以更加方便的调用各种模型,点击就可以选用。一开始是没有图片,可以在生成觉得符合这个模型特征的图后,点击如下图相应的地方就可以把图放进去,这样在初期可能不知道哪些模型有什么用,能达到什么效果的时候,卡片模型可以帮助自己理解,当然用的后面熟悉了,模型多了后面还得换回小的缩略模式展示方便使用。

继续介绍一些界面的其他设置

迭代步数是指生成图片迭代多少次,次数越多,要花的时间越多。每次迭代都是在上一次的基础上进行的,第一次从噪点图开始迭代。一般设置在20-30,你的提示词细节越多,就适当设置大一些的迭代次数,但是个人觉得也没必要超过30。

采用方法是选择用什么方式对噪点在潜空间进行处理,常用的就图中四种。个人使用感受图中是,第一种eulur最快,第二种DPM++2M生成二次元图最常用,第三种DPM++SDE用于生成偏真实的图像,第四种没用过。

高清修复意思就对生成的图再进行迭代高清重绘,有些模型在低分辨率的出图效果不佳,特别是在配合lora使用的时候(如脸容易崩),而一般生成原始分辨率不会设置的太高(一方面显卡受不了,另一方面ai训练用的是512x512的图,如果你设置的原始分辨率太高,常常会生成的图有多人。理解成ai要向这个分辨率的画布填东西,大的画布ai会缝合进去更多元素)。所以会常开高清修复出图,迭代步数个人觉得没必要太高,10步左右,重绘幅度选择0.6-0.7之间,太小不利于高清修复,太大对原图修改就多。

下面宽高就是你设置的原始分辨率,也就是上面提到的画布的大小,一般设置成512x768,有些模型作者会说建议使用其它分辨率来更好出图。

总批次数就是显卡多次生成多个图片。单批数量就是显卡一次生成多个图片,生成效率会比前者快,但是显卡性能一般的慎点,一次一张就好。

提示词引导就是提示词对于画面影响的大小,太小提示词基本不起作用,太大不利于ai发挥。总之太大,太小ai出图都不好。新手建议使用5-8。

种子是初始噪点图,会影响ai生成一整张图的走向,如果有一个种子让你的设置生成的图很符合你的要求,可以固定种子,再对提示词等进行微调达到其她想要的效果。

3.简单介绍各种模型及作用。

3.1checkpoint模型

checkpoint模型又称为大模型,可以理解为一个画师,一个有自己画风以及人物与场景风格的赛博画师。比如orangemix2模型,这种模型出的图有那种2.5d偏真实的质感(油油的感觉),细节也精致。petalmix模型就是那种色彩碰撞的蜡画感觉,色彩鲜艳。cetuxmix也有一点偏真实的质感,但是没orange强烈,出图色彩上更鲜艳。color box模型出图色彩十分绚丽,但是出的图手基本都不行。NightSkyYOZORAStyle模型出图细节多,但是需要更多的提示词去控制效果来发挥这个模型的优势。大颗寿司擅长暗夜风格。

3.2 embedding模型

可以理解为一堆tag的集合,一般用于负面提示词去掉不想要的效果。本来你需要写很多负面提示词去让画面整体质感变好,去掉一些不想要的画面效果,现在用一些训练好的embeding模型就能简单的实现更好效果。基本上easynegative这个embedding模型适用于所有大模型,无脑加都行,对一些大模型效果显著(好像就是用那些大模型练的,像orangemix和countfield)。

3.3 hypernetwork模型

基本不用,我到现在都没用过。好像因为实现效果和lora差不多,而lora训练速度快很多,大家基本都去搞lora了。

3.4 lora模型

个人理解为为对大模型这个画师进行了一些电波控制,让生成的人物、风格具有一些明显特征。比如你想生成爱莉希雅那种人物神似的感觉,但是不知道怎么描述爱莉希雅的发型,服装,或者描述了也得不到很好的效果,可以使用相应的lora辅助生成。

给的lora权重低,只是想有点神似

3.5 模型下载

最常用的模型下载网站有c站,资源非常丰富,有很多优秀的的模型(个人使用时突然感受到了一点国外分级制度,13+里有很多优秀的人物模型,但是你得去设置才能看到,这种在国内属于随便就能搜到看到的吧,18+确实是少儿不宜的)。不便科学上网可以使用如下国内的一个网站,现在很多国内的ai炼丹师都会优先在这个网站发模型了,感觉已经做起来一点了。

建议使用模型前都认真看看作者对于模型的一些介绍,帮助了解这个模型的特性。

LiblibAI_中国最大的原创AI模型分享社区www.liblibai.com/

4.了解大模型,根据想要风格选用

上面简单介绍了一下各种大模型大致效果。每个大模型基本都有自己擅长的一些地方,用在不擅长的地方甚至会妨碍效果的生成。所以需要了解这些大模型的特性,去多多尝试以及看作者对大模型的介绍还有其他人使用这个大模型所用的tag。

比如counterfeit模型在生成场景上表现很好,但是生成的场景偏向现实那种真实绘画的场景,对于可能想要生成的比较梦幻的场景这个模型就妨碍了生成那种效果。

橘子模型配合DPM++SDE出图会有二次元偏真实质感,在想生成有很强肉感的人物时比较好用。

大颗寿司则是暗场景十分优秀,喜欢这类风格的可以多试试,一般的模型都是比较明亮的场景。

总之自己有时间多多去尝试。

有些大模型内置的vae是坏的,比如前面说的橘子模型,出图会发灰,需要外加vae去变回正常。所以看得大模型出图发灰的话试着使用8400这个vae去修正。

5.使用lora模型

lora模型有改变人物画风(包括面部,头发,服装等)和改变画面整体效果的效果(比如塔罗牌模型、立绘风模型、封面模型等)。改变人物画风的一般会随着权重加大更改的部分更多,可以先去看看作者对于lora的介绍。

要想知道使用的lora不同权重的可视化效果,可以使用xyz-plot进行设置。点开脚本地方设置成提示词改变,将权重设置成几个英文字母表示,然后在脚本那设置如图,就可以生成lora不同权重下出图的效果。

其实设置0.2,0.5,0.8,1这几个点测试就可以很好知道不同权重效果了

生成的结果可以看到不同权重下对画面的影响,可以简单选择一个自己想要的效果设置权重生成图了

当然xyz-plot这个脚本可以实现的功能还有很多,比如可以设置不同采样器对于图片生成的影响,使用不同提示词替换生成图像等等,这些就看自己需求去开发学习吧。

如果你只想保留lora的服饰特性,又或者想减弱一些lora对于大模型出图风格的影响,只想保留人物特征,甚至如果使用那个lora常常会导致出图一些肢体错误,可以试试lora分层控制去解决这些问题。下面是人物lora一般的各层效果,图当然是别的大佬总结的。

使用方法,先下载一个插件LoRA Block Weight,然后这样,再那样。。。。算了给个视频链接自己去看吧,自己调整步骤比较繁琐,深入认真调整也十分费时费力的感觉,建议简单用一下评论区第一个关于分层控制的设置,多使用理解就大概能知道你使用lora不同层具体控制人物哪些特征。

当你学会后,你会发现,那我把可以生成想要的精致眼睛lora,想要的优秀背景画风lora,想要的优秀人物lora分别设置层权重去控制岂不是是我们无敌想要的效果。然后确实有搞过这个,有大佬甚至使用融合插件把这些调试参数然后融合成一个lora去使用。

再补充关于lora一些简单理解的认识

有些人物lora使用需要有触发词。有些lora不需要提示词,但是为了最大发挥lora效果,需要一些tag来帮助更好生成图像。比如人物拿爱莉希雅那个lora举例,可以试着打出elysia这个tag,可以配合lora更好生成角色形象。

还比如塔罗牌这个lora,为了更好效果,tag上建议加上(tarot:1.6),(themagician(tarot):1.6),这样出的效果就很塔罗牌了,下面有例子。再比如立绘那种画风 ,可以使用[(whitebackgruond:1.6)::5],mid shot 中景,更好的展示立绘那种感觉,下面也有例子。

使用lora难免会对画风有点影响,所以有些lora并不适合每个大模型。有些lora也可能特别适合一些大模型,让出图效果更好。总之,可能对于一个喜欢的lora,你可以使用不同大模型去尝试。

设置(tarot:1.6),(themagician(tarot):1.6),lora:animeTarotCardArtStyleLora_v31:0.4的结果

直接lora:animeTarotCardArtStyleLora_v31:0.4的结果

加了[(whitebackgruond:1.6)::5],mid shot 的效果

不加[(whitebackgruond:1.6)::5],mid shot 的效果

6.进一步了解提示词。

提示词里的内容,可以是一个个单词,词组,也可以是用句子描述(不过实际ai识别的时候也会拆成词组,单词)。建议多用词组,表达想要的元素,也可以适时使用一些句子描述。一般也都是用英文描述,用习惯了也还挺好,有自动补全词组的插件帮助写tag,慢慢也还能学不少词汇。不想前期麻烦的也可以下载另一个插件,可以把中午描述变成英文。

初学可以多看看学别人怎么写提示词的,然后慢慢形成自己的风格,比如先写整体画质元素,镜头,主题。然后是人物动作,情绪,衣服,姿势等要素。最后可以是背景以及次要的一些要素,或者一些光影的辅助要素。

相同画质、主题提示词对于不同大模型影响大小是不同的,比如masterpiece,bestquality对于anythingv5,countfield的生成的画质作用很大,对于color box基本就没作用(作者也有介绍),可能一组整体画质元素的提示词在这个模型表现很好,在另一个模型就表现不行了,特别是二次元和三次元模型之间。一些效果的提示词在不同大模型作用也可能天差地别。也可能你想要的效果模型里压根就没有这个tag,比如中国龙这个tag在一些模型里基本就生成不出来。所以还是得多看看别人使用这个模型出的好图的提示词。

提示词语法。

说一些经常使用的一些语法。

括号:(),提高tag的权重,一个括号是x1.1,两个就是1.21,以此类推。也可以在使用(tag:1.5)这种用法直接加权重。如果你想要的元素没生成出来的时候,可以试着通过加权重让ai生成出来。

标签替换:[tag::15]或[tag::0.2]前面意思是这个tag在迭代的15步就不用了,后面意思表示迭代到进度的20%就不用这tag了,如[whitebackgruond::5]这个经常在生成立绘抽卡那种要有一点白色背景的会经常用。

[tag:tag:0.45]意思是进行到进度的45%从前面一个tag换到后面一个,在那种要生成furry应该可以用到,还有那种有合成特性的形象可以用到,也可以用在头发上实现一些挑染的感觉,越在前面迭代的几步对的画面的影响大。和前面一样是大于1数字的话就是第几步开始换。

[tag:15]则表示迭代15步后才开始使用tag内容迭代。

/()/表示就是括号本来用法的那个意思,而不是权重,比如有很多种lucy,但是我们想要边缘行者的lucy形象,就有lucy/(Cyberpenke)/来具体表达想要的lucy是边缘行者的lucy。

标签轮转:[tag|tag],每次迭代换都换一次提示词用于生成,暂时没想到很好的使用场景。

提示词有时会互相污染,比如头发的颜色可能会跑到别的地方去了。

比如这个我写了blonde hair ,它把一些水的效果也生成了那种颜色。

解决办法可以通过凃乌重绘进行对画面修改,也可以使用一个扩展cutoff来对相应的提示词进行分割,具体想了解就自己去找教程吧(因为本人还没有特别被这个问题困扰,只是了解一些。没用过cutoff,不介绍了)

这里通过局部凃乌重绘修改的效果

7.根据想要的风格配合使用大模型,lora,提示词。

总之,不同大模型有自己的一类风格,lora可以辅助生成特定的人物形象或者一种风格,但是难免会互相影响,有些大模型作者也会推荐使用一些相性好的lora配合使用。选择使用合适的提示词对不同风格的大模型出图也是很重要的,不合适的提示词甚至出不了好图(特别是一些风格明显的提示词,在一些大模型生成一些意向会很好用,但是换一个模型可能就很糟糕),这方面还是得多去看别人的学习别人的。

到后面,基本都会使用lora的,所以多多了解这些还是挺重要的。

8.简单介绍control-net

control-net是一套帮助你更好控制画面的一组工具,里面有各种各样的控制画面效果的组件,比如控制人物姿势的opnepose,还有边缘检测的canny来提取图片线稿,提取图片景深的depth。还有比较新的tile是为了更好的超分重绘而做出来的,现在被一些大佬利用其特性都玩出花来了,还有referrence only配合其他的control-net能实现较好的ai动画效果。简单介绍一个我常用的、新手就可以用的。

openpose

可以控制人物姿态。如果有特别喜欢的姿态可以使用这个去控制,或者你感觉你参数条件下人物动作单一也可以使用这个改变单一的动作。用的时候最好使用相应提示词描述一下那个姿势,帮助出图。

介绍一个网站,基本功能它都有,还可以自己更好的摆一摆微调一下姿势,可以下载到本地作为浏览器的一个插件,所以用这个简单介绍一下用法:

3D Openpose Editorzhuyu1997.github.io/open-pose-editor/?lng=zh

加载一个图片检测姿势

这里最好用一个真实图片检测,准确度会高很多,可以自己给自己拍照上传,这里就用下面那个焰的图简单演示一下。

这个网站也有手甚至脚的depth的control-net图,但是感觉depth这个不算好用,配合openpose要开两个control-net会很慢,而且慢最后跑出来手时常还是不尽人意(毕竟出手好坏很大程度决定于大模型以及使用一些人物lora污染让出手变差程度,如果本来组合出手很难好,用这个控制也比较难获得满意的手部),所以看需求把要不要用吧。感觉用深度图控制生成手用depth library会好方便一些,有兴趣就去b站搜吧,所以这里不介绍depth了。

右上角要设置openpose图的分辨率为你要ai绘图的原始分辨率(这个最好对应上,不然使用难免裁剪掉一些地方)。

上面因为是二次元的图生成,上面这个生成的姿态明显还需要调整。最后经过调整生成的openpose图如下,注意,这个头部分的窄的那边是正面,张开的那两个点是头的后面,不要搞反了。

点开control-net选项,因为这里已经是用网站处理过的图了,所以预处理器选择none,模型选择openpose。如果不用网站用这个自带预处理器就要设置预处理器为openpose,只是这样无法自己微调骨架了。

但是这个战斗姿态比较复杂,很难得到正确的姿势,需要大量抽卡。随便生成的就这样

简单姿势就好控制的多,如

随便就能出姿势,其实这个openpose表示不单一,还可以出背对,只需要在提示词加入looking back等相似提示词就可以转身。

所以总得来说openpose还算是比较简单好用的一个控制器。

其它contro-net还有很多,都有各自的用处,但是个人目前用得不多,也感觉不太适合新手,想学自己去b站搜吧。

9.图生图,以及对图的局部修改

图生图第一个最简单的用法就是对现实照片图生图获得新的图片。比如对自己照片用二次元模型重绘可以生成自己的二次元脸,现实里的超跑图片也可以通过一些二次元的模型图生图来得到二次元版本的超跑。当然都要加上相应的tag。

它的第二个用途就是把文生图中的缺陷进行一定程度的修补,比如当前参数配置下手其实是可以比较好生成的,其中有一个图你特别喜欢,手却差点意思可以试试涂乌重绘或者重绘。如果本来就生成不好手的设置的就不用浪费时间用这个方法修复手了(所以目前修复手的最佳办法可能是用ps自己画手)。

选择原图方式重绘是让ai用新的噪点图重新跑一遍,把涂乌的部分用新的拼回去。仅蒙版的话就是在蒙版区域使用tag进行重绘,一般这个不用在修复而是添加要素上。比如先拿图生图生成一个跑车的二次元图,然后通过仅蒙版的局部重绘加上人物tag给一块画面添加一个赛车手进去。

涂乌重绘比简单重绘多了个可以控制涂乌地方出图的颜色,一定程度可以控制画面,但是目前用来修手也不算好用。用来生成特定颜色的衣物、装饰可能会好一些。

图生图还有一个可能会用的就是把自己满意的一张图再图生图的下面脚本选项里进行放大。在图生图页面才能看到的sd upscale放大,重绘幅度选择0.1-0.3基本不改变原图进行放大(因为这个放大是分几个部分进行放大拼和,它是不理解原本图像内容的,重绘幅度高了它会每个部分都用提示词重新生成一遍,然后拼起来的图片像是受过核打击一样)。现在还有更好用的control-net tile进行放大,它是理解一些原本图像内容的,重绘幅度可以开高一点。

10.最后

我也只能算一个初学者,所以这个教程可能只算是对小白入门有点帮助。越用ai绘画越觉得,ai绘画的水还是有点深的,如果你了解的足够多,你可以通过纯ai绘画得到惊艳的效果。如果你还会ps,会构图,本来就是相关从业者,用ai做出的效果可能就更好了。而且sd里面各种东西发展的也非常快,时不时就有新的插件出现来更好的帮助使用ai出更好的图。不过目前手这个部分对于ai还是难以解决的问题。

真的最后,其实写的时候有几次想放弃的,觉得自己作为初学者,写出来的东西难免有些问题,可能未来更加理解的时候会羞耻于现在写的一些内容。也有时不知道自己到底为什么会花时间学习AI绘画,自己又不是相关从业者。后面和一个人聊天发现,可能我内心有想把自己喜欢的角色具象化出来的欲望,每个人应该都在自己成长经历中获得对一些角色的喜爱。她们可能来自我的童年、少年、以及现在的影视游戏里,有关她们的故事我有美好记忆,有关她们的形象我念念不忘,有关她们的情怀我可能始终如一。不少可能还正在影响着我们对现实中女孩子的喜好。而ai绘画给了我一个机会去实现,一个老二次元,一个游戏爱好者从过往经历中再现我对喜欢角色的一些形象的按自己记忆和喜好再现。这怎么能忍得住不搞。

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

👉[[CSDN大礼包:《StableDiffusion安装包&AI绘画入门学习资料》免费分享]](安全链接,放心点击)

对于0基础小白入门:

如果你是零基础小白,想快速入门AI绘画是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以找到适合自己的学习方案

包括:stable diffusion安装包、stable diffusion0基础入门全套PDF,视频学习教程。带你从零基础系统性的学好AI绘画!

1.stable diffusion安装包 (全套教程文末领取哈)

随着技术的迭代,目前 Stable Diffusion 已经能够生成非常艺术化的图片了,完全有赶超人类的架势,已经有不少工作被这类服务替代,比如制作一个 logo 图片,画一张虚拟老婆照片,画质堪比相机。

最新 Stable Diffusion 除了有win多个版本,就算说底端的显卡也能玩了哦!此外还带来了Mac版本,仅支持macOS 12.3或更高版本。

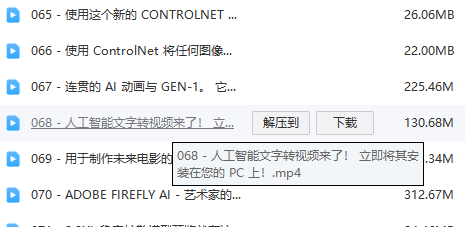

2.stable diffusion视频合集

我们在学习的时候,往往书籍源码难以理解,阅读困难,这时候视频教程教程是就很适合了,生动形象加上案例实战,一步步带你入坑stable diffusion,科学有趣才能更方便的学习下去。

3.stable diffusion模型下载

stable diffusion往往一开始使用时图片等无法达到理想的生成效果,这时则需要通过使用大量训练数据,调整模型的超参数(如学习率、训练轮数、模型大小等),可以使得模型更好地适应数据集,并生成更加真实、准确、高质量的图像。

4.stable diffusion提示词

提示词是构建由文本到图像模型解释和理解的单词的过程。可以把它理解为你告诉 AI 模型要画什么而需要说的语言,整个SD学习过程中都离不开这本提示词手册。

5.SD从0到落地实战演练

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名SD大神的正确特征了。

这份完整版的学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?