Llama-Factory:https://github.com/hiyouga/LLaMA-Factory/tree/main

请使用

--quantization_bit 4/8来启用 QLoRA 训练。

默认模块应作为 --lora_target 参数的默认值,可使用 --lora_target all 参数指定全部模块。 对于所有“基座”(Base)模型,--template 参数可以是 default, alpaca, vicuna 等任意值。 但“对话”(Chat)模型请务必使用对应的模板。

一、单GPU训练

1.预训练

CUDA_VISIBLE_DEVICES=0 python src/train_bash.py \

--stage pt \ # Pre——Training预训练模式

--model_name_or_path path_to_llama_model \ # 模型地址

--do_train \ # 表示进行训练

--dataset wiki_demo \ # 使用的数据集

--finetuning_type lora \ # 微调的方法

--lora_target W_pack \ # LoRA作用模块:Baichuan为W_pack

--output_dir path_to_pt_checkpoint \ # 断点保存:保存模型断点的位置

--overwrite_cache \ # 表示是否覆盖缓存文件

--per_device_train_batch_size 4 \ # 批处理大小:每块 GPU 上处理的样本数量

--gradient_accumulation_steps 4 \ # 梯度累积:梯度累积的步数(节省显存的方法)

--lr_scheduler_type cosine \ # 学习率调节器:采用的学习率调节器名称

--logging_steps 10 \ # 日志间隔:每两次日志输出间的更新步数

--save_steps 1000 \ # 保存间隔:每两次断点保存间的更新步数

--learning_rate 5e-5 \ # 学习率:AdamW优化器的初始学习率

--num_train_epochs 3.0 \ # 训练轮数:需要执行的训练总轮数

--plot_loss \ # 绘制损失函数图

--fp16 # 计算类型:是否启用fp16或bf16混合精度训练。2.指令监督微调

CUDA_VISIBLE_DEVICES=0 python src/train_bash.py \

--stage sft \

--model_name_or_path path_to_llama_model \

--do_train \

--dataset alpaca_gpt4_zh \ # 提示模板:构建提示词时使用的模板

--template default \

--finetuning_type lora \

--lora_target W_pack \

--output_dir path_to_sft_checkpoint \

--overwrite_cache \

--per_device_train_batch_size 4 \

--gradient_accumulation_steps 4 \

--lr_scheduler_type cosine \

--logging_steps 10 \

--save_steps 1000 \

--learning_rate 5e-5 \

--num_train_epochs 3.0 \

--plot_loss \

--fp163.

(1)奖励模型训练

CUDA_VISIBLE_DEVICES=0 python src/train_bash.py \

--stage rm \

--model_name_or_path path_to_llama_model \

--do_train \

--dataset comparison_gpt4_zh \ # 奖励模型训练数据集

--template default \

--finetuning_type lora \

--lora_target W_pack \

--resume_lora_training False \ # 接着上次的LoRA权重训练或创建一个新的LoRA权重

--checkpoint_dir path_to_sft_checkpoint \ # 指令微调模型的断点

--output_dir path_to_rm_checkpoint \ # 奖励模型的输出位置

--per_device_train_batch_size 2 \

--gradient_accumulation_steps 4 \

--lr_scheduler_type cosine \

--logging_steps 10 \

--save_steps 1000 \

--learning_rate 1e-6 \

--num_train_epochs 1.0 \

--plot_loss \

--fp16(2)PPO训练(PPO训练需要先进行上一步RM的训练,然后导入微调后模型和RM进行训练输出)

CUDA_VISIBLE_DEVICES=0 python src/train_bash.py \

--stage ppo \

--model_name_or_path path_to_llama_model \

--do_train \

--dataset alpaca_gpt4_zh \

--template default \

--finetuning_type lora \

--lora_target W_pack \

--resume_lora_training False \

--checkpoint_dir path_to_sft_checkpoint \ # 加载指令微调的断点模型

--reward_model path_to_rm_checkpoint \ # 奖励模型的断点路径

--output_dir path_to_ppo_checkpoint \ # ppo训练的断点输出位置

--per_device_train_batch_size 2 \

--gradient_accumulation_steps 4 \

--lr_scheduler_type cosine \

--logging_steps 10 \

--save_steps 1000 \

--learning_rate 1e-5 \

--num_train_epochs 1.0 \

--plot_loss4.DPO训练(不需要先训练RM,直接导入微调模型进行DPO训练)

CUDA_VISIBLE_DEVICES=0 python src/train_bash.py \

--stage dpo \

--model_name_or_path path_to_llama_model \

--do_train \

--dataset comparison_gpt4_zh \

--template default \

--finetuning_type lora \

--lora_target W_pack \

--resume_lora_training False \

--checkpoint_dir path_to_sft_checkpoint \

--output_dir path_to_dpo_checkpoint \

--per_device_train_batch_size 2 \

--gradient_accumulation_steps 4 \

--lr_scheduler_type cosine \

--logging_steps 10 \

--save_steps 1000 \

--learning_rate 1e-5 \

--num_train_epochs 1.0 \

--plot_loss \

--fp16注:

大规模无监督语言模型(LMs)虽然可以学习广泛的世界知识和一些推理技能,但由于其训练的完全无监督性,因此实现对其行为的精确控制是困难的。现有的获得这种可控性的方法是收集人工对模型生成相对质量的标签,并且通过人类反馈强化学习(RLHF)对无监督的 LM 进行微调,以使其与人类偏好相一致。然而,RLHF 是一个复杂且经常不太稳定的过程,它首先拟合一个反应人类偏好的奖励模型,然后通过强化学习对大型无监督 LM 进行微调以最大化评估奖励,并避免与原始模型相差太远。

在本文中,我们使用奖励函数和最优策略间的映射,展示了约束奖励最大化问题完全可以通过单阶段策略训练进行优化 ,从本质上解决了人类偏好数据上的分类问题。我们提出的这个算法称为直接偏好优化(Direct Preference Optimization,DPO)。它具有稳定性、高性能和计算轻量级的特点,不需要拟合奖励模型,不需要在微调时从 LM 中采样,也不需要大量的超参调节。我们的实验表明了 DPO 可以微调 LMs 以对齐人类偏好,甚至比现有方法更好。值得注意的是,用 DPO 进行微调在控制生成结果的情感以及改善摘要和单轮对话的响应质量方面表现出更好的能力,同时在实现和训练时的难度大大降低。

二、多卡训练

三、模型评估

CUDA_VISIBLE_DEVICES=0 python src/evaluate.py \

--model_name_or_path path_to_llama_model \

--finetuning_type lora \

--checkpoint_dir path_to_checkpoint \

--template vanilla \

--task ceval \

--split validation \

--lang zh \

--n_shot 5 \

--batch_size 4四、模型预测

CUDA_VISIBLE_DEVICES=0 python src/train_bash.py \

--stage sft \

--model_name_or_path path_to_llama_model \

--do_predict \

--dataset alpaca_gpt4_zh \

--template default \

--finetuning_type lora \

--checkpoint_dir path_to_checkpoint \

--output_dir path_to_predict_result \

--per_device_eval_batch_size 8 \

--max_samples 100 \ # 最大样本数:每个数据集最多使用的样本数

--predict_with_generate我们建议在量化模型的预测中使用

--per_device_eval_batch_size=1 --max_target_length 128

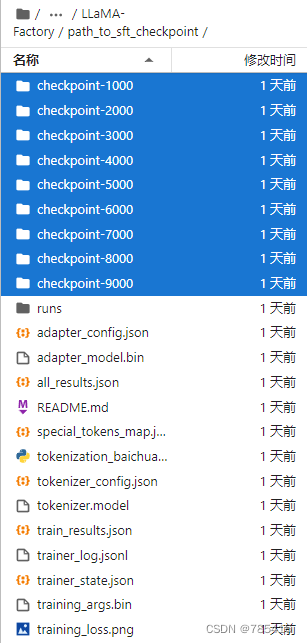

微调训练后生成的文件夹path_to_sft_checkpoint中包括:

1.checkpoint-xxx 间隔固定step生成的模型断点

2.runs 文件夹用于tensorboard可视化训练过程

3.lora adapter模型、配置

4.分词器脚本、配置、模型

5.训练日志

6.loss曲线

tensorboard:

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?