'scrapy' 不是内部或外部命令,也不是可运行的程序

1.刚开始折腾PY 只能记录下每一步。

C:\Users\Administrator>scrapy

'scrapy' 不是内部或外部命令,也不是可运行的程序

或批处理文件。

2.找到具体的scrapy.exe目录

C:\Users\Administrator\AppData\Roaming\Python\Python37\Scripts

3.命令行进入

C:\Users\Administrator>cd C:\Users\Administrator\AppData\Roaming\Python\Python37

\Scripts

C:\Users\Administrator\AppData\Roaming\Python\Python37\Scripts>

4.调出 CMD,输入如下代码并按【Enter】键,创建 Scrapy 爬虫项目:

scrapy startproject iosrule

打印出结果

C:\Users\Administrator\AppData\Roaming\Python\Python37\Scripts>scrapy startproje

ct iosrule

New Scrapy project 'iosrule', using template directory 'C:\Users\Administrator\A

ppData\Roaming\Python\Python37\site-packages\scrapy\templates\project', created

in:

C:\Users\Administrator\AppData\Roaming\Python\Python37\Scripts\iosrule

You can start your first spider with:

cd iosrule

scrapy genspider example example.com

C:\Users\Administrator\AppData\Roaming\Python\Python37\Scripts>

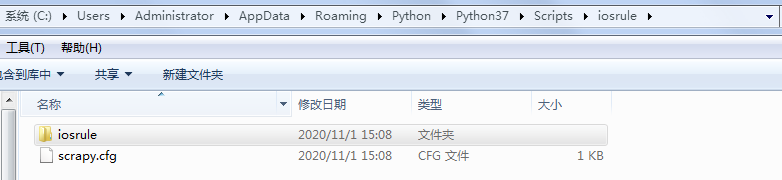

在目录下看到文件夹iosrule

继续点击文件夹,熟悉下里面内容

其中 scrapy startproject 是固定命令,iosrule设置的工程名字。

运行上述代码的目的是创建相应的项目文件,如下所示:

-

放置 spider 代码的目录文件 spiders(用于编写爬虫)。

-

项目中的 item 文件 items.py(用于保存所抓取的数据的容器,其存储方式类似于 Python 的字典)。

-

项目的中间件

-

middlewares.py(提供一种简便的机制,通过允许插入自定义代码来拓展 Scrapy 的功能)。

-

项目的 pipelines 文件 pipelines.py(核心处理器)。

-

项目的设置文件 settings.py。

-

项目的配置文件 scrapy.cfg

制作 Scrapy 爬虫 一共需要4步:

- 新建项目 (scrapy startproject xxx):新建一个新的爬虫项目

- 明确目标 (编写items.py):明确你想要抓取的目标

- 制作爬虫 (spiders/xxspider.py):制作爬虫开始爬取网页

- 存储内容 (pipelines.py):设计管道存储爬取内容

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?