1:

solrcloud集群搭建完毕之后,进入web界面,总是提示there exists no core with name”*”

不要使用IE内核的浏览器

2:

[root@localhost ~]# service mysqld restart

Stopping mysqld: [ OK ]

MySQL Daemon failed to start.

Starting mysqld: [FAILED]

日志

160128 15:12:48 [ERROR] /usr/libexec/mysqld: Can’t create/write to file ‘/var/run/mysqld/mysqld.pid’ (Errcode: 2)

160128 15:12:48 [ERROR] Can’t start server: can’t create PID file: No such file or directory

160128 15:12:48 mysqld_safe mysqld from pid file /var/run/mysqld/mysqld.pid ended

160128 15:19:19 mysqld_safe Starting mysqld daemon with databases from /var/lib/mysql

解决方法

[root@localhost ~]# mkdir /var/run/mysqld

[root@localhost ~]# chown -R mysql:mysql /var/run/mysqld

3:

像这样的错误,一般是磁盘满了 ,尤其是不清除 kafka-logs的

java.lang.InternalError: a fault occurred in a recent unsafe memory access operation in compiled Java code

4:

文件系统检查点已有 1 天,14 小时,36 分钟。占配置检查点期限 1 小时的 3,860.33%。 临界阈值:400.00%。 自上个文件系统检查点以来已发生 14,632 个事务。

2个可能;

1 , namenode的Cluster ID 与 secondnamenode的Cluster ID 不一致,对比/dfs/nn/current/VERSION 和/dfs/snn/current/VERSION中的Cluster ID 来确认,如果不一致改成一致后重启应该可以解决。

2,修改之后还出现这个状况,查看secondnamenode 日志,报

ERROR: Exception in doCheckpoint java.io.IOException: Inconsistent checkpoint field

这个错误,直接删除 /dfs/snn/current/下所有文件,重启snn节点

5:

还有个Hive Metastore 检查错误什么的,具体忘记是什么了,

查看Service Monitor 日志,原因是amon库出问题了,直接删除amon下所有表,重启服务 ,OK

6:

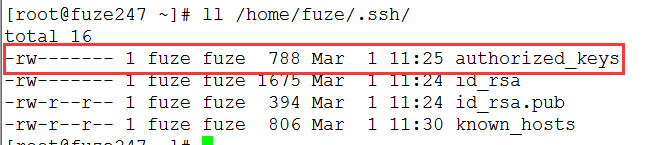

用root外用户做ssh

这个文件权限必须为600

7:

cdh 出现问题

chkconfig –list| grep cloudera

sudo service cloudera-scm-agent restart、

sudo service cloudera-scm-server restart、

sudo service cloudera-scm-server-db restart

也可能是资源没了

8:

HA 出现的问题

格式化zookper集群,重新生成HA集群信息

hdfs zkfc -formatZK

9:

10:34:20,942 ERROR [UsersRolesLoginModule] Failed to load users/passwords/role files

java.io.IOException: No properties file: users.properties or defaults: defaultUsers.properties found

System.setProperty(“zookeeper.sasl.client”, “false”);

10:

参考

-Xms16g -Xmx16g -Xmn2g -XX:+UseParNewGC -XX:+UseConcMarkSweepGC -XX:+UseCMSCompactAtFullCollection -XX:CMSFullGCsBeforeCompaction=15 -XX:CMSInitiatingOccupancyFraction=70 -verbose:gc -XX:+PrintGCDetails -XX:+PrintGCDateStamps -Xloggc:/var/log/hbase/gc-hbase.log -XX:OnOutOfMemoryError=”kill -9 %p” -XX:ErrorFile=”/var/log/hbase/hs_err_pid%p.log”

11:

我就在生产环境就碰到了个诡异的问题: org.apache.oozie.action.Hadoop.LauncherException: Output data exceeds its limit [2048]

查找了一下原因,Oozie默认最大输出的数据大小为2K,即2048B;而在hive action中,执行hql脚本时提交的MR作业的ID(比如job_1464936467641_1657)均会被记录下来并且返回给Oozie,如果在一个hql脚本中,hive查询语句过多将会导致Oozie收到的结果数据超过2k大小,于是就抛这个错误。解决办法, 添加如下配置到Oozie-site.xml中,重启Oozie服务生效:

oozie.action.max.output.data

204800

PS:如果是CDH搭建的集群,那么可以在 集群->Oozie->配置->Oozie Server Default Group->高级->oozie-site.xml 的 Oozie Server 高级配置代码段(安全阀)中添加上述配置。

2428

2428

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?