1.在使用Spark on YARN模式时,发现作业提交缓慢

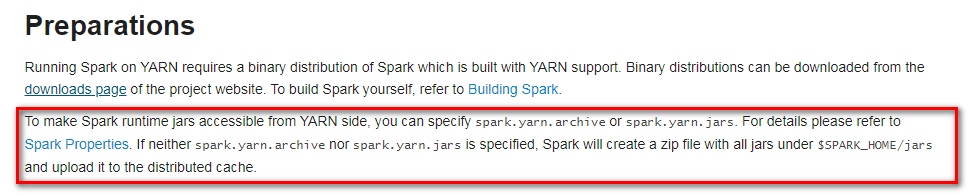

通过官网描述:

也就是说,:如果想要在yarn端(yarn的节点)访问spark的runtime jars,需要指定spark.yarn.archive 或者 spark.yarn.jars。如果都这两个参数都没有指定,spark就会把$SPARK_HOME/jars/所有的jar上传到分布式缓存中。这也是之前任务提交特别慢的原因。

./spark-submit \

--class org.apache.spark.examples.SparkPi \

--master yarn \

/home/hadoop/app/spark-2.4.4-bin-2.6.0-cdh5.15.1/examples/jars/spark-examples_2.11-2.3.1.jar \

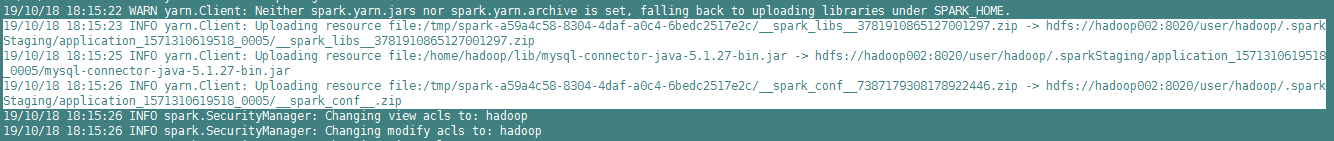

3查看日志发现:

[hadoop@hadoop002 bin]$ hdfs dfs -ls hdfs://hadoop002:8020/user/hadoop/.sparkStaging/application_1571310619518_0005

Found 3 items

-rw-r--r-- 1 hadoop supergroup 223291 2019-10-18 18:15 hdfs://hadoop002:8020/user/hadoop/.sparkStagi

在Spark on YARN模式下,作业提交缓慢,原因是Spark默认会上传所有$SPARK_HOME/jars的依赖。为解决此问题,可以设置`spark.yarn.archive`或`spark.yarn.jars`,指向HDFS上的jar包,避免大量jar上传导致的延迟。按照官方建议操作后,日志中不再显示上传库的提示,从而提升任务提交速度。

在Spark on YARN模式下,作业提交缓慢,原因是Spark默认会上传所有$SPARK_HOME/jars的依赖。为解决此问题,可以设置`spark.yarn.archive`或`spark.yarn.jars`,指向HDFS上的jar包,避免大量jar上传导致的延迟。按照官方建议操作后,日志中不再显示上传库的提示,从而提升任务提交速度。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?