随着人工智能(AI)和深度学习领域的快速发展,训练大规模深度学习模型已成为推动技术进步的关键。然而,在训练这些庞大模型时,硬件加速的作用尤为重要。传统上,NVIDIA的CUDA(Compute Unified Device Architecture)平台是深度学习加速的“行业标准”,几乎所有主流的深度学习框架都依赖于CUDA进行高效的计算支持。然而,DeepSeek作为一个创新的平台,打破了这一依赖,采用自研的硬件加速方案,绕过了CUDA,并提供了一种更加灵活、高效且低成本的解决方案。

为什么DeepSeek选择绕过CUDA?

尽管CUDA在深度学习领域已被广泛采用,但它并不是没有问题。DeepSeek选择绕过CUDA,并实现自研的硬件加速方案,背后有几个重要的原因。

1. 多硬件支持与兼容性

传统的深度学习硬件加速器主要依赖于NVIDIA的GPU,但随着AI硬件的发展,TPU(Tensor Processing Unit)、FPGA(Field-Programmable Gate Array)、以及其他定制化AI芯片逐渐崭露头角。通过绕过CUDA,DeepSeek能够支持多种硬件加速器,包括但不限于NVIDIA的GPU、Google的TPU以及国内的定制芯片。与其锁定在单一的硬件供应商上,DeepSeek能够提供更加开放的平台,支持硬件的多样性,并对特定硬件进行优化。

例如,TPU是Google专为深度学习设计的硬件,而TPU并不使用CUDA。DeepSeek的硬件架构也支持类似的定制硬件,使得DeepSeek能够在不同硬件平台上进行高效的训练,避免对NVIDIA硬件的依赖。

2. 自主优化与低成本

CUDA虽强大,但其框架的抽象层较为复杂,且硬件和驱动的优化往往受到厂商的限制。DeepSeek通过避开CUDA,能够深入到硬件的底层,从操作系统架构层面进行优化。自研的硬件加速方案为DeepSeek提供了更高的灵活性,使其能够根据具体硬件的特性进行优化——例如,针对处理单元的优化、内存带宽的管理以及数据传输效率的提高。最终,这些优化帮助DeepSeek降低了训练大规模模型时的硬件成本。

3. 避免硬件锁定与平台依赖

CUDA是NVIDIA专有的编程框架,它在某种程度上将开发者“锁定”在NVIDIA的硬件和软件生态中。DeepSeek选择绕过CUDA,避免了这种硬件锁定。这种策略使得DeepSeek不仅能够在NVIDIA的GPU上运行,还可以在其他硬件平台(如AMD GPU、TPU和国产芯片)上优化性能。这为开发者提供了更大的自由度,可以根据预算和需求选择最合适的硬件平台,而不必受到单一硬件供应商的限制。

4. 提升性能与灵活性

DeepSeek能够根据具体任务的需求灵活选择最合适的硬件进行加速计算。例如,在训练一个超大规模的模型时,DeepSeek可以根据模型的大小、数据传输的要求以及硬件资源的使用情况,智能地选择不同的硬件进行计算。通过这种“软硬分离”的设计,DeepSeek能够最大化硬件的性能,提升计算效率。

DeepSeek的硬件加速架构

DeepSeek通过自研的计算调度和优化引擎,打破了对CUDA的依赖,并为深度学习提供了更加灵活的加速方案。其硬件加速架构包括以下几个关键组成部分:

1. 硬件抽象层(HAL)

DeepSeek的硬件抽象层(HAL)屏蔽了不同硬件平台的底层细节,无论是NVIDIA、AMD、TPU,还是国产AI芯片,都可以通过统一的接口进行调用。HAL负责管理不同硬件架构的底层资源,并提供高效的计算资源调度,确保深度学习任务能够充分利用不同硬件的计算能力。

2. 并行计算调度引擎

DeepSeek的并行计算调度引擎通过智能化的调度算法,根据任务的需求将计算任务合理分配到不同的计算单元。调度引擎考虑了计算负载、数据传输带宽、硬件资源的使用情况等多个因素,确保硬件资源得到最大化的利用。

3. 自适应优化算法

为了在训练大规模深度学习模型时保证高效的计算和资源利用,DeepSeek引入了自适应优化算法。这些算法根据模型的规模、计算需求、内存管理等动态调整计算精度和内存使用策略,提升了整体计算性能,并有效减少了硬件资源的消耗。

4. 自研加速库

DeepSeek不仅绕过CUDA,还开发了自研的硬件加速库。与CUDA标准库相比,DeepSeek的加速库更加针对深度学习任务的计算需求进行了优化,支持不同硬件平台的高效计算。这些加速库通过对深度学习中的关键计算任务(如矩阵运算、卷积操作等)进行深度优化,进一步提升了训练效率。

避开CUDA的实际案例

尽管CUDA是深度学习领域的主流平台,越来越多的公司开始探索绕过CUDA的替代方案,以降低对NVIDIA的依赖并提升硬件的多样性。以下是几个避开CUDA的典型案例。

1. Google TPU的独立架构

Google的TPU(Tensor Processing Unit)是专为深度学习设计的加速器,特别适用于TensorFlow框架。尽管TensorFlow本身支持CUDA,但TPU有自己独立的硬件架构,完全绕过了CUDA。TPU的专用接口直接与硬件进行交互,实现了高效的深度学习训练。

关键点: 通过TPU,开发者可以在无需CUDA支持的情况下实现深度学习加速。这种做法使Google的硬件架构能够更好地与其深度学习框架配合,避免了对NVIDIA硬件的依赖。

2. AMD ROCm(Radeon Open Compute)

AMD推出的ROCm平台是一个为其GPU提供开源计算支持的框架。ROCm平台提供类似于CUDA的API接口,并且支持如TensorFlow和PyTorch等深度学习框架。它允许开发者利用AMD的GPU进行高效的深度学习计算,而无需依赖NVIDIA的CUDA。

关键点: ROCm平台的推出意味着开发者可以使用AMD的GPU进行训练,而不必绑定于NVIDIA的硬件和软件生态。ROCm是一个绕过CUDA的实际解决方案。

3. Facebook的LibTorch与Folly

Facebook的LibTorch(PyTorch的C++版本)与底层库Folly也采取了类似的做法。在某些内部实验性硬件平台上,Facebook没有依赖CUDA,而是通过自定义的加速库直接与硬件进行交互,从而绕过了CUDA。

关键点: 这种做法展示了如何通过将硬件与深度学习框架紧密集成,避免了CUDA的局限性,从而获得更高的计算效率。

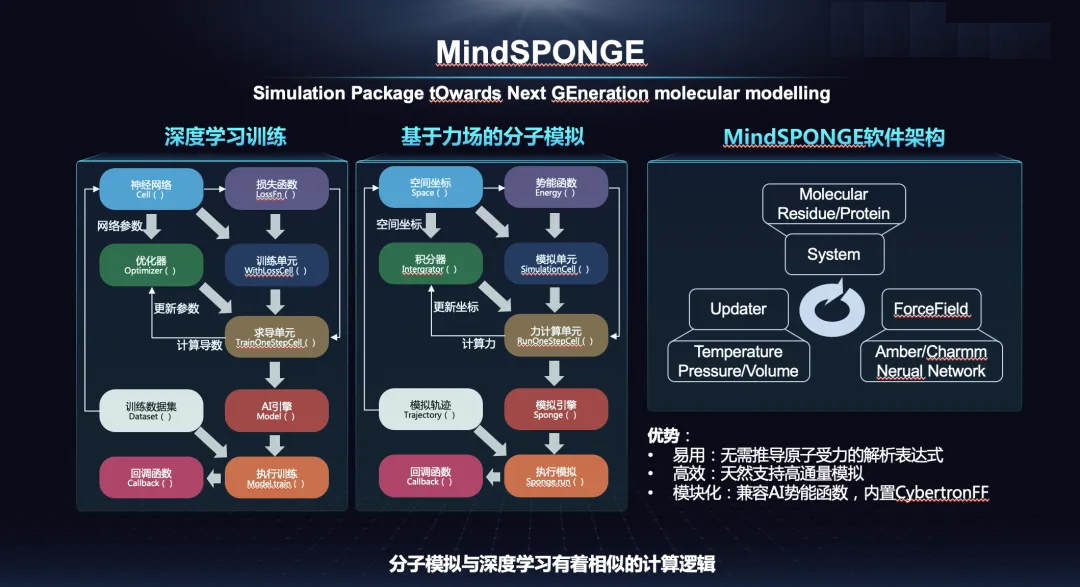

4. 华为Ascend与MindSpore

华为的Ascend AI芯片与自研的MindSpore框架是另一个绕过CUDA的典型案例。Ascend芯片专为AI任务设计,MindSpore框架为其提供支持,二者之间通过自研的软件栈和硬件驱动进行深度集成,从而不依赖于CUDA。

关键点: MindSpore和Ascend硬件的结合使得华为能够在不依赖NVIDIA的CUDA平台下,提供高效的深度学习训练与推理支持。

5. Apple的Metal加速框架

Apple的Metal框架是专为其硬件(如M1芯片)设计的计算API,支持图形渲染和计算任务。Metal框架使得Apple的设备能够高效地进行深度学习任务,而无需依赖CUDA。Apple的CoreML框架即是基于Metal,用来加速机器学习任务的计算。

关键点: Apple通过自研的硬件与计算框架,绕开了CUDA,利用其自有的硬件资源进行深度学习加速,进一步推动了AI计算的去NVIDIA化趋势。

结语

DeepSeek通过绕过CUDA框架,采取自研的硬件加速方案,提供了一种更加灵活、高效且低成本的深度学习训练解决方案。通过支持多种硬件平台、优化计算资源的利用并降低对单一硬件厂商的依赖,DeepSeek使得大规模模型的训练变得更加可控和高效。

随着人工智能技术的不断发展,DeepSeek有望成为一个突破CUDA依赖的创新平台,推动深度学习和大规模模型训练的普及与应用。通过这种创新的硬件加速架构,DeepSeek不仅为开发者提供了更高效的计算支持,也为未来的AI硬件加速生态打下了坚实的基础。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?