目录

AvaloniaChat介绍

AvaloniaChat是一个基于大语言模型用于翻译的简单应用。在看英文文献的过程中,比较喜欢对照着翻译看,因此希望一边是英文一边是中文,虽然某些软件已经自带了翻译功能,但还是喜欢大语言模型的翻译,但每次都要将英文复制粘贴过去还要自己手动添加prompt,还无法对照着看,因此自己基于Avalonia与Semantic Kernel开发了这款解决自己这个需求的软件,开源出来每个人都可以免费使用,希望能帮助到有同样需求的人。

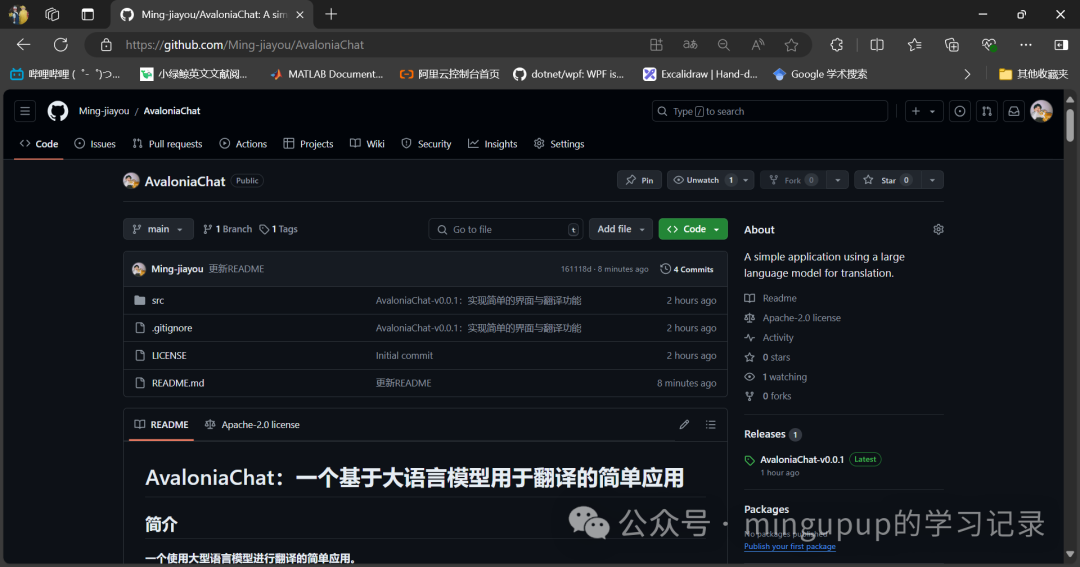

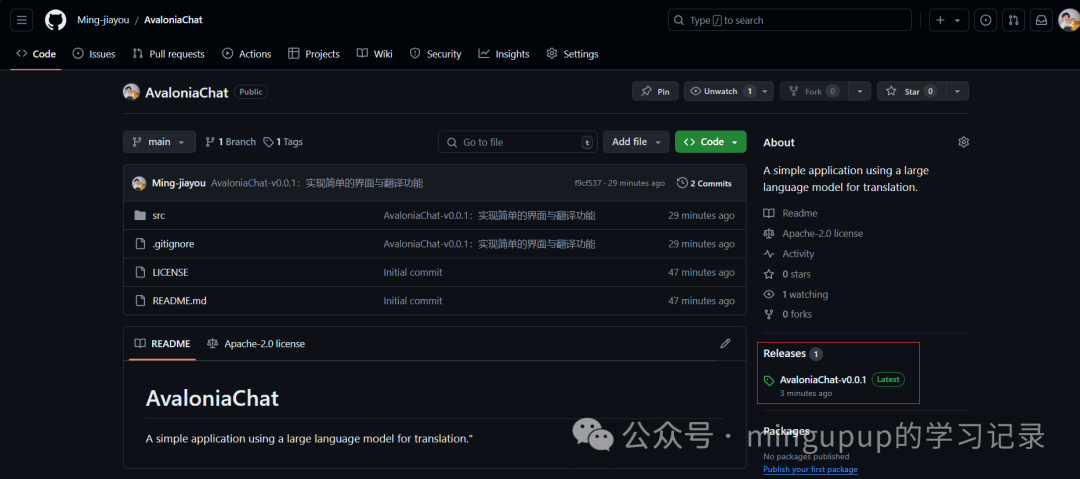

GitHub地址:https://github.com/Ming-jiayou/AvaloniaChat

使用指南

访问GitHub地址:https://github.com/Ming-jiayou/AvaloniaChat

注意到Releases这里:

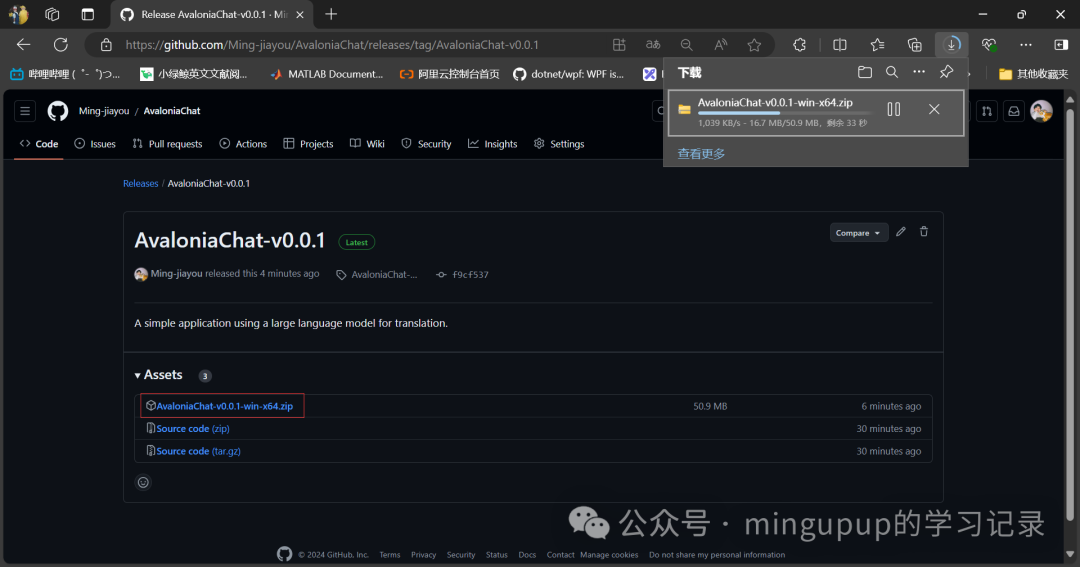

点击AvaloniaChat-v0.0.1-win-x64.zip就会在下载了:

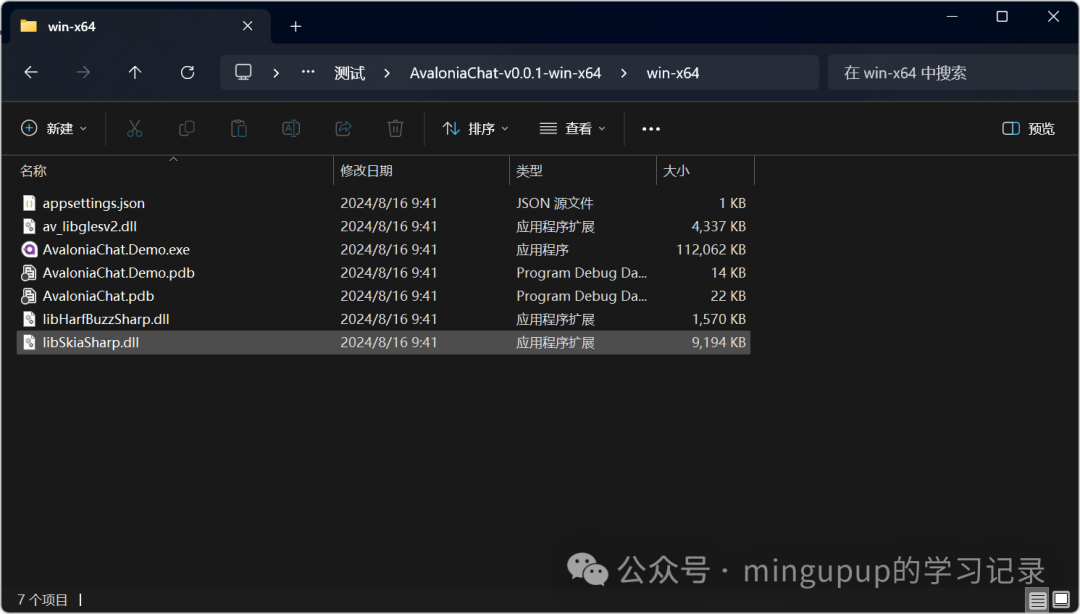

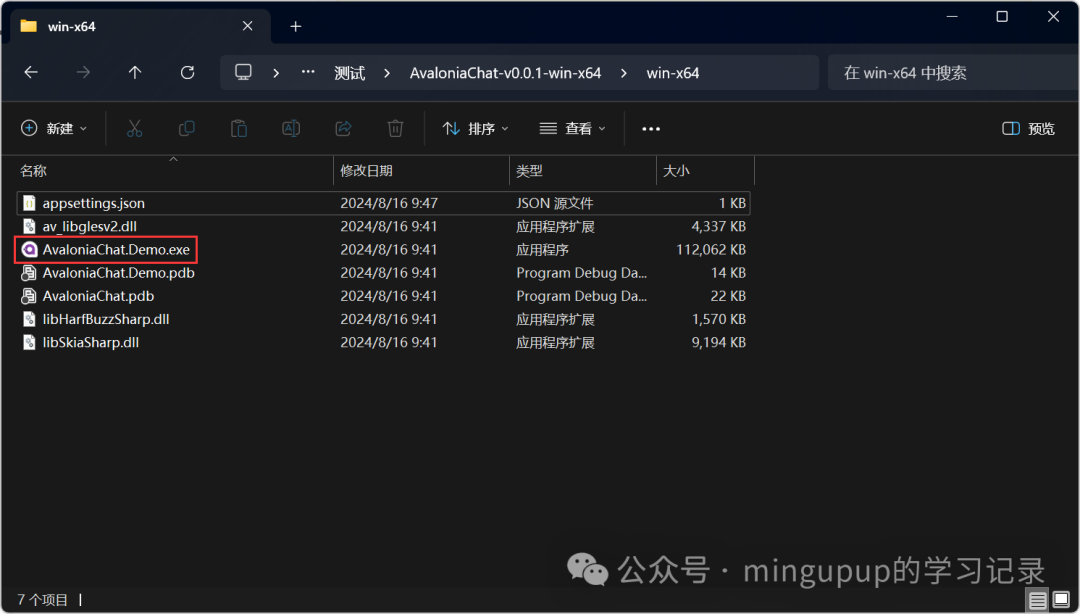

解压之后,打开文件夹,如下所示:

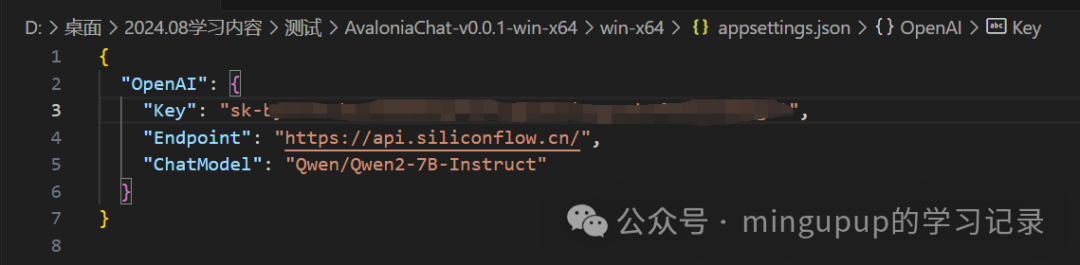

现在只需简单编辑一下appsettings.json文件,该文件用于配置你所使用的大语言模型。

以硅基流动为例,也最推荐硅基流动,Qwen/Qwen2-7B-Instruct是免费的,并且推理速度很快。

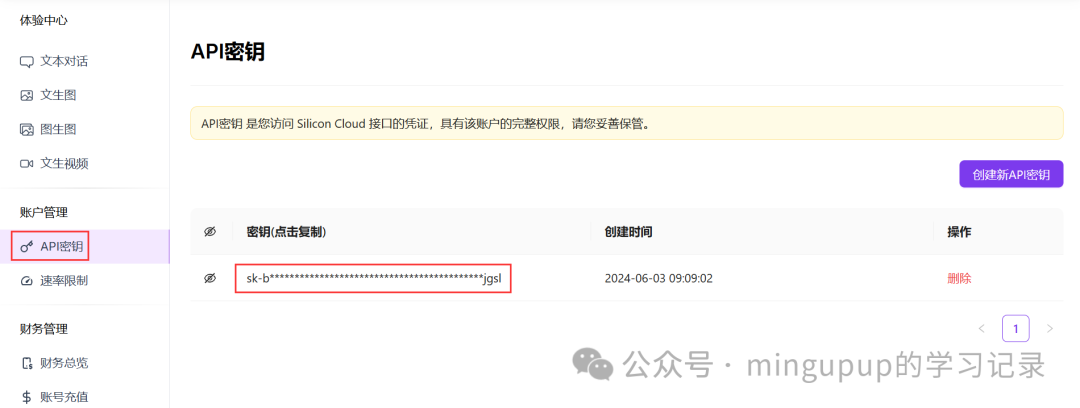

注册硅基流动之后,创建一个Api Key,复制这个Api Key:

打开appsettings.json文件,如果使用的是硅基流动,只需填入Api Key即可:

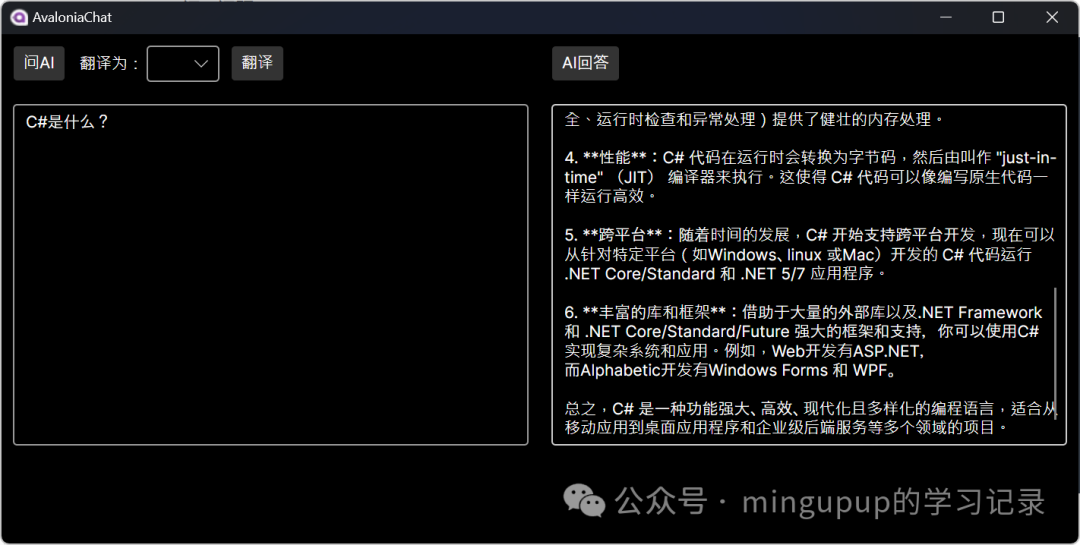

现在配置就完成了,点击exe文件即可使用:

问AI问题:

个人的主要使用场景

在看英文文献的过程中,比较喜欢对照着翻译看,因此希望一边是英文一边是中文,虽然某些软件已经自带了翻译功能,但还是喜欢大语言模型的翻译,但每次都要将英文复制粘贴过去还要自己手动添加prompt,还无法对照着看,因此自己基于Avalonia与Semantic Kernel开发了这款解决自己这个需求的软件,开源出来每个人都可以免费使用,希望能帮助到有同样需求的人。

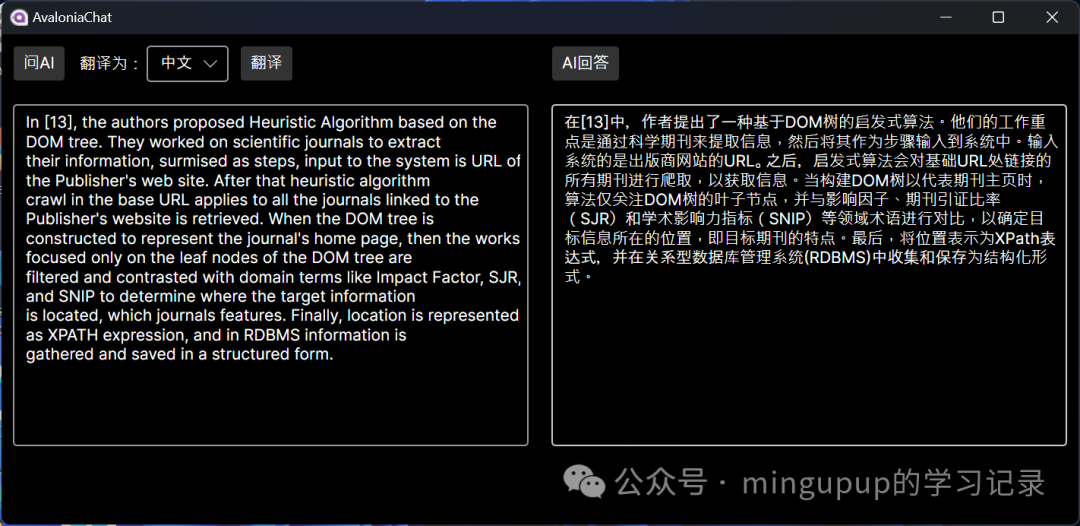

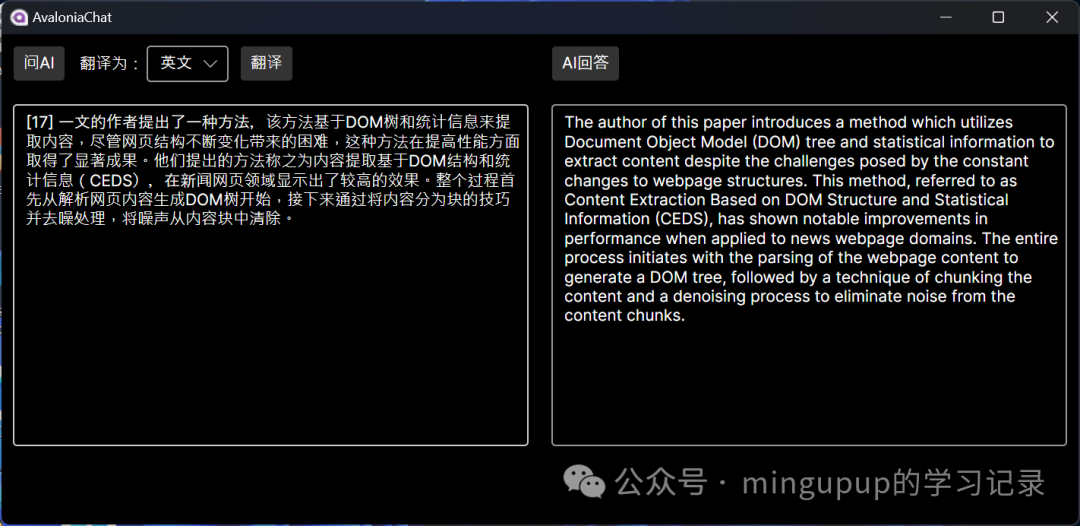

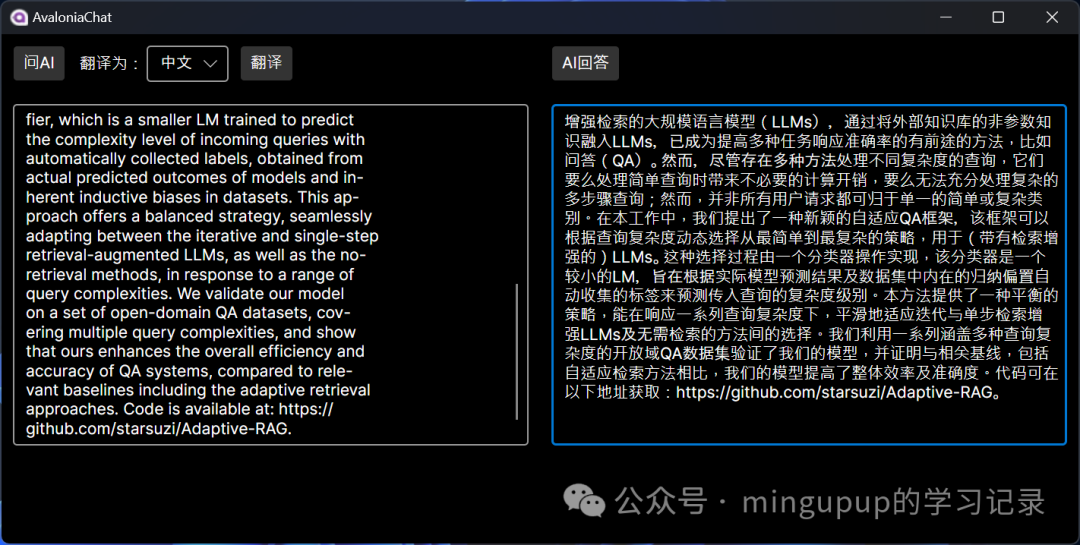

英译中:

中译英:

一般注册之后,都会送一些额度,因此为了更好的翻译质量,可以更换到收费的模型。

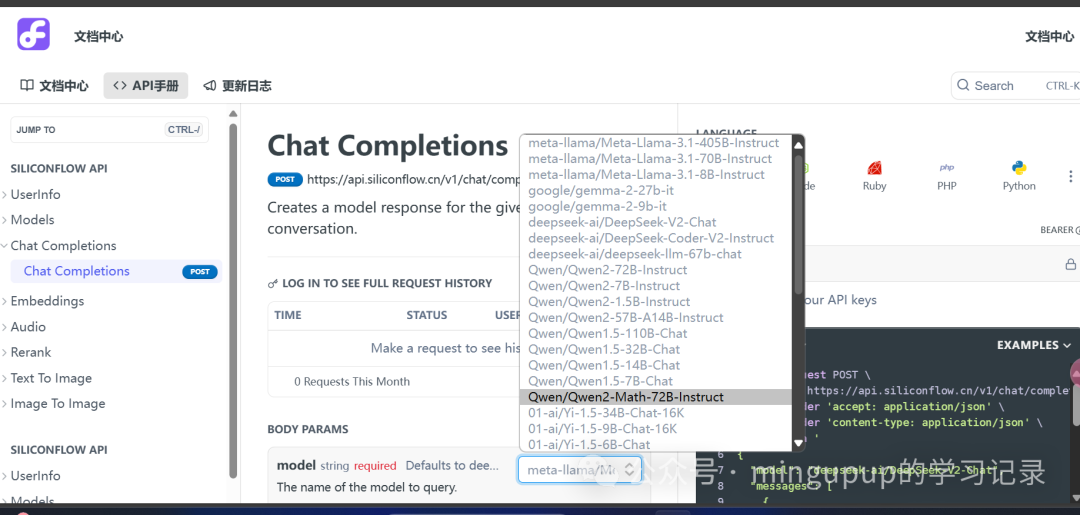

模型名称可以在这里看:

地址:https://docs.siliconflow.cn/reference/chat-completions-3

这里可以更换成一个更强的模型:Qwen/Qwen2-72B-Instruct

appsettings.json文件改成如下所示:

{

"OpenAI": {

"Key": "your key",

"Endpoint": "https://api.siliconflow.cn",

"ChatModel": "Qwen/Qwen2-72B-Instruct"

}

}

重新运行软件:

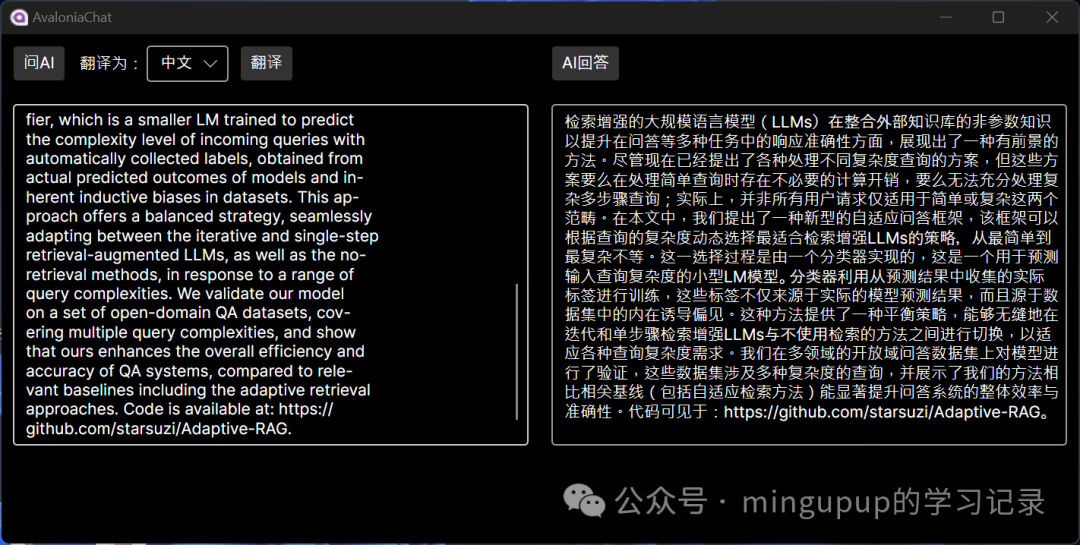

这是Qwen/Qwen2-72B-Instruct的效果,对比Qwen/Qwen2-7B-Instruct应该速度会慢一点,但翻译质量会高一点。同一段文本,我再用Qwen/Qwen2-7B-Instruct试试效果:

可以根据自己的需求灵活调整。

我推荐硅基流动的理由主要有以下几点:

-

提供多个领先的开源生文、生图和代码模型。对于这些模型,您只需按使用量付费。刚注册会送一些额度,够个人开发者用一段时间的了。

-

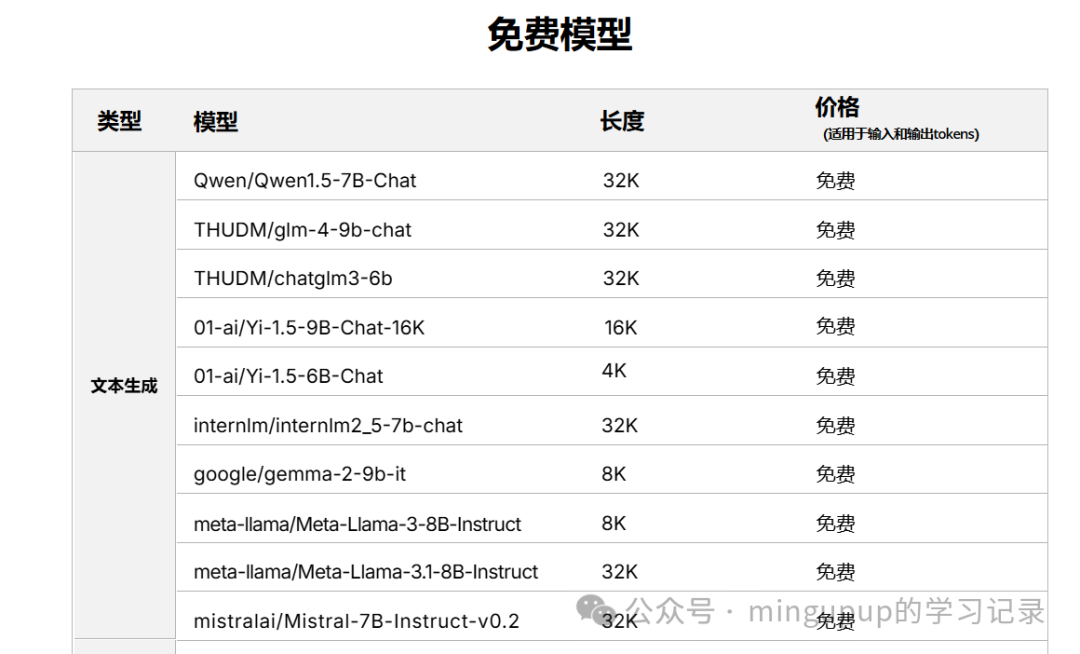

提供一些免费的模型,SiliconCloud提供了多款免费模型,嵌入与文生图暂时是免费的。

-

推理速度很快。

更多信息可以看SiliconCloud官网:https://siliconflow.cn/zh-cn/siliconcloud

5

5

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?