本章内容

- 降维技术

- 主成分分析(PCA,Principal Component Analysis)

- 对半导体数据进行降维处理

体育比赛中,人们面对的原本是百万像素的数据,但只有球的三维位置才是最重要的,这就被称为降维(dimensionality reduction)。在低维下,数据更容易进行处理。通常,在应用其他机器学习之前,须先识别出其相关特征。

一、降维技术

对数据进行简化的原因:

- 多维数据难以显示

- 使得数据集更易使用

- 降低很多算法的计算开销

- 去除噪声

- 使得结果易懂

在已标注和未标注的数据上都有降维技术,这里主要关注未标注数据上的降维技术。

- 主成分分析(Principal Component Analysis,PCA),在PCA中,数据从原来的坐标系转换到新的坐标系,新坐标系的选择是由数据本身决定的。第一个新坐标轴选择的是原始数据中方差最大的方向,第二个新坐标轴的选择和第一个坐标轴正交且具有最大方差的方向。该过程一直重复,重复次数是原始数据中特征的数目。我们发现,大部分方差都包含在最前面的几个新坐标轴中。因此,可以忽略余下的坐标轴,即对数据进行降维处理。

- 因子分析(Factor Analysis),在因子分析中,假设在观察数据的生成中有一些观察不到的隐变量(latent variable)。假设观察数据是这些隐变量和某些噪声的线性组合。那么隐变量的数据可能比观察的数据数目少,也就是说通过找到隐变量就可以实现数据的降维。因子分析已经应用于社会科学、金融和其他领域中了。

- 独立成分分析(Independent Component Analysis,ICA),ICA假设数据是从N个数据源生成的,这和因子分析有些类似。假设数据为多个数据源的混合观察结果,这些数据源之间在统计上是相互独立的,而PCA只假设数据是不相关的。同因子分析一样,如果数据源的数目少于观察数据的数目,则可以实现降维过程,则可以实现降维过程。

在上述降维技术中,PCA应用最为广泛,文中只关注PCA。

二、PCA

优点:降低数据的复杂性,识别最重要的多个特征。

缺点:不一定需要,且可能损失有用信息。

使用数据类型:数值型数据。

2-1 移动坐标轴

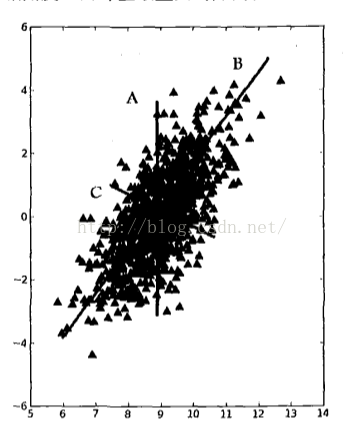

考虑一下图1中的大量数据点。若要求画出一条直线,这条线要尽可能覆盖这些点,三条直线中B最长。在PCA中,对数据的坐标进行旋转,该旋转的过程取决于数据的本身。第一条坐标轴旋转到覆盖数据的最大方差为止,即直线B。数据的最大方差给出了数据的最重要的信息。

图1 覆盖整个数据集的三条直线,其中直线B最长,并给出了数据集中差异化最大的方向

在选择了覆盖数据最大差异性的坐标轴后,继续选择第二条坐标轴。假如该坐标轴与第一条坐标轴垂直,它就是覆盖数据次大差异性的坐标轴。更严谨的说法是正交(orthogonal)。在二维平面下,垂直和正交是一回事。在图1中,直线C就是第二条坐标轴。利用PCA,可将数据坐标轴旋转至数据角度上的那些最重要的方向。

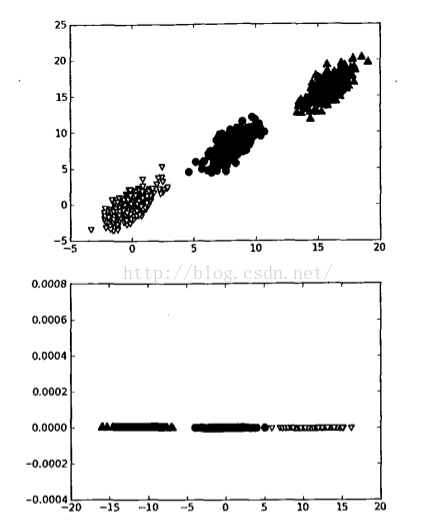

图2 二维空间的三个类别。当在该数据集上应用PCA时,就可以去掉一维,从而使得该分类问题变得更容易处理

实现坐标轴旋转后,可讨论降维。坐标轴的旋转并没有减少数据的维度。图2中包含三个不同的类别。要区分这三个类别,可使用决策树。决策树每次都是基于一个特征来做决策。我们会发现,在x轴上可找到一些值,这些值能够很好地将这3个类别分开。这样可得到一些规则,比如当(X<4)时,数据属于类别0。若使用SVM这样稍复杂的分类器,可得到更好的分类面和分类规则,比如当(w0*x + w1*y + b) > 0时,数据也属于类别0。SVM可能比决策树得到更好的分类间隔,但分类超平面却很难解释。

通过PCA进行降维处理,可同时获得SVM和决策树的优点:一方面,得到了和决策树一样的简单分类器,同时分类间隔和SVM一样好。考虑图2中下面的图,其中的数据来自于上面的图并经PCA转换后绘制而成。如果仅使用原始数据,那么这里的间隔会比决策树的间隔大。另外,由于只需要考虑一维信息,因此数据可通过比SVM简单得多的、且容易采用的规则进行区分。

在图2中,只需一维信息即可,因为另一维信息只是对分类缺乏贡献的噪声数据。在二维平面下,这看上去微不足道,但在高维空间则意义重大。

对PCA的基本过程简单阐述后,接下来可通过代码实现PCA过程。前面提到第一个主成分就是从数据差异性最大(即方差最大)的方向提取出来的,第二个主成分则来自于数据差异次大的方向,并且该方向与第一个主成分方向正交。通过数据集的协方差矩阵及其特征值分析,可以求得这些主成分的值。

一旦得到了协方差矩阵的特征向量,就可以保留最大的N个值。这些特征向量也给出了N个最重要的真实

本文介绍了降维技术的重要性,特别是主成分分析(PCA),并展示了如何在半导体制造数据上应用PCA进行降维。PCA通过旋转坐标轴以最大化方差,保留数据的主要特征,简化数据的同时降低计算开销。在半导体数据中,前六个主成分涵盖了96.8%的方差,实现了数据的高效压缩。

本文介绍了降维技术的重要性,特别是主成分分析(PCA),并展示了如何在半导体制造数据上应用PCA进行降维。PCA通过旋转坐标轴以最大化方差,保留数据的主要特征,简化数据的同时降低计算开销。在半导体数据中,前六个主成分涵盖了96.8%的方差,实现了数据的高效压缩。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

456

456

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?