第四章:

首先引入九宫格的故事,表示我们的模型在训练集D上完全正确,不代表我们在未知数据上也能与真实结果一致,我们很难从样本中学到一个固定的模型答案。所以这一章主要印证是否训练集和情况可以适用于整个输入空间。

所以我们引入霍夫丁不等式来解决这个问题:

![]()

其中v和u分别表示N个样本(独立同分布)和总体中的比例。这个式子足以表明,我们可以通过一个近似的算法,,通过增大data的数量或者增大误差的范围,使得估计值与真实值接近。

但是问题又来了,我们从H中选择Ein最小的最为g,可是是否训练样本中的误差会导致选择的g与输入空间有误差。意思比如,我们的袋子里有1000个红球,1000个绿球,但是我们取出的样本恰好是10个红球,那么这个样本实际上不可以反应总体的。

其中M是H中h的个数,N是样本数量,经过推导也可以成功得出,当M有限,而N足够多时,出现坏样本的几率是很低的。所以可以保证D对于所有的h都有Ein=Eout。

第五章:

第四章讨论的是当H中h的个数有限的情况,但是当hypothesis的个数是无限多的时候,机器学习的可行性是否仍然成立?

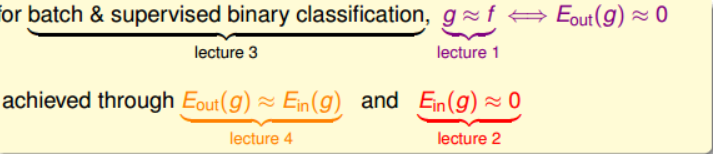

我们在之前学习了1、通过PLA、Pocket的方法令Ein≈0。2、通过统计学知识,证明Ein(g)≈Eout(g)。

机器学习的核心问题就是:

通过分析我们知道,当M无限大的时候,实际上第一个核心问题就不满足了,所以我们要想办法将M限定在一个有限的值mH内。

我们出现错误的地方在于两个h发生坏事情的dataset通常非常接近,也就是说Pd(bad)的上限被过分高估了。所以我们要找出这些坏事情重叠的部分,也就是说将无线个hypothesis分成有限个类别。

如何分呢?从平面上来看,就是如何用一条直线将点分开。

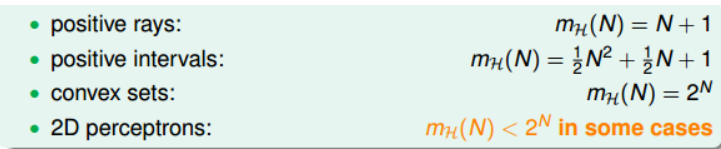

定义hypotheses H是平面上所有直线的集合,个数可能是无限个,而dichotomy H是平面上能将点完全用直线分开的直线种类,它的上界是2^N。接下来,我们要做的就是尝试用dichotomy代替M。定义成长函数mH(N),对于由N个点组成的不同集合中,某集合对应的dichotomy最大,也就是它是不同种dichotomy H的最大值,它的上界是2^N。

看到这里其实我们可以用mH(N)来代替M了,可是这里有存在问题,mh(N)如果是多项式形式的,它增长起来很慢,则可以认为相比与N指数形式的增长忽略不计,但是如果成长函数是2^N,也就是指数形式的,那么它的增长速度还是很大。也就是说我们现在要证明mH(N)是多项式形式的。

于是提出了进一步的猜想:对于positive intervals,break point k=3,它的成长函数是O(N^2)。则根据这种推论,我们猜测2D perceptrons,它的成长函数m_H(N)=O(N^{k-1})。

下一章对此进行论证。

421

421

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?