下一代AI芯片,拼什么?

AI,这个无尽的财富,无人愿意错过。尽管摩尔定律的极限临近,芯片性能提升愈发艰难。然而,各大厂商仍以瞩目速度推出新一代产品。在最近的台北国际电脑展上,英伟达、AMD和英特尔三大芯片巨头齐聚,展示自家实力,发布了下一代AI芯片。

在AI芯片的竞技场上,英伟达的Hopper GPU、Blackwell和Rubin,AMD的Instinct系列,以及英特尔的Gaudi芯片,都在争夺主导地位。这是一场速度与技术的较量。以英伟达为首的行业巨头,将芯片的更新周期缩短至每年一代,展现了AI领域的“芯”速度竞争。而在技术层面,如何提升芯片的计算速度,降低功耗,实现更节能且更易用的目标,将是各家厂商的实力体现。

尽管各家厂商在AI芯片方面各有侧重,但细看之下,其实存在着不少的共同点。

尽管摩尔定律面临挑战,但AI芯片的创新速度和发布频率却在加速。英伟达Blackwell的强势表现仍在持续,然而在短短3个月后的Computex大会上,英伟达又推出了新一代AI平台——Rubin。英伟达首席执行官黄仁勋宣布,未来每年都会有新的AI芯片问世。这一年度一代的新芯片发布速度,再次刷新了AI芯片更迭的记录。

英伟达的新一代GPU,以美国女天文学家Vera Rubin的名字命名,将配备全新的Vera CPU和先进的X1600 IB网络芯片。这款产品将于2026年上市,敬请期待。

当前,Blackwell和Rubin均在全面开发中,其2023年Computex上首度亮相的GH200 Grace Hopper“超级芯片”正全力投入生产。预计今年稍后,Blackwell将正式上市;Blackwell Ultra则计划于2025年问世,而Rubin Ultra则将在2027年与消费者见面。

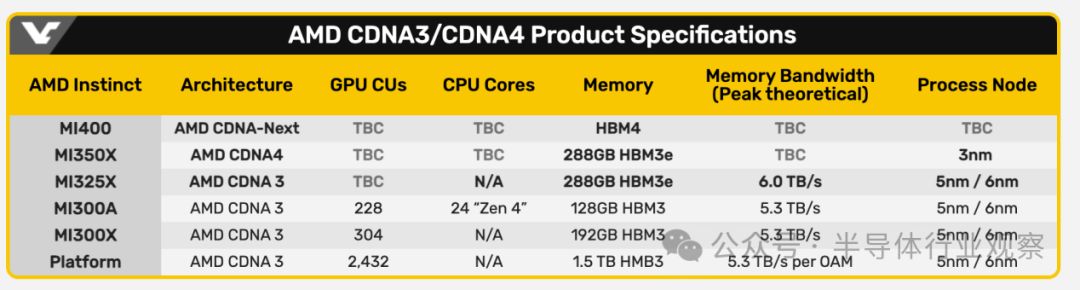

紧随英伟达之后,AMD也公布了其年度"Instinct"加速器路线图。每年,AMD将推出一代AI加速器,致力于引领行业发展。AMD总裁Lisa Su强调:“人工智能是我们的首要任务,我们正站在这个行业令人振奋的新时代的起点。”

继去年推出了MI300X,AMD的下一代MI325X加速器将于今年第四季度上市,Instinct MI325X AI加速器可以看作是MI300X系列的强化版,Lisa Su称其速度更快,内存更大。随后,MI350系列将于2025年首次亮相,采用新一代AMD CDNA 4架构,预计与采用AMD CDNA 3的AMD Instinct MI300系列相比,AI推理性能将提高35倍。MI350对标的是英伟达的Blackwell GPU,按照AMD的数据,MI350系列预计将比英伟达B200产品多提供50%的内存和20%的计算TFLOP。

基于AMD CDNA“Next”架构的AMD Instinct MI400系列预计将于2026年上市。

英特尔虽然策略相对保守,但是却正在通过价格来取胜,英特尔推出了Gaudi人工智能加速器的积极定价策略。英特尔表示,一套包含八个英特尔Gaudi 2加速器和一个通用基板的标准数据中心AI套件将以65,000美元的价格提供给系统提供商,这大约是同类竞争平台价格的三分之一。

英特尔表示,一套包含八个英特尔Gaudi 3加速器的套件将以125,000美元的价格出售,这大约是同类竞争平台价格的三分之二。AMD和Nvidia虽然不公开讨论其芯片的定价,但根据定制服务器供应商Thinkmate的说法,配备八个Nvidia H100 AI芯片的同类HGX服务器系统的成本可能超过30万美元。

芯片巨头们以疾风骤雨般的新产品发布速度和定价,揭示了AI芯片市场的竞争激度,令众多AI初创公司望尘莫及。预见未来,三大巨头将独霸大部分AI市场,而众多初创公司只能分得一杯羹。

工艺奔向3纳米

AI芯片迈向3纳米工艺是大势所趋,涵盖数据中心、边缘AI和终端设备。3纳米作为当前最先进的工艺节点,其性能提升、功耗降低和晶体管密度增加,成为推动AI芯片发展的关键因素。对于能源消耗巨大的数据中心而言,3纳米工艺的低功耗特性至关重要,能有效降低运营成本、缓解能源压力,并为绿色数据中心的建设提供有力支持。

英伟达的B200 GPU功耗高达1000W,而由两个B200 GPU和一个Grace CPU组成的GB200解决方案消耗高达2700W的功率。这样的高功耗使得数据中心难以为这些大型计算GPU集群提供足够的电力和冷却。因此,英伟达必须采取措施。

Rubin GPU,一款致力于功耗控制的设备,据天风国际证券分析师郭明錤透露,它有望采用台积电先进的3纳米工艺技术打造。

外媒进一步揭示,Rubin GPU将采用4x光罩设计,并借助台积电CoWoS-L封装技术,展现其独特魅力。然而,Rubin GPU是否能在降低功耗的同时,显著提升性能,或者专注于性能效率,这都是我们期待揭晓的问题。让我们一起关注,看Rubin GPU如何打破常规,创造新的可能。

AMD Instinct系列,曾以5纳米/6纳米双节点的Chiplet模式独领风骚。然而,MI350系列的诞生,标志着其已跃升至3纳米工艺。行业分析师陆行之预测,如果英伟达大量下单台积电,可能会挤压AMD的产能空间,迫使其转向三星寻求合作。

来源:videocardz

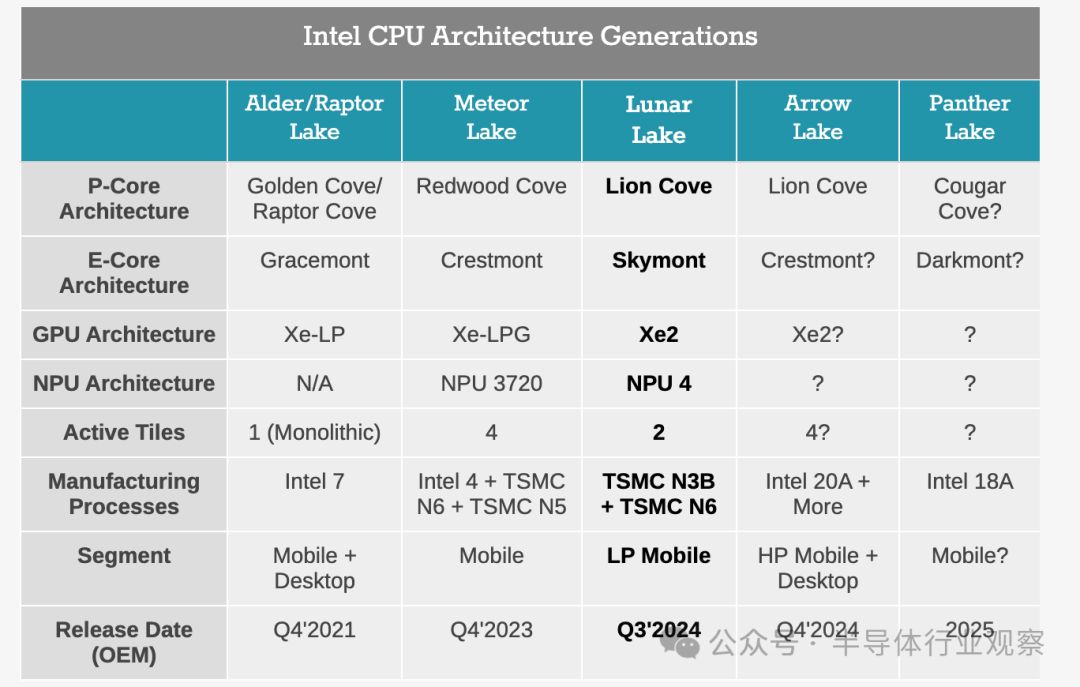

英特尔用于生成式AI的主打芯片Gaudi 3采用的是台积电的5纳米,对于 Gaudi 3,这部分竞争正在略微缩小。不过,英特尔的重心似乎更侧重于AI PC,从英特尔最新发布的PC端Lunar Lake SoC来看,也已经使用了3纳米。

Lunar Lake包含代号为Lion Cove的新 Lion Cove P核设计和新一波Skymont E 核,它取代了 Meteor Lake 的 Low Power Island Cresmont E 核。英特尔已披露其采用 4P+4E(8 核)设计,禁用超线程/SMT。整个计算块,包括P核和E核,都建立在台积电的N3B节点上,而SoC块则使用台积电N6节点制造。

英特尔历代PC CPU架构

(来源:anandtech)

在今年5月,AI芯片界的翘楚Arm在边缘和终端领域推出了第五代Cortex-X内核及搭载最新高性能图形单元的计算子系统(CSS)。这款Arm Cortex-X925 CPU采用了3纳米工艺节点,实现了单线程性能提升36%和AI性能提升41%的突破。这一创新将显著增强设备端生成式AI如大语言模型(LLM)的响应能力,为智能手机带来前所未有的强大性能。

高带宽内存HBM)是必需品

HBM(高带宽存储器),已成为AI芯片的核心要素。历经五代技术迭代:第一代HBM,第二代HBM2,第三代HBM2E,第四代HBM3,以及第五代HBM3E,现已积极研发第六代HBM。HBM持续突破性能边界,满足AI芯片日益增长的带宽需求。

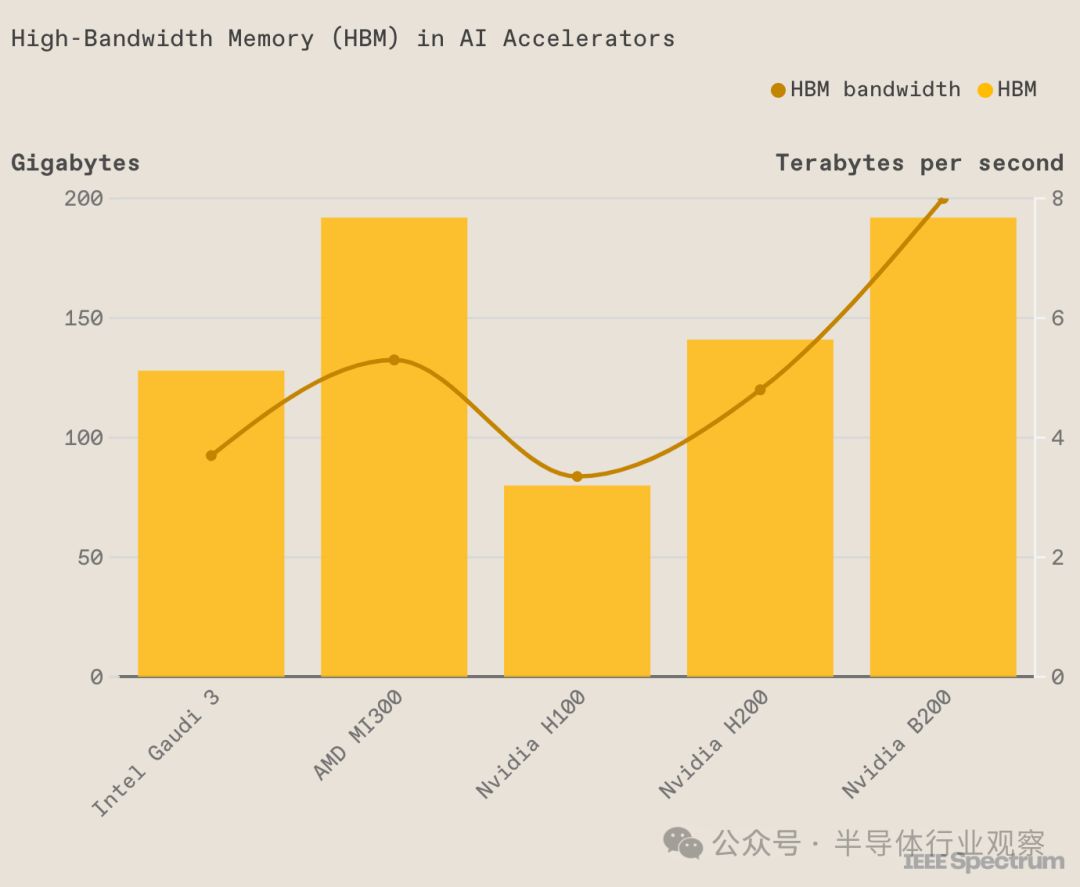

在当前一代的AI芯片中,各大厂商纷纷采用了第五代HBM-HBM3E技术。以英伟达Blackwell Ultra为例,其HBM3E内存已增至12颗;AMD MI325X则拥有高达288GB的HBM3e内存,相较于MI300X增加了96GB。而英特尔Gaudi 3则封装了八块HBM芯片,其高性价比的背后,很大程度上得益于使用了成本较低的HBM2e技术。

英特尔Gaudi 3的HBM内存,虽多于H100,但相较于H200、B200或AMD的MI300则略显不足(源自IEEE Spectrum)。

下一代AI芯片已全面拥抱第六代HBM-HBM4技术。英伟达的Rubin平台将升级至HBM4,其内置8颗HBM4的Rubin GPU,而更先进的Rubin Ultra将于2027年问世,将搭载12颗HBM4。AMD的MI400也紧随其后,迈向HBM4时代。

在HBM供应商领域,过去AMD、英伟达等主要选择的是SK海力士。然而,现在三星正在积极进军这些厂商市场,与AMD展开合作并测试三星的HBM技术。在6月4日于台北南港展览馆举行的新闻发布会上,黄仁勋回答了关于三星何时能成为Nvidia合作伙伴的问题。他表示:“我们对HBM的需求非常大,因此供应速度至关重要。目前我们正在与三星、SK海力士和美光合作,我们将从这三家公司获得产品。”

HBM市场竞争白热化,SK海力士提前至2026年量产HBM4,三星紧随其后明年开发。两家巨头争锋相对,今年DRAM产能的20%转向HBM。美光也加入战局,HBM大战一触即发。

HBM,作为当前最热门的技术,却成为了AI芯片大规模量产的难题。存储巨头SK Hynix的HBM4产能在2025年前已基本售罄,供需矛盾日益尖锐。据SK海力士预测,AI芯片的繁荣将推动HBM市场在2027年实现82%的复合年增长率。分析师们也普遍认为,明年HBM市场的规模将比今年增长一倍以上。

在KIW 2023上,三星电子DRAM产品与技术执行副总裁Hwang Sang-joon宣布:“我们客户的HBM订单量已比去年增长超过一倍。”设备解决方案部门总裁兼负责人Kyung Kye-hyun进一步强调,三星的目标是占据HBM市场的一半份额。同时,三星内存业务执行副总裁Jaejune Kim向分析师透露,该公司计划在2023年至2024年期间将其HBM产能翻倍。三星正积极拓展其在HBM市场的领先地位,以满足不断增长的客户需求。

互联:重要的拼图

AI芯片间的互联一直是个难题,随着加速器集成数量的增长,高效数据传输成为了瓶颈。由于PCIe技术发展滞后,主流AI芯片厂商纷纷自研互联技术,英伟达的NVLink和AMD的Infinity Fabric成为代表。

NVIDIA即将推出的下一代Rubin平台,将搭载NVLink 6交换机芯片,其传输速度高达3600GB/s,相较于上一代Blackwell所使用的NVLink 5.0有了显著提升。NVLink的诞生,源于对传统PCI Express (PCIe) 总线在处理高性能计算任务时带宽不足的问题的深度思考和解决。下图详细展示了英伟达各代NVLink的性能参数,清晰揭示了其在技术升级中的进步与突破。

各代NVLink的性能参数

与英伟达的NVLink相媲美,AMD推出了其创新的Infinity Fabric技术。这项技术与第二代AMD EPYC处理器同步推出,旨在为系统构建者和云架构师提供卓越的服务器性能,同时确保功能、可管理性和保护组织核心资产(数据)的能力不受影响。Infinity Fabric支持多种数据传输方式,包括芯片间、芯片对芯片以及即将推出的节点对节点传输。这一创新技术将助力您解锁无限可能。

英特尔,以太网的坚定支持者,其Gaudi AI芯片用于生成式AI,始终坚守传统的以太网互联技术。Gaudi 2芯片配备了24个100Gb以太网链路,而Gaudi 3则采用了24个200Gbps以太网RDMA NIC,将带宽提升了一倍,达到200Gb/秒,使外部以太网I/O总带宽高达8.4TB/秒。

拼服务

生成式AI如ChatGPT的开发过程极为繁琐,其大模型在多台计算机上运作,拥有数亿至数万亿的参数。为了提升效率,它运用了张量并行、流水线并行和数据并行等多种并行处理方式,在多个GPU上同步执行任务。

因此,如何能够帮助用户更快的开发,提供良好的服务也是关键一役。

在这方面,英伟达推出了一种新型的软件NIMS,即NVIDIA Inference Microservices(推理微服务)。黄仁勋称之为“盒子里的人工智能”,NIMS中包含了英伟达的CUDA、cuDNN、TensorRT、Triton。

NIMS 不仅使部署 AI 变得更容易,只需几分钟而不是几个月,它们还构成了客户可以创建新应用程序和解决新问题的构建块。如果采用,NIMS 将有助于加速创新并缩短价值实现时间。Nvidia 还宣布,NIMS 现在可供开发人员和研究人员免费使用。在生产中部署NIMS需要AI Enterprise许可证,每个GPU的价格为4500美元。

结语

一场全新的AI竞赛已经拉开序幕。在当前的AI芯片市场,英伟达、AMD和英特尔等领军企业正在展开白热化的角逐。他们在速度、技术和工艺等方面不断刷新记录,同时在互联和服务领域积极拓展,致力于打造更快捷、更强大、更智能的AI解决方案。AI芯片之争仍在上演,最终的胜利者会是谁?让我们共同期待。

-对此,您有什么看法见解?-

-欢迎在评论区留言探讨和分享。-

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?