目录

在 Linux 系统编程中,进程间通信(IPC) 是实现多进程协作的关键,而管道(Pipe) 作为最基础的 IPC 机制之一,背后蕴含着内核数据结构、系统调用和进程管理的深层逻辑。本文将从数据结构、管道原理、进程管理、实战应用四个维度解析管道通信,并拓展实现管道型进程池,展示管道在批量任务调度中的进阶用法。

一、内核数据结构:管道的“骨架”

要理解管道,先得看清它依赖的核心数据结构——这些结构体是Linux内核管理“文件”和“进程”的基石。

1. struct file 与 struct file_operations

- struct file :描述**“打开的文件”**,包含文件状态(如是否可读写)、文件偏移量、指向文件操作的指针等。管道本质上是一种“特殊文件”,因此也由 struct file 管理。

- struct file_operations :是一个函数指针集合,定义了对文件的所有操作(如 read 、 write 、 open 、 close 等)。管道的读写逻辑,就通过重载这些函数指针实现“字节流通信”。

2. task_struct :进程的“身份证”

task_struct 是Linux内核中描述进程的结构体,包含进程ID(PID)、进程状态、文件描述符表、父子进程关系等关键信息。

- 每个进程都有一个 task_struct 实例,而文件描述符表是其中的核心组件——它记录了进程打开的所有文件(包括管道),让进程能通过“文件描述符”(如 pipefd[0] / pipefd[1] )操作管道。

3. 数据结构的关联:进程与管道的“纽带”

进程通过文件描述符表关联到 struct file ,而 struct file 又通过 struct file_operations 定义管道的读写行为。这种关联,让“进程操作管道”的逻辑得以落地:

graph LR

A[进程 task_struct] --> B[文件描述符表];

B --> C[struct file(管道)];

C --> D[struct file_operations(管道读写逻辑)];二、管道通信:原理与实现

管道是“单向字节流”通信机制,分为匿名管道和命名管道(FIFO)。我们先聚焦“匿名管道”的原理与实现。

1. 接口定义: pipe() 系统调用

创建匿名管道的入口是 pipe() 系统调用,原型如下:

#include <unistd.h>

int pipe(int pipefd[2]);- pipefd[0] :读端,用于从管道中读取数据;

- pipefd[1] :写端,用于向管道中写入数据;

- 返回值:成功返回 0 ,失败返回 -1 。

2. 内核实现细节

匿名管道的内核实现,藏着三个关键逻辑:

- 基于文件系统的“匿名性”:

匿名管道没有文件名,仅在创建它的进程及其子进程中可见(通过 fork 继承文件描述符)。内核通过“文件系统”机制管理管道的缓冲区,但不将其暴露到磁盘文件系统中。

- 容量限制: PIPE_BUF :

Linux中管道的默认缓冲区大小是 4096字节(PIPE_BUF) 。如果写入数据超过 PIPE_BUF ,写入操作可能不再“原子性”(多个写操作的数据可能交织)。

- 通信流程:“写→存→读”:

写进程向 pipefd[1] 写入数据,内核将数据暂存到“管道缓冲区”;读进程从 pipefd[0] 读取数据,内核从缓冲区中消费数据——以此实现进程间的“字节流”通信。

3. 实战示例:父子进程管道通信

下面是一个经典的“父进程写、子进程读”的管道通信示例:

一:

#include <stdio.h>

#include <unistd.h>

#include <string.h>

int main() {

int pipefd[2];

char buf[100];

// 1. 创建管道

if (pipe(pipefd) == -1) {

perror("pipe");

return 1;

}

// 2. fork创建子进程

pid_t pid = fork();

if (pid == -1) {

perror("fork");

return 1;

}

if (pid == 0) { // 子进程(读端)

close(pipefd[1]); // 关闭写端

int n = read(pipefd[0], buf, sizeof(buf));

printf("子进程读取到:%.*s\n", n, buf);

close(pipefd[0]);

} else { // 父进程(写端)

close(pipefd[0]); // 关闭读端

const char* msg = "Hello, Pipe!";

write(pipefd[1], msg, strlen(msg));

close(pipefd[1]);

wait(NULL); // 等待子进程结束

}

return 0;

}运行结果会输出: 子进程读取到:Hello, Pipe! ,完美演示了管道的“父子通信”能力。

二:

#include <iostream>

#include <cstdio>

#include <string>

#include <cstring>

#include <cstdlib> //stdlib.h

#include <unistd.h>

#include <sys/types.h>

#include <sys/wait.h>

#define N 2

#define NUM 1024

using namespace std;

// child

void Writer(int wfd)

{

string s = "hello, I am child";

pid_t self = getpid();

int number = 0;

char buffer[NUM];

while (true)

{

sleep(1);

// 构建发送字符串

//buffer[0] = 0; // 字符串清空, 只是为了提醒阅读代码的人,我把这个数组当做字符串了

//snprintf(buffer, sizeof(buffer), "%s-%d-%d", s.c_str(), self, number++);

// cout << buffer << endl;

// 发送/写入给父进程, system call

write(wfd, buffer, strlen(buffer)); // strlen(buffer) + 1???

//if(number >= 5) break;

}

}

// father

void Reader(int rfd)

{

char buffer[NUM];

while(true)

{

buffer[0] = 0;

// system call

ssize_t n = read(rfd, buffer, sizeof(buffer)); //sizeof != strlen

if(n > 0)

{

buffer[n] = 0; // 0 == '\0'

cout << "father get a message[" << getpid() << "]# " << buffer << endl;

}

else if(n == 0)

{

printf("father read file done!\n");

break;

}

else break;

// cout << "n: " << n << endl;

}

}

int main()

{

int pipefd[N] = {0};

int n = pipe(pipefd);

if (n < 0)

return 1;

// cout << "pipefd[0]: " << pipefd[0] << " , pipefd[1]: " << pipefd[1] << endl;

// child -> w, father->r

pid_t id = fork();

if (id < 0)

return 2;

if (id == 0)

{

// child

close(pipefd[0]);

// IPC code

Writer(pipefd[1]);

close(pipefd[1]);

exit(0);

}

// father

close(pipefd[1]);

// IPC code

Reader(pipefd[0]);

pid_t rid = waitpid(id, nullptr, 0);

if(rid < 0) return 3;

close(pipefd[0]);

sleep(5);

return 0;

}三、进程管理与信号:管道的“边界控制”

管道通信并非孤立存在,它依赖进程生命周期管理和信号机制处理异常场景(如管道断连、进程崩溃),确保通信稳定性。

1. 进程状态与ps命令

通过ps命令可查看管道中进程的状态,理解其阻塞 / 运行逻辑:

bash

ps -ef | grep 进程名 # 查看进程基本信息

ps -aux | grep 进程名 # 查看进程状态(STAT列)

- 状态

S:可中断睡眠,如读进程等待管道数据时的状态; - 状态

Z:僵尸进程,若父进程未调用wait/waitpid回收子进程,会导致资源泄漏,管道通信中需特别注意。

2. 信号:管道的 “异常通知”

Linux 通过信号(Signal) 处理管道通信中的异常,常见关键信号如下:

| 信号 | 触发场景 | 默认行为 |

|---|---|---|

SIGINT | 按下Ctrl+C,手动中断进程 | 终止进程 |

SIGPIPE | 管道读端关闭后,写端继续写入 | 终止进程 |

SIGCHLD | 子进程退出,父进程未回收 | 忽略信号 |

实战:自定义SIGPIPE处理

若子进程意外崩溃导致管道读端关闭,父进程继续写管道会触发SIGPIPE并终止。通过自定义信号处理函数,可避免父进程意外退出:

#include <signal.h>

#include <stdio.h>

void sigpipe_handler(int sig) {

printf("捕获到SIGPIPE(信号%d):管道读端已关闭,停止写入!\n", sig);

}

int main() {

signal(SIGPIPE, sigpipe_handler); // 注册信号处理函数

// 后续管道操作...

return 0;

}四、管道的局限性与优化方向

匿名管道虽基础,但存在明显短板,需根据场景选择优化方案:

1. 匿名管道的核心局限性

- 通信范围有限:仅支持有亲缘关系的进程(父子、兄弟),无法实现无亲缘关系进程(如两个独立的 Shell 进程)通信;

- 通信方向单一:仅支持 “单向通信”,若需双向通信,需创建两个管道(一个用于 A→B,一个用于 B→A);

- 无持久化:管道随进程退出而销毁,无法跨会话(如重启进程后)保留通信状态。

2. 优化与替代方案

(1)命名管道(FIFO):突破 “亲缘关系” 限制

命名管道通过文件名在文件系统中创建实体(可见但不占磁盘空间),支持无亲缘关系进程通信,创建接口如下:

#include <sys/stat.h>

#include <sys/types.h>

// 1. 创建命名管道(类似创建文件)

int mkfifo(const char *pathname, mode_t mode);

// 2. 打开命名管道(类似打开文件)

int fd = open("myfifo", O_RDONLY); // 读端打开

int fd = open("myfifo", O_WRONLY); // 写端打开

(2)更复杂的 IPC 机制:应对多样化需求

若需更灵活的通信(如结构化数据、大内存传输),可选择以下 IPC 机制:

| IPC 机制 | 核心优势 | 适用场景 |

|---|---|---|

| 消息队列 | 支持结构化数据(消息类型 + 数据),非阻塞通信 | 多进程间按类型传递数据 |

| 共享内存 | 直接操作物理内存,速度比管道快 1 个数量级 | 大内存数据传输(如视频流) |

| 信号量 | 实现进程同步与互斥,避免数据竞争 | 多进程共享资源(如缓冲区) |

五、拓展实战:基于管道的进程池实现

管道的典型进阶应用是管道型进程池—— 通过 “父进程管理管道写端、子进程监听管道读端” 的模式,实现批量任务的分发与执行。以下是完整实现代码与解析。

1. 任务定义头文件(Task.hpp)

先定义进程池需执行的任务(如日志刷新、野区更新等),通过函数指针统一任务类型:

#pragma once

#include <iostream>

#include <vector>

// 定义任务类型:无参数、无返回值的函数指针

typedef void (*task_t)();

// 任务1:刷新日志

void task1() {

std::cout << "[任务1] 刷新日志完成,当前时间:" << __TIME__ << std::endl;

}

// 任务2:刷新野区

void task2() {

std::cout << "[任务2] 野区刷新完成,生成3只小野怪" << std::endl;

}

// 任务3:检测软件更新

void task3() {

std::cout << "[任务3] 软件版本检测完成,当前为最新版v1.0.0" << std::endl;

}

// 任务4:更新血量和蓝量

void task4() {

std::cout << "[任务4] 角色状态更新完成,血量+100,蓝量+50" << std::endl;

}

// 加载所有任务到任务列表

void LoadTask(std::vector<task_t> *tasks) {

tasks->push_back(task1);

tasks->push_back(task2);

tasks->push_back(task3);

tasks->push_back(task4);

}

2. 管道型进程池核心代码

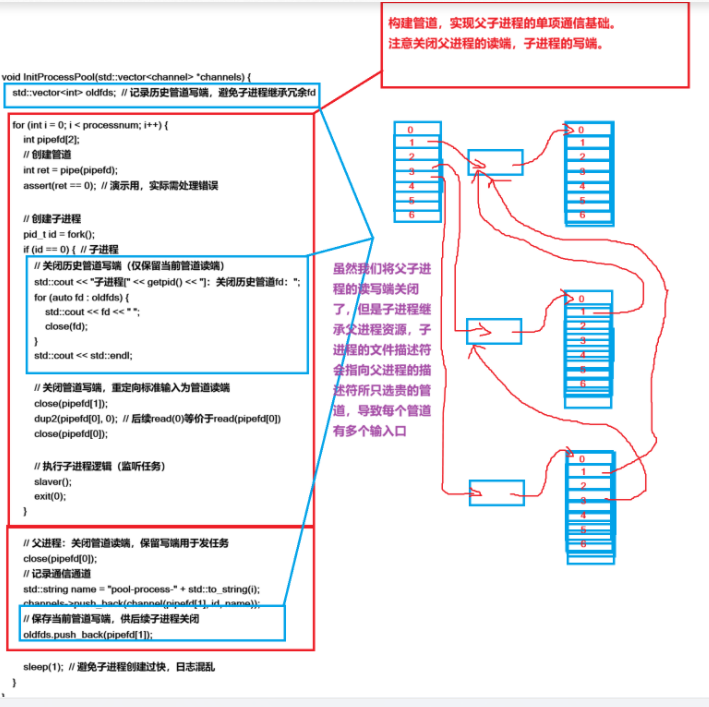

通过管道实现 “父进程分发任务、子进程执行任务”,核心逻辑包括:进程池初始化、任务分发、资源回收。

管道资源的描述

#include "Task.hpp"

#include <string>

#include <vector>

#include <cstdlib>

#include <ctime>

#include <cassert>

#include <unistd.h>

#include <sys/stat.h>

#include <sys/wait.h>

const int processnum = 10;

std::vector<task_t> tasks;

// 先描述

class channel

{

public:

channel(int cmdfd, int slaverid, const std::string &processname)

:_cmdfd(cmdfd), _slaverid(slaverid), _processname(processname)

{}

public:

int _cmdfd; // 发送任务的文件描述符

pid_t _slaverid; // 子进程的PID

std::string _processname; // 子进程的名字 -- 方便我们打印日志

// int _cmdcnt;

};

void Menu()

{

std::cout << "################################################" << std::endl;

std::cout << "# 1. 刷新日志 2. 刷新出来野怪 #" << std::endl;

std::cout << "# 3. 检测软件是否更新 4. 更新用的血量和蓝量 #" << std::endl;

std::cout << "# 0. 退出 #" << std::endl;

std::cout << "#################################################" << std::endl;

}

int main()

{

LoadTask(&tasks);

srand(time(nullptr)^getpid()^1023); // 种一个随机数种子

// 在组织

std::vector<channel> channels;

// 1. 初始化 --- bug?? -- 找一下这个问题在哪里?然后提出一些解决方案!

InitProcessPool(&channels);

// Debug(channels);

// 2. 开始控制子进程

ctrlSlaver(channels);

// 3. 清理收尾

QuitProcess(channels);

return 0;

}初始化进程池:创建子进程+管道,建立通信通道

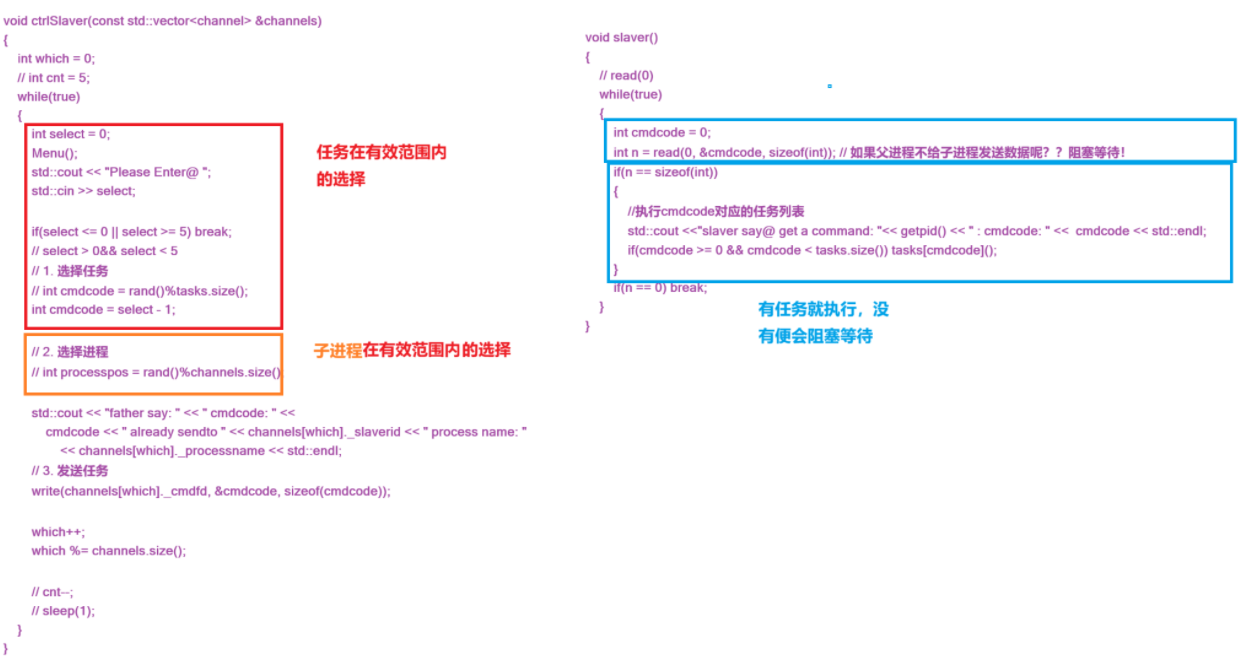

核心控制部分:父进程写子进程读

进程池资源释放时依次遍历关闭管道并等待子进程

void QuitProcess(const std::vector<channel> &channels)

{

for(const auto &c : channels){

close(c._cmdfd);

waitpid(c._slaverid, nullptr, 0);

}

}完整代码

#include "Task.hpp"

#include <string>

#include <vector>

#include <cstdlib>

#include <ctime>

#include <cassert>

#include <unistd.h>

#include <sys/stat.h>

#include <sys/wait.h>

const int processnum = 10;

std::vector<task_t> tasks;

// 先描述

class channel

{

public:

channel(int cmdfd, int slaverid, const std::string &processname)

:_cmdfd(cmdfd), _slaverid(slaverid), _processname(processname)

{}

public:

int _cmdfd; // 发送任务的文件描述符

pid_t _slaverid; // 子进程的PID

std::string _processname; // 子进程的名字 -- 方便我们打印日志

// int _cmdcnt;

};

void slaver()

{

// read(0)

while(true)

{

int cmdcode = 0;

int n = read(0, &cmdcode, sizeof(int)); // 如果父进程不给子进程发送数据呢??阻塞等待!

if(n == sizeof(int))

{

//执行cmdcode对应的任务列表

std::cout <<"slaver say@ get a command: "<< getpid() << " : cmdcode: " << cmdcode << std::endl;

if(cmdcode >= 0 && cmdcode < tasks.size()) tasks[cmdcode]();

}

if(n == 0) break;

}

}

// 输入:const &

// 输出:*

// 输入输出:&

void InitProcessPool(std::vector<channel> *channels)

{

// version 2: 确保每一个子进程都只有一个写端

std::vector<int> oldfds;

for(int i = 0; i < processnum; i++)

{

int pipefd[2]; // 临时空间

int n = pipe(pipefd);

assert(!n); // 演示就可以

(void)n;

pid_t id = fork();

if(id == 0) // child

{

std::cout << "child: " << getpid() << " close history fd: ";

for(auto fd : oldfds) {

std::cout << fd << " ";

close(fd);

}

std::cout << "\n";

close(pipefd[1]);

dup2(pipefd[0], 0);

close(pipefd[0]);

slaver();

std::cout << "process : " << getpid() << " quit" << std::endl;

// slaver(pipefd[0]);

exit(0);

}

// father

close(pipefd[0]);

// 添加channel字段了

std::string name = "process-" + std::to_string(i);

channels->push_back(channel(pipefd[1], id, name));

oldfds.push_back(pipefd[1]);

sleep(1);

}

}

void Debug(const std::vector<channel> &channels)

{

// test

for(const auto &c :channels)

{

std::cout << c._cmdfd << " " << c._slaverid << " " << c._processname << std::endl;

}

}

void Menu()

{

std::cout << "################################################" << std::endl;

std::cout << "# 1. 刷新日志 2. 刷新出来野怪 #" << std::endl;

std::cout << "# 3. 检测软件是否更新 4. 更新用的血量和蓝量 #" << std::endl;

std::cout << "# 0. 退出 #" << std::endl;

std::cout << "#################################################" << std::endl;

}

void ctrlSlaver(const std::vector<channel> &channels)

{

int which = 0;

// int cnt = 5;

while(true)

{

int select = 0;

Menu();

std::cout << "Please Enter@ ";

std::cin >> select;

if(select <= 0 || select >= 5) break;

// select > 0&& select < 5

// 1. 选择任务

// int cmdcode = rand()%tasks.size();

int cmdcode = select - 1;

// 2. 选择进程

// int processpos = rand()%channels.size();

std::cout << "father say: " << " cmdcode: " <<

cmdcode << " already sendto " << channels[which]._slaverid << " process name: "

<< channels[which]._processname << std::endl;

// 3. 发送任务

write(channels[which]._cmdfd, &cmdcode, sizeof(cmdcode));

which++;

which %= channels.size();

// cnt--;

// sleep(1);

}

}

void QuitProcess(const std::vector<channel> &channels)

{

for(const auto &c : channels){

close(c._cmdfd);

waitpid(c._slaverid, nullptr, 0);

}

}

int main()

{

LoadTask(&tasks);

srand(time(nullptr)^getpid()^1023); // 种一个随机数种子

// 在组织

std::vector<channel> channels;

// 1. 初始化 --- bug?? -- 找一下这个问题在哪里?然后提出一些解决方案!

InitProcessPool(&channels);

// Debug(channels);

// 2. 开始控制子进程

ctrlSlaver(channels);

// 3. 清理收尾

QuitProcess(channels);

return 0;

}总结:管道是Linux IPC的“入门钥匙”

从 struct file 到 task_struct 的底层关联,到 pipe() 系统调用的上层接口,再到进程管理和信号的边界控制——管道通信串联起了Linux内核数据结构、系统调用和进程协作的核心逻辑。

它或许不是最强大的IPC机制,但绝对是理解“Linux进程间如何协作”的最佳入门工具。掌握了管道,再去学习命名管道、消息队列、共享内存等IPC机制,会更加水到渠成。

希望本文能帮大家彻底吃透Linux管道通信,下次面对多进程协作场景时,能精准选择最适合的方案!

1871

1871

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?