介绍

本门课程是2020年李宏毅老师新课:Deep Learning for Human Language Processing(深度学习与人类语言处理)

课程网站

B站视频

公式输入请参考:在线Latex公式

先感叹一下这个巨大的模型,文章作者30+,文章页数70+,模型参数175亿,光下载下来要700+G,训练这个玩意不知道烧了多少钱。

之前BERT之类的预训练模型在进行下游任务的时候,还需要进行fine-tune,需要收集小部分和任务相关的数据,而GPT-3则想要省略这个步骤,直接使用。

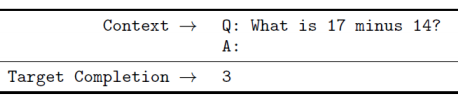

GPT-3的几种场景:中间就是要丢进模型的东西。

对42个任务进行了实验得到下面的结果:

下面来看几个典型的任务:

Closed Book QA

64个数据就可以拿SOTA

文本生成

文本生成没有zero shot的方式,需要给一个范文,就是一个标题,一个文章,然后再给一个标题,那么模型就要根据标题生成相应的文章内容,然后由人来判断文章是不是模型生成的,下图的横轴是模型的参数大小,纵轴是生成文章的置信度,越低表明人判断不是机器生成的概率越高。

造句

下面是模型造句的例子,最上面是一个完整的例子,造句分两个部分,第一部分是某个词的定义,第二个部分是用这个词造句。下面几个例子中的词都是不存在的,而模型依然可以正确的造出相应的句子。

数学计算

下图中横轴是参数的数量,纵轴是准确率,2位数和3位数的加减还行。

以上几个任务都是GPT-3比较好的,还有几个任务是不work的,例如:

NLI

这个任务就是判断两个句子的关系,例如:包含、中立、反对等。

GPT-3是一个LM,因此它在预测任务上表现较好,这里比较句子的任务中,通常出现的两个句子是比较怪的,因此GPT-3可能很少看见过类似句子,因此效果不好。

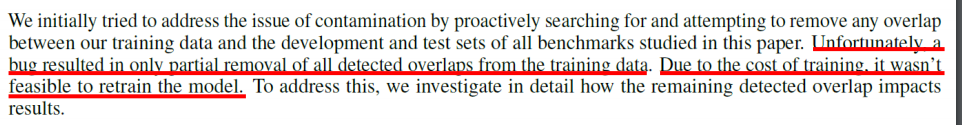

BUG

这段话的意思是,GPT-3比较大,在训练的时候用的training data是网上爬的,因此这些训练数据可能和testing data有overlap,这个相当于偷看过答案再去考试。。。但是模型太大,没法重新训练。前面提到训练一把估计就几亿美金。。。。为了解决这个问题,文章把testing data分成两种,一种是完全干净的(模型没有看过),一种是dirty data(模型可能看过的)然后得到下面这个图:

中间横线上方代表干净数据效果好,下放代表脏数据效果好,可以看到大多数任务都集中在横线附近,说明模型对于数据是否看过影响并不大。

Turing Advice Challenge

这个和GPT-3无关,是一个关于用NLP来给建议的一个任务,就是在论坛之类的网站上,有人给出各种提问、求助,然后有人在上面进行各种回复,得赞最高的就是ground truth,下面是结果:

这里还米有GPT-3的结果,但是从T5上看结果是不理想的,右边那个还不人类得赞最高的结果,是second best。

image GPT

GPT-3还可以用来图像生成,就是把图像里面的每一个像素看做一个序列,丢进模型中训练,下面是例子:

https://openai.com/blog/image-gpt/

355

355

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?