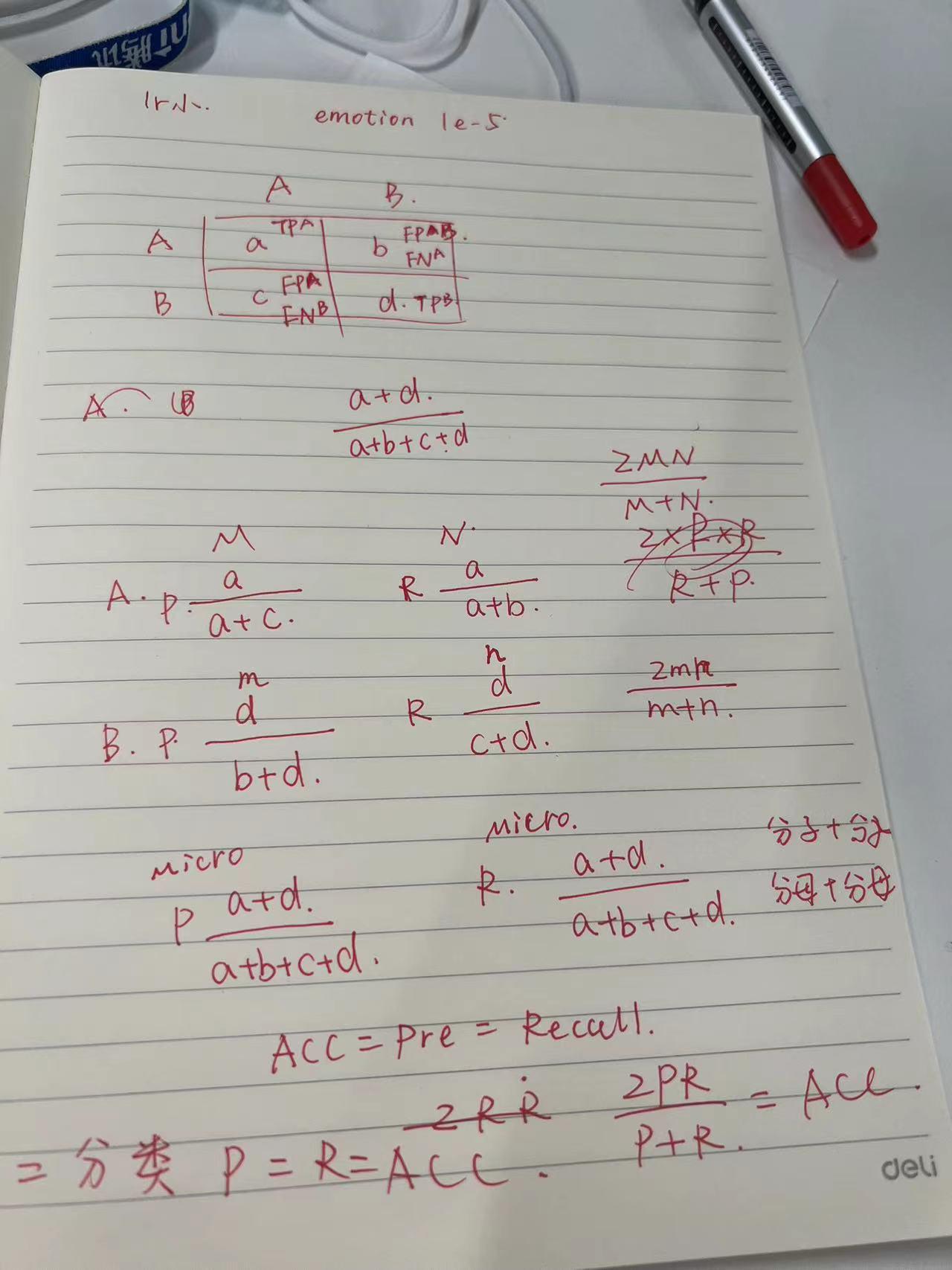

二分类的 macro的P=R=ACC,因此 macro F1 = ACC = 2PR/(P+R)。

在多分类里面,micro F1 = ACC

macro就是把所有的类别看成一体的,micro是分别求每个类然后取平均。

在二分类或者多分类一里面,一个分类结果对一个类来说可能是False positive,而对另一个类来说可能是False negative,注意有一个重叠关系,再比如一个类的true positive对另一个来说可能是true negative。就是因为计数的重叠性,才产生了F1和ACC可能会相等的情况。

macro的就不相等了,多分类问题,如果类别平衡,那其实用ACC足够了,如果类别不平衡,考虑F1或者AUC。

5878

5878

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?