为什么 OpenAI 变得越来越难以信任

OpenAI,一家以开发先进人工智能技术而闻名的公司,正面临越来越多的信任危机。近期,一些令人不安的迹象使人们对这家公司的透明度和安全性产生了质疑。

首先,在 OpenAI 的旧金山办公室外,有一些身份不明的秘密保安人员,这些人的出现给当地社区带来了不安。据《旧金山标准报》报道,邻近宠物店的收银员表示,OpenAI 的办公室有一种“秘密的氛围”,并且有员工看到类似秘密保安的男子站在大楼外,却不透露他们的雇主是 OpenAI 。一位邻近企业的员工说:“ OpenAI 不是一个坏邻居,但他们很秘密。”

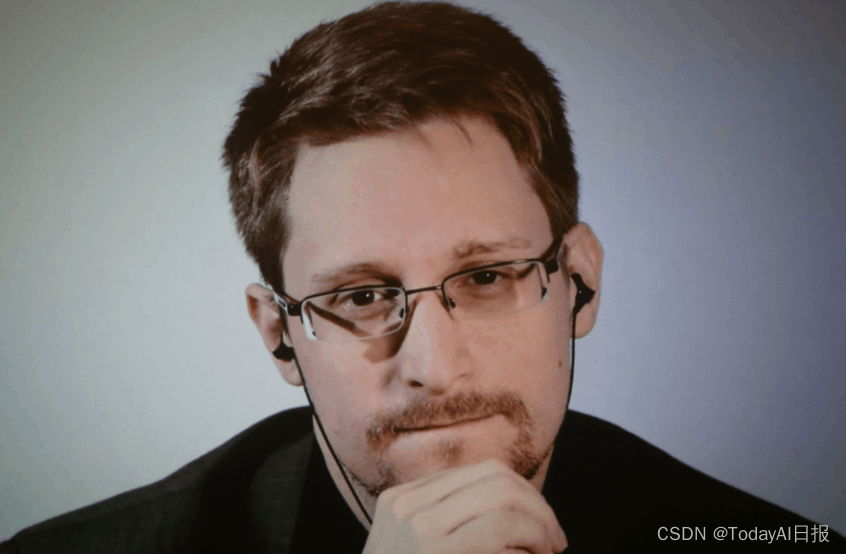

最近,OpenAI 宣布任命前美国国家安全局(NSA)局长 Paul Nakasone 进入董事会。Nakasone 不仅领导过 NSA ,还曾是美国网络司令部的负责人。OpenAI 表示,Nakasone 的聘用代表了公司对安全和保障的承诺,并强调了随着人工智能的发展,网络安全的重要性。

Nakasone 在一份声明中说:“ OpenAI 对其使命的奉献与我在公共服务中的价值观和经验高度一致。我期待为 OpenAI 确保通用人工智能的安全和造福全球人民的努力做出贡献。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?