随着大型语言模型(LLM)规模的持续扩大,其训练时间与计算资源需求急剧增加,给开发者带来了包括模型架构设计复杂、数据处理与预处理繁琐,以及梯度消失、梯度爆炸和过拟合等技术难题在内的重大挑战。此外,开发者还常面临计算资源利用不充分、模型调优复杂、训练过程难以复现及与最新研究成果同步困难等问题。因此,开发者迫切需要一套专为大型语言模型加速设计的综合工具套件,以简化训练流程,提高资源利用率。

在此背景下,昇腾AI打造面向大语言模型分布式训练的加速套件MindSpeed-LLM,集成了模型、算法以及各类开发工具链,致力于为开发者提供高效的训练算法与加速技术,以及多样化的高性能大模型解决方案,让开发更简单。

70+预训练模型开箱即用

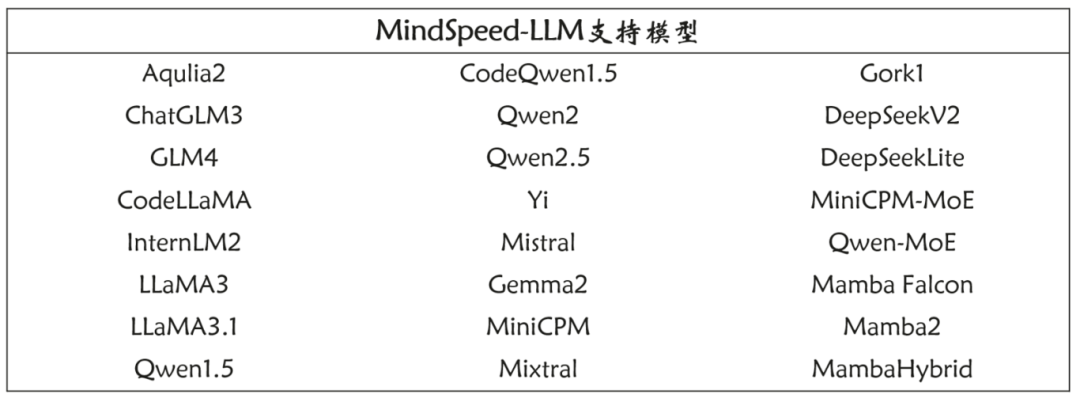

支持24个系列70+大模型,驱动多场景智能创新

表1 MindSpeed-LLM支持的模型

仓库提供完备的启动脚本和流程说明,使用户能够在不需深入理解底层实现的情况下,快速启动并运行模型。通过简洁直观的操作流程,用户只需下载模型并运行预配置的启动脚本,即可立即开始训练或推理。不仅如此,仓库还配备了详细的文档与示例代码,帮助开发者全面理解模型使用方法与最佳实践。我们希望通过积极的互动为用户提供全面的支持和合作机会。

图1 MindSpeed-LLM配备的使用指南

支持Transformer稠密模型与MoE (Mixture of Experts) 架构的有效结合,助力大模型突破性能瓶颈

随着模型规模的不断扩展,传统的稠密Transformer架构面临着计算资源与模型性能之间的瓶颈。与传统稠密Transformer相比,MoE能够有效提高计算资源的利用效率,使得模型在相同或更低资源投入下,依然保持出色的推理能力和响应速度。更重要的是,这种结合不仅简化了复杂模型的开发与训练流程,还使得大模型的可扩展性更具弹性,能够根据任务需求智能调整计算开销。通过这一技术融合,Transformer模型不再局限于以往的性能瓶颈,而是能够在更大规模、更复杂场景中持续保持卓越的表现。对于开发者而言,此架构不仅显著提升了性能,还极大减轻了计算资源与成本的负担,有效促进了大型模型在多样化应用场景中的商业化部署。

全流程LLM训练加速

仓库提供了LLM大模型完整的训练解决方案,涵盖Pretrain阶段的加速开发以及Posttrain阶段的指令微调与偏好对齐,实现模型全流程性能优化。

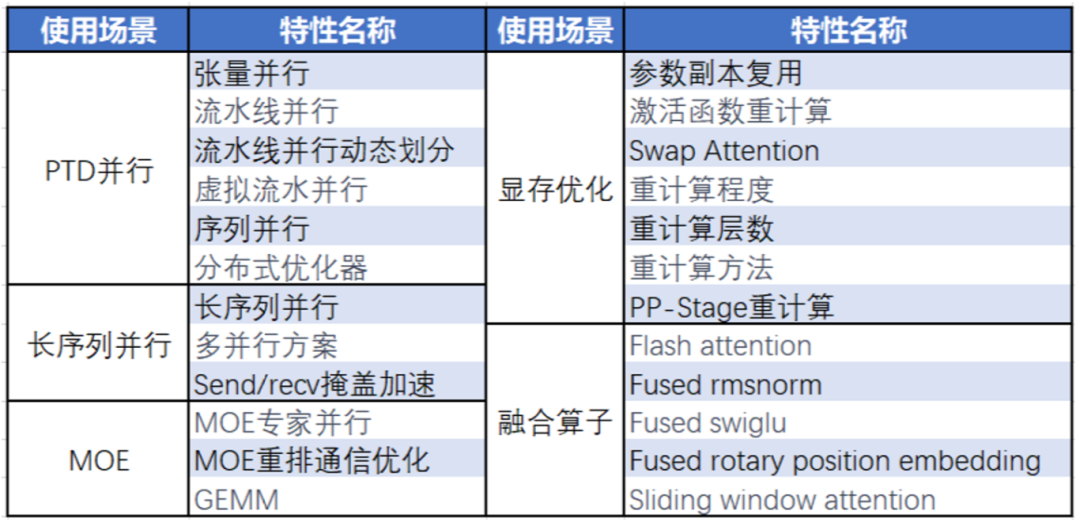

Pretrain阶段:支持多种并行加速和显存优化算法

在Pretrain阶段,系统集成了多种高效的分布式训练算法,支持张量并行和流水线并行等先进技术。这些并行化方法在处理大规模数据集和模型参数时,能够最大化计算资源的利用率,显著缩短训练时间。同时,融合算子技术进一步优化了计算效率,减少了冗余操作。此外,重计算技术的引入也极大地增强了显存优化能力。通过在反向传播过程中重新计算部分中间激活,而不是在前向传播时保存所有中间结果,有效减少了显存占用。因此,重计算与并行加速策略相结合,使得系统在大规模训练中能够达到更高的效率和更低的资源消耗。

表2 MindSpeed-LLM支持的训练加速技术和优化方法

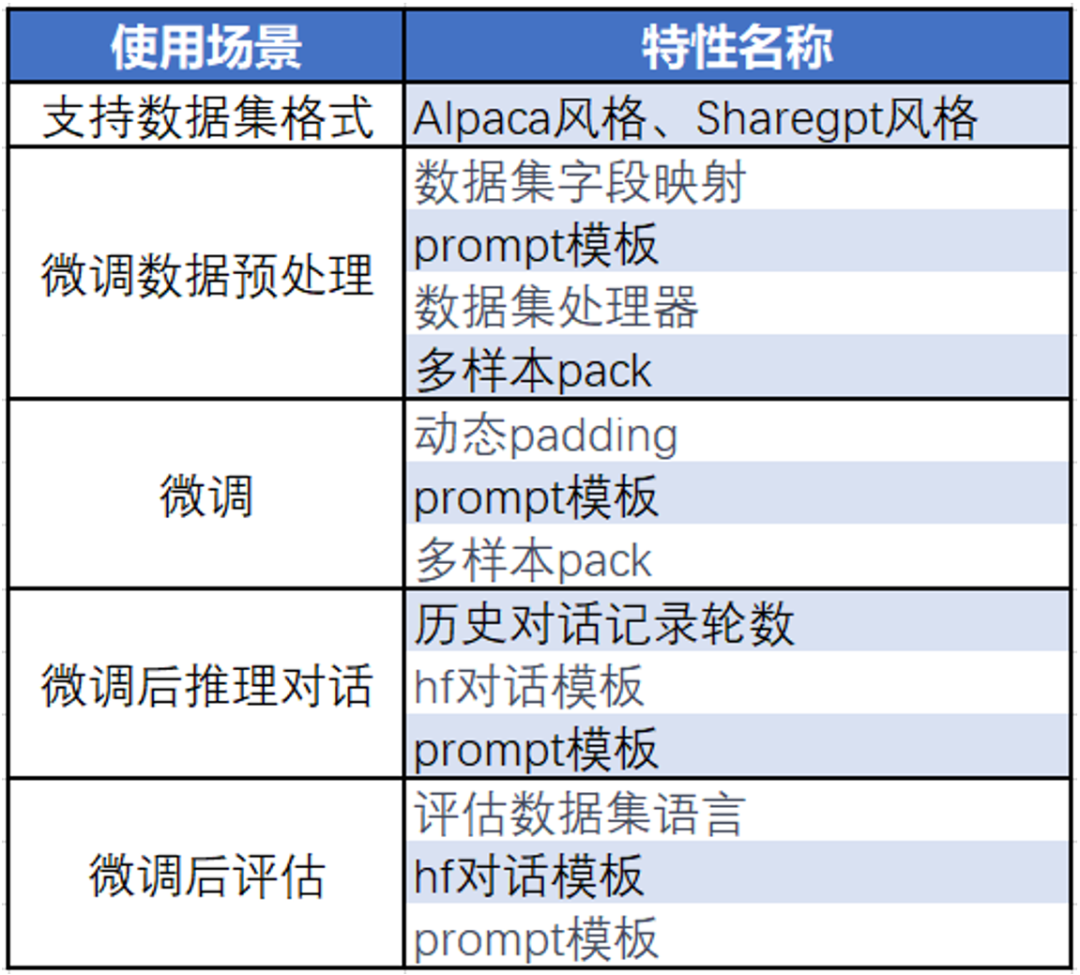

Posttrain阶段:指令微调与偏好对齐实现任务定制化

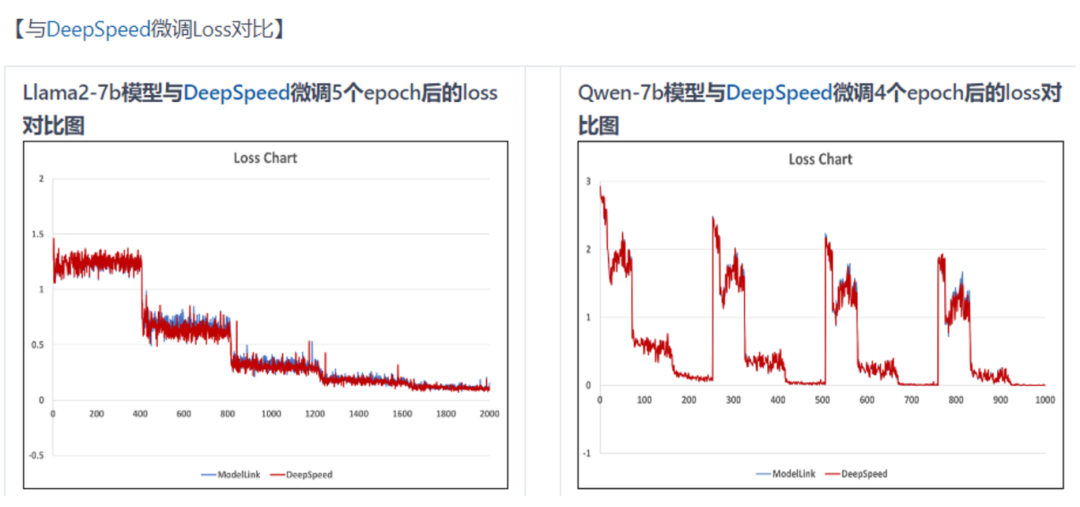

图2 MindSpeed-LLM与DeepSpeed微调Loss对比

Posttrain阶段的重点在于通过指令微调和偏好对齐技术,对大模型进行定制化优化。指令微调让模型能够在特定任务和场景中表现出更高的执行效率,确保其对用户输入的理解更加精准。而偏好对齐则通过学习用户的行为模式,使得模型输出更符合个性化需求。

表3 MindSpeed-LLM已支持的微调特性

即将上线的特性:

即将发布的LoRA、DPO、奖励模型、PPO等前沿特性,将进一步增强模型能力和灵活性。通过这些新特性,用户能够更好地进行模型优化和适配,满足多样化的应用需求,从而在人工智能领域取得更大的成功。

一站式LLM开发工具链

一站式LLM开发工具链支持大模型的数据处理、权重转换、推理评估及Profiling数据采集,并提供高可用性保障,帮助开发者更高效地管理与优化大模型。

权重转换

支持Hugging Face与MindSpeed-LLM之间的权重转换,确保用户能够方便地迁移和复用现有模型。通过简化转换流程,用户可迅速将模型适应不同的训练环境,从而提高开发效率。这一功能降低了在不同框架间操作的复杂性,使开发者能更专注于模型的优化和应用。

数据集处理

提供全面的数据集处理解决方案,涵盖预训练数据集和指令微调数据集的构建与处理。不仅支持多种数据格式,还能高效地进行数据清洗与预处理,确保数据质量。同时,用户能够利用丰富的示例和模板,快速创建符合特定需求的数据集,从而提升模型训练效果和适应性。

分布式推理

提供流式推理和人机对话的分布式推理能力,确保在实际应用中高效、快速地进行推理。这种灵活性使得系统能够实时响应用户请求,提升用户交互体验。

分布式评估

评估工具支持多种标准,包括MMLU、CEVAL、HumanEval、BBH、BoolQ和AGIEval,确保模型在不同维度上的性能表现。不仅可以帮助用户量化模型的能力,还能针对性地揭示模型的弱点和改进空间。通过系统的评估,用户能够更科学地选择和优化适合自身需求的模型。

MindStudio调试调优工具

配备MindStudio调试调优工具,支持Profiling采集、确定性计算和高可用性功能。该工具为模型开发和部署提供了强有力的保障,确保用户在使用过程中能够获得详尽的性能分析和优化建议。

MindSpeed-LLM简介

MindSpee-LLM是昇腾AI面向大模型分布式训练提供的语言大模型套件,仓库涵盖了模型、算法以及各类开发工具链,支持开箱即用及灵活组装开发。仓库配备了详细的使用指南和示例代码,欢迎加入和体验:

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

478

478

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?