序言

文中的文本及图片来自互联网,仅作学习培训、沟通交流应用,不具备一切商业行为,著作权归著作人全部,如不太好请立即在线留言以作解决。

今日来教大伙儿怎么使用Python来抓取博海拾贝的图片,归类储存,载入文本文档。

项目目标

建立一个文件夹名称, 归类储存全部文章内容图片。免费下载取得成功,数据显示控制面板。

项目分析报告

1、怎样寻找真实浏览的详细地址,多网页页面请求?

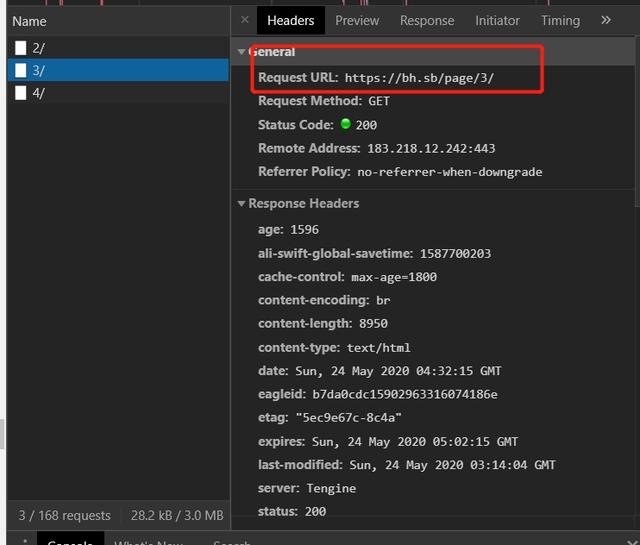

拖动电脑鼠标,观查网址,鼠标右键F12 。鼠标中键拖动载入新內容。如图所示:

点开任意网页页面 , 点开Request URL ,观查网址的规律性。

https://bh.sb/page/1/

https://bh.sb/page/2/

https://bh.sb/page/3/

https://bh.sb/page/4/

观查到,每提升一页page/{}/自提升1,用{}替代转换的自变量,再用for循环解析xml这网址,完成好几个网址请求。

2. 反爬解决

1)获得一切正常的 http请求头,并在requests请求时,设定这种基本的http请求头。

2)应用 fake_useragent ,造成任意的UserAgent开展浏览。

涉及到的库和网址

1、网址以下:

https://www.doutula.com/photo/list/?page={}

2、涉及到的库:requests、lxml、fake_useragent、time、os

3、手机软件:PyCharm

项目实施

1、大家界定一个class类承继object,随后界定init方式承继self,再界定一个主函数main承继self。导进必须的库和网址,建立储存文件夹名称。

import requests, os

from lxml import etree

from fake_useragent import UserAgent

import time

class bnotiank(object):

def __init__(self):

os.mkdir("图片") # 在创建文件夹 记牢仅有第一次运作再加,假如数次运作请注解掉行内。

def main(self):

pass

if __name__ == '__main__':

Siper=bnotiank()

Siper.main()

2、任意UserAgent ,结构请求头,避免 反爬。

ua = UserAgent(verify_ssl=False)

for i in range(1, 50):

self.headers = {

'User-Agent': ua.random

}

3、推送请求 ,获得回应,网页页面回调函数,便捷下一次请求。

'''推送请求 获得回应'''

def get_page(self, url):

res = requests.get(url=url, headers=self.headers)

html = res.content.decode("utf-8")

return html

4、界定parse_page涵数,获得二级网页页面详细地址,for解析xml获得必须的字段名。

def parse_page(self, html):

parse_html = etree.HTML(html)

image_src_list = parse_html.xpath('//p/a/@href')

# print(image_src_list)

5、对二级网页页面产生请求,xpath分析数据信息,获得大图片连接。

reo = parse_html1.xpath('//div//div[@class="content"]') #父节点

for j in reo:

d = j.xpath('.//article[@class="article-content"]//p/img/@src')[0]

text = parse_html1.xpath('//h1[@class ="article-title"] //a/text()')[0].strip()

6、请求图片详细地址,载入文本文档。

html2 = requests.get(url=d, headers=self.headers).content

dirname = "./d/" text ".jpg" #界定图取名

with open(dirname, 'wb') as f:

f.write(html2)

print("%s 【免费下载取得成功!!!!】" % text)

7、启用方式,完成作用。

url = self.url.format(page)

print(url)

html = self.get_page(url)

self.parse_page(html)

8、设定廷时。(避免 ip被封)。

time.sleep(1) """時间廷时"""

实际效果展现

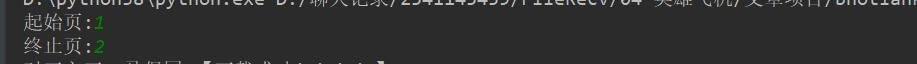

1、点一下翠绿色小三角运作键入起始页,停止页。

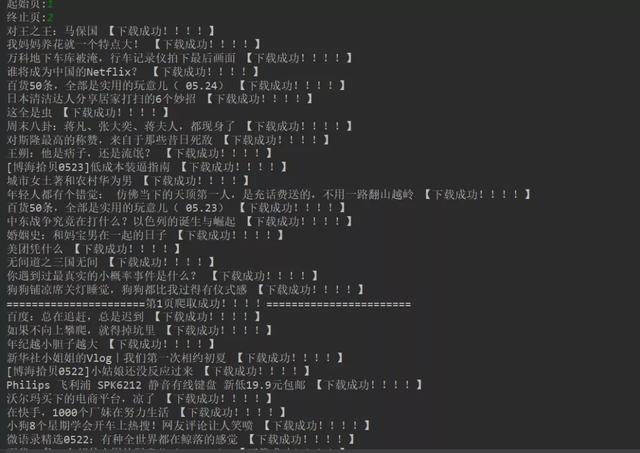

2、将免费下载取得成功信息内容显示信息在控制面板。

3、text 做为图片取名,展现实际效果以下所显示。

小结

1、不建议爬取过多数据信息,非常容易对网络服务器导致负荷,瞻前顾后就可以。

2、文中根据Python爬虫技术,叙述了反爬方法,运用网络爬虫库,完成了归类图片的获得,存进文本文档。

3、期待根据这一新项目,可以协助掌握xpath,字符串数组是怎样拼凑,format涵数怎样应用。

4、完成的情况下,都会有各式各样的难题,切忌好高骛远,勤动手能力,才能够了解的更为刻骨铭心。

文章来源于网络,如有侵权请联系站长QQ61910465删除

本文版权归趣快排营销www.SEOguruBLOG.com 所有,如有转发请注明来出,竞价开户托管,seo优化请联系QQ㊣61910465

208

208

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?