👉目录

1 混元 Large:参数规模最大、效果最好

2 混元 MoE 技术创新点

3 混元 3D 生成大模型:首个同时支持文字、图像生成 3D 的开源模型

11 月 5 日,腾讯混元一天内正式开源 2 大核心模型:MoE 模型“混元 Large”以及 3D 生成模型。各位开发者朋友可在 GitHub 、 Huggingface 等技术社区直接下载使用。

腾讯云 TI 平台和高性能应用服务 HAI 也同步宣布开放接入以上两大模型,为模型的精调、 API 调用及私有化部署提供一站式服务。

关注腾讯云开发者,一手技术干货提前解锁👇

01

混元 Large:参数规模最大、效果最好

腾讯混元 Large 的模型总参数量 389B,激活参数量 52B ,上下文长度高达256K,是当前业界参数规模最大、效果最好的 MoE 模型,同时通过技术的优化,也更适配开源框架的精调和部署,具有较强的实用性。

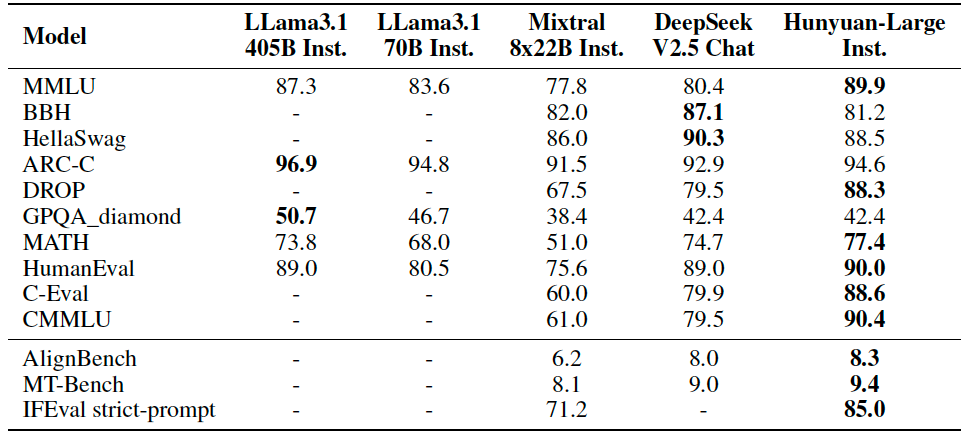

公开测评结果显示,腾讯混元 Large 在 CMMLU、MMLU、CEval、MATH等多学科综合评测集、中英文 NLP 任务、代码和数学等9大维度全面领先,超过 Llama3、Mixtral 等国外一流的开源大模型。

MoE(Mixture of Experts)结构是目前主流的大模型结构,MoE 模型的每一层都包含多个并行的同构专家,一次 token 的前向计算只会激活部分专家,推理成本远低于同等参数的稠密模型。

02

混元 MoE 技术创新点

1 、路由策略

路由策略是指把 token 分发给 MoE 中各个专家的策略,是 MoE 模型中至关重要的部分。业界常用的路由策略是 Top-K 路由,也就是将各个token按照其和专家的激活得分路由给各个专家。但是这种路由方式难以保障 token 在各个专家间平均分配,而那些超过专家负载的 token 则会被直接扔掉,不参与专家层的计算。这样会导致部分处理 token 较少的专家训练不稳定。

针对这一问题,腾讯混元 Large 中在传统 Top-K 路由的基础上进一步提出了随机补偿的路由方式。具体而言,腾讯混元 Large 会将因为专家满负载原本会扔掉的 token,随机路由到其他仍有负载冗余的专家,这样一来,模型内各专家在训练时还会有少量随机 token 参与梯度更新。

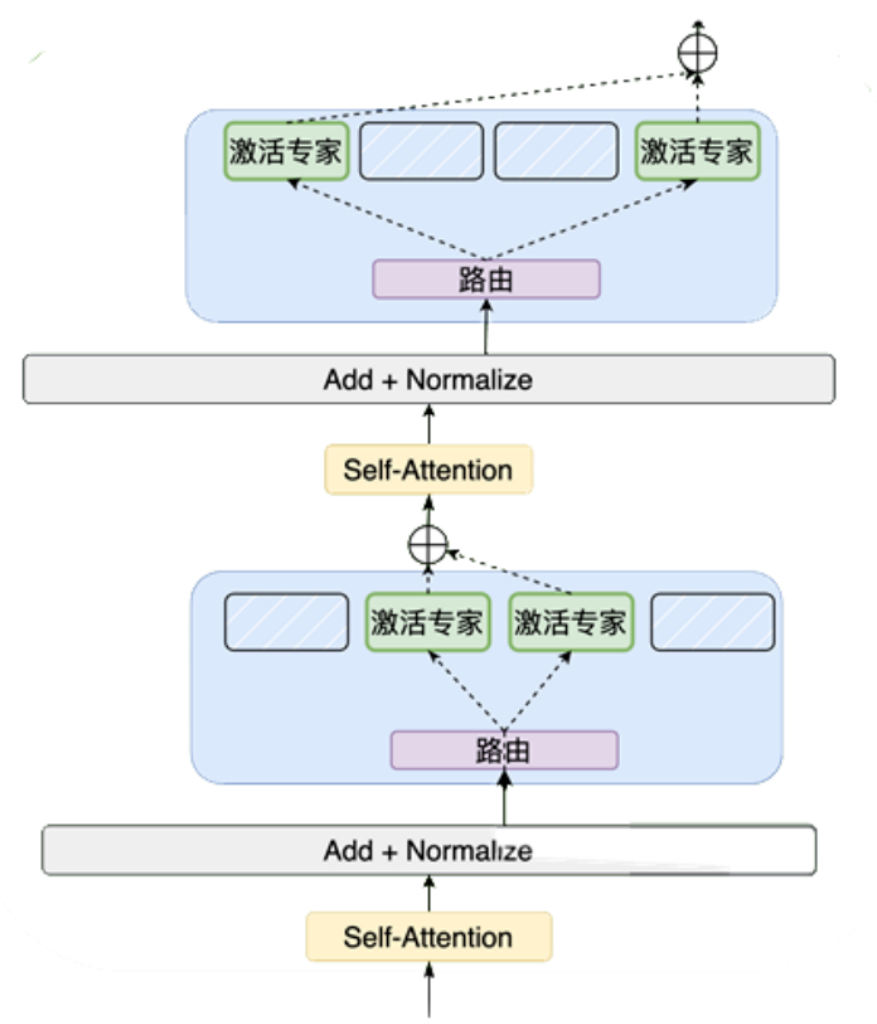

总体来说,腾讯混元 Large 的专家层中,设置一个共享专家来捕获所有 token 所需的共同知识,还设置了16个需要路由的专家,模型将每个 token 路由给其激活得分最高的专家来动态学习特定领域的知识,并通过随机补偿的路由保障训练稳定性。

2 、合成数据&长文

大语言模型的成功与高质量的训练数据密不可分,腾讯混元 Large 模型对数据瓶颈的解决方法之一就是使用高质量的合成数据。

它在天然文本语料库的基础上,通过混元内部系列大语言模型研发了一套自动化的合成数据获取、筛选、优化数据链路,构建了覆盖数十个类目,高质量、高多样性、大量级的中英文合成数据、显著提升了模型通用效果。

对于长文领域,混元 Large 通过引入多阶段预训练和退火机制,使得模型仅使用少量长文合成语料,即可获得较好的长文效果,显著提升模型长文外推能力。

3 、两种 KV Cache 压缩策略

随着 LLM 处理序列逐渐增长,Key-Value Cache 占用内存过大的问题日益突出,为推理成本和速度带来了挑战。为了提高推理效率,混元 Large 模型使用 Grouped-Query Attention (GQA) 和 Cross-Layer Attention (CLA) 两种 KV Cache 压缩策略,从 head/layer 两个维度联合压缩 KV cache 引入量化技术,进一步提升压缩比。最终将模型的 KV Cache 压缩为MHA的5%,大幅提升推理性能。

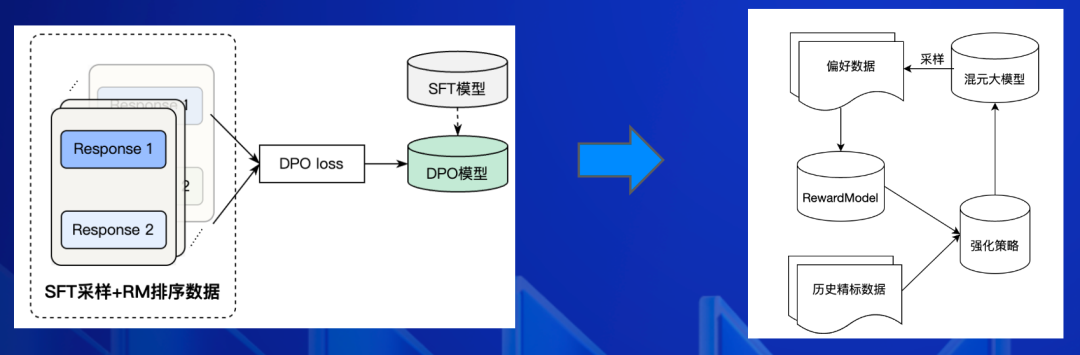

腾讯混元 Large 在 Post-Train 方面做了大量创新优化。面对 SFT 通用领域繁多,数学、代码高质量指令数据获取困难,业界广泛采用的离线 DPO,强化策略效果上限不高,泛化性弱等挑战,腾讯混元 Large 模型分门别类提升数学、逻辑推理、代码等能力,另外在一阶段离线 DPO 的基础上引入了二阶段在线强化策略。

2024 年年初,腾讯混元在国内率先上线 MoE 架构模型,模型总体性能相比上一代 Dense 模型提升 50%。随后,腾讯混元推出了基于 MoE 架构的多模态理解大模型,在架构、训练方法和数据处理方面的创新和深度优化让其性能再次得到显著提升。9 月,混元大模型架构再次得到全新升级,最新推出的 MoE 结构大模型“混元 turbo”在性能、效果、速度等多个领域有突出表现。

本次开源的腾讯混元 Large 全面探索了 MoE ScalingLaw。在模型结构和训练策略方面,腾讯混元 Large 进行了 MoE 共享专家路由、回收路由等路由策略上的创新,并引入了专家特化的学习率适配训练策略,有效提升不同专家的利用率和稳定性,带来模型效果的提升。

在大模型的核心节点上,腾讯混元 Large 模型实现了全链路自研,其训练和推理均基于腾讯 Angel 机器学习平台。

针对 MoE 模型 All2all 通信效率问题,Angel 训练加速框架(AngelPTM)实现了 Expert 计算和通信层次 overlap 优化、MOE 算子融合优化以及低精度训练优化等,性能是 DeepSpeed 开源框架的2.6倍。针对模型推理加速,腾讯 Angel 机器学习平台和腾讯云智能联合研发 AngelHCF-vLLM 框架,在开源框架 vLLM 的基础上适配腾讯混元 Large 模型,持续通过叠加 NF4 和 FP8 的量化以及并行解码优化,在最大限度保障精度的条件下,节省50%以上显存,相比于业界主流的 BF16 吞吐提升1倍以上。

目前,腾讯混元 Large 模型已上架腾讯云 TI 平台,支持业务在线精调专属模型。同时,腾讯混元大模型 PaaS 平台也开放支持包含混元 Large 模型在内的十余种混元 API 服务调用,满足业务对于不同模态(文生文、图生文、文生图)、不同专项(角色扮演、functioncall、代码等)的模型需求。

2.1 腾讯混元 Large-访问地址

github(开源模型工具包):

https://github.com/Tencent/Hunyuan-Large

huggingface(模型卡片&模型上传):

https://huggingface.co/tencent/Hunyuan-Large/tree/main

huggingface demo 地址:

https://huggingface.co/spaces/tencent/Hunyuan-Large

03

混元 3D 生成大模型:首个同时支持文字、图像生成 3D 的开源模型

划重点:这是业界首个同时支持文字、图像生成3D的开源大模型!

腾讯混元 3D 生成大模型具有强大泛化能力和可控性,可重建各类尺度物体,大到建筑,小到工具花草。

在两个公开的 3D 数据集 GSO 与 OmniObject3D 上,腾讯混元 Hunyuan3D-1.0 效果优于主流开源模型,整体能力属于国际领先水平。从定性角度评估Hunyuan3D-1.0 与 SOTA 开源模型的 3D 生成效果表现,包括几何细节、纹理细节、纹理-几何一致性、3D合理性、指令遵循等评价维度,结果显示,Hunyuan3D-1.0 在生成质量上全面超过了 SOTA 开源模型。

在腾讯,3D 生成相关技术已经开始应用于 UGC 3D 创作、商品素材合成、游戏 3D 资产生成等司内业务及场景。

3.1 腾讯 3D 模型访问地址

官网地址:

https://3d.hunyuan.tencent.com/

Github 项目地址:

https://github.com/Tencent/Hunyuan3D-1

Hugging Face 模型地址:

https://huggingface.co/spaces/tencent/Hunyuan3D-1

本次两大核心模型的开源,是腾讯混元继文生图大模型开源后的又一力作,也是腾讯混元拥抱开源,用技术反馈社区的一大成果。接下来,腾讯混元也会继续保持开放,将更多经过腾讯应用场景检验的模型开源出来,促进大模型生态的繁荣发展。

未来腾讯云开发者社区也将与混元大模型团队带来更多深入的技术解读,敬请大家保持关注!

-End-

原创作者 | 腾讯云开发者

还有哪些混元技术是你想了解的?欢迎评论分享。我们将选取点赞本文并且留言评论的一位读者,送出腾讯Q哥公仔1个(见下图)。11月13日中午12点开奖。

📢📢欢迎加入腾讯云开发者社群,享前沿资讯、大咖干货,找兴趣搭子,交同城好友,更有鹅厂招聘机会、限量周边好礼等你来~

(长按图片立即扫码)

497

497

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?