在自然语言处理(Natural Language Processing, NLP)的领域,大型语言模型(Large Language Models, LLMs)已经取得了令人瞩目的成就,它们使得文本生成、摘要和问答等应用成为现实。但是,这些模型依赖于基于令牌(token)级别的处理——即一次预测一个词——这种方式面临着挑战。这种方法与人类交流的方式不同,人类交流往往在更高的抽象层次上进行,比如整个句子或完整的想法。

在需要长期上下文理解的任务中,基于令牌级别的建模也显得力不从心,可能会产生不一致的输出。此外,将这些模型扩展到多语言和多模态应用在计算和数据上都是昂贵的。为了解决这些问题,Meta AI 的研究人员提出了一种新方法:大型概念模型(Large Concept Models, LCMs)。

大型概念模型

Meta AI 的大型概念模型(LCMs)代表了从传统大型语言模型架构的转变。LCMs带来了两项重大创新:

-

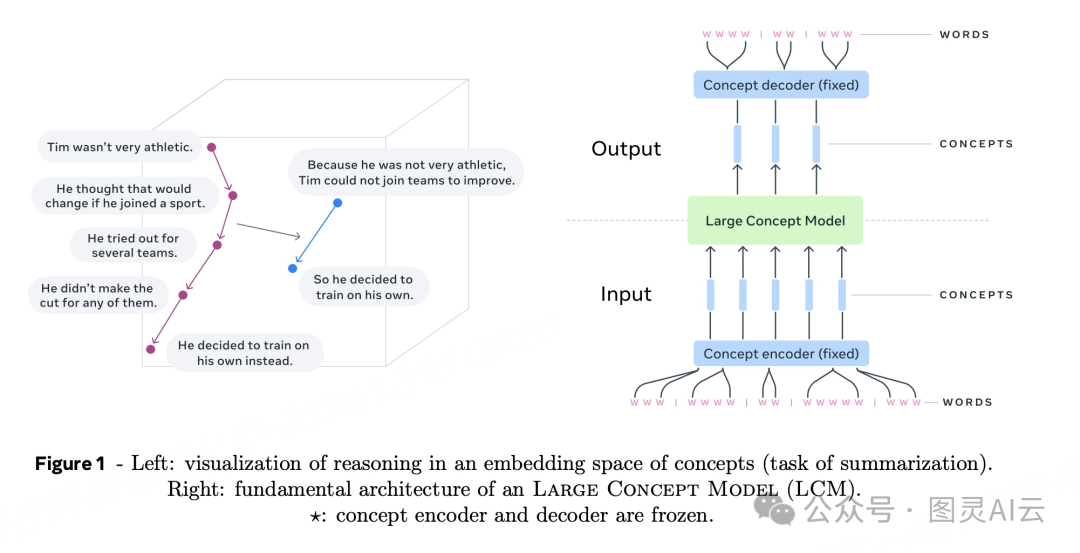

高维嵌入空间建模: 与在离散令牌上操作不同,LCMs在高维嵌入空间中执行计算。这个空间代表了抽象的意义单元,称为概念,对应于句子或话语。SONAR,一种高维嵌入空间,它被设计成对语言和模态不敏感,支持超过200种语言和多种模态,包括文本和语音。

-

语言和模态不可知建模: 与特定语言或模态绑定的模型不同,LCMs在纯粹的语义层面上处理和生成内容。这种设计允许在语言和模态之间无缝过渡,实现强大的零样本泛化。

LCMs的核心是概念编码器和解码器,它们将输入句子映射到SONAR的嵌入空间,并将嵌入解码回自然语言或其他模态。这些组件是固定的,确保模块化和易于扩展到新的语言或模态,而无需重新训练整个模型。

LCMs的技术细节和优势

LCMs引入了几项创新以推进语言建模:

-

层次结构: LCMs采用层次结构,反映了人类的推理过程。这种设计提高了长形式内容的连贯性,并允许在不破坏更广泛上下文的情况下进行局部编辑。

-

基于扩散的生成: 扩散模型被确定为LCMs最有效的设计。这些模型基于前面的嵌入预测下一个SONAR嵌入。探索了两种架构:

-

单塔: 单个Transformer解码器同时处理上下文编码和去噪。

-

双塔: 将上下文编码和去噪分开,每个任务都有专门的组件。

-

-

可扩展性和效率: 概念级建模比基于令牌的处理减少了序列长度,解决了标准Transformers的二次复杂性问题,使得长上下文的处理更加高效。

-

零样本泛化: LCMs表现出强大的零样本泛化能力,通过利用SONAR广泛的多语言和多模态支持,在未见过的语言和模态上表现良好。

-

搜索和停止标准: 一个基于“文档结束”概念距离的搜索算法和停止标准,确保了生成的连贯性和完整性,而无需微调。

实验结果的洞见

Meta AI的实验突出了LCMs的潜力。一个扩展到70亿参数的基于扩散的双塔LCM在摘要等任务上展现了竞争力。关键结果包括:

-

多语言摘要: LCMs在多语言零样本摘要中超越了基线模型,展示了它们的适应性。

-

摘要扩展任务: 这个新颖的评估任务展示了LCMs生成扩展摘要的能力,保持了连贯性和一致性。

-

效率和准确性: LCMs比基于令牌的模型更有效地处理更短的序列,同时保持准确性。互信息和对比准确度等指标显示出显著的改进,如研究结果中详细说明的。

结论

Meta AI的大型概念模型为传统的基于令牌的语言模型提供了一个有希望的替代方案。通过利用高维概念嵌入和模态不可知处理,LCMs解决了现有方法的关键限制。它们的层次结构增强了连贯性和效率,而强大的零样本泛化扩展了它们在多种语言和模态中的应用。随着对这个架构研究的继续,LCMs有潜力重新定义语言模型的能力,为AI驱动的通信提供一种更可扩展和适应性强的方法。

详见论文:https://arxiv.org/pdf/2412.08821

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?