文章目录

- 03 | 为什么“高兴”接近“开心”?Embedding空间中的语义分布揭秘

- 一、语义如何转化为空间?

- 二、向量空间中的“靠近”是怎么来的?

- 三、词义相近与空间距离的映射关系

- 在 embedding 空间中:

- 四、结构几何的语义美感

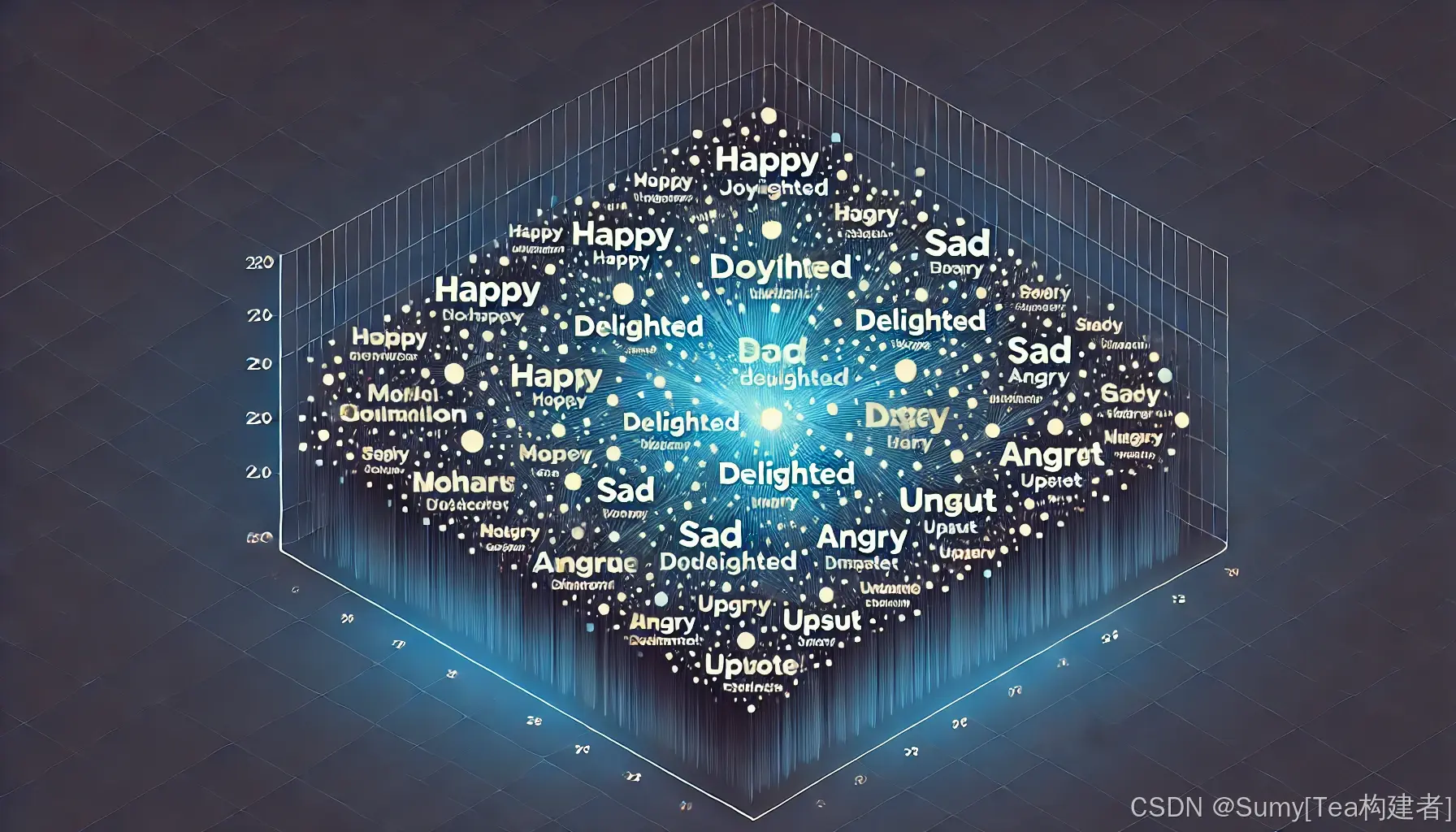

- 五、视觉示例:语义空间聚类图

- 六、实际应用场景举例

- 七、总结

03 | 为什么“高兴”接近“开心”?Embedding空间中的语义分布揭秘

副标题:token在语义空间的“站位规则”与几何解释—

一、语义如何转化为空间?

GPT模型并不能直接理解“高兴”或“开心”的情感含义,它所能做的,是通过训练数据中上下文共现的统计规律,在高维空间中学习这些词的“位置关系”。这些位置(即embedding向量)会自然聚集出语义相似的簇。—

二、向量空间中的“靠近”是怎么来的?

以以下语料为例:

他今天很高兴。 她回家非常开心。 大家都感到无比快乐。

模型观察到这些句子具有相似结构和上下文,那么:

- “高兴”、“开心”、“快乐”常在相似位置出现;

- 它们的 token 向量在训练中会收到相似的误差信号;

- 结果是:它们在高维空间中向同一方向收缩靠近。

这种过程无需人工标注,模型仅通过统计+梯度优化自组织出了语义结构。

三、词义相近与空间距离的映射关系

在 embedding 空间中:

| 词语对 | 欧式距离(示意) | 语义解释 |

|---|---|---|

| 高兴 - 开心 | 0.13 | 同义词,语境高度重合 |

| 高兴 - 生气 | 0.57 | 情感相反 |

| 高兴 - 苹果 | 0.89 | 语义无关 |

距离越近,表示模型越容易在语境中“互换”这些词。

四、结构几何的语义美感

Embedding 向量不是随机分布,而具有以下几何规律:

- 情感维度聚类:喜怒哀乐分别形成不同语义子空间;

- 时态变形方向一致:如 walk → walked → walking 向量差值近似一致;

- 语言结构映射方向:如 man → woman 与 king → queen 的差向量近似。

这种结构性,是语言统计规律通过模型训练自动浮现的产物。

五、视觉示例:语义空间聚类图

可参考下图所示的词向量空间分布(使用 t-SNE 降维):

同类词语明显在同一区域形成语义簇,如:

- 喜悦类:“高兴”、“开心”、“快乐”、“愉快”

- 悲伤类:“伤心”、“悲伤”、“难过”

- 时间类:“今天”、“明天”、“昨天”

六、实际应用场景举例

-

文本相似度计算:

“我很高兴”和“我很开心”可以在语义空间中余弦相似度极高; -

同义词推荐:

自动推荐表达替换,不依赖人工词典; -

语义搜索系统:

用户搜索“悲伤”,可返回带“难过”的语句。

七、总结

Embedding 空间不是黑箱,而是有秩序、有几何结构的语义地图。

GPT 模型正是借助这张地图,在“看起来只是数字”的世界中,建立了强大的语义认知能力。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?