基于SVM的美女图像分类

此项目并没有大伙想的这么复杂,算法我们可以站在巨人的肩膀上直接调用,或者copy过来就行,可能在获取数据、清洗数据方面有点小繁琐

需要准备技能包

- 本项目采用的开发语言是python,所以读者要有最基本的python知识储备

- 分类算法是sklearn中的SVM,提取图片的特征值是用HOG特征,不懂没关系,直接调用人家写好的就行

- 会用python爬取数据(这里的数据是美女图片)

- 知道如何清洗数据(比如去掉空值、无用值)

废话不多逼逼,直接开干

1. 准备需要分类的图片

美女图片哪里来呢????

在这个地址里有:美女图片链接

里面还有大众的评分,这个可以为我们以后进行美女分类提供依据

2. 获取每个链接(图片)URL

- 如何爬取网页的page??这个不要问我,直接看网上资源

- 怎么用正则表达式、BeautifulSoup怎么用? 这个也不要问我

- …………问题总是一大堆?(我想说:先让项目跑起来,至于后面不会的知识,面向百度编程就可以了)

获取成功并插入Excel表中后的样子:

数据清洗后长这样(去掉无用值):

3. 根据URL获取图片

获取到图片统一放在一个images文件夹里:

只截取了其中的一部分图片

3. 美女分类

分类的依据是什么?

我们根据大众的评分,将美女分成三类:女神级别>9.0 大众级别>8.5 普通级别<8.5

分完类之后长这样:

4. 美女图片格式化

- images中的图片大小是不统一的,分类后相应文件里的图片也是没有经过格式化的

- 为了方便提取图片特征以及后面模型的训练,故需对图片进行统一化处理

格式化的样子长这样:

拿女神级别的来展示

将三个类别的图片分别格式化,然后放在三个文件夹里:

5. 训练模型:

- 三个类别分别用1,2,3代替,1代表女神级别,2代表大众级别,3代表普通级别

- 这里需要准备训练的图片,我将其60张图片放置在practice_Img文件夹中。60张图片分别来自三个类别,每个类别各20张。

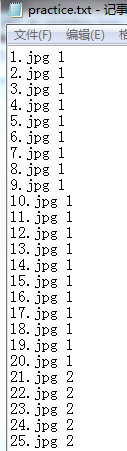

- 既然要让机器(电脑)去训练,那就必须事先告诉这个机器,每一张是属于那个类别的,所以事先将训练集中的类别放置在practice.txt中,里面有每一张图片对应的类别

- 将数据导入SVM训练模型函数中,让机器去训练

practice.txt 长这样(展示其中的一部分):

6. 模型预测:

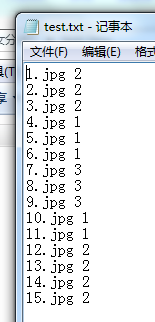

- 准备好需要预测的图片,这里将15张预测图片放置在test_Img文件夹中。15张图片分别来自三个类别,每个类别各5张。

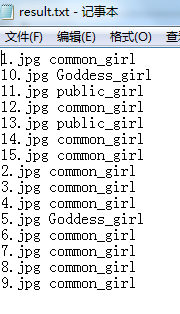

- 同理,我们要知道机器(电脑)预测的准不准确,那就必须保存需预测图片的正确类别,正确类别存放在test.txt中,然后让机器预测的类别跟标准类别来对比,从而得出预测的准确率,并将预测值写到result.txt中。

test.txt 长这样:

结果(result.txt):

7. 模型准确率:

- 将result.txt与标准类别test.txt一对比就能够得到模型的准确率了

看图:

完整代码奉上:

catchData.py 爬取数据并插表

import requests

import urllib.request as rq

import os

import re

import xlrd

import xlutils.copy

from bs4 import BeautifulSoup

# 获取html文本

def getHtml(url):

session = requests.Session()

headers = {

"User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_9_5) AppleWebKit 537.36 (KHTML, like Gecko) Chrome"

}

req = session.get(url, headers=headers)

html = req.text

return html

# 图片url列表

def getImg(html):

Null_img_list = []

reg = r'img src="([.*\S]*\.jpg)"' # 正则表达式

imgre = re.compile(reg)

imglist1 = re.findall(imgre, html)

if len(imglist1) > 2:

return imglist1

else:

return Null_img_list

# 获取女生姓名

def getName(html):

reg = r'<strong>今日女神:(.*?)</strong>'

textRe = re.compile(reg)

textList = re.findall(textRe, html)

return textList

# 获取本期的女神的名字和期数

def getNumb_name(number, html):

GoddessName = getName(html)

if GoddessName == []:

print("女神大会" + number + ":" + "空")

else:

print("女神大会" + number + ":" + GoddessName[0])

# 获取期刊标题

def getTitle(html):

soup = BeautifulSoup(html, "html.parser")

titleList = soup.find_all('a', {

'target': '_self', 'content': ''})

titleListLength = len(titleList)

if titleListLength > 1:

title = str(soup.find_all('a', {

'target': '_self', 'content': ''})[1].string)

elif titleListLength == 1:

title = str(soup.find_all('a', {

'target': '_self', 'content': ''})[0].string)

else:

title = "没有获取到该期刊的标题"

return title

# 获取女神评分

def getGrade(html):

NullGrade = ["没有获取到评分"]

reg = r'<span style="color:#ff0000">综合得分(.*?)</span>'

GradeRe = re.compile(reg)

GradeList1 = re.findall(GradeRe, html)

reg = r'<strong>综合得分(.*?)</strong>'

GradeRe = re.compile(reg)

GradeList2 = re.findall(

基于SVM的美女图像分类此项目并没有大伙想的这么复杂,算法我们可以站在巨人的肩膀上直接调用,或者copy过来就行,可能在获取数据、清洗数据方面有点小繁琐需要准备技能包本项目采用的开发语言是python,所以读者要有最基本的python知识储备分类算法是sklearn中的SVM,提取图片的特征值是用HOG特征,不懂没关系,直接调用人家写好的就行会用python爬取数据(这里的数据是美女...

基于SVM的美女图像分类此项目并没有大伙想的这么复杂,算法我们可以站在巨人的肩膀上直接调用,或者copy过来就行,可能在获取数据、清洗数据方面有点小繁琐需要准备技能包本项目采用的开发语言是python,所以读者要有最基本的python知识储备分类算法是sklearn中的SVM,提取图片的特征值是用HOG特征,不懂没关系,直接调用人家写好的就行会用python爬取数据(这里的数据是美女...

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

727

727

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?