这个算法李航在《统计学习方法》上说的比较好:

“EM算法是一种迭代算法,用于含有隐变量的概率模型产生的极大似然估计,或极大后验概率估计。”

Q函数:完全数据的对数似然函数

logP(Y,Z|θ

)关于在给定观测数据Y和当前参数

θi

下对未观测数据Z的条件概率分布

P(Z|Y,θi)

的期望称为Q函数,即

Q(θ,θi)=EZ[logP(Y,Z|θ)|Y,θi]

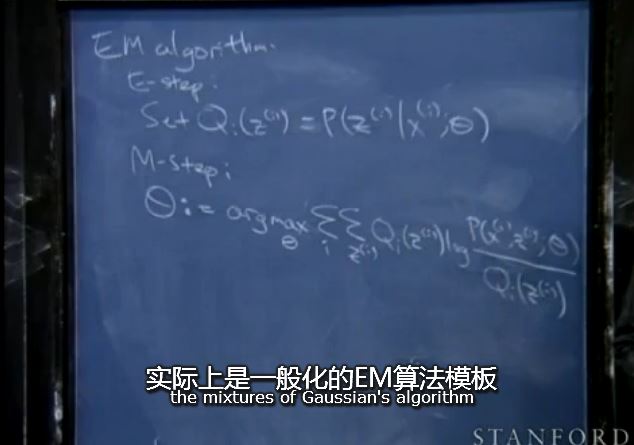

E step:

计算

Q(θ,θi)=EZ[logP(Y,Z|θ)|Y,θi]

M step:

θi+1=argmaxθQ(θ,θi)

需要注意的是,李航的那句话确实有助于记忆理清算法步骤,但是我觉得更好的explanation建议看Andrew N.g CS229的notes 8(对应lecture12). 下面把几个关键点贴上:

由下图可以看到,EM确实是极大似然估计(和文首李航说的一样)。并且设隐变量服从Q分布,由琴生不等式得到下界

可是,世上的分布函数那么多,怎么选择Q分布作为隐变量的分布函数呢?EM的原则是,根据琴生不等式,选择一个Q分布使得不等式取到等号!这样就可以在后续的M-step中,通过寻找 θ 最大化这个紧下界来提升似然概率(也就是上图(1)式等号左边的式子)。

M-step完了之后,再用新的 θ 来更新Q分布(这就是E-step).就这样不断的迭代EM两步,E-step使(3)式取到等号,M-step最大化下界(也就是(3)的右边,这时候(3)又变成大于等于),然后又E-step取到等号……

简单说就是设Z服从 Q(Zi) 的分布,用Jensen不等式构造 logP(Y|θ) 的紧下界,由此(下界函数紧时,也就是取到等号时)可以得出 Q(Zi) 的分布形式;然后就是M步优化 θ 最大化下界了。

对于上图,其实M-step与李航的M-step是等价的,只是写法不同而已。

总的来说,EM算法记住两句话:

1,EM算法是一种迭代算法,用于含有隐变量的概率模型产生的极大似然估计,或极大后验概率估计。

2,E步:求Q函数,其实就是构造紧下界函数

(记住是“紧”,紧相当于Jensen不等式取到等号,从而得到

Q(Zi)

分布,从而可以求完全数据对数似然函数

logP(Y,Z|θ)|Y,θi)

关于

Q(Zi)

的期望,也就是Q函数,两个Q不要搞混了。。。前者是

Q(Zi)

分布,后者才是Q函数)

3,M步:求

θi+1=argmaxθQ(θ,θi)

应用在高斯混合模型,混合模型可以由任意概率密度代替,我们常用的是高斯混合模型。

要区别高斯混合模型和高斯判别模型。高斯判别模型认为数据由某一个(记住是一个!)高斯函数生成;高斯混合模型认为数据是由一堆加权组合的高斯模型生成。

1274

1274

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?