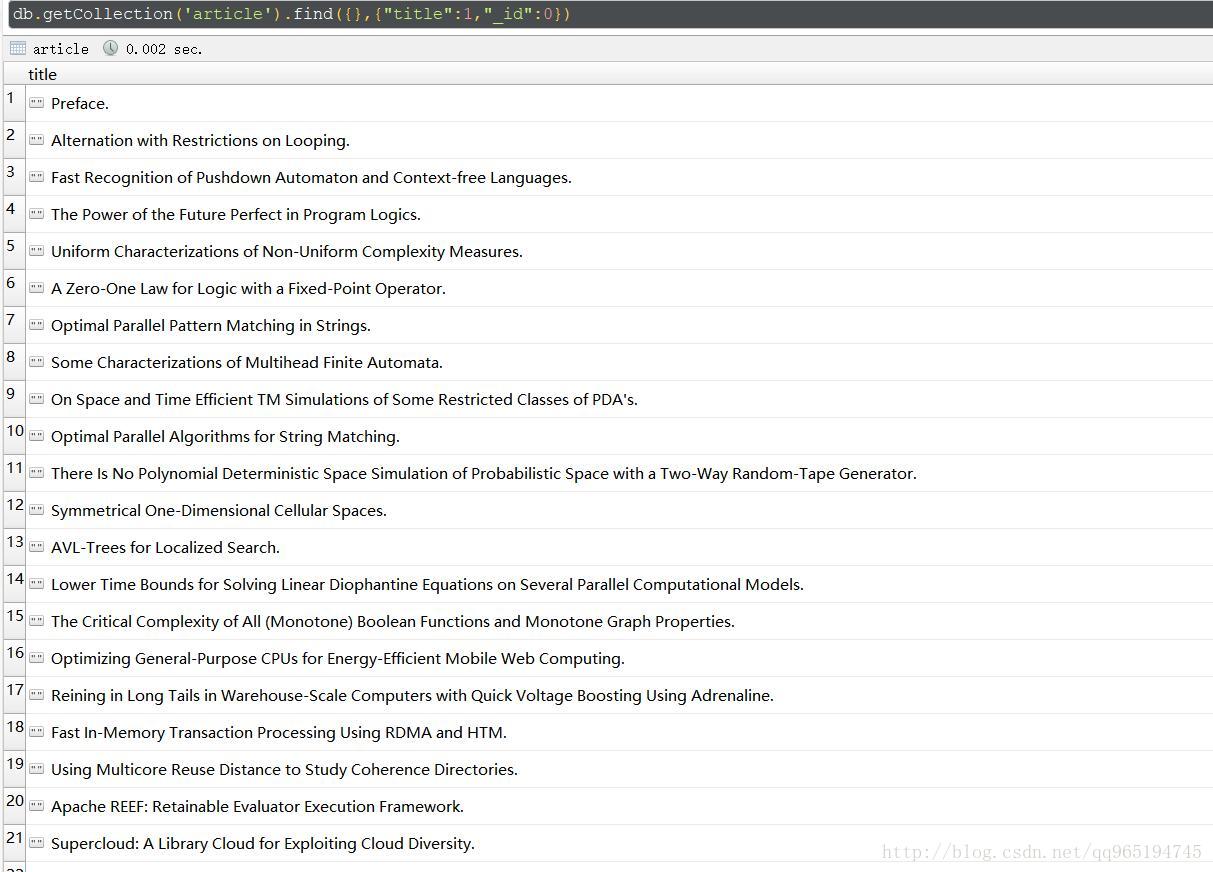

数据

这是大量的论文文章的标题

思维方法

所谓标签指的就是有些共同的特征,所以不能局限于一个文章标题,要全局考虑

文章标题中很多停用词(stopwords)以及标点符号应该去除

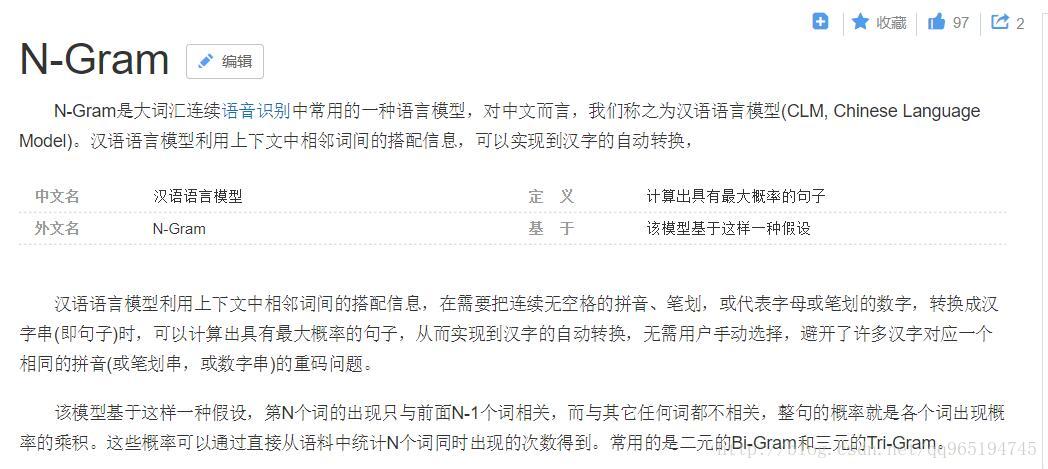

ngram模型

有了上述条件就可以粗略的寻找文章的标签了

工具

使用python以及python的nltk自然语言处理库非常方便

这个是nltk中文文档

方法1

按照上述思路借助nltk库进行

import re

from pymongo import MongoClient

client = MongoClient("192.168.33.131", 27017)#连接数据库取用数据

db = client.ccf.article.find()

text = ""

for a in db:

text += " " + a['title']#将标题拼接成一个文本

from nltk import word_tokenize, bigrams#使用nltk的英文分词以及2gram模型

from nltk.corpus import stopwords#停用词

list_stopWords = list(set(stopwords.words('english')))#获取英文停用词数据

text = text.lower()#小写转换方便分析

text = re.sub(r'[{}]+'.format(":,.?"), ' ', text)#用正则表达式去除无用的符号

text = word_tokenize(text)#分词技术

text = [w for w in

本文介绍了如何通过去除停用词和标点符号,运用ngram模型和nltk库来为大量文章标题生成标签。方法1手动进行,方法2则利用nltk的Text类自动化分析。最终,通过文本索引实现文章标签的精准匹配。

本文介绍了如何通过去除停用词和标点符号,运用ngram模型和nltk库来为大量文章标题生成标签。方法1手动进行,方法2则利用nltk的Text类自动化分析。最终,通过文本索引实现文章标签的精准匹配。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1654

1654

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?