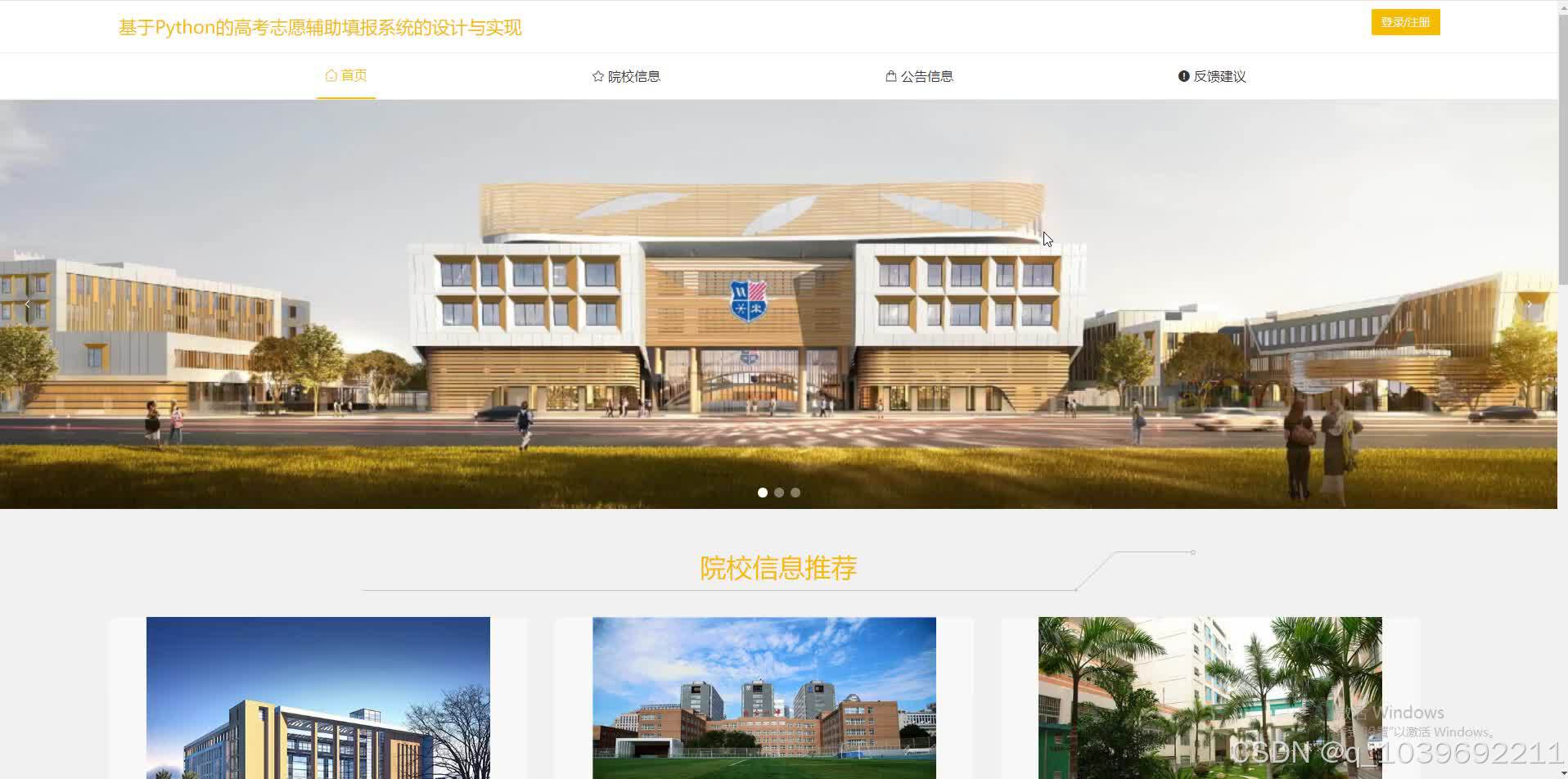

一、系统概述

基于 Python 的高考志愿辅助填报系统是一款利用 Python 强大的数据处理、分析和网络爬虫技术开发的智能软件工具。旨在帮助高考考生及其家长在填报志愿时,基于考生的高考成绩、兴趣爱好、职业规划等多方面因素,科学、合理、高效地筛选出适合的高校与专业,从而提高志愿填报的准确性和成功率,减轻填报过程中的信息不对称和决策压力。

二、功能模块设计

(一)数据采集模块

1.高校信息采集

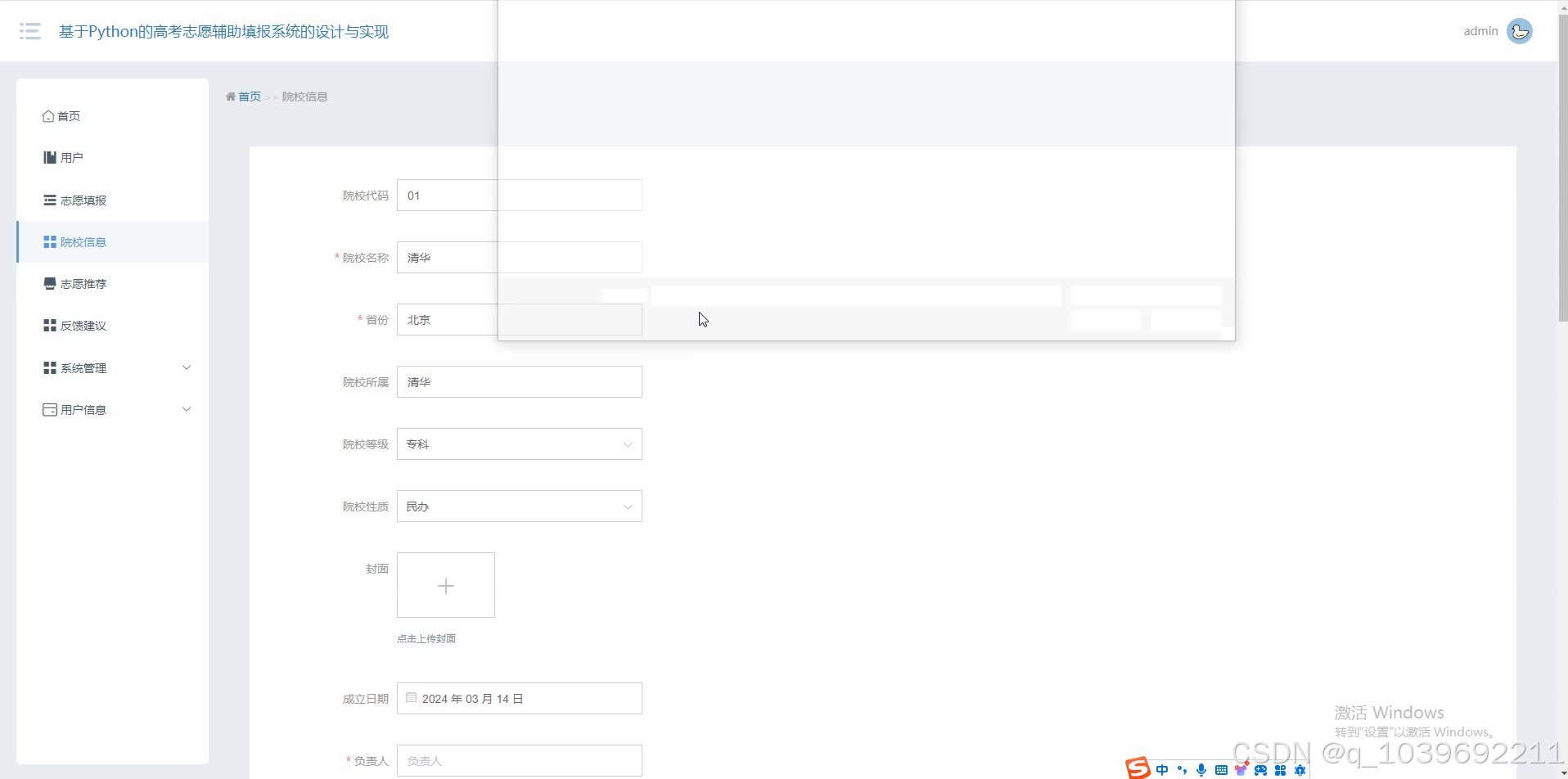

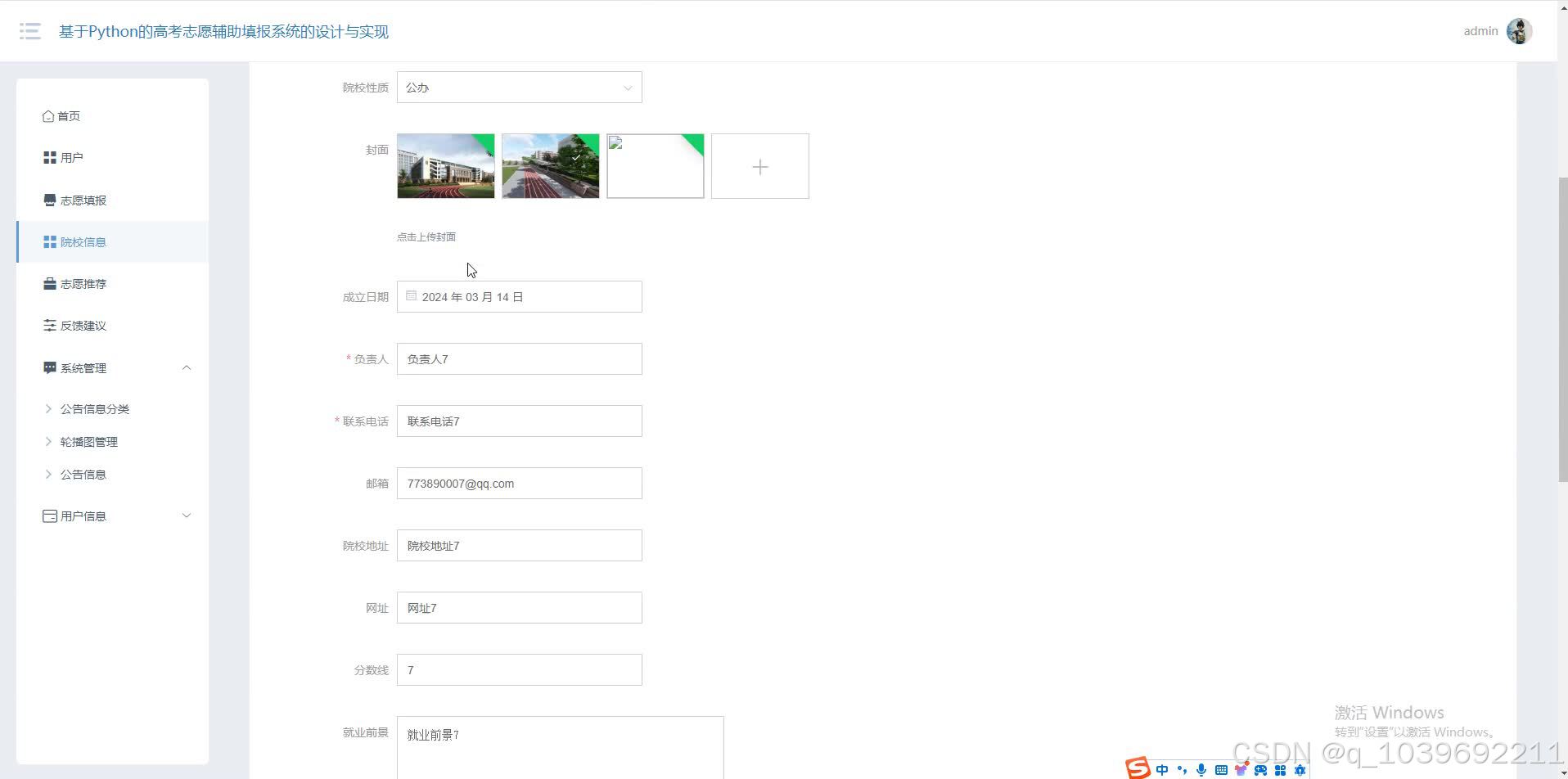

1.从教育部官方网站、各高校招生网站以及权威的教育数据平台等多渠道,利用 Python 的网络爬虫框架(如 Scrapy)抓取高校的基本信息。包括高校名称、学校代码、学校类型(如综合类、理工类、师范类等)、地理位置(所在省份、城市)、办学层次(本科、专科)、学校历史、师资力量(教师数量、职称分布等)、学科专业设置(专业名称、所属学科门类、专业特色等)、招生计划(分省份、分专业招生人数)等详细数据。

2.定期更新高校信息,以确保数据的时效性和准确性。例如,在每年高校招生政策和计划发布后,及时更新系统中的招生计划数据,为考生提供最新的报考依据。

2.专业信息采集

1.采集专业的详细信息,如专业课程设置、就业方向、发展前景、专业排名(不同机构的排名情况)、考研深造率、出国留学机会等。这些信息有助于考生深入了解各个专业的内涵和未来发展路径,结合自身兴趣和职业规划做出更合适的专业选择。

2.整合专业的历年录取分数线数据,从各省级招生考试机构网站以及高校招生网站获取不同高校、不同专业在各省的历年录取分数线(包括最高分、最低分、平均分)以及录取位次信息。通过对这些数据的分析,可以了解专业的录取难度和竞争态势,为考生提供参考。

(二)考生信息录入与分析模块

1.考生成绩与位次录入

1.考生或家长在系统中录入考生的高考成绩(包括总分、各科目成绩)以及在本省的高考位次信息。系统根据考生所在省份的高考政策和一分一段表,对考生的成绩和位次进行准确性验证和标准化处理,确保数据的有效性。

2.考生兴趣爱好与职业规划评估

1.通过问卷调查或心理测评等方式,收集考生的兴趣爱好信息(如学科兴趣、特长爱好等)以及职业规划意向(如未来想从事的行业、职业类型等)。利用 Python 的数据分析库(如 Pandas 和 Numpy)对这些信息进行分析和分类,为推荐符合考生兴趣和职业目标的专业提供依据。例如,对于对物理学科有浓厚兴趣且希望从事科研工作的考生,系统会优先推荐物理学相关的专业,并结合高校的科研实力进行排序。

(三)志愿推荐模块

1.基于分数与位次的推荐

1.根据考生录入的高考成绩和位次信息,结合历年高校专业录取分数线和位次数据,利用数据匹配算法和统计学模型(如线性回归模型预测录取概率),筛选出符合考生成绩范围且录取概率较高的高校和专业。系统会按照录取概率从高到低对推荐结果进行排序,并提供详细的录取分析报告,包括该专业在考生所在省份的招生人数变化趋势、近几年的录取分数线波动情况等信息,帮助考生直观了解报考风险。

2.基于兴趣爱好与职业规划的推荐

1.在考虑考生成绩的基础上,进一步结合考生的兴趣爱好和职业规划进行志愿推荐。系统通过对考生兴趣爱好和职业目标的分析,匹配与之相关的专业和高校。例如,对于喜欢艺术设计且希望未来从事广告设计工作的考生,推荐视觉传达设计、数字媒体艺术等相关专业,并从具有良好艺术设计专业声誉和丰富实践教学资源的高校中筛选合适的报考选项。推荐结果会突出专业与考生兴趣和职业规划的契合度,同时提供相关专业的课程设置和就业案例,帮助考生更好地理解专业内涵和未来发展方向。

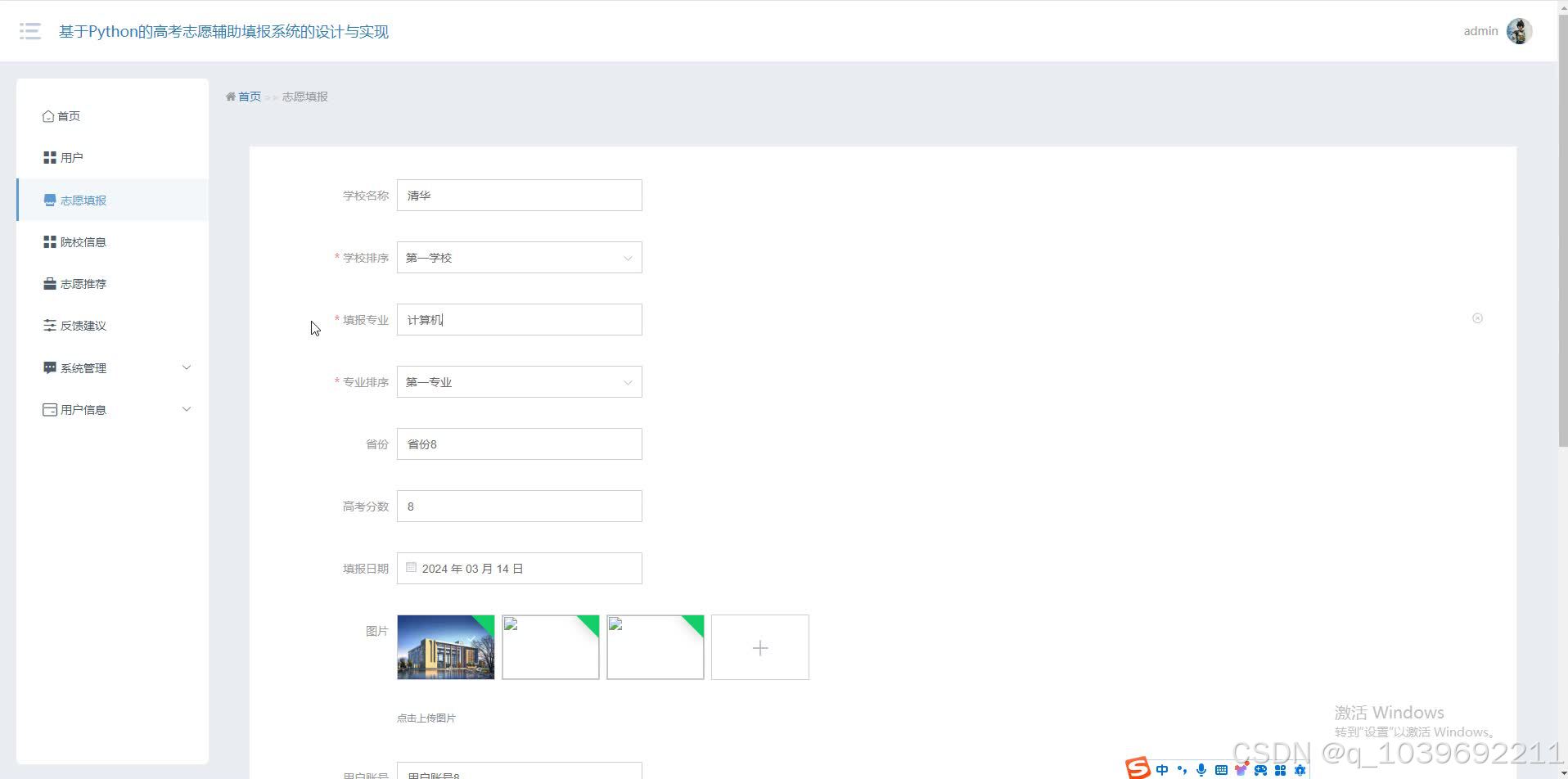

(四)志愿方案评估与优化模块

1.志愿方案合理性评估

1.考生可以将自己初步拟定的志愿填报方案输入系统,系统从多个维度对方案进行评估。包括志愿的梯度设置是否合理(如冲、稳、保的搭配是否得当)、专业调剂风险评估(分析考生选择服从专业调剂或不服从专业调剂的潜在风险)、院校地域分布合理性(考虑不同地区高校的资源差异和考生的地域偏好)等。

2.根据评估结果,系统生成详细的评估报告,指出志愿方案的优点和不足之处,并提供改进建议。例如,如果发现考生的志愿方案中 “冲” 的院校过多,可能导致录取风险增加,系统会建议适当调整,增加一些 “稳” 和 “保” 的志愿选项,以提高录取的成功率。

2.志愿方案优化调整

1.基于评估结果和系统的优化算法,对考生的志愿方案进行自动优化。系统会根据考生的成绩、兴趣爱好、职业规划以及高校招生数据的动态变化,重新调整志愿的顺序、推荐更合适的高校和专业组合,以达到志愿方案的最优化。优化后的方案会在保证一定录取概率的前提下,尽量满足考生的多元化需求,如兼顾院校层次、专业兴趣和地域分布等因素。

(五)信息查询与咨询模块

1.高校与专业详情查询

1.考生和家长可以在系统中查询任意高校和专业的详细信息。除了采集到的数据展示外,还提供高校和专业的对比功能,方便考生直观比较不同高校在同一专业上的优势和差异,或者不同专业在同一高校内的资源分配和发展前景。例如,对比两所高校的计算机科学与技术专业,可以查看它们的师资力量对比、实验室设备条件、科研项目成果以及毕业生就业质量等方面的信息,从而做出更精准的选择。

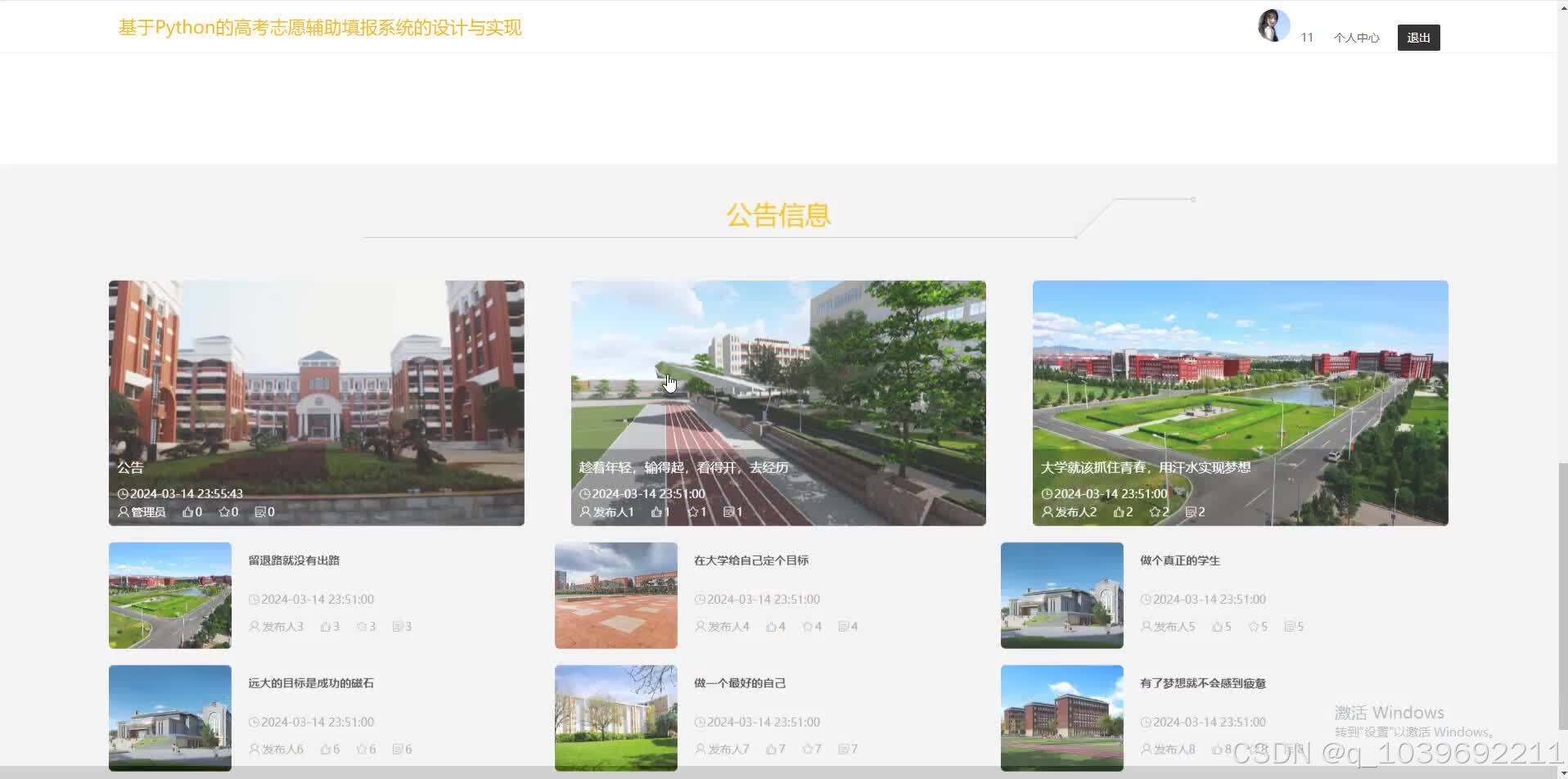

2.招生政策与资讯查询

1.实时收集和整理各省份以及各高校的招生政策、招生章程、录取规则等重要资讯信息。考生可以通过系统及时了解最新的高考招生动态,如加分政策、特殊类型招生(自主招生、专项计划等)的相关规定、高校的录取原则(如是否对单科成绩有要求、体检标准等)。系统对这些资讯进行分类整理和关键词检索功能,方便考生快速查找自己关心的信息,避免因政策不明导致的填报失误。

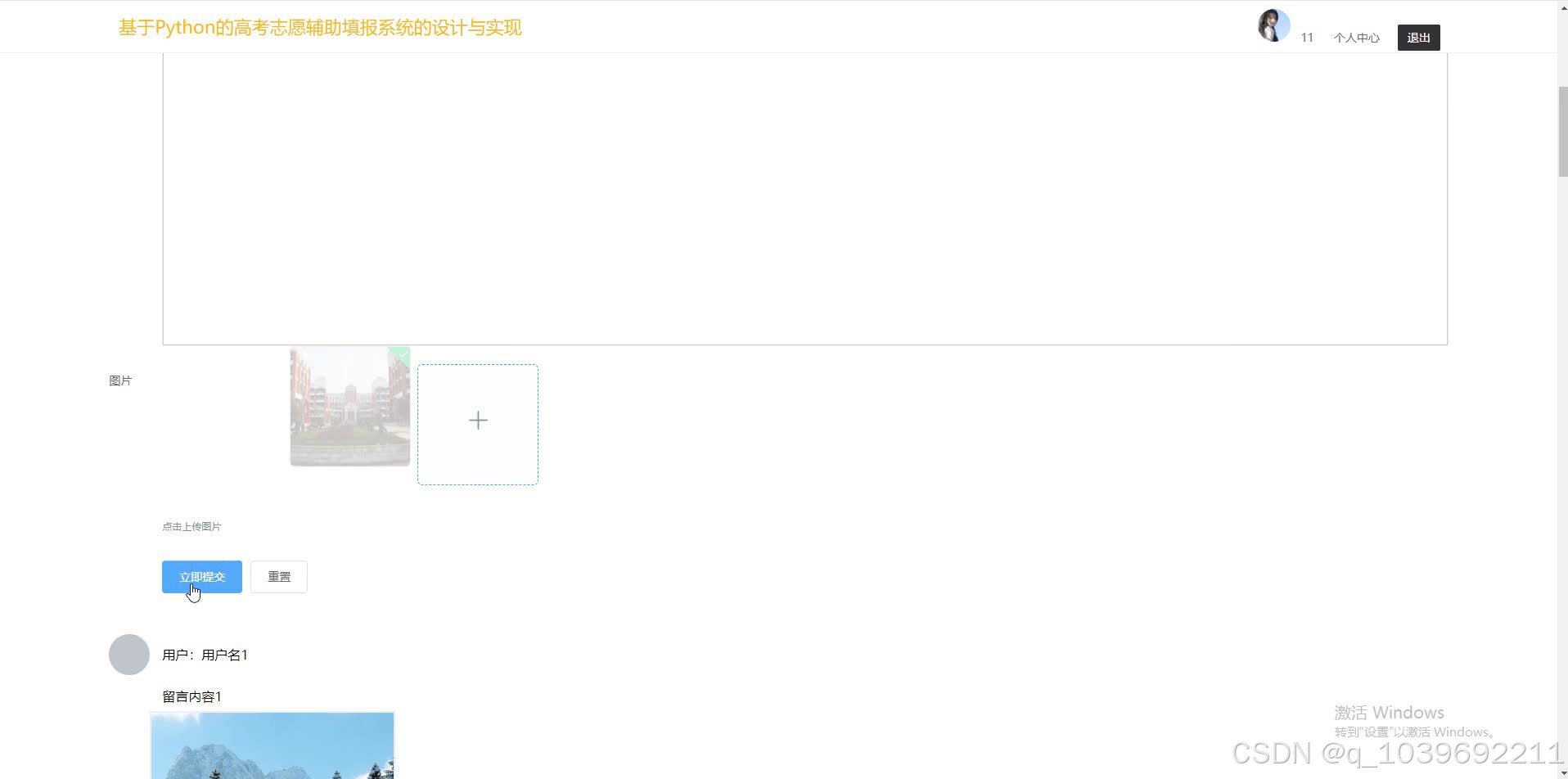

3.在线咨询与交流

1.搭建在线咨询平台,邀请教育专家、高校招生老师以及有经验的学长学姐入驻。考生和家长可以在平台上提出关于高考志愿填报的疑问,如专业选择困惑、高校录取规则解读、志愿填报技巧等问题,由专业人士进行解答和指导。同时,平台支持考生之间的交流互动,分享志愿填报经验和心得,形成良好的互助学习氛围。

三、技术实现要点

(一)Python 技术应用

1.数据处理与分析库

1.Pandas 库用于数据的读取、清洗、整理和分析。它提供了高效的数据结构(如 Series 和 DataFrame)和丰富的数据操作方法,能够方便地处理从各种数据源采集到的高校、专业和招生数据。例如,使用 Pandas 的 read_csv 函数读取 CSV 格式的历年录取分数线数据,然后利用数据筛选和分组操作,提取出特定高校、专业在某省份的录取分数线数据,并进行统计分析,如计算平均分、最高分、最低分的变化趋势等。

2.Numpy 库用于数值计算和科学计算任务。在数据处理过程中,如计算录取概率的统计模型中,Numpy 提供了强大的数组运算功能和数学函数库,能够高效地进行数据的数学变换和计算。例如,在基于线性回归模型预测录取概率时,利用 Numpy 进行矩阵运算,求解回归系数等参数。

3.Scikit - learn 库用于机器学习算法的应用。在志愿推荐模块中,利用 Scikit - learn 中的分类和回归算法(如逻辑回归、决策树等)构建录取概率预测模型。通过对历年录取数据的训练,模型可以根据考生的成绩和其他特征预测被不同高校专业录取的概率。例如,将考生的高考成绩、位次、所在省份等信息作为特征变量,将是否被录取作为目标变量,训练一个逻辑回归模型,用于预测考生被特定高校专业录取的可能性。

2.网络爬虫框架

1.Scrapy 框架用于高校和专业数据的采集。它具有强大的页面抓取和数据提取能力,可以高效地从多个网站抓取结构化的数据。例如,定义 Scrapy 的 Spider 类,指定要抓取的网站 URL 列表和数据提取规则,就可以自动地从教育部网站抓取高校名单信息,从高校招生网站抓取专业设置、招生计划等详细数据。在抓取过程中,Scrapy 能够处理页面的跳转、数据的异步加载等复杂情况,确保数据的完整性和准确性。

2.BeautifulSoup 库辅助进行网页解析。在一些相对简单的网页数据提取任务中,或者与 Scrapy 框架结合使用时,BeautifulSoup 可以方便地解析 HTML 和 XML 文档,提取出所需的数据元素。例如,在从高校招生网站的页面中提取专业介绍文本时,利用 BeautifulSoup 找到对应的 HTML 标签,并获取标签内的文本内容。

3.图形化界面开发库(可选)

1.如果系统开发桌面应用程序版本,可以使用 PyQt 或 Tkinter 等 Python 的图形化界面开发库。这些库可以创建直观、友好的用户界面,方便考生和家长操作。例如,使用 PyQt 设计系统的主窗口、数据录入界面、志愿推荐结果展示界面等,通过布局管理器和各种界面组件(如文本框、按钮、列表框、表格等)构建出功能齐全、美观大方的图形化界面。在界面设计过程中,注重用户体验,如设置合理的界面布局、颜色搭配和交互提示,使考生和家长能够轻松上手使用系统。

(二)数据存储与管理

1.数据库选型与设计

1.选择关系型数据库(如 MySQL 或 PostgreSQL)存储系统的核心数据,包括高校信息表、专业信息表、考生信息表、历年录取分数线表、志愿填报方案表等。设计合理的数据库表结构,定义表之间的主键和外键关系,以确保数据的完整性和一致性。例如,高校信息表可以包含高校 ID、高校名称、学校类型、地理位置等字段,专业信息表可以包含专业 ID、专业名称、所属高校 ID、学科门类等字段,通过专业所属高校 ID 与高校信息表的高校 ID 建立外键关联,实现数据的关联查询和管理。

2.对于一些非结构化数据,如高校的校园图片、专业的课程大纲文档等,可以结合使用非关系型数据库(如 MongoDB)或文件系统进行存储。在数据库中存储这些非结构化数据的引用地址或路径,以便在需要时能够快速获取和展示。例如,在高校信息表中增加一个字段用于存储校园图片的文件路径,当在系统中展示高校详情时,根据该路径读取并显示校园图片。

2.数据更新与维护

1.建立数据定期更新机制,确保高校、专业和招生数据的时效性。可以设置定时任务(如每天或每周特定时间)启动数据采集程序,检查数据源是否有新的数据更新,如果有,则更新到数据库中。在数据更新过程中,要注意数据的一致性和完整性,避免出现重复数据或数据错误。例如,在更新高校招生计划数据时,先对新采集的数据进行清洗和验证,然后与数据库中已有的数据进行比对和合并,确保招生计划数据的准确性和唯一性。

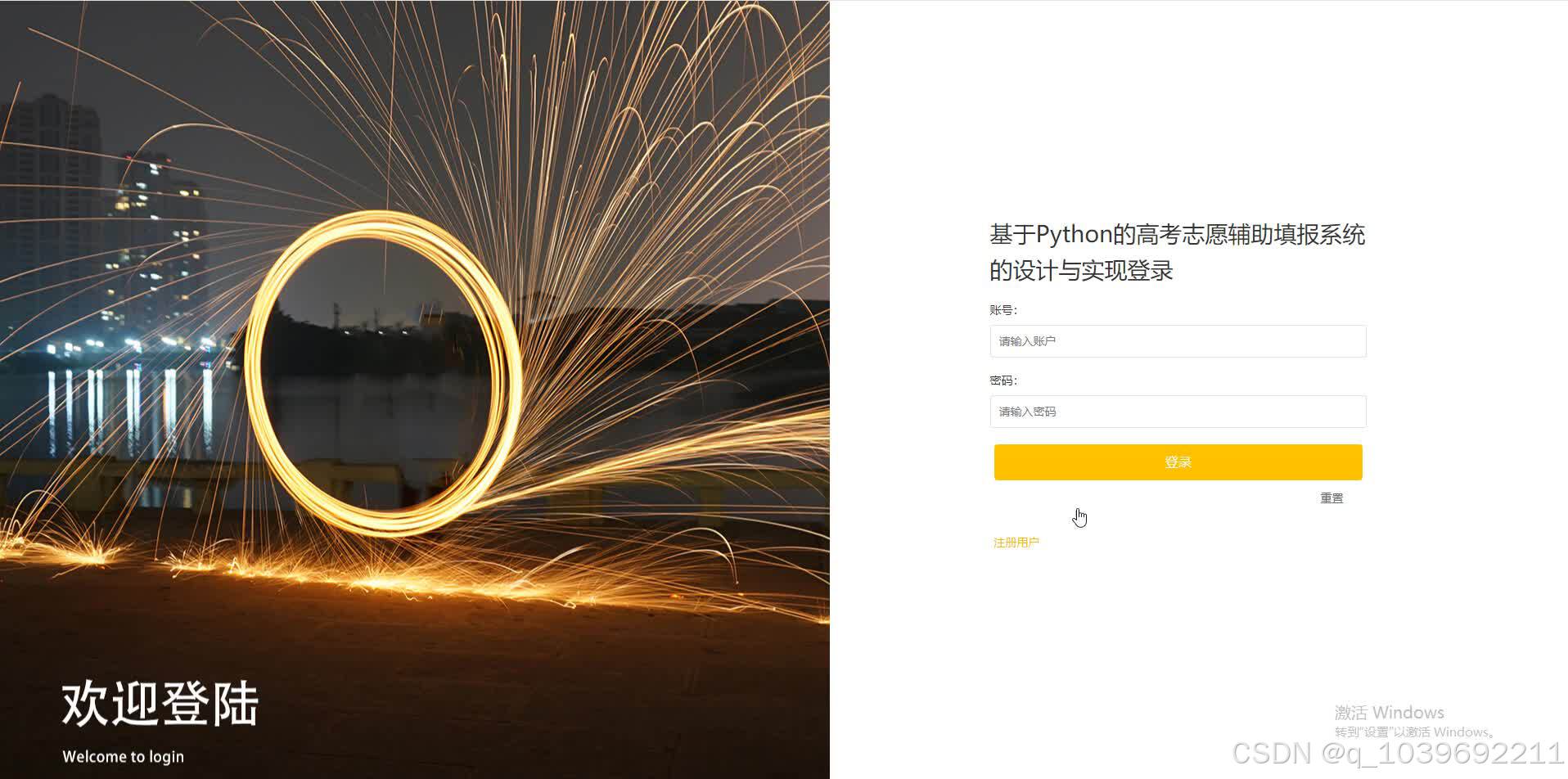

(三)系统性能优化与安全防护

1.性能优化

1.优化数据采集程序的效率,合理设置网络爬虫的并发请求数量和爬取频率,避免对目标网站造成过大的访问压力,同时提高数据采集速度。例如,使用 Scrapy 的设置项调整并发请求数和延迟时间,根据目标网站的服务器负载能力和反爬虫策略,设置合适的参数值,以在不被封禁的前提下快速获取数据。

2.对数据库查询操作进行优化,建立合适的索引。在经常进行查询的字段(如高校名称、专业名称、录取分数线年份等)上建立索引,提高数据查询速度。例如,在历年录取分数线表中,对高校 ID、专业 ID 和录取年份字段建立联合索引,这样在查询特定高校特定专业的历年录取分数线时,可以快速定位到相关数据,减少查询时间。

3.采用缓存技术,如使用 Python 的缓存库(如 Redis)对一些频繁访问但数据变化不大的信息(如高校基本信息、专业分类信息等)进行缓存。当系统需要这些信息时,首先从缓存中获取,如果缓存中不存在或数据已过期,则从数据库中读取并更新缓存。这样可以减少数据库的访问次数,提高系统的响应速度。

2.安全防护

1.对考生信息进行严格的安全保护。采用加密技术对考生的成绩、位次、个人信息等敏感数据进行加密存储和传输。例如,使用哈希函数(如 SHA - 256)对考生密码进行加密存储,在考生登录系统时,将输入的密码进行哈希计算,并与存储在数据库中的哈希值进行比对验证,确保密码的安全性。在数据传输过程中,采用 SSL/TLS 协议对网络请求进行加密,防止考生信息被窃取或篡改。

2.防范网络爬虫的恶意攻击和数据滥用。在数据采集程序中,设置合理的反爬虫机制,如识别和限制同一 IP 地址的频繁访问、设置验证码验证等措施,防止其他恶意爬虫对系统数据源进行非法抓取和数据盗用。同时,对系统的接口进行访问控制,只允许合法的客户端应用程序或用户访问系统数据和功能,防止数据泄露和恶意操作。

四、系统应用前景

1.提高志愿填报质量

1.系统基于大量的数据和科学的分析算法,能够为考生提供全面、精准的志愿推荐和方案评估服务。帮助考生避免因信息不足或决策失误而导致的志愿填报不合理情况,提高志愿填报的质量和成功率,使考生能够更顺利地进入自己理想的高校和专业学习。

2.促进教育资源合理配置

1.通过引导考生根据自身情况和兴趣爱好选择合适的高校和专业,避免了盲目跟风报考热门高校和专业的现象,从而促进教育资源在不同高校和专业之间的合理配置。使得一些优质但相对冷门的高校和专业能够得到更多优秀考生的关注和报考,有利于教育资源的均衡发展和充分利用。

3.推动高考志愿填报服务的信息化与智能化

1.该系统的开发和应用为高考志愿填报服务领域提供了一个信息化、智能化的解决方案范例。随着技术的不断发展和数据的不断积累,系统可以不断优化和完善,进一步提高其准确性和实用性。同时,也能够带动整个高考志愿填报服务行业向更加科学、高效、智能的方向发展,为广大考生和家长提供更好的服务体验。

798

798

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?