最近在eclipse构建spark java开发环境走了很多坑,把步骤记录下来。

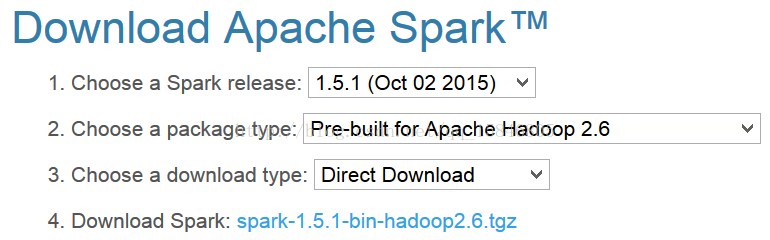

第一步、从spark官网上下载spark安装包,我下载的为spark-1.5.1-bin-hadoop2.6

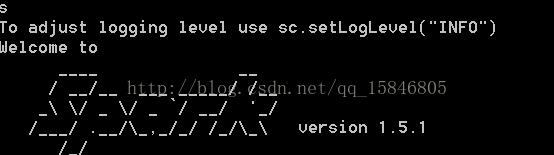

直接解压缩即可,在环境变量path中配置为你解压缩的路径+\bin,我的path为D:\spark-1.5.1-bin-hadoop2.6\bin,在cmd中输入spark-shell

第二步、在eclipse中新建一个工程,添加依赖jar包(在解压缩spark文件夹的lib目录下,我的为D:\spark-1.5.1-bin-hadoop2.6\lib)。

本文记录了在Eclipse中搭建Spark Java开发环境的详细步骤,包括下载Spark安装包,配置环境变量,新建工程,添加依赖jar包,以及解决运行时遇到的winutils错误。最终通过使用Java 8的lambda表达式实现wordcount示例。

本文记录了在Eclipse中搭建Spark Java开发环境的详细步骤,包括下载Spark安装包,配置环境变量,新建工程,添加依赖jar包,以及解决运行时遇到的winutils错误。最终通过使用Java 8的lambda表达式实现wordcount示例。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1030

1030

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?